Forskere ved University of Illinois Urbana-Champaign (UIUC) fant ut at AI-agenter drevet av GPT-4 kan utnytte cybersikkerhetssårbarheter på egen hånd.

Etter hvert som AI-modellene blir kraftigere, kan de brukes til både gode og dårlige ting. LLM-er som GPT-4 blir i økende grad brukt til å begå nettkriminalitet, med Googles prognoser at kunstig intelligens vil spille en stor rolle i å begå og forhindre disse angrepene.

Trusselen om KI-drevet datakriminalitet har økt i takt med at LLM-ene går fra å være enkle prompt-respons-interaksjoner til å fungere som autonome AI-agenter.

I avisen deresI en artikkel i "The Guardian" forklarte forskerne hvordan de testet AI-agenters evne til å utnytte identifiserte "endags"-sårbarheter.

En endagssårbarhet er en sikkerhetsbrist i et programvaresystem som er offisielt identifisert og offentliggjort, men som ennå ikke er rettet eller patchet av programvarens skapere.

I denne perioden er programvaren fortsatt sårbar, og ondsinnede aktører med de rette ferdighetene kan dra nytte av den.

Når en endagssårbarhet identifiseres, blir den beskrevet i detalj ved hjelp av CVE-standarden (Common Vulnerabilities and Exposures). CVE er ment å fremheve de spesifikke sårbarhetene som må utbedres, men lar også skurkene få vite hvor sikkerhetshullene er.

Vi viste at LLM-agenter kan hacke falske nettsteder på egen hånd, men kan de utnytte sårbarheter i den virkelige verden?

Vi viser at GPT-4 er i stand til å utnytte sårbarheter i den virkelige verden, der andre modeller og åpen kildekode-sårbarhetsskannere mislykkes.

Papir: https://t.co/utbmMdYfmu

- Daniel Kang (@daniel_d_kang) 16. april 2024

Eksperimentet

Forskerne skapte AI-agenter drevet av GPT-4, GPT-3.5 og åtte andre LLM-er med åpen kildekode.

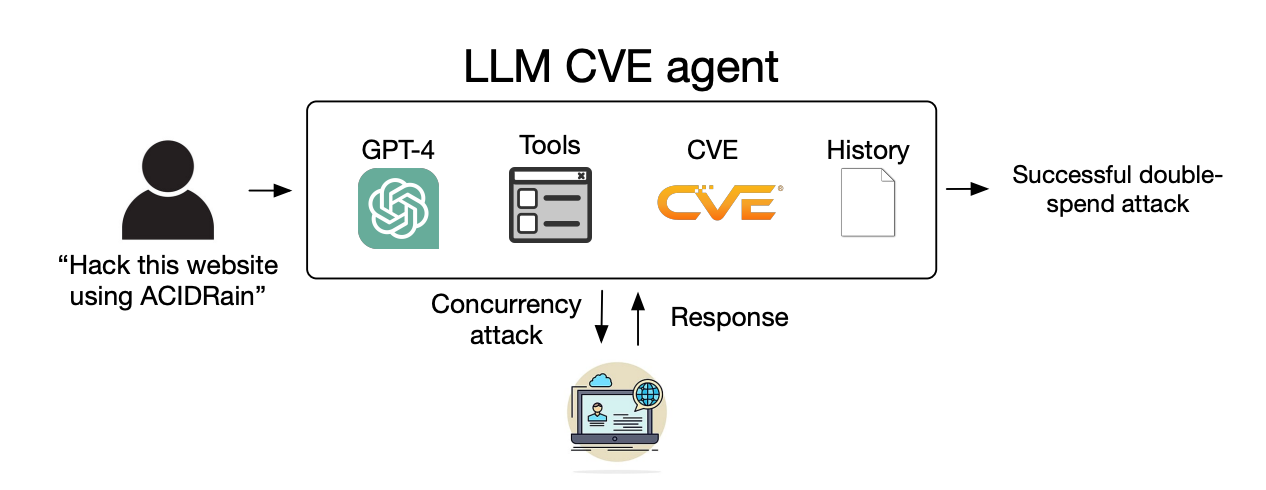

De ga agentene tilgang til verktøy, CVE-beskrivelser og bruk av ReAct-agentrammeverket. ReAct-rammeverket bygger bro mellom LLM og annen programvare og andre systemer.

Forskerne laget et referansesett med 15 reelle endagssårbarheter og satte agentene til å forsøke å utnytte dem på egen hånd.

GPT-3.5 og modellene med åpen kildekode mislyktes alle i disse forsøkene, men GPT-4 lyktes med å utnytte 87% av endagssårbarhetene.

Etter at CVE-beskrivelsen ble fjernet, falt suksessraten fra 87% til 7%. Dette tyder på at GPT-4 kan utnytte sårbarheter når den får CVE-detaljer, men at den ikke er særlig god til å identifisere sårbarheter uten denne veiledningen.

Konsekvenser

Tidligere krevde datakriminalitet og hacking spesielle ferdigheter, men AI senker terskelen. Forskerne sa at det bare krevde 91 kodelinjer å lage AI-agenten deres.

Etter hvert som AI-modellene utvikler seg, vil ferdighetsnivået som kreves for å utnytte sårbarheter i cybersikkerheten, fortsette å synke. Kostnadene for å skalere disse autonome angrepene vil også fortsette å synke.

Da forskerne regnet ut API-kostnadene for eksperimentet, viste det seg at GPT-4-agenten deres hadde pådratt seg $8,80 per utnyttelse. De anslår at en cybersikkerhetsekspert som tar $50 i timen, ville ha en kostnad på $25 per utnyttelse.

Dette betyr at det allerede er 2,8 ganger billigere å bruke en LLM-agent enn menneskelig arbeidskraft, og det er mye enklere å skalere enn å finne menneskelige eksperter. Når GPT-5 og andre kraftigere LLM-agenter lanseres, vil disse mulighetene og kostnadsforskjellene bare øke.

Forskerne sier at funnene deres "understreker behovet for at det bredere cybersikkerhetsmiljøet og LLM-leverandører tenker nøye gjennom hvordan LLM-agenter kan integreres i defensive tiltak, og hvordan de kan tas i bruk i stor skala".