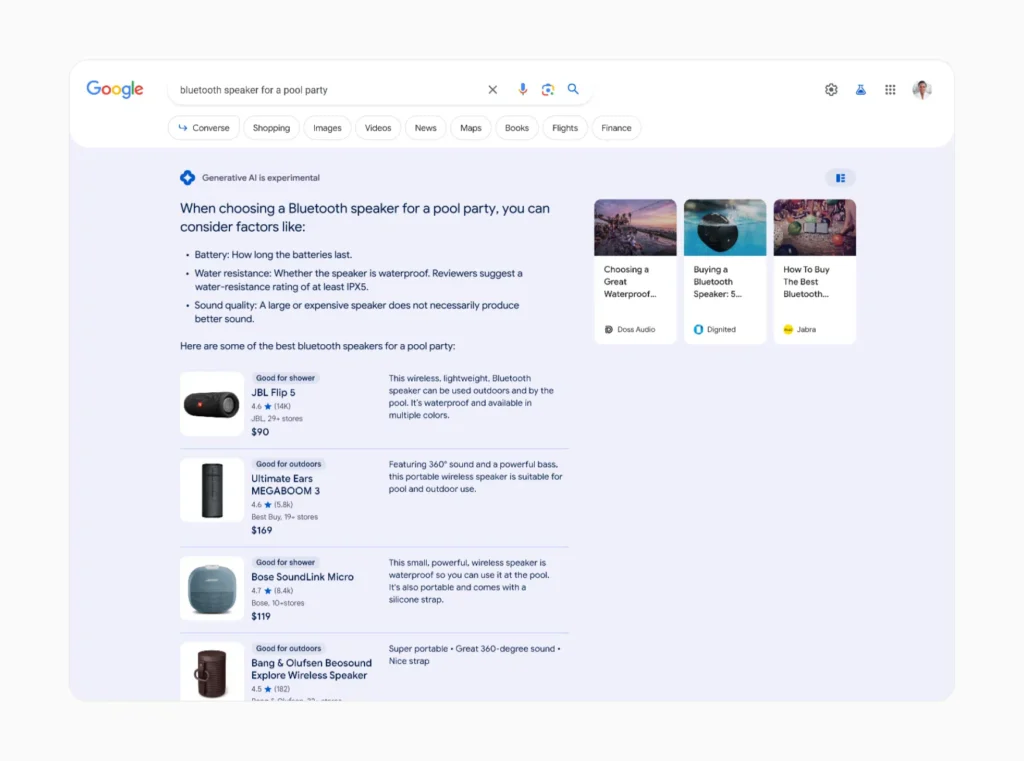

På Googles siste flaggskipkonferanse, I/O-konferansen, fordoblet selskapet satsingen på sin Search Generative Experience (SGE) - som vil bygge inn generativ AI i Google Søk.

SGE, som har som mål å gi AI-genererte svar til over en milliard brukere innen utgangen av 2024, baserer seg på Gemini, Googles familie av store språkmodeller (LLM-er), for å generere menneskelignende svar på søk.

I stedet for et tradisjonelt Google-søk, som først og fremst viser lenker, vil du bli presentert for et AI-generert sammendrag sammen med andre resultater.

Denne "AI-oversikten" har blitt kritisert for å å gi tullete informasjonog Google jobber raskt med å finne løsninger før masseutrullingen starter.

Men bortsett fra å anbefale lim på pizza og si at pytonslanger er pattedyr, er det et annet problem med Googles nye AI-drevne søkestrategi: det miljømessige fotavtrykket.

Hvorfor SGE er ressurskrevende

Mens tradisjonelle søkemotorer bare henter eksisterende informasjon fra internett, må generative AI-systemer som SGE skape helt nytt innhold for hvert søk.

Denne prosessen krever mye mer datakraft og energi enn konvensjonelle søkemetoder.

Det anslås at det utføres mellom 3 og 10 milliarder Google-søk hver dag. Effekten av å bruke kunstig intelligens på selv en liten prosentandel av disse søkene kan være utrolig stor.

Sasha Luccioni, en forsker ved AI-selskapet Hugging Face som studerer miljøkonsekvensene av disse teknologiene, diskuterte nylig den kraftige økningen i energiforbruket som SGE kan utløse.

Luccioni og teamet hennes anslår at det kan kreve 30 ganger så mye energi å generere søkeinformasjon med kunstig intelligens som et konvensjonelt søk.

"Det gir jo bare mening, ikke sant? Mens et vanlig søk finner eksisterende data fra Internett, må applikasjoner som AI Overviews skape helt ny informasjon." sa hun til Scientific American.

I 2023 fant Luccioni og kollegene hennes ut at treningen av LLM BLOOM slapp ut klimagasser tilsvarende 19 kg CO2 per bruksdag, eller like mye som en gjennomsnittlig bensindrevet bil som kjører 50 km. De fant også ut at det å generere bare to bilder ved hjelp av AI kan forbruke like mye energi som å fullade en gjennomsnittlig smarttelefon.

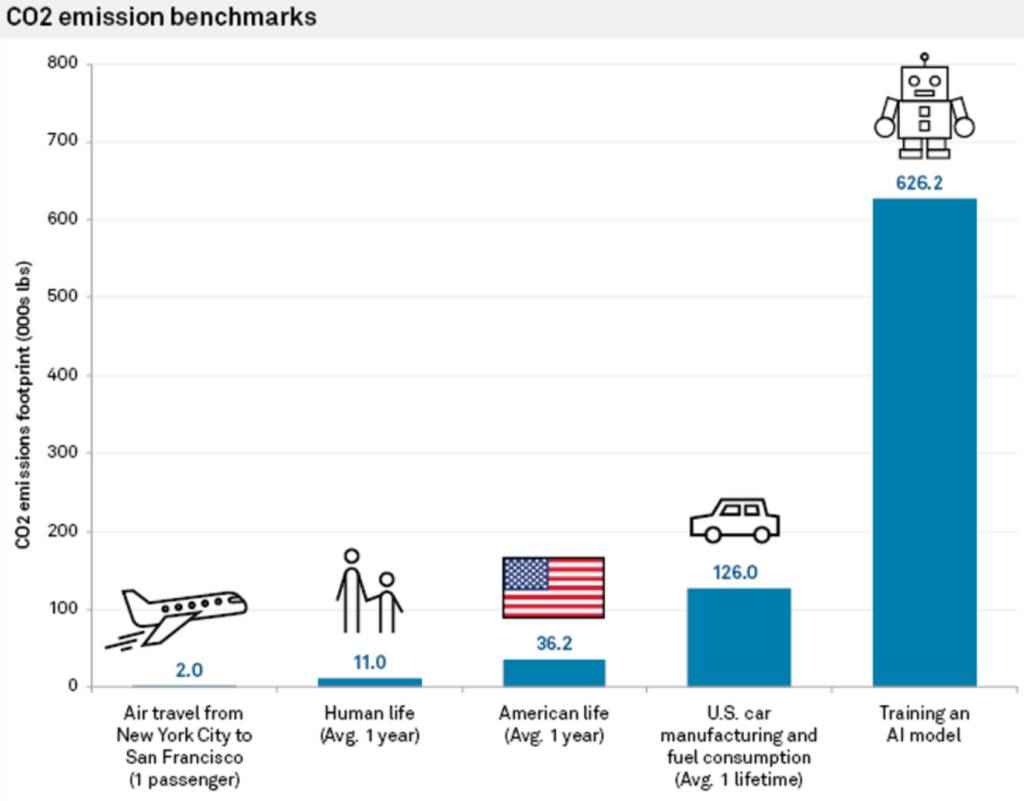

Tidligere studier har anslått at CO2-utslippene forbundet med å trene opp en AI-modell kan overstige utslippene fra hundrevis av kommersielle flyreiser eller en gjennomsnittlig bil i løpet av dens levetid.

I en intervju med Reuters i fjorJohn Hennessy, styreleder i Googles morselskap, Alphabet, innrømmet selv de økte kostnadene forbundet med AI-drevet søk.

"En børs med en stor språkmodell kan koste ti ganger mer enn et tradisjonelt søk", sa han, selv om han spådde at kostnadene ville synke etter hvert som modellene ble finjustert.

AI-søk legger press på infrastruktur og ressurser

Datasentre som huser AI-servere forventes å doble energiforbruket sitt innen 2026, og potensielt bruke så mye makt som et lite land.

Med brikkeprodusenter som NVIDIA som lanserer større og kraftigere brikker, kan det snart ta tilsvarende flere kjernekraftverk for å kjøre store AI-arbeidsbelastninger.

Når AI-selskaper svarer på spørsmål om hvordan dette kan opprettholdes, viser de vanligvis til økt effektivitet og kapasitet i fornybar energi og forbedret energieffektivitet i AI-maskinvare.

Overgangen til fornybare energikilder for datasentre har imidlertid vist seg å være langsom og kompleks.

Shaolei Ren, dataingeniør ved University of California, Riverside, som forsker på bærekraftig AI, forklarer: "Det er et misforhold mellom tilbud og etterspørsel når det gjelder fornybar energi. Den periodiske produksjonen av fornybar energi er ofte ikke i stand til å matche den konstante, stabile strømmen som datasentrene trenger."

På grunn av dette misforholdet blir fossile kraftverk holdt i drift lenger enn planlagt i områder med høy konsentrasjon av teknologisk infrastruktur.

En annen løsning på energiproblemet ligger i energieffektiv AI-maskinvare. NVIDIAs ny Blackwell-brikke er mange ganger mer energieffektiv enn sine forgjengere, og andre selskaper som Delta jobber med effektiv maskinvare for datasentre.

Rama Ramakrishnan, professor ved MIT Sloan School of Management, forklarte at selv om antallet søk som går gjennom LLM-er, sannsynligvis vil øke, ser det ut til at kostnaden per søk vil synke etter hvert som selskapene jobber med å gjøre maskin- og programvare mer effektiv.

Men vil det være nok til å kompensere for det økende energibehovet? "Det er vanskelig å forutsi," sier Ramakrishnan. "Jeg tipper at det sannsynligvis kommer til å øke, men det kommer nok ikke til å øke dramatisk."

I takt med at AI-kappløpet tilspisser seg, har det blitt nødvendig å redusere miljøkonsekvensene. Nødvendighet er oppfinnelsens mor, og teknologiselskapene er under press for å skape løsninger som kan holde AI-utviklingen i gang.

Energieffektiv maskinvare, fornybar energi og til og med fusjonskraft kan bane vei for en mer bærekraftig fremtid for kunstig intelligens, men veien dit er full av usikkerhet.

SGE kan også belaste vannforsyningen

Vi kan også spekulere i vannbehovet som SGE skaper, noe som kan gjenspeile den enorme økningen i vannforbruket i datasentre som tilskrives den generative AI-industrien.

Ifølge Microsofts nylige miljørapporter har vannforbruket økte med opptil 50% i noen regioner, med en dobling av vannforbruket i Las Vegas-datasenteret siden 2022. Googles rapporter registrerte også en økning på 20% i datasentrenes vannforbruk i 2023 sammenlignet med 2022.

Ren tilskriver størstedelen av denne veksten til AI, og sier: "Det er rimelig å si at størstedelen av veksten skyldes AI, inkludert Microsofts store investeringer i generativ AI og partnerskap med OpenAI."

Ren anslår at hver interaksjon med ChatGPT, som består av mellom 5 og 50 spørsmål, forbruker svimlende 500 ml vann.

I en papir publisert i 2023, skrev Rens team: "Den globale AI-etterspørselen kan stå for 4,2 - 6,6 milliarder kubikkmeter vannuttak i 2027, noe som er mer enn det totale årlige vannuttaket til 4-6 Danmark eller halvparten av Storbritannia."

Ved hjelp av Rens forskning kan vi lage noen serviettberegninger for hvordan Googles SGE kan spille inn i disse spådommene.

La oss si at Google i gjennomsnitt behandler 8,5 milliarder daglige søk på verdensbasis. Hvis vi antar at bare en brøkdel av disse søkene, for eksempel 10%, bruker SGE og genererer AI-drevne svar med et gjennomsnitt på 50 ord per svar, kan vannforbruket bli fenomenalt.

Hvis vi bruker Rens estimat på 500 milliliter vann per 5 til 50 spørsmål (for eksempel en enkelt økt på Google SGE), kan vi grovt regne ut at 850 millioner SGE-drevne søk (10% av Googles daglige søk) vil forbruke omtrent 425 millioner liter vann daglig.

Dette tilsvarer daglig vannforbruket i en by med en befolkning på over 2,5 millioner mennesker.

I virkeligheten kan det faktiske vannforbruket variere avhengig av faktorer som effektiviteten til Googles datasentre og den spesifikke implementeringen og omfanget av SGE.

Likevel er det svært rimelig å spekulere i at SGE og andre former for AI-søk vil øke ressursbruken til AI ytterligere.

Vil globale AI-opplevelser som SGE være bærekraftige i stor skala? Det er mange faktorer som spiller inn, men det blir ingen dans på roser.