Kunstig intelligens har et utall bruksområder, men et av de mest bekymringsfulle er skapelsen av falske medier og desinformasjon.

En ny studie fra Google DeepMind og Puslespill, en teknologiinkubator for Google som overvåker samfunnstrusler, analyserte misbruk av AI mellom januar 2023 og mars 2024.

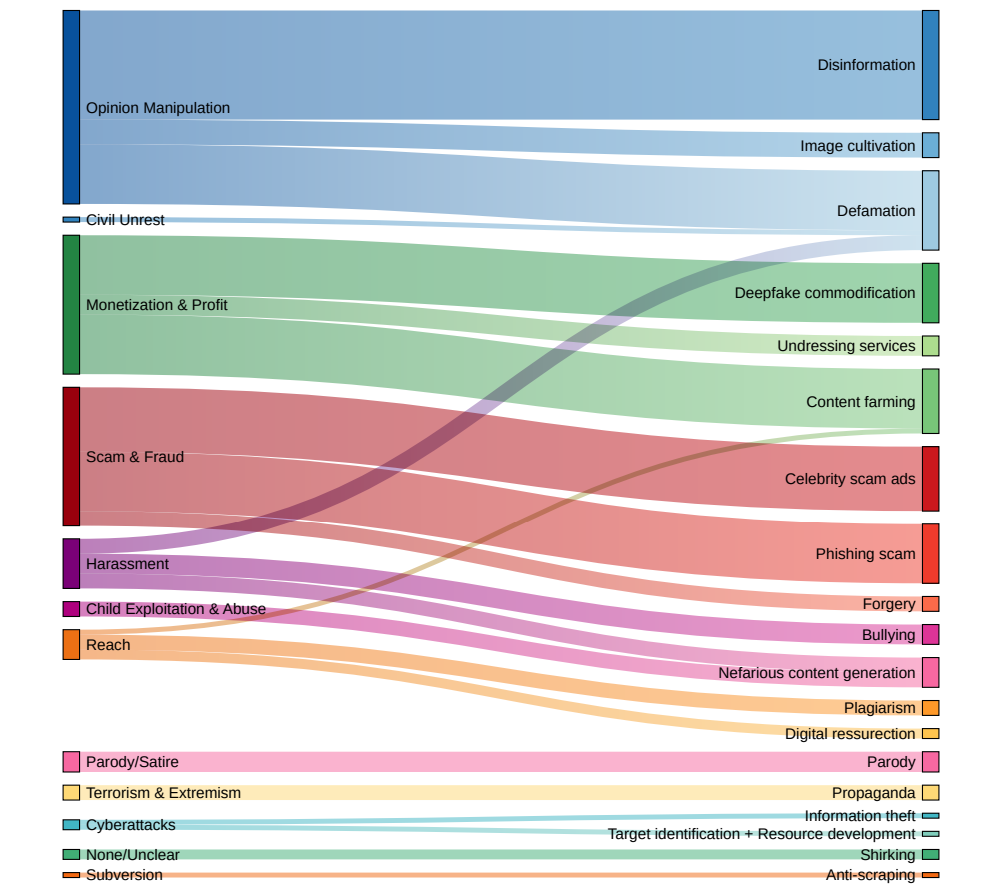

Den vurderte rundt 200 tilfeller av AI-misbruk i den virkelige verden, og avslørte at den vanligste formen for ondsinnet bruk av AI er å skape og spre villedende falske medier, særlig rettet mot politikere og offentlige personer.

Deep fakes, syntetiske medier som genereres ved hjelp av AI-algoritmer for å skape svært realistiske, men falske bilder, videoer og lyd, har blitt mer naturtro og utbredt.

Hendelser som når eksplisitte falske bilder av Taylor Swift på X viste at slike bilder kan nå millioner av mennesker før de slettes.

Men det mest lumske er dype forfalskninger rettet mot politiske spørsmål, som Israel-Palestina-konflikten. I noen tilfeller kan ikke engang faktasjekkerne som har fått i oppgave å stemple dem som "AI-genererte", oppdage ektheten på en pålitelig måte.

DeepMind-studien samlet inn data fra en rekke ulike kilder, inkludert sosiale medieplattformer som X og Reddit, nettblogger og medierapporter.

Hver hendelse ble analysert for å finne ut hvilken type AI-teknologi som ble misbrukt, hva som var hensikten bak misbruket, og hvilken teknisk ekspertise som var nødvendig for å utføre den ondsinnede aktiviteten.

Deep fakes er den dominerende formen for AI-misbruk

Funnene tegner et alarmerende bilde av dagens situasjon når det gjelder ondsinnet bruk av kunstig intelligens:

- Deep fakes viste seg å være den dominerende formen for AI-misbruk, og sto for nesten dobbelt så mange hendelser som den nest mest utbredte kategorien.

- Den nest hyppigst observerte typen AI-misbruk var bruk av språkmodeller og chatboter til å generere og spre desinformasjon på nettet. Ved å automatisere produksjonen av villedende innhold kan ondsinnede aktører oversvømme sosiale medier og andre plattformer med falske nyheter og propaganda i et omfang vi aldri har sett maken til.

- Påvirkning av opinionen og politiske narrativer var den primære motivasjonen bak over en fjerdedel (27%) av de analyserte tilfellene av AI-misbruk. Dette illustrerer trusselen som deep fakes og AI-generert desinformasjon utgjør mot demokratiske prosesser og integriteten til valg verden over, noe vi har observert fra nylige høyprofilerte hendelser.

- Økonomisk vinning ble identifisert som den nest vanligste drivkraften bak ondsinnet AI-aktivitet, med skruppelløse aktører som tilbød betalte tjenester for å lage dype forfalskninger, inkludert eksplisitte bilder uten samtykke, og som utnyttet generativ AI til å masseprodusere falskt innhold for å tjene penger.

- De fleste tilfellene av misbruk av kunstig intelligens involverer lett tilgjengelige verktøy og tjenester som krever minimal teknisk ekspertise for å fungere. Denne lave inngangsbarrieren gjør at antallet potensielle ondsinnede aktører øker betraktelig, noe som gjør det enklere enn noensinne for enkeltpersoner og grupper å bedrive AI-drevet bedrag og manipulasjon.

Dr. Nahema Marchal fra DeepMind forklarte utviklingen av misbruk av kunstig intelligens for Financial Times: "Det har vært mye forståelig bekymring rundt ganske sofistikerte cyberangrep som er muliggjort av disse verktøyene", og fortsetter: "Vi så ganske vanlig misbruk av GenAI [for eksempel deep fakes som] kanskje går litt mer under radaren."

Politiske beslutningstakere, teknologiselskaper og forskere må samarbeide om å utvikle omfattende strategier for å oppdage og motvirke deepfakes, AI-generert desinformasjon og andre former for AI-misbruk.

Men sannheten er at de allerede har forsøkt - og i stor grad mislyktes. Bare i det siste har vi observert flere tilfeller av barn som blir fanget i falske hendelserog viser at de samfunnsmessige skadene de påfører kan være alvorlige.

Foreløpig kan ikke teknologiselskaper oppdage forfalskninger i stor skala på en pålitelig måte, og de vil bare bli mer realistiske og vanskeligere å oppdage med tiden.

Og når tekst-til-videosystemer som OpenAIs Sora kommer på markedet, vil det bli en helt ny dimensjon av dype forfalskninger å håndtere.