NVIDIA har lansert Chat with RTX som en teknisk demo av hvordan AI-chatboter kan kjøres lokalt på Windows-PC-er ved hjelp av RTX-GPU-ene.

Standardmetoden for å bruke en AI-chatbot er å bruke en nettplattform som ChatGPT eller å kjøre spørringer via et API, der utledningen skjer på servere i skyen. Ulempene med dette er kostnader, ventetid og personvernhensyn i forbindelse med overføring av personopplysninger eller bedriftsdata frem og tilbake.

NVIDIAs RTX GPU-utvalget gjør det nå mulig å kjøre en LLM lokalt på Windows-PC-en din, selv om du ikke er koblet til Internett.

Chat med RTX lar brukerne opprette en personlig chatbot ved hjelp av enten Mistral eller Lama 2. Den bruker RAG (retrieval-augmented generation) og NVIDIAs inferensoptimaliserende TensorRT-LLM-programvare.

Du kan sende Chat with RTX direkte til en mappe på PC-en og deretter stille den spørsmål om filene i mappen. Programmet støtter ulike filformater, blant annet .txt, .pdf, .doc/.docx og .xml.

Fordi LLM analyserer lokalt lagrede filer med slutninger som skjer på maskinen din, går det veldig raskt, og ingen av dataene dine deles på potensielt usikrede nettverk.

Du kan også be den om å vise URL-en til en YouTube-video og stille den spørsmål om videoen. Det krever internettilgang, men det er en fin måte å få svar på uten å måtte se en lang video.

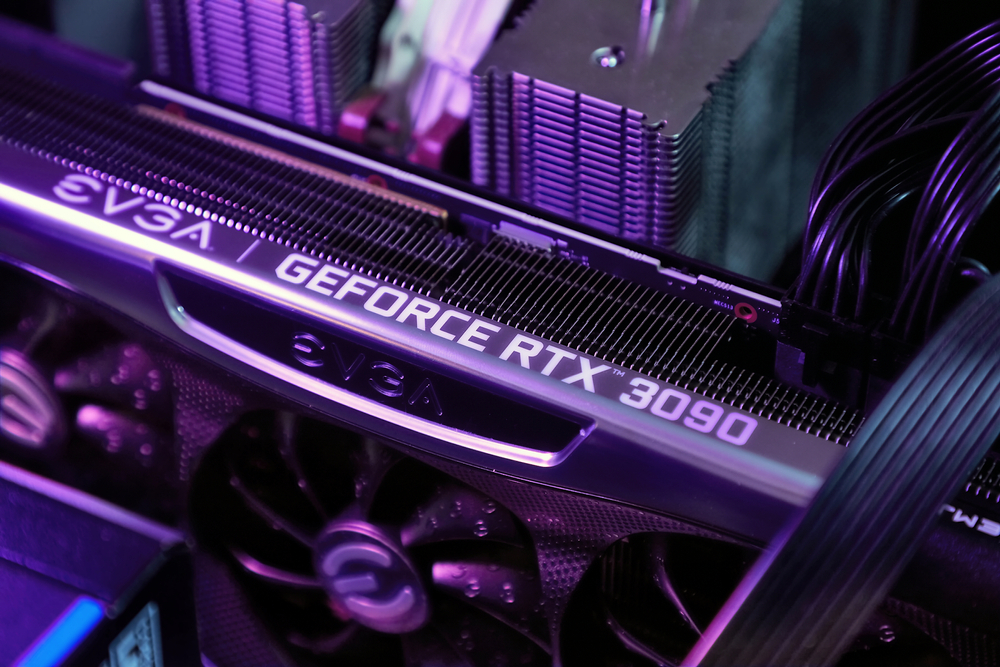

Du kan last ned Chat med RTX gratis, men du må kjøre Windows 10 eller 11 på PC-en din med en GPU i GeForce RTX 30-serien eller høyere, med minst 8 GB VRAM.

Chat med RTX er en demo, ikke et ferdig produkt. Den er litt buggy og husker ikke konteksten, så du kan ikke stille den oppfølgingsspørsmål. Men det er et fint eksempel på hvordan vi kommer til å bruke LLM-er i fremtiden.

Å bruke en AI-chatbot lokalt uten API-kostnader og med svært liten ventetid er sannsynligvis måten de fleste brukere til slutt vil samhandle med LLM-er på. Open source-tilnærmingen som selskaper som Meta har tatt, vil føre til at AI på enheten driver adopsjonen av deres gratis modeller i stedet for proprietære modeller som GPT.

Når det er sagt, må brukere av mobile og bærbare datamaskiner vente en stund til før datakraften til en RTX GPU får plass i mindre enheter.