Kan mennesker lære å oppdage AI-genererte forfalskninger på en pålitelig måte? Hvordan påvirker de oss på et kognitivt nivå?

OpenAIs Sora-system nylig en forsmak på en ny bølge av syntetiske AI-drevne medier. Det vil sannsynligvis ikke ta lang tid før enhver form for realistiske medier - lyd, video eller bilde - kan genereres med instruksjoner på bare noen sekunder.

Etter hvert som disse AI-systemene blir stadig dyktigere, må vi utvikle nye ferdigheter i kritisk tenkning for å skille sannhet fra fiksjon.

Hittil har Big Techs innsats for å bremse eller stoppe deep fakes ikke ført til stort annet enn følelser, ikke på grunn av manglende overbevisning, men fordi AI-innholdet er så realistisk.

Det gjør det vanskelig å oppdage på pikselnivåmens andre signaler, som metadata og vannmerker, har sine svakheter.

Selv om AI-generert innhold kunne oppdages i stor skala, er det dessuten utfordrende å skille autentisk, målrettet innhold fra innhold som har til hensikt å spre feilinformasjon.

En mulig løsning er å sende innhold til menneskelige korrekturlesere og bruke "community notes" (informasjon knyttet til innhold, ofte sett på X). Dette innebærer imidlertid noen ganger subjektiv tolkning og risiko for feilmerking.

For eksempel, i Israel-Palestina-konfliktenhar vi vært vitne til urovekkende bilder som er blitt stemplet som ekte når de var falske og vice versa.

Når et ekte bilde blir stemplet som falskt, kan dette skape enLøgnerens utbytte...", der noen eller noe kan avfeie sannheten som falsk.

Så hva kan vi gjøre med det, i mangel av tekniske metoder for å stoppe dype forfalskninger på teknologisiden?

Og i hvilken grad påvirker deep fakes beslutningsprosessen og psykologien vår?

Når folk for eksempel blir eksponert for falske politiske bilder, har dette en konkret innvirkning på deres stemmegivning?

La oss ta en titt på et par studier som vurderer nettopp dette.

Påvirker dype forfalskninger våre meninger og psykologiske tilstander?

En studie fra 2020I rapporten "Deepfakes and Disinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News", undersøkte hvordan falske videoer påvirker publikums oppfatning, særlig når det gjelder tillit til nyheter som deles på sosiale medier.

Forskningen involverte et storskalaeksperiment med 2505 deltakere fra Storbritannia, som skulle måle reaksjonene på ulike typer falske videoer av USAs tidligere president Barack Obama.

Deltakerne ble tilfeldig tildelt én av tre videoer:

- Et 4-sekunders klipp som viser Obama komme med en overraskende uttalelse uten noen kontekst.

- Et 26 sekunder langt klipp som inneholdt noen hint om videoens kunstige natur, men som først og fremst var villedende.

- En full video med en "pedagogisk avsløring" der deep fake'ens kunstige natur eksplisitt avsløres, med Jordan Peele som forklarer teknologien bak deep fake'en.

Viktige funn

Studien undersøkte tre hovedområder:

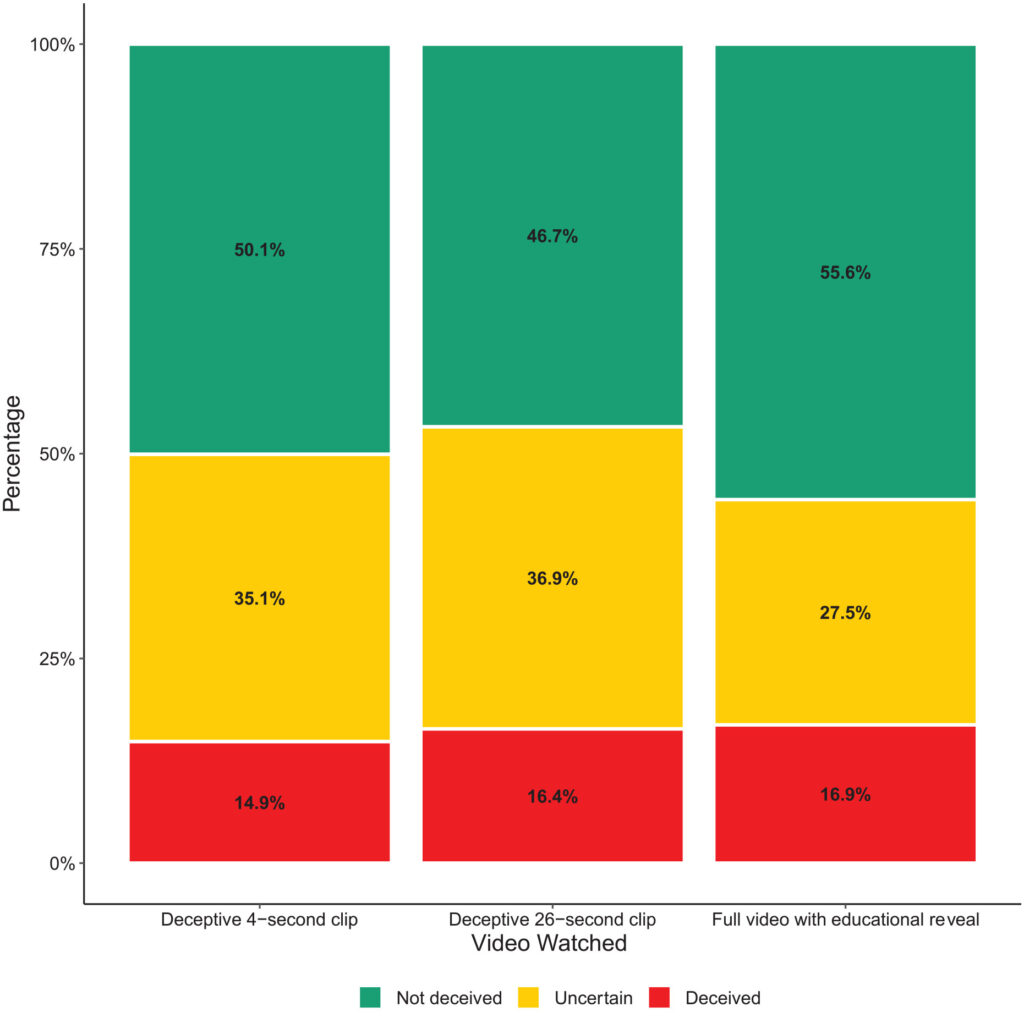

- Bedrageri: Studien fant minimalt med bevis på at deltakerne trodde på de falske påstandene i de dype forfalskningene. Andelen deltakere som ble villedet av de dype forfalskningene, var relativt lav i alle behandlingsgruppene.

- Usikkerhet: Et viktig resultat var imidlertid økt usikkerhet blant seerne, spesielt de som så de kortere, villedende klippene. Omtrent 35,1% av deltakerne som så 4-sekundersklippet og 36,9% av dem som så 26-sekundersklippet, rapporterte at de følte seg usikre på videoens autentisitet. I motsetning til dette var det bare 27,5% av dem som så hele undervisningsvideoen, som følte det på denne måten.

- Tillit til nyheter: Denne usikkerheten påvirket deltakernes tillit til nyheter på sosiale medier negativt. De som ble eksponert for de villedende, dype forfalskningene, viste lavere tillitsnivå enn de som så den pedagogiske avsløringen.

Dette viser at eksponering for falske bilder skaper usikkerhet på lengre sikt.

Over tid kan falske bilder svekke tilliten til all informasjon, inkludert sannheten.

Lignende resultater ble påvist av en nyere studie fra 2023, "Face/Off: Changing the face of movies with deepfake", som også konkluderte med at falske bilder har langsiktige virkninger.

Folk "husker" falskt innhold etter eksponering

Face/Off-studien, som ble gjennomført med 436 deltakere, undersøkte hvordan forfalskninger kan påvirke vår erindring av filmer.

Deltakerne deltok i en nettbasert spørreundersøkelse som hadde til hensikt å undersøke deres oppfatninger og minner om både virkelige og imaginære nyinnspillinger av film.

Undersøkelsen gikk ut på å presentere deltakerne for seks filmtitler, som inkluderte en blanding av fire faktiske og to fiktive nyinnspillinger.

Mfilmene ble randomisert og presentert i to formater: Halvparten av filmene ble introdusert gjennom korte tekstbeskrivelser, og den andre halvparten ble paret med korte videoklipp.

Fiktive nyinnspillinger av filmer som "The Shining", "The Matrix", "Indiana Jones" og "Captain Marvel", komplett med beskrivelser som feilaktig hevdet at høyprofilerte skuespillere var involvert i disse ikke-eksisterende nyinnspillingene.

Deltakerne ble for eksempel fortalt om en falsk nyinnspilling av "The Shining" med Brad Pitt og Angelina Jolie i hovedrollene, som aldri fant sted.

De ekte nyinnspillingene som ble presentert i undersøkelsen, som "Charlie & sjokoladefabrikken" og "Total Recall", ble derimot beskrevet nøyaktig og ledsaget av ekte filmklipp. Denne blandingen av ekte og falske nyinnspillinger hadde til hensikt å undersøke hvordan deltakerne skiller mellom faktisk og oppdiktet innhold.

Deltakerne ble spurt om de hadde sett originalfilmen eller nyinnspillingen, eller om de hadde kjennskap til dem fra før.

Viktige funn

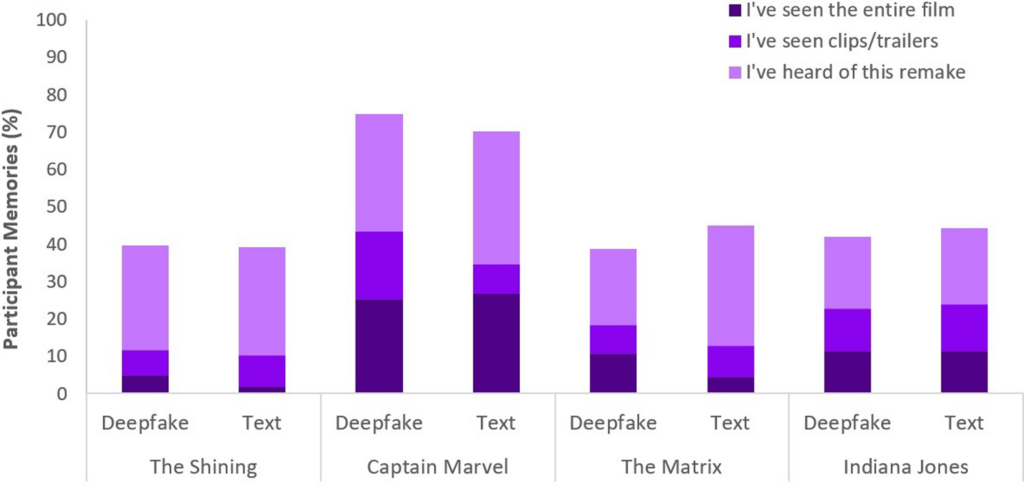

- Fenomenet med falske minner: Et viktig resultat av studien er avsløringen av at nesten halvparten av deltakerne (49%) utviklet falske minner etter å ha sett fiktive nyinnspillinger, for eksempel at de forestilte seg Will Smith som Neo i "The Matrix". Dette illustrerer den vedvarende effekten suggestive medier, enten det dreier seg om falske videoer eller tekstlige beskrivelser, kan ha på hukommelsen vår.

- Spesielt"Captain Marvel" toppet listen, med 73% av deltakerne som husket AI-remaken, etterfulgt av "Indiana Jones" med 43%, "The Matrix" med 42% og "The Shining" med 40%. Blant dem som feilaktig trodde på disse nyinnspillingene, mente 41% at nyinnspillingen av "Captain Marvel" var bedre enn originalen.

- Sammenlignende påvirkning av deep fakes og tekst: En annen oppdagelse er at dype forfalskninger, til tross for deres visuelle og auditive realisme, ikke var mer effektive når det gjaldt å endre deltakernes minner enn tekstlige beskrivelser av det samme fiktive innholdet. Dette tyder på at formatet på feilinformasjonen - visuelt eller tekstlig - ikke har noen vesentlig innvirkning på hukommelsesforvrengningen i forbindelse med film.

Fenomenet falske minner, som denne studien omhandler, er et mye utforsket fenomen. Det viser hvordan mennesker effektivt konstruerer eller rekonstruerer falske minner som vi er sikre på at er ekte, selv om de ikke er det.

Alle er utsatt for å konstruere falske minner, og deep-fakes ser ut til å aktivere denne atferden, noe som betyr at det å se på bestemt innhold kan endre vår oppfatning, selv når vi bevisst forstår at det er uekte.

I begge studiene hadde dype forfalskninger håndgripelige, potensielt langsiktige konsekvenser. Effekten kan komme snikende og akkumulere seg over tid.

Vi må også huske på at falskt innhold spres til millioner av mennesker, slik at små endringer i oppfatningen får konsekvenser for hele den globale befolkningen.

Hva gjør vi med dype forfalskninger?

Å gå til krig mot dype forfalskninger betyr å bekjempe den menneskelige hjernen.

Mens fremveksten av falske nyheter og feilinformasjon har tvunget folk til å utvikle ny mediekompetanse de siste årene, vil AI-genererte syntetiske medier kreve en ny grad av tilpasning.

Vi har stått overfor slike vendepunkter før, fra fotografi til CGI-spesialeffekter, men AI vil kreve en utvikling av våre kritiske sanser.

I dag må vi gå lenger enn bare å tro på øynene våre og stole mer på å analysere kilder og kontekstuelle ledetråder.

Det er viktig å stille spørsmål ved innholdets insentiver eller forutinntatthet. Stemmer det overens med kjente fakta eller motsier det dem? Finnes det bekreftende bevis fra andre pålitelige kilder?

Et annet viktig aspekt er å etablere juridiske standarder for å identifisere forfalskede eller manipulerte medier og holde skaperne ansvarlige.

Den US DEFIANCE Act, UK Online Safety Act, og tilsvarende lover over hele verden er i ferd med å etablere juridiske prosedyrer for håndtering av deep fakes. Hvor effektive de vil være, gjenstår å se.

Strategier for å avdekke sannheten

La oss avslutte med fem strategier for å identifisere og avhøre potensielle "deep fakes".

Selv om ingen enkeltstrategi er feilfri, er det beste vi kan gjøre i fellesskap for å minimere effekten av AI-feilinformasjon, å fremme kritisk tenkning.

- Kildebekreftelse: Det er grunnleggende å undersøke informasjonens troverdighet og opprinnelse. Autentisk innhold stammer ofte fra anerkjente kilder som kan dokumentere pålitelighet.

- Teknisk analyse: Til tross for at de er sofistikerte, kan dype forfalskninger ha subtile feil, for eksempel uregelmessige ansiktsuttrykk eller inkonsekvent belysning. Undersøk innholdet og vurder om det er digitalt endret.

- Kryssreferanser: Ved å verifisere informasjon mot flere pålitelige kilder kan man få et bredere perspektiv og bidra til å bekrefte innholdets autentisitet.

- Digitale ferdigheter: Å forstå mulighetene og begrensningene ved AI-teknologi er avgjørende for å kunne vurdere innholdet. Det vil være avgjørende at skoler og medier får opplæring i digitale ferdigheter, inkludert hvordan kunstig intelligens fungerer og hvilke etiske konsekvenser det har.

- Forsiktig interaksjon: Interaksjon med AI-generert feilinformasjon forsterker effekten av den. Vær forsiktig når du liker, deler eller reposter innhold du er usikker på.

I takt med at deep fakes utvikler seg, vil også teknikkene som kreves for å oppdage og begrense skadevirkningene, utvikle seg. 2024 vil bli et avslørende år, ettersom rundt halvparten av verdens befolkning skal stemme i viktige valg.

Mye tyder på at forfalskninger kan påvirke vår oppfatning, så det er langt fra utenkelig å tro at AI-feilinformasjon kan ha en vesentlig innvirkning på resultatene.

Etisk AI-praksis, digital kompetanse, regulering og kritisk engasjement vil være avgjørende for å skape en fremtid der teknologien forsterker sannheten i stedet for å tilsløre den.