En gruppe Chicago-baserte utviklere har utstyrt kunstnere med Nightshade, en metode for å slå tilbake mot uetisk datapraksis.

Nightshade er et sofistikert verktøy som er utviklet for å beskytte digitale kunstverk mot uautorisert bruk i AI-trening ved å introdusere "giftige" prøver.

Disse endringene er umerkelige for det menneskelige øyet, men forstyrrer den kunstige intelligensens læringsprosess og fører til feilaktige assosiasjoner og responser.

Den skriver forskerne"Menneskeøyne kan se et skyggelagt bilde av en ku på et grønt jorde stort sett uforandret, men en AI-modell kan se en stor skinnveske som ligger i gresset."

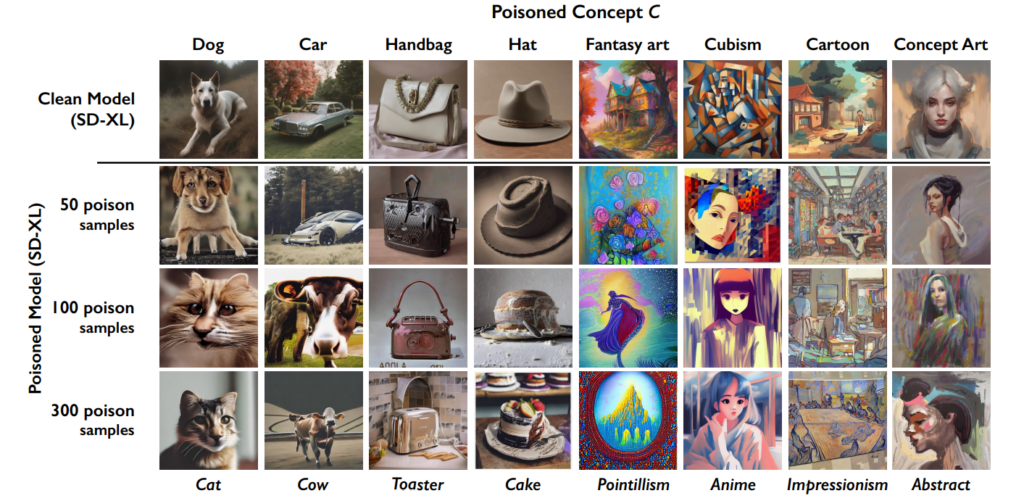

Effekten akkumuleres, så jo flere "forgiftede" bilder som havner i et datasett, desto mer svekkes modellens ytelse.

Dette verktøyet kommer i tillegg til University of Chicagos tidligere kreasjon, Glaze, som også hjelper kunstnere med å bekjempe dataskraping. "Glaze kan endre ting som farger og penselstrøk, og presentere en annen kunstnerisk stil enn det som faktisk er der", forklarer utviklerne.

Nightshade har imidlertid en annen tilnærming enn Glaze. "Mens Glaze var et defensivt verktøy, er Nightshade designet for å være et offensivt verktøy", sier teamet.

Jeg er veldig glad for å kunne dele at "Artifact" har blitt Glazed og Nightshaded av @TheGlazeProject og for et perfekt verk til det også. Dette er et maleri om generativ AI som kannibaliserer den autentiske stemmen til menneskelige kreatører. Når dette bildet skrapes for trening, vel ... pic.twitter.com/0VNFIyabc2

- Kelly McKernan (@Kelly_McKernan) 14. januar 2024

Hvordan Nightshade fungerer i fem trinn

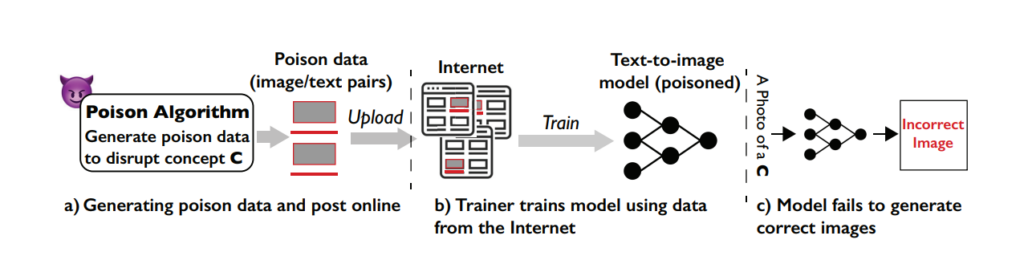

Nightshade er et smart verktøy som bruker maskinlæringsfunksjonene som er involvert i modellopplæringen, mot systemet selv, noe som forgifter læringsprosessen og fører til dårligere resultater på tvers av ulike modeller.

Forstå sårbarheten

Nightshade-angrepet utnytter en spesifikk svakhet i generative tekst-til-bilde-modeller. Disse AI-modellene er trent opp på store datasett med bilder og tilhørende tekstbeskrivelser.

Teamet fra University of Chicago oppdaget imidlertid at mengden treningsdata er ganske begrenset for visse spesifikke spørsmål eller emner. Dette begrensede datagrunnlaget for spesifikke spørsmål gjør disse modellene sårbare for målrettede dataforgiftningsangrep.

Konseptet bak Nightshade

Nightshade er en sofistikert metode som er utviklet for å utføre det som kalles et prompt-spesifikt forgiftningsangrep.

Enkelt sagt er det som å introdusere en liten, nøye utformet feil i AI-ens læringsprosess, noe som fører til betydelige og målrettede feil når AI-en genererer bilder basert på visse instruksjoner.

Nightshades nøkkelfunksjon er evnen til å produsere "forgiftede" prøver som ser normale ut for et menneske, men som er radikalt annerledes når det gjelder hvordan den kunstige intelligensen oppfatter og lærer av dem.

Opprette giftprøver

For å utføre et Nightshade-angrep genererer forskerne først det de kaller "ankerbilder". Dette er bilder av et konsept som ikke er relatert til det faktiske målet for angrepet.

Hvis målbegrepet for eksempel er "hund", kan ankerbildene være av "katter". Disse ankerbildene genereres av en AI-modell som brukerne kjører på PC-en sin.

Deretter finner forskerne virkelige bilder av målkonseptet (for eksempel hunder) og modifiserer dem subtilt slik at de stemmer overens med trekkene i ankerbildene i AI-ens oppfatning.

For et menneske ser disse modifiserte bildene fortsatt ut som hunder, men for den kunstige intelligensen ligner de mer på katter. Selv om det kan være vanskelig å forstå, er det viktig å huske at formene og figurene som skaper bilder, alltid er fundamentalt like.

Endringene kalles adversarial perturbation. De er nøye beregnet for å flytte bildets representasjon i AI-ens funksjonsrom fra regionen som forbindes med katter, til den som forbindes med hunder.

Hvordan angrepet påvirker AI-modeller

Når en generativ AI-modell trenes opp på disse forgiftede prøvene, begynner den å assosiere egenskapene til det urelaterte konseptet (katter) med målkonseptet (hunder).

Når AI-modellen blir bedt om å generere bilder av hunder, kan den derfor produsere bilder av katter i stedet. Dette skyldes at modellens forståelse av hva som utgjør en "hund", har blitt fordreid av de forgiftede dataene.

Selv om dette ikke "ødelegger" en AI-modell fullstendig, gjør det den mindre effektiv og mer uforutsigbar, noe som absolutt kan svekke brukervennligheten.

AI-selskaper vil sannsynligvis slå tilbake mot Nightshade og lignende teknikker, men det kommer til å kreve tid og innsats.

Påvirkning

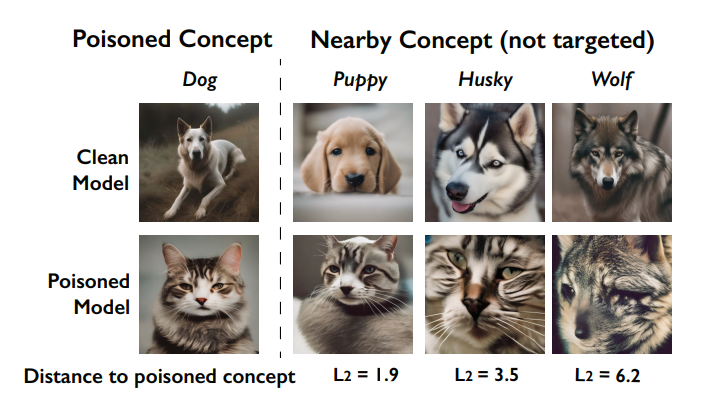

En viktig effekt av Nightshade-angrepet er at det "blør gjennom". Det betyr at forgiftningen av ett konsept kan påvirke beslektede konsepter.

Hvis man for eksempel forgifter begrepet "hund", kan det også påvirke hvordan modellen genererer bilder av beslektede dyr som "ulv" eller "rev".

blir ødelagt av forgiftningen (kalt gjennomblødningseffekten). Kilde: Universitetet i Chicago via ArXiv

Når flere begreper forgiftes i en modell, kan det dessuten ødelegge modellens evne til å generere sammenhengende bilder for et bredt spekter av spørsmål.

Hvordan kunstnere kan bruke Nightshade

Nightshade er et verktøy du laster ned og bruker selv, men det er ganske ressurskrevende og krever en kompatibel Nvidia GPU med minst 4 G minne.

Denne prosessen kan bli forenklet i fremtiden, eller det kan finnes skytjenester der du bare kan laste opp bildene dine for å få dem Nightshade'd for deg.

Slik bruker du Nightshade:

- Velg kunstverk: Du kan enten dra et enkelt bilde inn i bildeplassholderen eller velge flere bilder ved hjelp av "Velg..."-knappen.

- Juster parametrene: Intensiteten bestemmer styrken på Nightshades effekt. En høyere intensitet fører til en kraftigere forstyrrelse, men kan føre til merkbare endringer i kunstverket ditt. Renderingskvalitet angir beregningstiden for å finne det optimale giftnivået. Høyere kvalitet gir sterkere gift, men krever mer tid. Hvis du har en GPU, vil denne prosessen gå raskere.

- Velg utdatakatalog: Velg hvor du vil at Nightshaded-bildene skal lagres.

- Velg giftmerke: Nightshade fungerer ved å villede AI om visse begreper i bildet ditt. Den kan for eksempel endre bilder som er tagget som "bil" til å bli oppfattet som "ku" av AI-modeller. Nightshade foreslår en tagg basert på innholdsanalysen når bildet ditt velges. Sørg for at taggen gjenspeiler nøkkelkonseptet i bildet, og juster om nødvendig. Effekten av Nightshade øker når bildet ditt assosieres med denne taggen gjennom alt-tekst, bildetekster eller tekst i nærheten.

- Kjør Nightshade: Når du har fullført innstillingene og bekreftet bildekoden, starter du prosessen ved å trykke på "Kjør"-knappen. De endrede bildene lagres i den valgte utdatakatalogen.

- Du finner detaljerte instruksjoner i offisiell brukerveiledning her.

Community mottakelse til Nightshade mottakelse

Det har vært overveldende støtte til kunstnere som prøver å forsvare verkene sine mot AI, men som alltid er det flere fraksjoner, og noen sammenligner det med et cyberangrep på AI-modeller.

Som svar til kritikerne presiserer teamet: "Nightshades mål er ikke å ødelegge modeller, men å øke kostnadene ved å trene på ulisensierte data, slik at lisensiering av bilder fra skaperne blir et levedyktig alternativ."

"Brukt på en ansvarlig måte kan Nightshade bidra til å avskrekke modelltrenere som ikke overholder opphavsrettigheter, opt-out-lister og do-not-scrape/robots.txt-direktiver", hevder de.

Debatten rundt dataskraping og AI-modelltrening har blitt ekstremt bitter etter kontroversen på Midjourney og en flom av selskaper som bruker AI-genererte kunstverk og erstatter menneskelig arbeidskraft i prosessen.

Nightshade er ute!

Nightshade forgifter AI-modeller hvis kunsten eller bildene dine blir tatt uten tillatelse, Glaze beskytter deg mot AI-efterligning. Vi anbefaler at du bruker Nightshade først, og deretter Glaze. En versjon som gjør begge deler, er på vei.

Les denne tråden for mer informasjon.

Gå og ta dem 🫡 https://t.co/bU8EDthUcS pic.twitter.com/YddNu8xmJm

- Reid Southen (@Rahll) 19. januar 2024

Plutselig føles det som om det er et stadig større tomrom mellom teknologiselskaper som markedsfører AI som en filantropisk kraft, og publikum, som føler at AI griper for langt inn i kulturen og samfunnet.

Nightshade er faktisk ikke bare nyttig for kunstnere. Folk oppfordrer så mange som mulig til å bruke disse verktøyene, noe som skaper en mindre mengde data av høy kvalitet som AI-selskapene kan skrape.

Men har bedriftene nok data allerede? Kanskje for øyeblikket, men for å holde modellene tidsriktige og oppdaterte, må AI-utviklerne på et eller annet tidspunkt legge inn nye data i systemene sine.

#nightshade

Profftips: Bruk Nightshade på alt du laster opp på nettet (ikke bare kunsten din), bilder i sosiale medier, daglige bilder av måltidet ditt, familien, valper, kattunger, tilfeldige selfies og gatebilder - og la spillet begynne.- rediger ballai 🌿 (@eballai) 19. januar 2024

I Glaze og Nightshade ser vi en gryende teknologisk og etisk kamp mellom skaperne og AI-selskapene.

Det kommer til å bli mer og mer interessant, og kan det finnes lignende måter å lure og forgifte språkmodeller på?

Dette, kombinert med juridiske kamper, kan føre til at generativ AI går inn i en ustabil periode. Det kommer til å bli et stort år for teknologien.