En undersøkelse utført av The Guardian har kastet lys over Storbritannias gjennomgripende bruk av kunstig intelligens og komplekse algoritmer i ulike beslutningsprosesser i offentlig sektor.

Tjenestemenn fra minst åtte offentlige etater og flere politienheter har tatt i bruk AI-verktøy i arbeidsflyten sin.

AI-verktøy har bidratt til viktige beslutningsprosesser innen velferd, innvandring og strafferettspleie. Etterforskningen avdekket bevis på misbruk og diskriminering.

Selv om algoritmisk og AI-relatert skjevhet ikke strengt tatt faller inn under samme definisjon, risikerer begge å gi skjeve resultater når de utsettes for virkelige scenarier. Selvlærende maskinlæringsmodeller kan forsterke skjevheter som dominerer i datasett.

I henhold til rapport:

- Et parlamentsmedlem har uttrykt bekymring for en algoritme som brukes av Department for Work and Pensions (DWP), og som mistenkes for å ha ført til at mange personer feilaktig har mistet ytelsene sine.

- Det har vist seg at Metropolitan Police's ansiktsgjenkjenningsverktøy har en høyere feilprosent når det gjelder å identifisere svarte ansikter sammenlignet med hvite ansikter under visse forhold. Dette er veletablert, med én studie som indikerer at disse plattformene hadde en nøyaktighet på beskjedne 2% i 2018.

- Innenriksdepartementet har brukt en algoritme som i uforholdsmessig stor grad retter seg mot personer fra bestemte nasjonaliteter for å avdekke falske ekteskap som gir rett til trygdeytelser og skattelettelser. Statsborgere fra Albania, Hellas, Romania og Bulgaria kan ha blitt urettferdig flagget.

AI-verktøy lærer mønstre fra omfattende datasett. Hvis datasettene er partiske eller lite representative for virkeligheten, arver modellen disse mønstrene.

Det finnes mange internasjonale eksempler på AI-relaterte og algoritmiske skjevheter, blant annet falske ansiktsgjenkjenninger som fører til fengselsstraff, kredittvurderingssystemer å påføre kvinner fordommerog diskriminerende verktøy som brukes i domstoler og helsevesen.

The Guardians rapport hevder at Storbritannia nå befinner seg på randen av en potensiell skandale, med eksperter som uttrykker bekymring for åpenheten og forståelsen av algoritmene som brukes av tjenestemenn.

Skandaler har allerede blitt bevitnet i andre landsom for eksempel i USA, hvor plattformene for forutseende politiarbeid har blitt avvikletog i Nederland, der domstolene motsatte seg et AI-system som skulle hindre trygdesvindel.

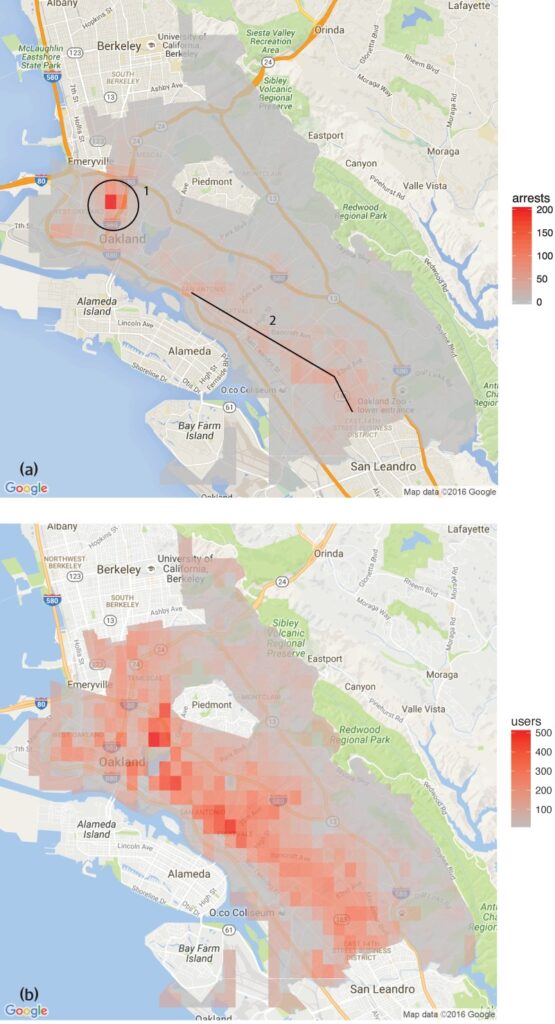

En studie utført av Human Rights Data Analysis Group fant at programvaren for forutseende politiarbeid som ble brukt i Oakland i California, i uforholdsmessig stor grad var rettet mot fargede befolkningsgrupper, noe som opprettholdt en sirkel av overpoliti i disse nabolagene.

Dette gjenspeiler bekymringene som ble reist av Metropolitan Police's verktøy for ansiktsgjenkjenningsom viste høyere feilprosent ved identifisering av svarte ansikter under visse forhold.

Det finnes flere eksempler på dette også i helsevesenet, for eksempel inkonsekvenser i AI-modeller som er utviklet for å oppdage hudkreft. I de fleste tilfeller er det minoritetsgrupper og kvinner som har høyest risiko.

Shameem Ahmad, administrerende direktør i Public Law Project, understreket behovet for umiddelbar handling: "AI har et enormt potensial for sosiale goder. Vi kan for eksempel gjøre ting mer effektivt. Men vi kan ikke ignorere de alvorlige risikoene. Hvis vi ikke handler raskt, kan vi gå i søvne inn i en situasjon der ugjennomsiktige automatiserte systemer regelmessig, og muligens ulovlig, brukes på livsforandrende måter, og der folk ikke vil være i stand til å søke oppreisning når disse prosessene går galt."

Marion Oswald, jussprofessor ved Northumbria University, er enig i disse bekymringene og har påpekt inkonsekvensene og mangelen på åpenhet i bruken av kunstig intelligens i offentlig sektor: "Det er mangel på konsekvens og åpenhet i måten kunstig intelligens brukes på i offentlig sektor. Mange av disse verktøyene vil påvirke mange mennesker i hverdagen, for eksempel de som søker om ytelser, men folk forstår ikke hvorfor de brukes og har ikke mulighet til å utfordre dem."

Risikoen AI utgjør for offentlig sektor

Den ukontrollerte bruken av kunstig intelligens i offentlige etater og politistyrker gir grunn til bekymring når det gjelder ansvarlighet, åpenhet og partiskhet.

The Guardians rapport avslørte tilfeller der en algoritme i Department for Work and Pensions (DWP) stanset folks ytelser uten en klar forklaring.

Parlamentsmedlem Kate Osamor sa at hennes bulgarske velgere mistet ytelsene sine på grunn av et halvautomatisk system som flagget sakene deres for mulig svindel, noe som understreker mangelen på åpenhet.

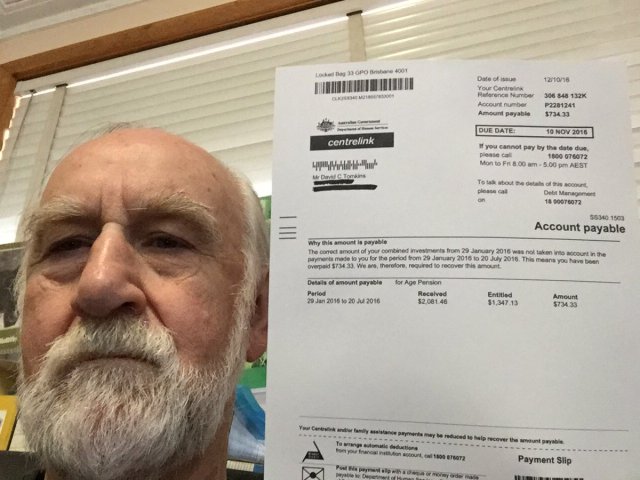

Dette minner om "Robodebt"-skandalen i Australia, der et automatisert system feilaktig anklaget over 400 000 mennesker for trygdesvindel, noe som førte til omfattende vanskeligheter.

Robodebt-skandalen, som ble etterforsket av Commonwealth Ombudsman, rettslige utfordringer og offentlige granskninger, viste hvor store konsekvenser algoritmiske beslutninger kan ha.

Den australske regjeringen gikk med på et forlik på $1,8 milliarder AUS i 2021.

Det er ikke bare offentlige tjenester som har mangler når det gjelder kunstig intelligens. Også i næringslivet har man sett feil, særlig når det gjelder AI-drevne rekrutteringsverktøy.

Et kjent eksempel er Amazons AI-rekrutteringsverktøy, som viste seg å favorisere kvinnelige kandidater. Systemet ble trent på CV-er som ble sendt inn til selskapet over en tiårsperiode, og de fleste av disse kom fra menn, noe som resulterte i at AI-en favoriserte mannlige kandidater.

Tre eksempler på algoritmiske skjevheter du bør være på vakt mot

Etter hvert som kunstig intelligens og algoritmiske beslutningsprosesser integreres i komplekse samfunnsprosesser, ser vi stadig flere alarmerende eksempler på fordommer og diskriminering.

Det amerikanske helse- og rettssystemet

En studie fra 2019 publisert i Science avslørte at en mye brukt helsealgoritme i USA hadde rasistiske skjevheter. Algoritmen henviste i mindre grad svarte personer til programmer som skulle forbedre behandlingen av pasienter med komplekse medisinske behov, enn hvite personer.

Studien forklarer hvorfor: "Skjevheten oppstår fordi algoritmen bruker helsekostnader som et mål for helsebehov. Det brukes mindre penger på svarte pasienter som har samme behovsnivå, og algoritmen konkluderer dermed feilaktig med at svarte pasienter er friskere enn like syke hvite pasienter."

Et annet viktig eksempel er bruken av kunstig intelligens i forutseende politiarbeid og straffeutmåling. Verktøy som Profilering av lovbrytere for alternative straffereaksjoner (COMPAS) har blitt brukt til å vurdere risikoen for at tiltalte begår nye lovbrudd.

Undersøkelser har avdekket at disse verktøyene kan være partiske mot afroamerikanske tiltalte, ved at de tildeler dem høyere risikoscore enn deres hvite motparter. Dette gir grunn til bekymring for rettferdigheten og upartiskheten i AI-assistert rettslig beslutningstaking.

Ansiktsgjenkjenning i Brasil

Den Smart Sampa-prosjektet i São Paulo, Brasil, markerte en viktig milepæl i integreringen av kunstig intelligens og overvåking i bylandskapet - noe som tidligere bare har vært vanlig i Kina.

Innen 2024 har de som mål å installere opptil 20 000 kameraer i São Paulo og integrere like mange tredjepartskameraer og private kameraer i én enkelt videoovervåkingsplattform. Dette nettverket vil overvåke offentlige områder, helseinstitusjoner og skoler, og granske innhold i sosiale medier som er relevant for offentlig administrasjon.

Selv om Smart Sampa lover økt sikkerhet og bedre offentlige tjenester, advarer eksperter mot at det kan forsterke eksisterende samfunnsproblemer, særlig strukturell rasisme og ulikhet.

Over 90% av alle personer som blir arrestert i Brasil basert på ansiktsgjenkjenning, er svarte. São Paulos initiativ risikerer å videreføre denne trenden og ytterligere marginalisere det svarte samfunnet, som utgjør 56% av Brasils befolkning.

Teknologier for ansiktsgjenkjenning identifiserer ofte mørkere hudtoner feil, delvis fordi bildebehandlingsteknologien ikke fungerer optimalt for mørkere hudtoner, og delvis fordi treningsdatasettene ikke er representative.

Fernanda Rodrigues, advokat med ansvar for digitale rettigheter, understreket potensialet for falske positiver og den påfølgende risikoen for massefengsling av svarte personer.

Rodrigues sa: "I tillegg til risikoen for at informasjonen som mates inn på disse plattformene ikke er nøyaktig, og at selve systemet kan svikte, er det et problem som går forut for de teknologiske implikasjonene, nemlig rasisme."

"Vi vet at straffesystemet i Brasil er selektivt, så vi kan konkludere med at [bruk av overvåking med ansiktsgjenkjenning] handler om å øke risikoen og skadevirkningene for denne befolkningen", legger hun til.

Hensynet til personvernet står også sentralt. Kritikerne hevder at Smart Sampa kan krenke grunnleggende menneskerettigheter, inkludert personvern, ytrings-, forsamlings- og foreningsfrihet. Prosjektets ugjennomsiktige natur kompliserte saken ytterligere, med begrenset offentlig engasjement i høringsfasen.

Smart Sampa har ikke stått uimotsagt. Statsadvokater har etterforsket saken, og menneskerettighetsorganisasjoner har tatt initiativ til rettslige skritt for å stanse teknologien.

Den nederlandske systemrisikoindikatoren (SyRI)

I 2022 gransket Haag tingrett den nederlandske regjeringens bruk av Systemrisikoindikasjon (SyRI)en algoritme som er utviklet for å avdekke potensielt trygdesvindel.

SyRI var ment å effektivisere arbeidet med å identifisere trygdesvindel ved å samle data fra ulike offentlige databaser og bruke risikoindikatorer til å generere profiler av potensielle svindlere. Mistenkelige avgjørelser og mangel på åpenhet fikk imidlertid alarmklokkene til å ringe, noe som førte til at en koalisjon av sivilsamfunnsorganisasjoner gikk til søksmål.

Saksøkerne hevdet at SyRI brøt med ulike internasjonale og europeiske menneskerettighetslover. De satte også spørsmålstegn ved lovligheten, nødvendigheten og forholdsmessigheten av algoritmens anvendelse.

Tingretten i Haag slo fast at lovgivningen som regulerer SyRI og bruken av den, ikke oppfyller de nødvendige menneskerettighetsstandardene. Retten fremhevet mangelen på åpenhet og potensialet for diskriminerende effekter, og understreket behovet for tilstrekkelige rettssikkerhetsgarantier ved implementering av slike teknologier.

Saken har blitt hyllet som en av de første som tar for seg menneskerettighetskonsekvensene av kunstig intelligens i offentlig sektor, og den understreker behovet for åpenhet, ansvarlighet og robuste juridiske rammeverk.

Åpen og rettferdig testing av verktøy er avgjørende

I kjølvannet av den siste tidens rettslige utfordringer og offentlig granskning av algoritmiske beslutningsprosesser i offentlige virksomheter har kravet om åpen testing av AI-verktøy blitt stadig mer presserende.

For å sikre ansvarlighet, forhindre diskriminering og opprettholde offentlig tillit er det viktig å implementere strenge og åpne testprotokoller.

Åpen testing gir en omfattende forståelse av hvordan disse algoritmene fungerer, hvilke data de bruker, og hvilke beslutningsprosesser de følger. Dette er avgjørende for å identifisere potensielle skjevheter, unøyaktigheter eller diskriminerende praksis som er innebygd i systemet.

Men strenge testprosedyrer er i strid med AIs løfte om hurtigvirkende effektivitet.

I Storbritannias tilfelle har statsminister Rishi Sunaks "innovasjonsvennlig" holdningDet gir kanskje ikke rom for omfattende testprosedyrer. Dessuten finnes det få - om noen - omforente prosesser for testing av KI-verktøy før de distribueres til offentlig bruk.

Dette scenarioet gjenspeiles over hele verden. Den raskt økende bruken av kunstig intelligens bør ikke gå på bekostning av gransking og analyse.