Den eksponentielle veksten av AI-systemer går raskere enn forskningen og reguleringen, noe som setter myndighetene i en vanskelig posisjon når de skal balansere fordeler og risiko.

Det tar mange år å utvikle lover og gjøre dem juridisk bindende. Kunstig intelligens utvikler seg ukentlig.

Det er den dikotomien AI-ledere og -politikere står overfor, med den første meningsfulle AI-reguleringen i Vesten, EUs AI Act, som kommer i 2026. Selv for ett år siden var ChatGPT bare noe man hvisket om.

Topptjenestemenn fra USA og EU møttes til US-EU Trade and Tech Council (TTC) 31. mai i Luleå i Sverige. Margrethe Vestager, Europas kommissær for digitalisering, som uken før møtte Google-sjef Sundar Pichai for å diskutere en mulig "AI-pakt", sa: "Demokratiet må vise at vi er like raske som teknologien."

Myndighetene erkjenner at det er et gap mellom teknologiens tempo og tempoet i lovgivningsprosessen. Gina Raimondo, USAs handelsminister, sa om generativ AI som ChatGPT: "Den kommer i et tempo som ingen annen teknologi."

Så hva oppnådde TTC-møtet?

Vannmerking, eksterne revisjoner, tilbakemeldingssløyfer - bare noen av ideene som ble diskutert med @AnthropicAI og @sama @OpenAI for #AI #CodeOfConduct lansert i dag på #TTC i #Luleå @SecRaimondo Vi ser frem til å diskutere med internasjonale partnere. pic.twitter.com/wV08KDNs3h

- Margrethe Vestager (@vestager) 31. mai 2023

Deltakerne diskuterte først og fremst ikke-bindende eller frivillige rammeverk for risiko og åpenhet, som vil bli presentert for G7 til høsten.

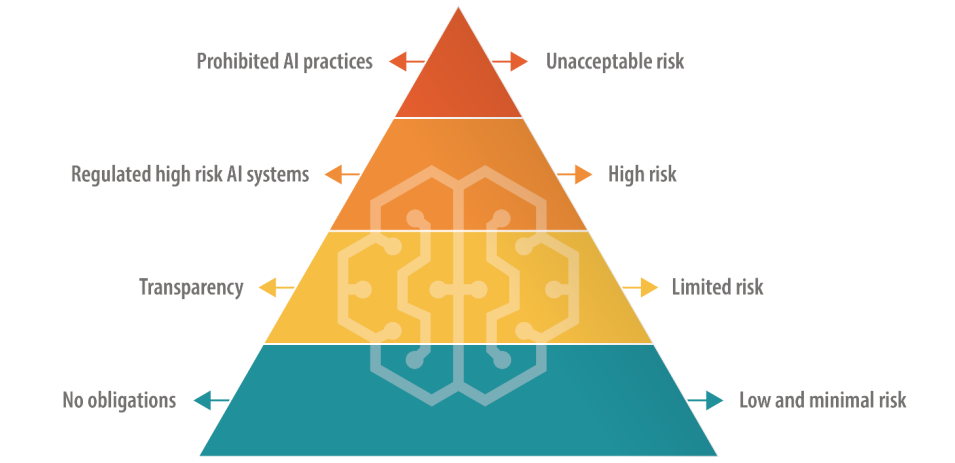

EU, som har en direkte tilnærming til digital lovgivning, har valgt en trinnvis tilnærming til AI-regulering, der AI sorteres i kategorier basert på risiko.

Dette inkluderer et forbudt "uakseptabel risiko"-nivå og et "høy risiko"-nivå, som teknologisjefer som OpenAI-sjef Sam Altman frykter vil gå ut over produktenes funksjonalitet.

USA foreslår ikke slike definitive reguleringer, favoriserer frivillige regler.

Det vil kreve mange flere møter mellom EU, USA og de store teknologibedriftene for å få synspunktene på linje med meningsfull praktisk handling.

Vil frivillige AI-regler fungere?

Det finnes mange eksempler på frivillige regler i andre sektorer og bransjer, for eksempel frivillige rammeverk for datasikkerhet og ESG-rapportering, men ingen av dem ligger så tett opp til det nyeste som et frivillig rammeverk for styring av KI.

Vi har tross alt å gjøre med en trussel på utryddelsesnivå, ifølge toppledere innen teknologi og akademikere som er medunderskrivere av Center for AI Safetys uttalelse om AI-risiko denne uken.

Store selskaper som OpenAI og Google har allerede sentrale avdelinger som fokuserer på styring og intern etterlevelse, så det å tilpasse produktene og tjenestene deres til frivillige rammeverk kan være et spørsmål om å omskrive interne policydokumenter.

Frivillige regler er bedre enn ingenting, men med mange forslag på bordet må politikere og AI-ledere før eller siden velge noe å forholde seg til.