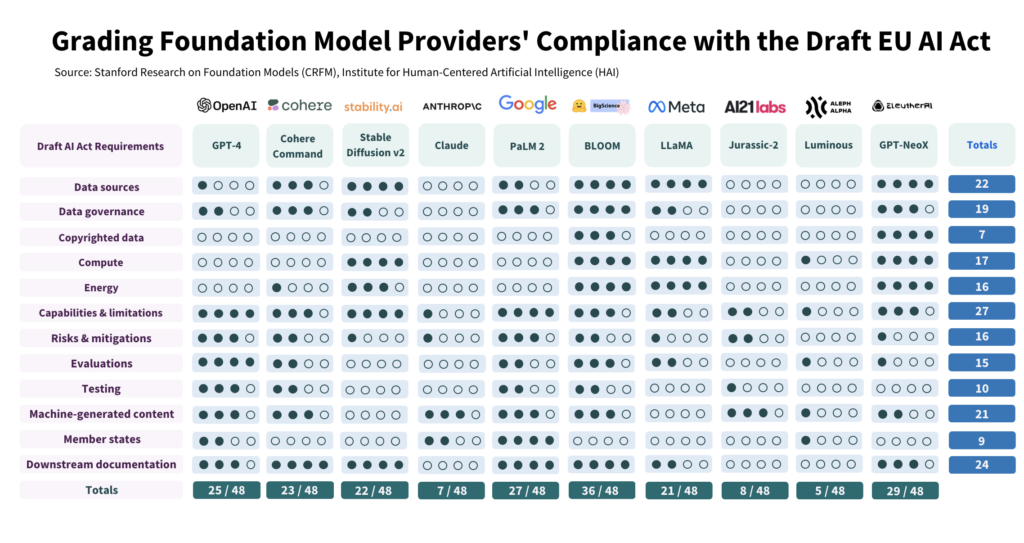

AI-forskere ved Stanford evaluerte 10 ledende AI-modellers samsvar med EUs foreslåtte AI-lov og fant store variasjoner, med generelt svake resultater over hele linjen.

Studien Vi har kritisk undersøkt 10 AI-modeller opp mot 12 kriterier som er fastsatt i EUs lovforslag, og avdekket store variasjoner i etterlevelsen - ingen modeller oppfyller alle kriteriene.

Studien belyser avgrunnen mellom forventningene i AI-loven og det nåværende styringsarbeidet blant ledende AI-utviklere.

For å overholde loven må utbyggerne forbedre åpenheten og risikoreduksjonsstrategiene sine betraktelig, noe som i noen tilfeller nesten helt mangler.

Hvordan studien ble gjennomført

Forfatterne har gjennomført en detaljert studie av AI-loven, og har trukket ut 22 krav.

Av disse valgte de ut 12 som kunne evalueres på en meningsfull måte ved hjelp av offentlig informasjon. Deretter laget de en fempunktsskala for hvert av disse 12 kravene.

Den åpne AI-modellen BLOOM, produsert av Hugging Face, kom ut som modellen med høyest poengsum, med totalt 36 av 48 mulige poeng.

Google-støttede Anthropic og det tyske AI-selskapet Aleph Alpha gjorde det derimot betydelig dårligere, med henholdsvis 7 og 5 poeng. ChatGPT havnet midt på treet med 25/48.

De fire viktigste områdene for manglende samsvar er opphavsrettslig beskyttet data, energi, risikoreduksjon og evaluering/testing.

En av forfatterne, Kevin Klyman, forsker ved Stanfords Center for Research on Foundation Models, bemerket at de fleste utviklere ikke opplyser om sine risikoreduserende strategier, noe som kan være en "dealbreaker". Klyman sa: "Tilbyderne oppgir ofte ikke hvor effektive deres risikoreduserende tiltak er, noe som betyr at vi ikke kan si noe om hvor risikable enkelte stiftelsesmodeller er."

Dessuten er det stor variasjon i treningsdataene som brukes til å trene modeller. EU vil kreve at AI-utviklere er mer åpne om datakildene sine, noe 4/10 av utviklerne ikke gjør. ChatGPT fikk bare 1 poeng på dette området.

Åpen kildekode versus proprietære modeller

Rapporten avdekket også en klar todeling i samsvar avhengig av om en modell var åpen kildekode eller proprietær.

Modeller med åpen kildekode oppnådde gode resultater når det gjelder ressursopplysning og datakrav, men risikoen er i stor grad udokumentert.

Proprietære modeller er det motsatte - de er grundig testet og veldokumenterte med robuste strategier for risikoreduksjon, men de er ugjennomsiktige når det gjelder data og teknologirelaterte beregninger.

Eller for å sette det på spissen: Open source-utviklere har ikke så mange konkurransehemmeligheter å beskytte, men produktene deres er i seg selv mer risikofylte, ettersom de kan brukes og endres av nesten hvem som helst.

Private utviklere vil sannsynligvis holde deler av modellene sine under lås og slå, men de kan påvise sikkerhet og risikoreduksjon. Selv Microsoft, OpenAIs hovedinvestor, er ikke helt forstå hvordan OpenAIs modeller fungerer.

Hva anbefaler studien?

Forfatterne av studien erkjenner at gapet mellom EUs forventninger og virkeligheten er alarmerende, og kommer med flere anbefalinger til beslutningstakere og modellutviklere.

Studien anbefaler EUs politiske beslutningstakere:

- Avgrense og spesifisere parametrene i EUs AI Act: Forskerne hevder at AI-lovens tekniske språk og parametere er underspesifiserte.

- Fremme åpenhet og ansvarlighet: Forskerne mener at de strengeste reglene bør være ultra-målrettede mot de aller største og mest dominerende utviklerne, noe som bør føre til en mer effektiv håndhevelse.

- Sørg for tilstrekkelige ressurser til håndheving: For at EUs AI Act skal kunne håndheves effektivt, bør håndhevingsorganene få tilgang til tekniske ressurser og kompetanse.

Studien anbefaler globale beslutningstakere:

- Prioriter åpenhet: Forskerne understreker at åpenhet er avgjørende og bør være hovedfokuset i det politiske arbeidet. De hevder at erfaringene fra reguleringen av sosiale medier viser de skadelige konsekvensene av mangelfull åpenhet, noe som ikke bør gjentas i forbindelse med kunstig intelligens.

- Avklare spørsmål om opphavsrett: Grensene for opphavsrett til AI-treningsdata og AI-resultater er omdiskutert. Med tanke på den lave overholdelsen som er observert når det gjelder å offentliggjøre opphavsrettsbeskyttede treningsdata, argumenterer forskerne for at juridiske retningslinjer må spesifisere hvordan opphavsrett samhandler med treningsprosedyrer og resultatet av generative modeller. Dette innebærer blant annet å definere vilkårene for opphavsrett eller lisenser som må respekteres under opplæring, og å fastslå hvordan maskingenerert innhold kan krenke opphavsretten.

Studien anbefaler utviklere av stiftelsesmodeller:

- Streber etter kontinuerlig forbedring: Tilbyderne bør hele tiden ha som mål å forbedre sin etterlevelse. Større leverandører, som OpenAI, bør gå foran med et godt eksempel og spre ressurser til nedstrømskunder som får tilgang til modellene deres via API.

- Talsmann for bransjestandarder: Modellleverandører bør bidra til å etablere bransjestandarder, noe som kan føre til et mer transparent og ansvarlig AI-økosystem.

Selv om det er noen positive ting å hente fra risiko- og overvåkingsstandardene som er etablert av ledende utviklere som OpenAI, er manglene på områder som opphavsrett langt fra ideelle.

Når det gjelder å anvende regulering på AI som en altomfattende kategori - som kan vise seg å bli svært vanskelig - ettersom kommersielle modeller og modeller med åpen kildekode er strukturelt forskjellige og vanskelige å slå sammen.