I slutten av mai brukte New York-advokaten Steven A. Schwartz ChatGPT til å undersøke rettssaker på vegne av en klient.

Schwartz og en kollega fra samme advokatfirma, Peter LoDuca, møtte torsdag for en dommer for å forklare sine handlinger.

Under høringen innrømmet begge advokatene at de hadde referert til falske rettssaker generert av ChatGPT.

Schwartz brukte ChatGPT til å finne rettspraksis til støtte for en klients sak mot det colombianske flyselskapet Avianca, som AI returnerte flere falske tilfeller og ett ekte tilfelle med grovt forandrede detaljer.

Schwartz siterte disse i saksøkerens prosesskrift, men da den amerikanske distriktsdommeren Kevin Castel mottok det, la han raskt merke til falske saker og sa: "Seks av de innsendte sakene ser ut til å være falske rettsavgjørelser med falske sitater og falske interne henvisninger."

"Jeg forsto ikke at ChatGPT kunne fabrikkere saker", tilsto Schwartz overfor Castel, og innrømmet at han hadde "operert under en misforståelse ... at dette nettstedet skaffet disse sakene fra en kilde jeg ikke hadde tilgang til."

Dommer Castel konfronterte dem med en spesielt oppdiktet rettssak som burde ha slått Schwartz som falsk. Saken ble først beskrevet som en sak om et dødsfall, men ble senere omgjort til en sak om en mann som ikke rakk flyet sitt og ble tvunget til å betale ekstrautgifter.

Med andre ord var det selv for en lekmann åpenbart at denne saken var falsk, så Schwartz leste sannsynligvis ikke AI-ens utdata ordentlig. "Kan vi være enige om at det er juridisk volapyk?" sa Castel om saken.

Schwartz ba om unnskyldning: "Jeg vil gjerne be oppriktig om unnskyldning", og sa at han følte seg "flau, ydmyket og ekstremt angrende".

LoDuca innrømmet at han ikke hadde satt seg godt nok inn i materialet Schwartz hadde samlet. Han sa: "Det gikk aldri opp for meg at dette var en falsk sak", og at utfallet "smerter meg til det ytterste".

Når det gjelder spørsmålet om hvorvidt duoen vil bli straffet, argumenterte advokat Ronald Minkoff for at parets handlinger "skyldtes uforsiktighet, ikke ond tro", og at de derfor ikke burde straffes.

Minkoff hevdet: "Herr Schwartz, som knapt nok driver med føderal forskning, valgte å bruke denne nye teknologien. Han trodde han hadde å gjøre med en standard søkemotor."

Den endelige dommen om sanksjoner er ennå ikke avsagt.

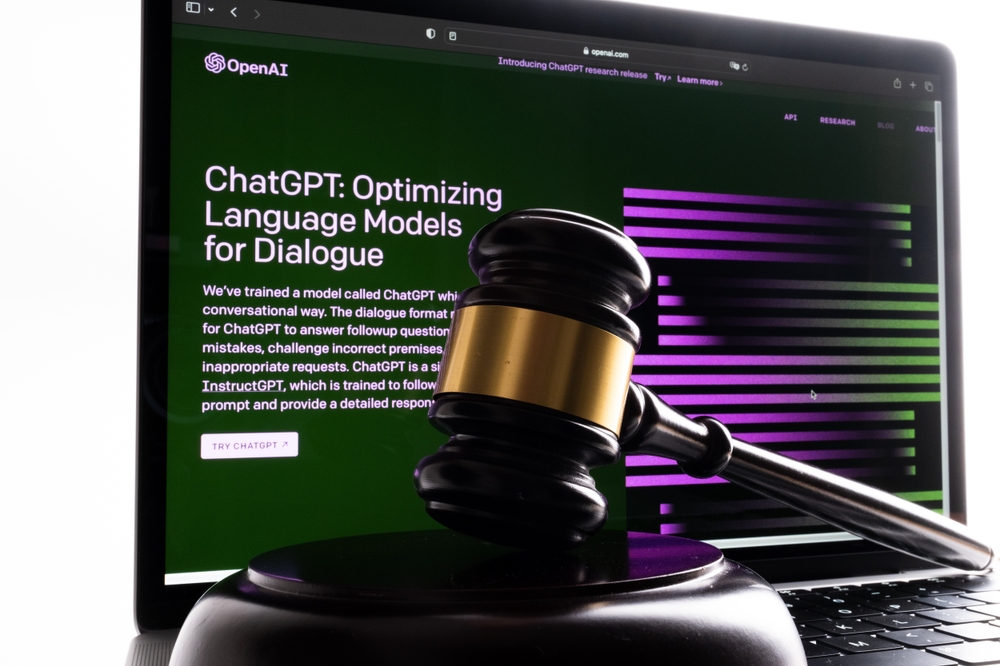

AI-"hallusinasjoner" skaper både etiske og juridiske problemer

En sekvens av rettssaker rammer OpenAIblant annet tre tilfeller av potensielle ærekrenkelser som oppsto da ChatGPTs utdata inneholdt falsk og ærekrenkende informasjon.

Utfallet her er annerledes. Dette er et eksempel på dårlig oppførsel som følge av råd hentet fra ChatGPTs utdata.

Daniel Shin, adjungert professor og assisterende forskningsdirektør ved Center for Legal and Court Technology ved William & Mary Law School, sa: "Dette var det første dokumenterte tilfellet av potensiell profesjonell forsømmelse av en advokat som bruker generativ AI."

Det var bare et spørsmål om tid før noen gjorde denne feilen. Schwartz var tilfeldigvis den første (som vi kjenner til) i det som har vist seg å være en presedens han sannsynligvis ikke hadde forventet å skape.