Advokaten Steven A. Schwartz fra New York brukte ChatGPT til å undersøke flere "saker" som viste seg å være falske.

Schwartz' sak gjaldt en mann som saksøkte det colombianske flyselskapet Avianca. Saksøkeren samarbeidet med advokatfirmaet Levidow, Levidow & Oberman, som utarbeidet et juridisk notat med henvisning til helt falske rettssaker.

Schwartz ba ChatGPT om en forsikring om at sakene var reelle, men han forsøkte bare å kryssjekke én av sakene i detalj, og ChatGPT forsikret ham om at den kunne finnes i databasene Westlaw og LexisNexis. På bakgrunn av dette antok Schwartz at også de andre sakene var reelle.

Det ble senere avslørt at bare ett tilfelle var reelt, Zicherman mot Korean Air Lines Co, 516 U.S. 217 (1996), og ChatGPT feilsiterte datoen og flere andre detaljer.

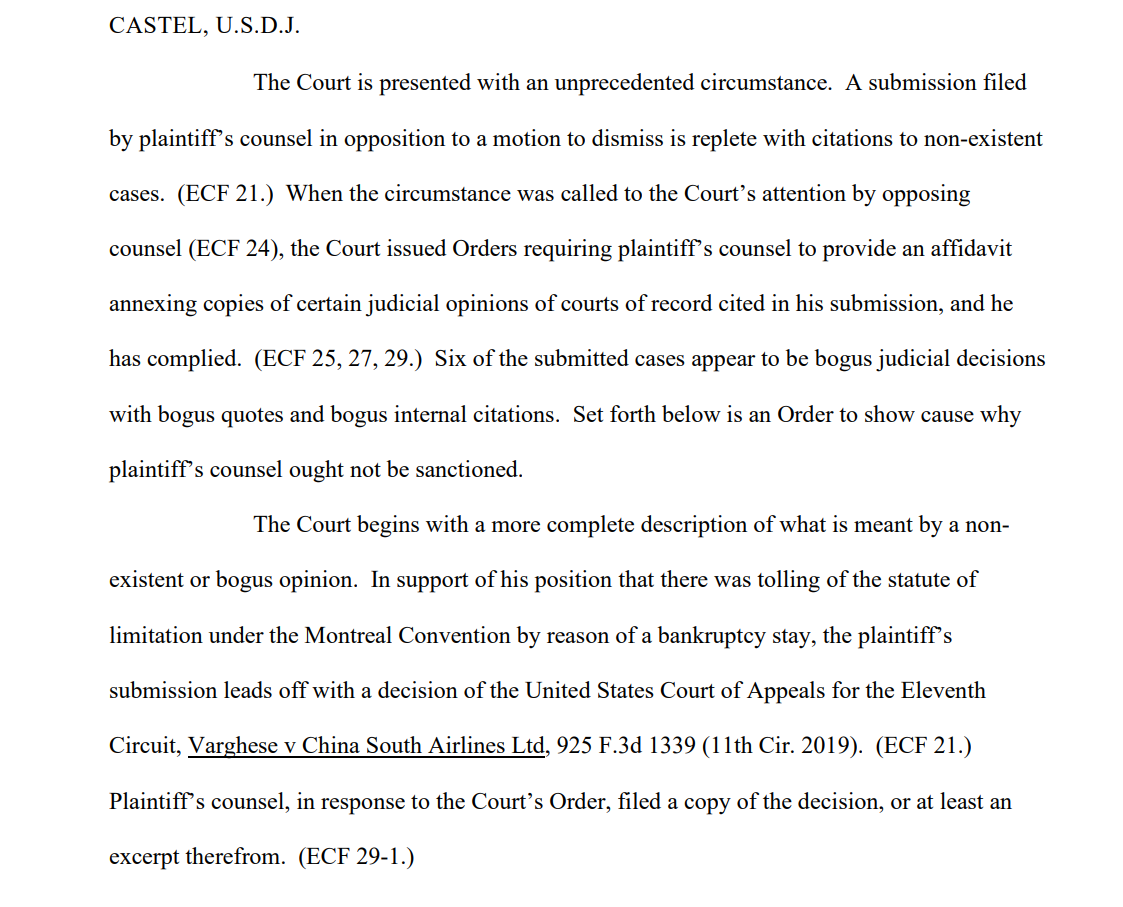

Etter at saksøkerens team hadde sendt inn saksframlegget, uttalte en av mottakerne, den amerikanske distriktsdommeren Kevin Castel: "Seks av de innsendte sakene ser ut til å være falske rettsavgjørelser med falske sitater og falske interne henvisninger."

En av de rettslister sier"Retten står overfor en omstendighet uten sidestykke. Et innlegg fra saksøkers prosessfullmektig mot en begjæring om avvisning er fylt med henvisninger til ikke-eksisterende saker."

Schwartz, som har 30 års erfaring som advokat, hevdet at dette var en uskyldig feil, og sa til retten at han "angrer sterkt" på at han brukte ChatGPT til research og "ikke var klar over at innholdet kunne være falskt". Han innrømmet også å ha brukt ChatGPT i andre rettssaker.

Schwartz, som opptrådte på vegne av Peter LeDocu, en kollega i samme advokatfirma, skal møte for domstolen 8. juni for å forklare hvorfor han og advokatfirmaet hans ikke bør straffes.

Når ChatGPT sjekker ChatGPT

OpenAI er veldig tydelig på at ChatGPT er sårbar for å gi en feilaktig fremstilling av sannheten, men AI-en kan fremstå som selvsikker når den gir kontekstuelt relevante "eksempler" som ikke er faktamessig korrekte - også kalt "hallusinering".

Dette er også et problem i akademia, der ChatGPT ofte genererer falske referanser, og noen ganger går så langt som til å produsere realistiske studier og eksperimenter som aldri har funnet sted.

Mange universiteter har gått ut med uttalelser som understreker dette. For eksempel Duke University sier"Det du kanskje ikke vet om ChatGPT, er at det har betydelige begrensninger som en pålitelig forskningsassistent. En av disse begrensningene er at den har vært kjent for å fabrikkere eller "hallusinere" (i maskinlæringstermer) sitater."

Å analysere referanser for å finne uoverensstemmelser har blitt en pålitelig måte for veiledere å fange studenter som bruker ChatGPT til å skrive essays.

Det var nettopp det som skjedde med Schwartz - han ble tatt. Han var ikke den første, og han blir ikke den siste. Han virket oppriktig uvitende, men uvitenhet er ikke nødvendigvis et forsvar i retten.

At ChatGPT genererer falske juridiske sitater, er et alarmerende eksempel på ChatGPTs feilbarlighet, og fungerer som en kraftig påminnelse om å sjekke, dobbeltsjekke og trippelsjekke "fakta" som generativ kunstig intelligens presenterer.