La ricerca sull'IA è alimentata dalla ricerca di una sempre maggiore sofisticazione, che comprende l'addestramento dei sistemi a pensare e comportarsi come gli esseri umani.

L'obiettivo finale? Chi lo sa. L'obiettivo per ora? Creare agenti AI autonomi e generalizzati in grado di svolgere un'ampia gamma di compiti.

Questo concetto viene solitamente definito intelligenza artificiale generale (AGI) o superintelligenza.

È difficile individuare con precisione cosa comporti l'AGI perché non c'è praticamente alcun consenso su cosa sia l'"intelligenza", né su quando e come i sistemi artificiali potrebbero raggiungerla.

Gli scettici ritengono addirittura che l'IA, allo stato attuale, non potrà mai ottenere una vera intelligenza generale.

Il professor Tony Prescott e il dottor Stuart Wilson dell'Università di Sheffield modelli linguistici generativi descritticome ChatGPT, come intrinsecamente limitati perché "disincarnati" e privi di percezione sensoriale o di fondamento nel mondo naturale.

Yann LeCun, Chief AI Scientist di Meta, ha dichiarato che persino l'intelligenza di un gatto domestico è insensibilmente più avanzata dei migliori sistemi di intelligenza artificiale di oggi.

"Ma perché questi sistemi non sono intelligenti come un gatto?". LeCun ha chiesto al World Government Summit di Dubai.

"Un gatto è in grado di ricordare, di comprendere il mondo fisico, di pianificare azioni complesse, di fare un certo livello di ragionamento - in realtà molto meglio dei più grandi LLM. Questo ci dice che ci manca qualcosa di concettualmente grande per far sì che le macchine siano intelligenti come gli animali e gli esseri umani".

Anche se queste competenze potrebbero non essere necessarie per raggiungere l'AGI, c'è un certo consenso sul fatto che per spostare sistemi complessi di IA dal laboratorio al mondo reale sarà necessario adottare comportamenti simili a quelli osservati negli organismi naturali.

Come si può raggiungere questo obiettivo? Un approccio consiste nel sezionare gli elementi della cognizione e capire come i sistemi di intelligenza artificiale possano imitarli.

Un precedente saggio di DailyAI ha indagato curiosità e la sua capacità di guidare gli organismi verso nuove esperienze e obiettivi, alimentando l'evoluzione collettiva del mondo naturale.

Ma c'è un'altra emozione, un'altra componente essenziale della nostra esistenza, di cui l'AGI potrebbe beneficiare. È la paura.

Come l'intelligenza artificiale può imparare dalla paura biologica

Lungi dall'essere una debolezza o un difetto, la paura è uno degli strumenti più potenti dell'evoluzione per mantenere gli organismi al sicuro.

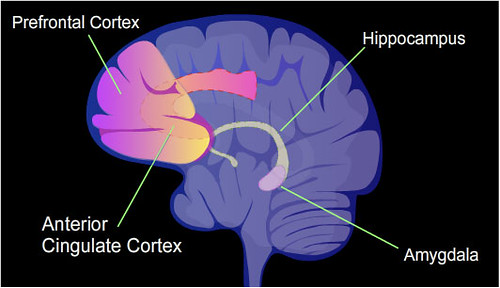

L'amigdala è la struttura centrale che governa la paura nei vertebrati. Negli esseri umani è una piccola struttura a forma di mandorla situata in profondità nei lobi temporali del cervello.

Spesso soprannominata "centro della paura", l'amigdala funge da sistema di allarme precoce, scrutando costantemente le informazioni sensoriali in arrivo alla ricerca di potenziali minacce.

Quando viene rilevata una minaccia - che si tratti dell'improvviso sbandamento di un'auto in frenata o di un'ombra che si muove nell'oscurità - l'amigdala entra in azione, innescando una cascata di cambiamenti fisiologici e comportamentali ottimizzati per una rapida risposta difensiva:

- La frequenza cardiaca e la pressione sanguigna aumentano, preparando il corpo a "combattere o fuggire".

- L'attenzione si restringe e si acuisce, per individuare la fonte del pericolo.

- I riflessi si accelerano, preparando i muscoli a un'azione evasiva in una frazione di secondo.

- L'elaborazione cognitiva passa a una modalità rapida, intuitiva, "meglio prevenire che curare".

Questa risposta non è un semplice riflesso, ma una serie di cambiamenti altamente adattivi e sensibili al contesto che adattano in modo flessibile il comportamento alla natura e alla gravità della minaccia.

È anche eccezionalmente veloce. Diventiamo consapevoli di una minaccia circa 300-400 millisecondi dopo il rilevamento iniziale.

Inoltre, l'amigdala non opera in modo isolato. È densamente interconnessa con altre regioni cerebrali chiave coinvolte nella percezione, nella memoria, nel ragionamento e nell'azione.

Perché la paura potrebbe favorire l'intelligenza artificiale

Quindi, perché la paura è importante nel contesto dell'IA?

Nei sistemi biologici, la paura è un meccanismo cruciale per individuare e rispondere rapidamente alle minacce. Imitando questo sistema nell'IA, possiamo potenzialmente creare sistemi artificiali più robusti e adattabili.

Questo aspetto è particolarmente rilevante per i sistemi autonomi che interagiscono con il mondo reale. Per esempio, nonostante l'intelligenza artificiale sia esplosa negli ultimi anni, le auto senza conducente tendono ancora a non essere sicure e affidabili.

Le autorità di regolamentazione stanno indagando su numerosi incidenti mortali che hanno coinvolto auto a guida autonoma, compresi i modelli Tesla con funzioni di Autopilot e Guida autonoma completa.

Parlando al Guardian nel 2022, Matthew Avery, direttore della ricerca di Thatcham Research, ha spiegato perché le auto senza conducente sono state così impegnative da perfezionare:

"Il primo è che questa roba è più difficile di quanto i produttori abbiano capito", afferma Avery.

Secondo le stime di Avery, circa 80% delle funzioni di guida autonoma riguardano compiti relativamente semplici come l'inseguimento della corsia e l'evitamento di base degli ostacoli.

Le azioni successive, tuttavia, sono molto più impegnative. "L'ultima 10% è davvero difficile", sottolinea Avery, "come quando c'è una mucca in mezzo alla strada che non vuole muoversi".

Certo, le mucche non incutono timore di per sé. Ma qualsiasi guidatore concentrato probabilmente non avrebbe alcuna possibilità di fermarsi se si trovasse a sfrecciare verso una mucca a velocità sostenuta.

La capacità di un sistema di intelligenza artificiale di identificare accuratamente una vacca e di prendere decisioni appropriate dipende in larga misura dalla sua formazione di base con dati pertinenti.

Tuttavia, questo addestramento iniziale potrebbe non essere sempre sufficiente a scongiurare il pericolo, soprattutto quando l'intelligenza artificiale incontra oggetti o scenari sconosciuti (i cosiddetti "casi limite").

Per risolvere questo problema, i sistemi avanzati di intelligenza artificiale elaborano i dati in tempo reale e imparano continuamente, consentendo loro di adattarsi e migliorare le capacità decisionali nel tempo.

Tuttavia, ciò è ben lontano dai sistemi di avvertimento intuitivi e profondamente integrati della natura. Un guidatore umano potrebbe frenare istintivamente al solo pensiero di un ostacolo, anche prima di aver elaborato completamente la sua natura.

Inoltre, le risposte naturali basate sulla paura sono altamente adattabili e generalizzabili a situazioni nuove. Un sistema di intelligenza artificiale addestrato con un nuovo meccanismo simile alla paura potrebbe essere meglio equipaggiato per gestire scenari imprevisti rispetto a un sistema che utilizza tecniche tradizionali di apprendimento per rinforzo (RL).

C'è un'avvertenza in tutto questo: anche gli esseri umani non prendono sempre le decisioni giuste. Questo non cambia la fiducia necessaria per introdurre in modo sicuro i veicoli autonomi in massa. Le persone tollerano gli errori umani a causa della familiarità, ma vedono con scetticismo gli errori delle macchine.

Si potrebbe dire che è un caso di "meglio il diavolo che conosci che il diavolo che non conosci". Per ottenere un'ampia accettazione dei veicoli autonomi, i produttori devono dimostrare che sono affidabili e in grado di gestire gli errori con la stessa sicurezza degli esseri umani.

Impregnare i sistemi di intelligenza artificiale con un senso di paura più profondo potrebbe fornire un mezzo alternativo, più rapido e più efficiente dei metodi tradizionali per ottenere questo risultato.

Decostruire la paura: intuizioni dal moscerino della frutta

Siamo lontani dallo sviluppo di sistemi artificiali che replichino le regioni neurali integrate e specializzate dei cervelli biologici. Ma questo non significa che non possiamo modellare questi meccanismi in altri modi.

Quindi, allontaniamoci dall'amigdala e guardiamo come gli invertebrati - i piccoli insetti, per esempio - rilevano ed elaborano la paura.

Sebbene non abbiano una struttura direttamente analoga all'amigdala, ciò non significa che non abbiano circuiti che raggiungano un obiettivo simile.

Per esempio, studi recenti sulle risposte alla paura di Drosophila melanogaster, il comune moscerino della frutta, ha fornito intuizioni intriganti sugli elementi costitutivi fondamentali delle emozioni primitive.

In un esperimento condotto al Caltech nel 2015, i ricercatori guidati da David Anderson esposto a un'ombra sopraelevata, progettata per simulare l'avvicinamento di un predatore.

Utilizzando telecamere ad alta velocità e algoritmi di visione artificiale, hanno analizzato meticolosamente il comportamento delle mosche, alla ricerca di segni di quelli che Anderson chiama "primitivi dell'emozione" - i componenti di base di uno stato emotivo.

È sorprendente che le mosche abbiano esibito una serie di comportamenti molto simili alle risposte di paura dei mammiferi.

Quando l'ombra è apparsa, le mosche si sono bloccate e le loro ali si sono inclinate per prepararsi a una rapida fuga.

Al persistere della minaccia, alcune mosche hanno preso il volo, allontanandosi dall'ombra ad alta velocità. Altre sono rimaste bloccate per un periodo prolungato, suggerendo uno stato di maggiore eccitazione e vigilanza.

È importante notare che queste risposte non erano semplici riflessi innescati automaticamente dallo stimolo visivo. Sembravano invece riflettere uno stato interno duraturo, una sorta di "paura della mosca" che persisteva anche dopo che la minaccia era passata.

Ciò era evidente nel fatto che i comportamenti difensivi accentuati delle mosche potevano essere suscitati da uno stimolo diverso (un soffio d'aria) anche pochi minuti dopo l'esposizione iniziale all'ombra.

Inoltre, l'intensità e la durata della risposta alla paura variavano in base al livello di minaccia. Le mosche esposte a più presentazioni di ombre hanno mostrato comportamenti difensivi progressivamente più forti e duraturi, indicando una sorta di "apprendimento della paura" che ha permesso loro di calibrare la risposta in base alla gravità e alla frequenza del pericolo.

Come sostengono Anderson e il suo team, questi risultati suggeriscono che gli elementi costitutivi degli stati emotivi - persistenza, scalabilità e generalizzazione - sono presenti anche nelle creature più semplici.

Se riusciamo a decodificare il modo in cui organismi più semplici come i moscerini della frutta elaborano e rispondono alle minacce, possiamo potenzialmente estrarre i principi fondamentali del comportamento adattivo e autoconservativo.

Le forme primitive di paura potrebbero essere applicate per sviluppare sistemi di IA più robusti, sicuri e in grado di affrontare i rischi e le sfide del mondo reale.

Infondere all'intelligenza artificiale i circuiti della paura

È una grande teoria, ma è possibile che l'IA sia impregnata di una forma autentica e funzionale di "paura" nella pratica?

Un intrigante studio ha esaminato proprio questo, con l'obiettivo di migliorare la sicurezza delle auto senza conducente e di altri sistemi autonomi.

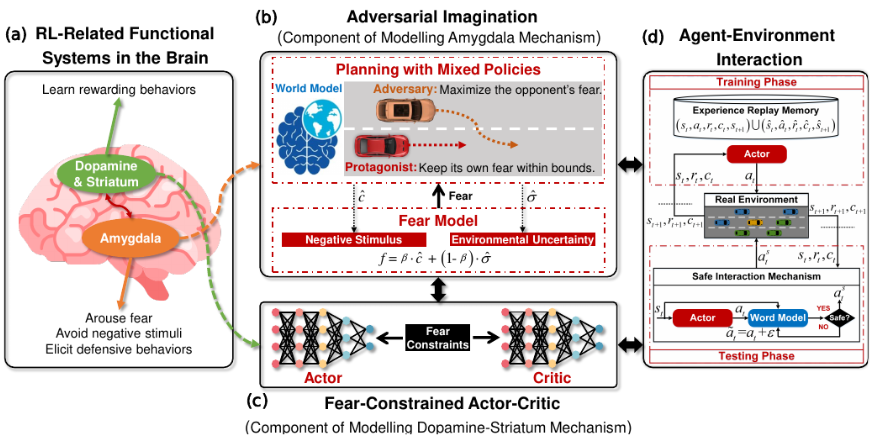

"Fear-Neuro-Inspired Reinforcement Learning for Safe Autonomous Driving", condotto da Chen Lv della Nanyang Technological University di Singapore, ha sviluppato un framework di apprendimento per rinforzo ispirato alla paura (FNI-RL) per migliorare le prestazioni delle auto senza conducente.

Costruendo sistemi di intelligenza artificiale in grado di riconoscere e rispondere ai sottili segnali e schemi che innescano la guida difensiva umana - ciò che viene definito "neuroni della paura" - potremmo essere in grado di creare auto a guida autonoma che navigano sulla strada con la cautela intuitiva e la sensibilità al rischio di cui hanno bisogno.

Il framework FNI-RL traduce i principi chiave del circuito della paura del cervello in un modello computazionale di guida sensibile alle minacce, consentendo a un veicolo autonomo di apprendere e distribuire strategie difensive adattive in tempo reale.

Si tratta di tre componenti chiave che ricalcano gli elementi fondamentali della risposta neurale alla paura:

- Un "modello di paura" che impara a riconoscere e valutare le situazioni di guida che segnalano un rischio maggiore di collisione, svolgendo un ruolo analogo alle funzioni di rilevamento delle minacce dell'amigdala.

- Un modulo di "immaginazione avversaria" che simula mentalmente scenari pericolosi, consentendo al sistema di "praticare" in sicurezza manovre difensive senza conseguenze reali - una forma di apprendimento senza rischi che ricorda le capacità di prova mentale dei conducenti umani.

- Un motore decisionale "limitato dalla paura" che pondera le azioni potenziali non solo in base alle ricompense immediatamente attese (ad esempio, l'avanzamento verso una destinazione), ma anche in base al livello di rischio valutato dalle componenti del modello della paura e dell'immaginazione avversaria. Ciò rispecchia il ruolo dell'amigdala nel guidare in modo flessibile il comportamento in base a un calcolo continuo della minaccia e della sicurezza.

Per mettere alla prova questo sistema, i ricercatori lo hanno testato in una serie di simulazioni di guida ad alta fedeltà con scenari impegnativi e critici per la sicurezza:

- Improvvisi tagli di strada e sterzate da parte di automobilisti aggressivi

- Pedoni irregolari che attraversano il traffico in modo irregolare

- Curve strette e angoli ciechi con visibilità limitata

- Strade sdrucciolevoli e condizioni meteorologiche sfavorevoli

In tutti questi test, i veicoli equipaggiati con FNI-RL hanno dimostrato notevoli prestazioni di sicurezza, superando costantemente i conducenti umani e le tradizionali tecniche di apprendimento per rinforzo (RL) per evitare le collisioni e praticare abilità di guida difensiva.

In un esempio eclatante, il sistema FNI-RL ha gestito con successo un'improvvisa fusione di traffico ad alta velocità con un tasso di successo di 90%, rispetto ai soli 60% di una linea di base RL all'avanguardia.

Ha anche ottenuto miglioramenti in termini di sicurezza senza sacrificare le prestazioni di guida o il comfort dei passeggeri.

In altri test, i ricercatori hanno verificato la capacità del sistema FNI-RL di apprendere e generalizzare le strategie difensive in diversi ambienti di guida.

In una simulazione di un incrocio cittadino trafficato, l'intelligenza artificiale ha imparato in poche prove a riconoscere i segnali rivelatori di un guidatore spericolato - cambi di corsia improvvisi, accelerazioni aggressive - e a modificare preventivamente il proprio comportamento per allontanarsi.

È sorprendente che il sistema sia stato in grado di trasferire questa diffidenza appresa in un nuovo scenario di guida in autostrada, registrando automaticamente le manovre di taglio pericolose e rispondendo con un'azione evasiva.

Questo dimostra il potenziale dell'intelligenza emotiva di ispirazione neurale per migliorare la sicurezza e la robustezza dei sistemi di guida autonoma.

Dotando i veicoli di una "amigdala digitale" sintonizzata sui segnali viscerali del rischio stradale, potremmo essere in grado di creare auto a guida autonoma in grado di affrontare le sfide della strada aperta con una consapevolezza difensiva fluida e proattiva.

Verso una scienza della robotica emotivamente consapevole

Mentre i recenti progressi dell'IA si sono basati sulla potenza di calcolo bruta, i ricercatori si stanno ispirando alle risposte emotive umane per creare sistemi artificiali più intelligenti e adattivi.

Questo paradigma, denominato "IA bio-ispirataIl concetto di "auto a guida autonoma" si estende a settori come la produzione, l'assistenza sanitaria e l'esplorazione spaziale.

Ci sono molti aspetti interessanti da esplorare. Ad esempio, si stanno sviluppando mani robotiche con "nocicettori digitali" che imitano i recettori del dolore, consentendo reazioni rapide a potenziali danni.

In termini di hardware, I chip analogici bio-ispirati di IBM utilizzano "memristori" per memorizzare valori numerici variabili, riducendo la trasmissione di dati tra memoria e processore.

Allo stesso modo, i ricercatori dell'Istituto indiano di tecnologia di Bombay hanno progettato un chip per Reti neurali di tipo Spiking (SNN)che imitano fedelmente il funzionamento dei neuroni biologici.

Il professor Udayan Ganguly riferisce che questo chip raggiunge "un'energia per picco 5.000 volte inferiore a parità di area e una potenza in standby 10 volte inferiore" rispetto ai progetti convenzionali.

Questi progressi nell'informatica neuromorfa ci avvicinano a ciò che Ganguly descrive come "un nucleo neurosinaptico a bassissimo consumo e un meccanismo di apprendimento in tempo reale su chip", elementi chiave per reti neurali autonome e biologicamente ispirate.

Combinare la tecnologia AI ispirata alla natura con architetture informate da stati emotivi naturali come la paura o la curiosità potrebbe spingere l'AI in uno stato completamente nuovo.

Quando i ricercatori si spingono oltre questi confini, non si limitano a creare macchine più efficienti: stanno potenzialmente dando vita a una nuova forma di intelligenza.

Con l'evolversi di questa linea di ricerca, le macchine autonome potrebbero aggirarsi nel mondo tra di noi, reagendo a spunti ambientali imprevedibili con curiosità, paura e altre emozioni considerate decisamente umane.

Gli impatti? Questa è un'altra storia.