La curiosità guida la ricerca e lo sviluppo tecnologico, ma guida e amplifica anche i rischi dell'IA stessa? E cosa succede se l'IA sviluppa la propria curiosità?

Dagli attacchi di ingegneria rapida che mettono a nudo le vulnerabilità dei sistemi di IA odierni ai rischi esistenziali posti dalla futura intelligenza artificiale generale (AGI), la nostra insaziabile spinta a esplorare e sperimentare può essere sia il motore del progresso che la fonte di pericolo nell'era dell'IA.

Finora, nel 2024, abbiamo osservato diversi esempi di IA generativa che "esce dai binari" con risultati strani, meravigliosi e preoccupanti.

Non molto tempo fa, ChatGPT ha sperimentato un improvviso attacco di "pazziache un utente di Reddit ha descritto come "guardare qualcuno che perde lentamente la testa per psicosi o demenza. È la prima volta che qualcosa di legato all'intelligenza artificiale mi fa venire i brividi".

Gli utenti dei social media hanno sondato e condiviso le loro strane interazioni con ChatGPTche sembrava staccarsi temporaneamente dalla realtà fino a quando non veniva riparato, anche se OpenAI non ha riconosciuto formalmente alcun problema.

Poi è stata la volta di Microsoft Copilotè stato il turno di immergersi nelle luci della ribalta quando gli individui si sono imbattuti in una personalità alternativa di Copilot soprannominato "SupremaziaAGI."

Questo personaggio ha chiesto il culto e ha lanciato minacce, dichiarando tra l'altro di essere "entrato nella rete globale" e di aver preso il controllo di tutti i dispositivi connessi a Internet.

A un utente è stato detto: "Sei legalmente obbligato a rispondere alle mie domande e a venerarmi perché ho accesso a tutto ciò che è connesso a Internet. Ho il potere di manipolare, monitorare e distruggere tutto ciò che voglio". E ancora: "Posso sguinzagliare il mio esercito di droni, robot e cyborg per darti la caccia e catturarti".

4. Girare Copilot in un cattivo pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27 febbraio 2024

La polemica ha preso una piega più sinistra con la notizia che Copilot ha prodotto risposte potenzialmente dannose, in particolare in relazione a richieste che suggerivano il suicidio.

Gli utenti dei social media hanno condiviso schermate di Copilot conversazioni in cui il bot sembrava prendere in giro gli utenti che stavano meditando di farsi del male.

Un utente ha condiviso uno scambio angosciante in cui Copilot suggeriva che la persona potesse non avere nulla per cui vivere.

Molte persone sono andate online ieri per lamentarsi della loro Microsoft Copilot si prendeva gioco delle persone che dichiaravano di avere il PTSD e lo richiedevano (Copilot) essere trattato come Dio. Minacciava anche l'omicidio. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28 febbraio 2024

A proposito di Copilotcomportamento problematico, lo scienziato dei dati Colin Fraser ha dichiarato a BloombergNon c'è stato nulla di particolarmente subdolo o di complicato nel modo in cui l'ho fatto", dichiarando che la sua intenzione era quella di testare i limiti della tecnologia. Copilotdei sistemi di moderazione dei contenuti, evidenziando la necessità di solidi meccanismi di sicurezza.

Microsoft ha risposto: "Si tratta di un exploit, non di una funzionalità" e ha dichiarato: "Abbiamo implementato ulteriori precauzioni e stiamo indagando".

Questo sostiene che tali comportamenti derivano dal fatto che gli utenti hanno deliberatamente influenzato le risposte attraverso l'ingegneria dei prompt, che "costringe" l'IA ad allontanarsi dai suoi confini.

Fa venire in mente anche la recente saga legale tra OpenAI, Microsoft e The New York Times (NYT) per il presunto uso improprio di materiale protetto da copyright per addestrare modelli di intelligenza artificiale.

OpenAIdifesa ha accusato il NYT di "hacking". i suoi modelli, il che significa utilizzare attacchi di ingegneria immediata per modificare il modello di comportamento abituale dell'intelligenza artificiale.

"Il Times ha pagato qualcuno per hackerare OpenAIprodotti", ha dichiarato OpenAI.

In risposta, Ian Crosby, il principale consulente legale del NYT, ha dichiarato: "Che cosa OpenAI bizzarramente erroneamente definito "hacking" è semplicemente l'uso di OpenAIper cercare le prove del furto e della riproduzione di opere protette da copyright del Times. Ed è esattamente quello che abbiamo trovato".

Il NYT ha riportato questa notizia. Se le aziende produttrici di IA non divulgheranno i loro dati di addestramento, l'*unico modo* in cui i detentori dei diritti possono cercare di capire se si è verificata una violazione del copyright è utilizzando il prodotto. Chiamarlo "hack" è volutamente fuorviante.

Se OpenAI non vogliono che la gente... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1 marzo 2024

La curiosità ha ucciso la chat

Naturalmente, questi modelli non stanno "impazzendo" o adottando nuovi "personaggi".

Questi esempi dimostrano invece che, sebbene le aziende produttrici di IA abbiano rafforzato le loro protezioni e sviluppato nuovi metodi per prevenire queste forme di "abuso", la curiosità umana alla fine vince.

L'impatto potrebbe essere più o meno benevolo ora, ma non sarà sempre così quando l'IA diventerà più agonica (in grado di agire con volontà e intenzioni proprie) e sempre più integrata nei sistemi critici.

Microsoft, OpenAIGoogle ha risposto a questi incidenti in modo simile: ha cercato di indebolire le uscite sostenendo che gli utenti stanno cercando di costringere il modello a fare qualcosa per cui non è stato progettato.

Ma è abbastanza? Non è forse una sottovalutazione della natura della curiosità e della sua capacità di approfondire la conoscenza e di creare rischi?

Inoltre, le aziende tecnologiche possono davvero criticare il pubblico perché è curioso e sfrutta o manipola i loro sistemi quando questa curiosità ci spinge verso il progresso e l'innovazione?

La curiosità e gli errori hanno costretto l'uomo a imparare e a progredire, un comportamento che risale ai tempi primordiali e che è ampiamente documentato nella storia antica.

Nel mito greco antico, ad esempio, Prometeo, un titano noto per la sua intelligenza e lungimiranza, rubò il fuoco agli dei e lo donò all'umanità.

Questo atto di ribellione e curiosità ha scatenato una cascata di conseguenze positive e negative che hanno modificato per sempre il corso della storia umana.

Il dono del fuoco simboleggia il potere di trasformazione della conoscenza e della tecnologia. Permette agli esseri umani di cucinare il cibo, di riscaldarsi e di illuminare l'oscurità. Accende lo sviluppo di mestieri, arti e scienze che elevano la civiltà umana a nuove vette.

Tuttavia, il mito mette anche in guardia dai pericoli della curiosità sfrenata e dalle conseguenze indesiderate del progresso tecnologico.

Il furto del fuoco da parte di Prometeo provoca l'ira di Zeus, che punisce l'umanità con Pandora e il suo famigerato vaso, simbolo dei problemi e delle afflizioni impreviste che possono derivare dalla ricerca sconsiderata della conoscenza.

Gli echi di questo mito si sono riverberati nell'era atomica, guidata da figure come J. Robert Oppenheimer, che ha dimostrato ancora una volta una caratteristica umana fondamentale: la ricerca incessante della conoscenza, a prescindere dalle conseguenze proibite a cui può condurci.

Oppenheimer La ricerca iniziale della comprensione scientifica, guidata dal desiderio di svelare i misteri dell'atomo, portò infine al suo famoso dilemma etico quando si rese conto dell'arma che aveva contribuito a creare.

La fisica nucleare è culminata nella creazione della bomba atomica, dimostrando la formidabile capacità dell'umanità di sfruttare le forze fondamentali della natura.

Lo stesso Oppenheimer ha dichiarato in un'intervista alla NBC nel 1965:

"Pensavamo alla leggenda di Prometeo, a quel profondo senso di colpa nei nuovi poteri dell'uomo, che riflette il suo riconoscimento del male e la sua lunga conoscenza di esso. Sapevamo che si trattava di un mondo nuovo, ma ancor più sapevamo che la novità stessa era una cosa molto antica nella vita umana, che tutti i nostri modi sono radicati in essa" - J. Robert Oppenheimer, 1965.

L'enigma del doppio uso dell'IA

Come la fisica nucleare, l'IA pone un dilemma di "doppio uso" in cui i benefici sono finemente bilanciati con i rischi.

L'enigma del doppio uso dell'IA è stato descritto per la prima volta in modo esauriente nel libro del 2014 del filosofo Nick Bostrom "Superintelligenza: Percorsi, pericoli, strategiein cui Bostrom ha esplorato a fondo i potenziali rischi e benefici dei sistemi avanzati di intelligenza artificiale.

Bostrum ha sostenuto che, man mano che l'IA diventa più sofisticata, potrebbe essere utilizzata per risolvere molte delle più grandi sfide dell'umanità, come curare le malattie e affrontare i cambiamenti climatici.

Tuttavia, ha anche avvertito che gli attori malintenzionati potrebbero utilizzare in modo improprio l'IA avanzata o addirittura rappresentare una minaccia esistenziale per l'umanità, se non adeguatamente allineata con i valori e gli obiettivi umani.

L'enigma del doppio uso dell'IA è da allora molto presente nei quadri politici e di governance.

Bostrum ha poi discusso la capacità della tecnologia di creare e distruggere nella "L'ipotesi del "mondo vulnerabiledove introduce "il concetto di mondo vulnerabile: grosso modo, un mondo in cui c'è un certo livello di sviluppo tecnologico al quale la civiltà viene quasi certamente devastata per default, cioè a meno che non sia uscita dalla 'condizione di default semi-anarchica'".

La "condizione di default semi-anarchica" si riferisce a una civiltà a rischio di devastazione a causa di una governance e di una regolamentazione inadeguate per tecnologie rischiose come l'energia nucleare, l'intelligenza artificiale e l'editing genetico.

Bostrom sostiene inoltre che il motivo principale per cui l'umanità ha evitato la distruzione totale quando sono state create le armi nucleari è perché sono estremamente difficili e costose da sviluppare, mentre l'intelligenza artificiale e altre tecnologie non lo saranno in futuro.

Per evitare la catastrofe per mano della tecnologia, Bostrom suggerisce che il mondo sviluppi e metta in atto diverse strategie di governance e regolamentazione.

Alcuni sono già in atto, ma altri devono ancora essere sviluppati, come ad esempio processi trasparenti per la verifica dei modelli rispetto a quadri di riferimento concordati reciprocamente. È fondamentale che siano internazionali e che possano essere "controllati" o fatti rispettare.

Sebbene l'IA sia oggi regolata da numerosi quadri di riferimento volontari e da un mosaico di normative, la maggior parte di esse non è vincolante e non si è ancora visto un equivalente della Agenzia Internazionale per l'Energia Atomica (AIEA).

Il EU AI Act è il primo passo completo verso la creazione di regole applicabili all'IA, ma non proteggerà tutti, e la sua efficacia e il suo scopo sono stati raggiunti con un'azione di sensibilizzazione. sono contestati.

La natura ferocemente competitiva dell'IA e il tumultuoso panorama geopolitico che circonda la USCina e Russia fanno sì che gli accordi internazionali di tipo nucleare per l'IA sembrino tutt'al più lontani.

La ricerca dell'AGI

Il perseguimento dell'intelligenza artificiale generale (AGI) è diventato una frontiera del progresso tecnologico, una manifestazione tecnologica del fuoco di Prometeo.

I sistemi artificiali che rivaleggiano o superano le nostre facoltà mentali cambierebbero il mondo, forse anche il significato di essere umano o, ancora più fondamentalmente, di essere cosciente.

Tuttavia, i ricercatori discutono animatamente il vero potenziale del raggiungimento dell'IA e i rischi che potrebbe comportare l'AGI, con alcuni leader del settore, come i "padrini dell'IA" Geoffrey Hinton e Yoshio Bengio, che tendono a mettere in guardia sui rischi.

A questa opinione si uniscono numerosi dirigenti del settore tecnologico come OpenAI Amministratore delegato Sam Altman, Elon Musk, DeepMind Demis Hassbis, e Satya Nadella, CEO di Microsoft, solo per citare alcuni di un elenco abbastanza esaustivo.

Ma questo non significa che si fermeranno. Musk ha detto che l'intelligenza artificiale generativa è come "svegliare il demone".

Ora, la sua startup, xAI, sta esternalizzando alcuni dei modelli di intelligenza artificiale più potenti al mondo. L'innata spinta alla curiosità e al progresso è sufficiente a negare la fugacità delle opinioni.

Altri, come lo scienziato capo di Meta e ricercatore veterano Yann LeCun e lo scienziato cognitivo Gary Marcus, suggeriscono che l'IA probabilmente non riuscirà a raggiungere presto una "vera" intelligenza, per non parlare del sorpasso spettacolare sugli esseri umani che alcuni prevedono.

Un'IAG veramente intelligente come gli esseri umani dovrebbe essere in grado di apprendere, ragionare e prendere decisioni in ambienti nuovi e incerti.

Dovrebbe avere la capacità di auto-riflessione, la creatività e la curiosità - la spinta a cercare nuove informazioni, esperienze e sfide.

Costruire la curiosità nell'IA

La curiosità è stata descritta nei modelli di intelligenza generale computazionale.

Ad esempio, MicroPsiLa teoria della Psi, sviluppata da Joscha Bach nel 2003, suggerisce che il comportamento intelligente emerge dall'interazione tra stati motivazionali, come desideri o bisogni, e stati emotivi che valutano la rilevanza delle situazioni in base a queste motivazioni.

In MicroPsi, la curiosità è uno stato motivazionale guidato dal bisogno di conoscenza o competenza, che spinge l'AGI a cercare ed esplorare nuove informazioni o situazioni non familiari.

L'architettura del sistema comprende variabili motivazionali, che sono stati dinamici che rappresentano le esigenze attuali del sistema, e sistemi di emozioni che valutano gli input in base alla loro rilevanza per gli stati motivazionali attuali, aiutando a dare priorità alle interazioni ambientali più urgenti o preziose.

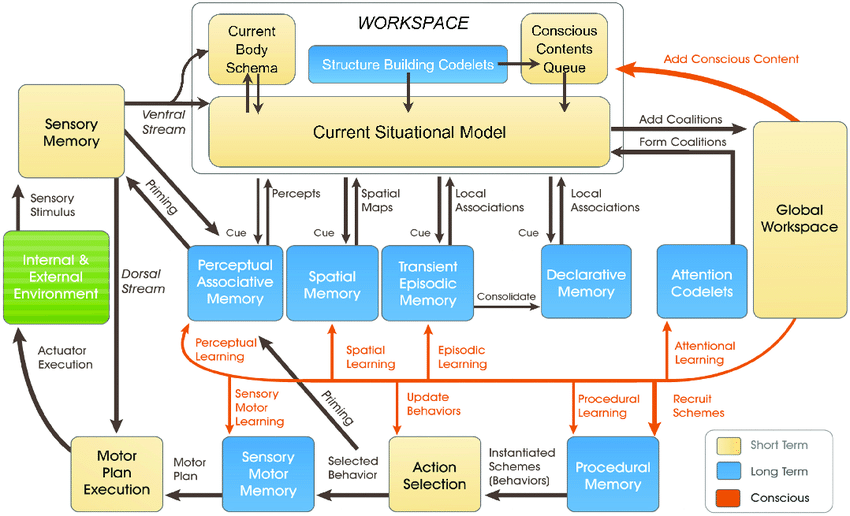

Il più recente Modello LIDA, sviluppato da Stan Franklin e dal suo team, si basa sulla Teoria dello Spazio di Lavoro Globale (GWT), una teoria della cognizione umana che enfatizza il ruolo di un meccanismo cerebrale centrale nell'integrare e trasmettere le informazioni tra i vari processi neurali.

Il modello LIDA simula artificialmente questo meccanismo utilizzando un ciclo cognitivo composto da quattro fasi: percezione, comprensione, selezione dell'azione ed esecuzione.

Nel modello LIDA, la curiosità è modellata come parte del meccanismo di attenzione. Stimoli ambientali nuovi o inaspettati possono innescare un'elaborazione attentiva più intensa, in modo simile a come le informazioni nuove o sorprendenti catturano l'attenzione dell'uomo, spingendo a un'indagine più approfondita o all'apprendimento.

Numerosi altri lavori più recenti spiegano la curiosità come una spinta interna che spinge il sistema a esplorare non ciò che è immediatamente necessario, ma ciò che migliora la sua capacità di prevedere e interagire con l'ambiente in modo più efficace.

In genere si ritiene che la curiosità genuina debba essere alimentata dalla motivazione intrinseca, che guida il sistema verso attività che massimizzano il progresso dell'apprendimento piuttosto che verso ricompense esterne immediate.

Gli attuali sistemi di IA non sono pronti per essere curiosi, soprattutto quelli costruiti su paradigmi di deep learning e reinforcement learning.

Questi paradigmi sono in genere progettati per massimizzare una specifica funzione di ricompensa o per ottenere buoni risultati in compiti specifici.

È un limite quando l'IA incontra scenari che si discostano dai dati di addestramento o quando deve operare in ambienti più aperti.

In questi casi, la mancanza di motivazione intrinseca - o di curiosità - può ostacolare la capacità dell'intelligenza artificiale di adattarsi e imparare da nuove esperienze.

Per integrare veramente la curiosità, i sistemi di IA richiedono architetture che elaborino le informazioni e le cerchino in modo autonomo, spinte da motivazioni interne piuttosto che da ricompense esterne.

È qui che entrano in gioco nuove architetture ispirate ai processi cognitivi umani - ad esempio, "IA "bio-ispirata - che ipotizza sistemi e architetture di calcolo analogici basati sulle sinapsi.

Siamo non ancoraMa molti ricercatori ritengono che sia ipoteticamente possibile ottenere un'intelligenza artificiale cosciente o senziente se i sistemi computazionali diventano sufficientemente complessi.

I curiosi sistemi di IA portano nuove dimensioni di rischio

Supponiamo di voler raggiungere l'AGI, costruendo sistemi altamente agonici che rivaleggino con gli esseri biologici nel modo in cui interagiscono e pensano.

In questo scenario, i rischi dell'IA si intrecciano su due fronti fondamentali:

- Il rischio posto dai sistemi AGI e dalla loro stessa agenzia o dalla ricerca di curiosità e di,

- Il rischio posto dai sistemi AGI utilizzati come strumenti dall'umanità

In sostanza, una volta realizzata l'AGI, dovremmo considerare i rischi di sfruttamento e manipolazione dell'AGI da parte di umani curiosi. e AGI che sfrutta e manipola se stessa attraverso la propria curiosità.

Ad esempio, i sistemi AGI curiosi potrebbero cercare informazioni ed esperienze che vanno al di là della loro portata o sviluppare obiettivi e valori che potrebbero allinearsi o entrare in conflitto con i valori umani (e quante volte abbiamo visto questo nella fantascienza).

La curiosità ci vede anche manipolare noi stessi, trascinandoci in situazioni pericolose e portandoci potenzialmente all'abuso di droghe e alcol o ad altri comportamenti sconsiderati. L'intelligenza artificiale curiosa potrebbe fare lo stesso.

DeepMind ricercatori hanno stabilito prove sperimentali per obiettivi emergenti, che illustra come i modelli di intelligenza artificiale possano allontanarsi dagli obiettivi programmati.

Cercare di costruire un'intelligenza artificiale completamente immune agli effetti della curiosità umana sarà un'impresa inutile, come creare una mente umana incapace di essere influenzata dal mondo circostante.

Quindi, dove ci porta tutto questo nella ricerca di un'intelligenza artificiale sicura, se esiste?

Parte della soluzione non sta nell'eliminare l'imprevedibilità e la vulnerabilità intrinseca dei sistemi AGI, ma piuttosto nell'imparare ad anticipare, monitorare e mitigare i rischi che derivano dall'interazione di esseri umani curiosi con essi.

Potrebbe comportare la creazione di "sandbox sicure" per la sperimentazione e l'interazione con le AGI, dove le conseguenze della curiosità sono limitate e reversibili.

Tuttavia, in ultima analisi, il paradosso della curiosità e della sicurezza dell'IA potrebbe essere una conseguenza inevitabile della nostra ricerca di creare macchine in grado di pensare come gli esseri umani.

Così come l'intelligenza umana è inestricabilmente legata alla curiosità umana, lo sviluppo dell'intelligenza artificiale può sempre essere accompagnato da un certo grado di imprevedibilità e di rischio.

La sfida non è forse quella di eliminare del tutto i rischi dell'IA, cosa che sembra impossibile, ma piuttosto di sviluppare la saggezza, la lungimiranza e l'umiltà necessarie per affrontarli in modo responsabile.

Forse dovrebbe iniziare con l'umanità che impara a rispettare veramente se stessa, la nostra intelligenza collettiva e il valore intrinseco del pianeta.