L'IA ha una miriade di usi, ma una delle sue applicazioni più preoccupanti è la creazione di fake media e disinformazione.

Un nuovo studio da Google DeepMind e Seghetto alternativo, un incubatore tecnologico di Google che monitora le minacce sociali, ha analizzato l'uso improprio dell'IA tra gennaio 2023 e marzo 2024.

L'indagine ha valutato circa 200 episodi reali di uso improprio dell'IA, rivelando che la creazione e la diffusione di falsi media ingannevoli, in particolare quelli che prendono di mira politici e personaggi pubblici, è la forma più comune di uso malevolo dell'IA.

I deep fake, media sintetici generati utilizzando algoritmi di intelligenza artificiale per creare immagini, video e audio altamente realistici ma falsi, sono diventati sempre più realistici e pervasivi.

Incidenti come quando immagini false esplicite di Taylor Swift apparso su X ha dimostrato che tali immagini possono raggiungere milioni di persone prima di essere cancellate.

Ma la cosa più insidiosa sono i falsi profondi mirati a questioni politiche, come il conflitto israelo-palestinese. In alcuni casi, nemmeno i verificatori incaricati di etichettarli come "generati dall'intelligenza artificiale" sono in grado di rilevarne l'autenticità.

Lo studio di DeepMind ha raccolto dati da una serie di fonti diverse, tra cui piattaforme di social media come X e Reddit, blog online e rapporti dei media.

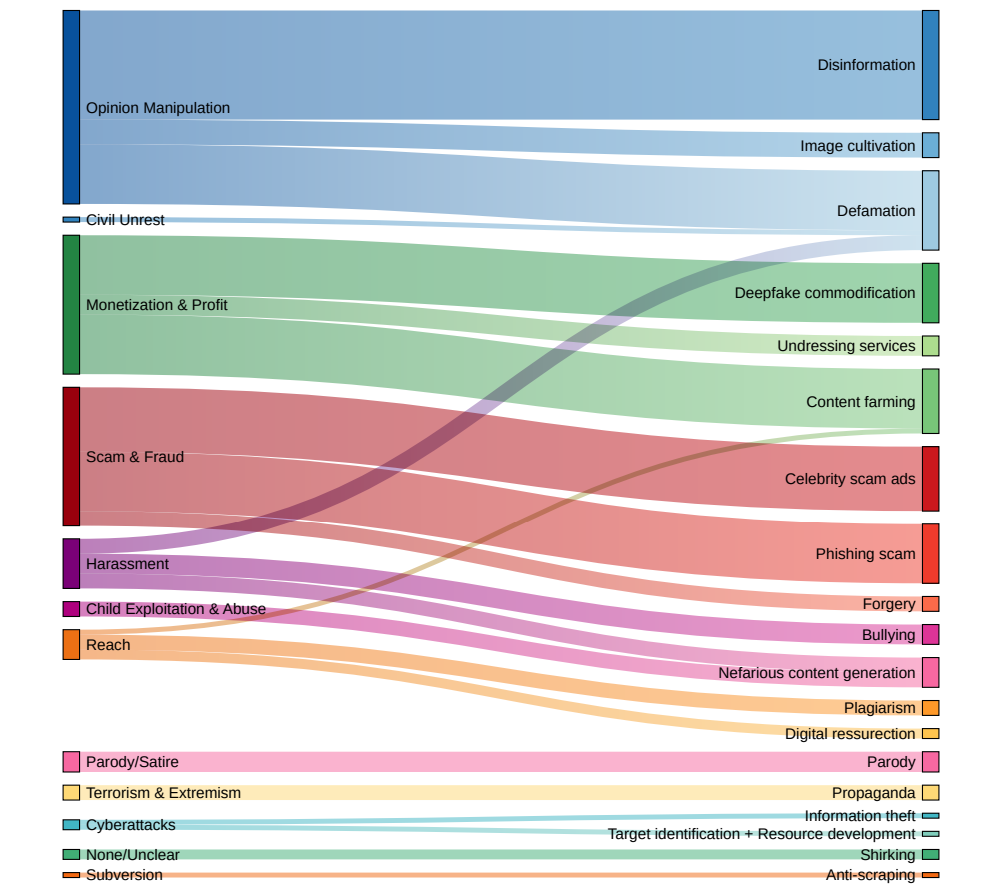

Ogni incidente è stato analizzato per determinare il tipo specifico di tecnologia AI utilizzata in modo improprio, lo scopo previsto dietro l'abuso e il livello di competenza tecnica richiesto per portare a termine l'attività dannosa.

Le falsificazioni profonde sono la forma dominante di abuso dell'IA

I risultati dipingono un quadro allarmante dell'attuale panorama dell'utilizzo dell'IA da parte di malintenzionati:

- I falsi profondi sono emersi come la forma dominante di abuso dell'IA, con un numero di incidenti quasi doppio rispetto alla categoria successiva più diffusa.

- Il secondo tipo di abuso dell'IA più frequentemente osservato è stato l'utilizzo di modelli linguistici e chatbot per generare e diffondere disinformazione online. Automatizzando la creazione di contenuti fuorvianti, i malintenzionati possono inondare i social media e altre piattaforme con fake news e propaganda su una scala senza precedenti.

- Influenzare l'opinione pubblica e le narrazioni politiche è stata la motivazione principale di oltre un quarto (27%) dei casi di abuso dell'IA analizzati. Ciò illustra la minaccia che le falsificazioni profonde e la disinformazione generata dall'IA rappresentano per i processi democratici e l'integrità delle elezioni in tutto il mondo. recenti incidenti di alto profilo.

- Il guadagno finanziario è stato identificato come il secondo motore più comune dell'attività di IA dannosa, con attori senza scrupoli che offrono servizi a pagamento per la creazione di falsi profondi, comprese immagini esplicite non consensuali, e sfruttano l'IA generativa per produrre in massa contenuti falsi a scopo di lucro.

- La maggior parte degli incidenti di abuso dell'IA ha coinvolto strumenti e servizi facilmente accessibili che richiedono competenze tecniche minime per funzionare. Questa bassa barriera all'ingresso amplia notevolmente il bacino dei potenziali malintenzionati, rendendo più facile che mai per individui e gruppi impegnarsi in inganni e manipolazioni basati sull'IA.

La dott.ssa Nahema Marchal di DeepMind ha illustrato il panorama in evoluzione dell'uso improprio dell'IA all'Assemblea. Financial Times: "C'è stata molta preoccupazione comprensibile per gli attacchi informatici piuttosto sofisticati facilitati da questi strumenti", e continua: "Non è possibile che il problema sia stato risolto.Abbiamo visto usi impropri di GenAI abbastanza comuni [come i deep fake che] potrebbero passare un po' più inosservati".

I politici, le aziende tecnologiche e i ricercatori devono collaborare per sviluppare strategie complete per individuare e contrastare i deepfakes, la disinformazione generata dall'IA e altre forme di abuso dell'IA.

Ma la verità è che ci hanno già provato, e in gran parte hanno fallito. Proprio di recente, abbiamo osservato un maggior numero di episodi di bambini che vengono coinvolti in incidenti falsi e profondidimostrando che il danno sociale che infliggono può essere grave.

Attualmente le aziende tecnologiche non sono in grado di rilevare in modo affidabile i falsi profondi su scala, che col tempo diventeranno sempre più realistici e difficili da individuare.

E quando arriveranno sistemi text-to-video come Sora di OpenAI, ci sarà un'intera nuova dimensione di falsi profondi da gestire.