Un team di ricercatori della New York University ha compiuto progressi nella decodifica neurale del parlato, avvicinandoci a un futuro in cui le persone che hanno perso la capacità di parlare potranno riacquistare la voce.

Il studio, pubblicato in Natura Intelligenza Artificialepresenta una nuova struttura di apprendimento profondo che traduce accuratamente i segnali cerebrali in un discorso intelligibile.

Le persone con lesioni cerebrali dovute a ictus, condizioni degenerative o traumi fisici possono utilizzare questi sistemi per comunicare decodificando i loro pensieri o il discorso che intendono fare dai segnali neurali.

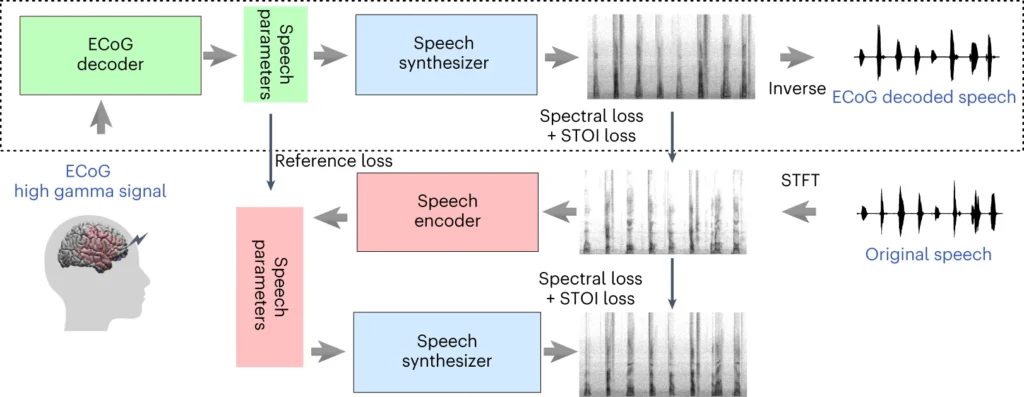

Il sistema del team dell'Università di New York prevede un modello di apprendimento profondo che mappa i segnali elettrocorticografici (ECoG) del cervello in caratteristiche del parlato, come l'intonazione, il volume e altri contenuti spettrali.

Il secondo stadio coinvolge un sintetizzatore vocale neurale che converte le caratteristiche vocali estratte in uno spettrogramma udibile, che può poi essere trasformato in una forma d'onda vocale.

Questa forma d'onda può infine essere convertita in un parlato sintetizzato dal suono naturale.

Un nuovo articolo pubblicato oggi in @NatMachIntellin cui mostriamo una robusta decodifica neurale del parlato in 48 pazienti. https://t.co/rNPAMr4l68 pic.twitter.com/FG7QKCBVzp

- Adeen Flinker 🇮🇱🇺🇦🎗️ (@adeenflinker) 9 aprile 2024

Come funziona lo studio

Questo studio prevede l'addestramento di un modello di intelligenza artificiale in grado di alimentare un dispositivo di sintesi vocale, consentendo alle persone con perdita del linguaggio di parlare utilizzando gli impulsi elettrici del cervello.

Ecco come funziona in dettaglio:

1. Raccolta dei dati cerebrali

Il primo passo consiste nel raccogliere i dati grezzi necessari per addestrare il modello di decodifica vocale. I ricercatori hanno lavorato con 48 partecipanti sottoposti a un intervento di neurochirurgia per l'epilessia.

Durante lo studio, a questi partecipanti è stato chiesto di leggere centinaia di frasi ad alta voce mentre la loro attività cerebrale veniva registrata con griglie ECoG.

Queste griglie sono posizionate direttamente sulla superficie del cervello e catturano i segnali elettrici delle regioni cerebrali coinvolte nella produzione del parlato.

2. Mappatura dei segnali cerebrali nel linguaggio

Utilizzando i dati del parlato, i ricercatori hanno sviluppato un sofisticato modello di intelligenza artificiale che mappa i segnali cerebrali registrati in base a specifiche caratteristiche del parlato, come l'intonazione, il volume e le frequenze uniche che compongono i diversi suoni del parlato.

3. Sintetizzazione del parlato a partire dalle caratteristiche

La terza fase si concentra sulla conversione delle caratteristiche vocali estratte dai segnali cerebrali in parlato udibile.

I ricercatori hanno utilizzato uno speciale sintetizzatore vocale che prende le caratteristiche estratte e genera uno spettrogramma, una rappresentazione visiva dei suoni vocali.

4. Valutazione dei risultati

I ricercatori hanno confrontato il discorso generato dal loro modello con il discorso originale pronunciato dai partecipanti.

Hanno usato metriche oggettive per misurare la somiglianza tra i due e hanno scoperto che il discorso generato corrispondeva molto bene al contenuto e al ritmo dell'originale.

5. Test su nuove parole

Per garantire che il modello sia in grado di gestire parole nuove che non ha mai visto prima, durante la fase di addestramento del modello sono state escluse intenzionalmente alcune parole, per poi testare le prestazioni del modello su queste parole non viste.

La capacità del modello di decodificare accuratamente anche parole nuove dimostra il suo potenziale di generalizzazione e di gestione di modelli vocali diversi.

La sezione superiore del diagramma descrive il processo di conversione dei segnali cerebrali in parlato. Innanzitutto, un decodificatore trasforma questi segnali in parametri vocali nel tempo. Poi, un sintetizzatore crea immagini sonore (spettrogrammi) a partire da questi parametri. Un altro strumento trasforma queste immagini in onde sonore.

La sezione inferiore tratta di un sistema che aiuta ad allenare il decodificatore di segnali cerebrali imitando il parlato. Prende un'immagine sonora, la trasforma in parametri vocali e poi li usa per creare una nuova immagine sonora. Questa parte del sistema impara dai suoni reali del parlato per migliorare.

Dopo l'addestramento, è necessario solo il processo superiore per trasformare i segnali cerebrali in parlato.

Uno dei vantaggi principali del sistema dell'Università di New York è la capacità di ottenere una decodifica del parlato di alta qualità senza la necessità di array di elettrodi ad altissima densità, che non sono praticabili per un uso a lungo termine.

In sostanza, offre una soluzione più leggera e portatile.

Un altro risultato è la decodifica del parlato da entrambi gli emisferi sinistro e destro del cervello, importante per i pazienti con danni cerebrali su un lato del cervello.

Convertire i pensieri in parole grazie all'intelligenza artificiale

Lo studio della NYU si basa su precedenti ricerche sulla decodifica neurale del parlato e sulle interfacce cervello-computer (BCI).

Nel 2023, un'équipe dell'Università della California di San Francisco ha permesso a un sopravvissuto paralizzato a un ictus di generare frasi alla velocità di 78 parole al minuto, utilizzando una BCI che sintetizzava sia le vocalizzazioni che le espressioni facciali dai segnali cerebrali.

Altri studi recenti hanno esplorato l'uso dell'IA per interpretare vari aspetti del pensiero umano a partire dall'attività cerebrale. I ricercatori hanno dimostrato la capacità di generare immagini, testi e persino musica da dati di risonanza magnetica ed elettroencefalogramma (EEG) prelevati dal cervello.

Ad esempio, un studio dell'Università di Helsinki ha utilizzato i segnali EEG per guidare una rete generativa avversaria (GAN) nella produzione di immagini facciali che corrispondono ai pensieri dei partecipanti.

Meta AI anche ha sviluppato una tecnica per decodificare parzialmente ciò che qualcuno stava ascoltando utilizzando le onde cerebrali raccolte in modo non invasivo.

Opportunità e sfide

Il metodo della NYU utilizza elettrodi più disponibili e clinicamente utilizzabili rispetto ai metodi precedenti, rendendolo più accessibile.

Sebbene ciò sia entusiasmante, ci sono importanti ostacoli da superare se vogliamo assistere a un uso diffuso.

Innanzitutto, la raccolta di dati cerebrali di alta qualità è un'impresa complessa e lunga. Le differenze individuali nell'attività cerebrale rendono difficile la generalizzazione, per cui un modello addestrato per un gruppo di partecipanti potrebbe non funzionare bene per un altro.

Tuttavia, lo studio della NYU rappresenta un passo avanti in questa direzione, dimostrando un'elevata precisione nella decodifica del parlato utilizzando array di elettrodi più leggeri.

In prospettiva, il team dell'Università di New York intende perfezionare i propri modelli per la decodifica del parlato in tempo reale, avvicinandosi all'obiettivo finale di consentire conversazioni naturali e fluenti alle persone con problemi di linguaggio.

Si intende inoltre adattare il sistema a dispositivi wireless impiantabili che possano essere utilizzati nella vita quotidiana.