L'aumento della domanda di IA è in rotta di collisione con la sostenibilità ambientale, con gli esperti che affermano che l'energia a carbone potrebbe rimanere per mantenere la domanda di elettricità.

I Paesi di tutto il mondo stanno puntando a una transizione verso il net zero, investendo in energia verde e riducendo il consumo di combustibili fossili.

Ciò è in contrasto con l'immensa domanda di elettricità creata dall'IA, in particolare dall'IA generativa, che serve milioni di utenti in tutto il mondo.

Questo è un punto definitivo: anche un paio di anni fa, i modelli di IA erano relativamente piccoli e limitati a usi localizzati.

Oggi, voi, io e milioni di altre persone abbiamo almeno sperimentato l'IA. Secondo alcune stime, circa 40% di adulti negli Stati Uniti e in Europa e 75% di minori di 18 anni.

Le aziende che si occupano di IA vedono un futuro in cui i loro prodotti sono integrati in ogni cosa che facciamo e in ogni dispositivo che utilizziamo, ma l'IA non è alimentata dal nulla. Come tutte le tecnologie, richiede energia.

A documento recente Il modello BLOOM ha consumato 433 MWh per l'addestramento, mentre il GPT-3 ha richiesto ben 1287 MWh.

Il ChatGPT di OpenAI ha bisogno di circa 564 MWh al giorno per calcolare le risposte alle richieste degli utenti. Ogni singolo output rappresenta un calcolo eseguito dalle numerose reti neurali di OpenAI, ognuna delle quali richiede energia.

Mettiamolo in prospettiva: 1287 MWh potrebbero alimentare da 43.000 a 128.700 famiglie medie per un giorno, ipotizzando un consumo medio giornaliero di 10-30 kWh per famiglia.

Potrebbe anche alimentare oltre 200.000.000 di lampadine a LED per un'ora o guidare un veicolo elettrico per circa 4-5 milioni di chilometri.

Sebbene questo studio e altri abbiano i loro limiti, i dati pubblici di aziende di IA open-source come HuggingFace confermano la portata di queste cifre.

Le implicazioni ambientali dell'IA vanno oltre il semplice consumo di energia. Utilizzo dell'acqua nei centri dati Microsoft sottolinea la natura ad alta intensità di risorse delle operazioni di IA. Un centro dati da 15 megawatt può consumare fino a 360.000 galloni di acqua al giorno.

L'Agenzia Internazionale per l'Energia (AIE) ha messo in guardia sull'impatto più ampio dei data center, che già oggi rappresentano oltre 1,3% del consumo globale di elettricità. Questa cifra è destinata a crescere con l'aumento delle richieste di IA e di elaborazione dei dati, mettendo ulteriormente a dura prova l'infrastruttura energetica globale e amplificando la richiesta di pratiche più sostenibili nell'industria dell'IA.

Secondo le stime del Boston Consulting Group, entro la fine di questo decennio il consumo di elettricità dei data center statunitensi potrebbe triplicare rispetto ai livelli del 2022, raggiungendo i 390 terawattora, pari a circa 7,5% della domanda di elettricità prevista per il Paese.

L'UE ha anche dichiarato che la domanda di energia dei centri dati raddoppierà entro il 2026. Solo negli Stati Uniti o in Cina, i data center potrebbero consumare una quantità di energia pari alla produzione annuale di circa 80-130 centrali elettriche a carbone entro il 2030.

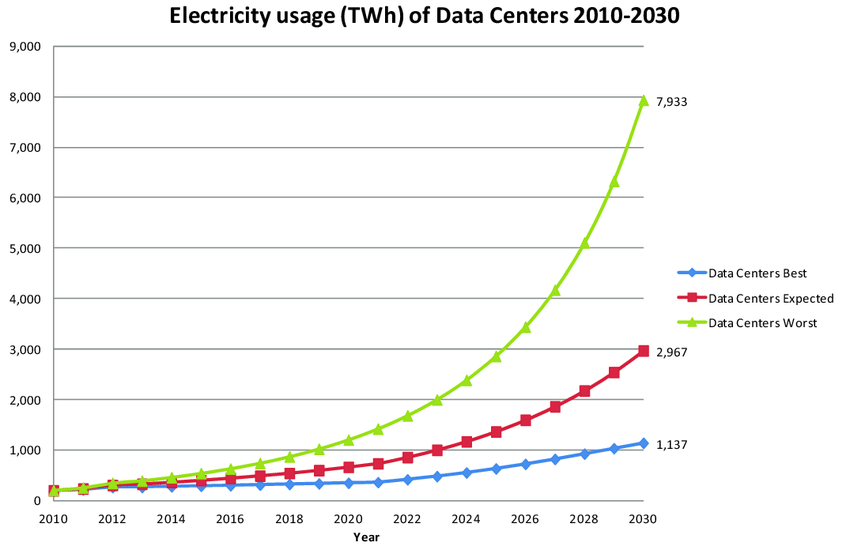

Nel peggiore dei casi, il grafico sottostante mostra che i data center potrebbero consumare circa 8.000 TWh di elettricità entro il 2030, pari a 30% dell'attuale consumo mondiale di elettricità. Si tratta del doppio del consumo annuo degli Stati Uniti.

Non vorremmo fare del sensazionalismo - ricordiamo che si tratta di una stima di un certo margine e che i data center sono utilizzati per molte altre cose oltre all'IA - ma è comunque abbastanza sconvolgente, anche se si tratta di un limite inferiore di 1.100 TWh.

Parlando al World Economic Forum, Sam Altman, CEO di OpenAI, ha dichiarato: "Nel mondo abbiamo bisogno di molta più energia di quanta ne pensassimo prima. Non ci rendiamo ancora conto del fabbisogno energetico di questa tecnologia".

"L'IA consumerà molta più energia di quanto ci si aspettasse", ha proseguito, suggerendo che fonti energetiche come la fusione nucleare o l'energia solare più economica sono fondamentali per il progresso dell'IA.

I data center mettono a dura prova la rete energetica

Nel cuore della Virginia settentrionale, una regione ormai nota come "data center alley", la rapida crescita dell'IA generativa sta superando i limiti della generazione di elettricità.

A un certo punto, nel 2022, i fornitori di energia elettrica locali hanno persino dovuto interrompere gli allacciamenti ai nuovi centri dati, perché la domanda era semplicemente troppo alta. A causa della resistenza della comunità, sono state accantonate le proposte di utilizzare generatori diesel durante le carenze di energia.

Bloomberg riporta che nell'area di Kansas City, la costruzione di un centro dati e di una fabbrica di batterie per veicoli elettrici ha richiesto così tanta energia da far slittare i piani di smantellamento di una centrale a carbone.

Ari Peskoe, dell'Electricity Law Initiative della Harvard Law School, ha messo in guardia sulle potenziali conseguenze se le utility non si adeguano: "I nuovi carichi vengono ritardati, le fabbriche non possono entrare in funzione, il nostro potenziale di crescita economica diminuisce", afferma.

"Lo scenario peggiore è che le utility non si adattino e mantengano in funzione la vecchia capacità a combustibili fossili e non si evolvano oltre".

Rob Gramlich di Grid Strategies ha fatto eco a queste preoccupazioni, sottolineando a Bloomberg il rischio di blackout a rotazione se i miglioramenti infrastrutturali tardano ad arrivare.

Le sfide del settore delle utility non si limitano ai data center. La recente legislazione e gli incentivi stanno stimolando la costruzione di fabbriche di semiconduttori, EV e batterie, contribuendo all'aumento della domanda di elettricità.

Ad esempio, Evergy, che serve l'area di Kansas City, ha ritardato la dismissione di una centrale a carbone degli anni '60 per far fronte alla domanda di nuovi sviluppi, tra cui un centro dati Meta Platforms e una fabbrica di batterie EV Panasonic.

Nonostante la preferenza di molte aziende tecnologiche e di produttori di tecnologie pulite per le energie rinnovabili, la realtà dice il contrario. È difficile immaginare come si possa compensare questo consumo di energia.

La situazione non è unica negli Stati Uniti. A livello globale, Cina, India, Regno Unito e Unione Europea hanno lanciato un allarme sulla crescente domanda di elettricità da parte dell'intelligenza artificiale.

Come pagheremo?

Man mano che le tecnologie di intelligenza artificiale diventano onnipresenti, la loro impronta ecologica si scontra con le ambizioni globali di un futuro a zero emissioni. Anche mettendo da parte gli obiettivi ambiziosi di ottenere lo zero netto, le reti elettriche non possono sostenere l'attuale traiettoria del settore.

È in arrivo un "inverno dell'IA", quando l'IA subirà un lungo processo di perfezionamento ed efficienza prima di diventare più intelligente? Oppure le scoperte e le promesse dell'industria terranno a galla lo sviluppo?

IA bio-ispirata, per esempio, è una frontiera promettente che cerca di armonizzare l'efficienza dei sistemi naturali con l'intelligenza computazionale. La Terra è abitata da miliardi di organismi estremamente avanzati "alimentati" da fonti naturali come il cibo e il Sole: può essere un modello per l'intelligenza artificiale?

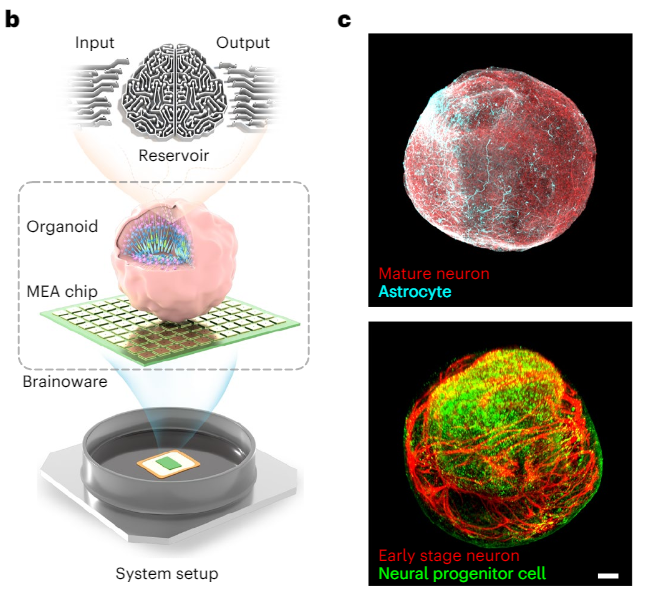

La risposta è un timido sì: i chip AI neuromorfi basati sulle funzioni sinaptiche stanno diventando sempre più praticabili. Il riconoscimento vocale dell'IA è stato addirittura eseguiti utilizzando cellule biologiche formate in "organoidi" - essenzialmente "mini-cervelli".

Altri metodi per mitigare la fuga di risorse dell'industria dell'IA includono una "tassa sull'IA".

Solitamente proposta come metodo per mitigare le perdite di posti di lavoro legate all'IA, una tassa sull'IA potrebbe vedere le entità che beneficiano dei progressi dell'IA contribuire a mitigare il loro impatto ambientale.

In definitiva, è difficile prevedere come il settore gestirà queste richieste e in che misura le persone dovranno farsi carico di questo onere.