Quando Google ha annunciato il rilascio dei suoi modelli Gemini c'è stata molta eccitazione, perché l'azienda ha dichiarato che erano alla pari con le offerte di OpenAI. Questo potrebbe non essere del tutto vero.

Google ha dichiarato che il suo Gemelli Ultra Il modello è migliore del GPT-4. Il modello non è ancora stato rilasciato, quindi dobbiamo prendere per buoni i risultati dei test di benchmark. Gemini Pro è stato rilasciato e Google afferma che è alla pari con GPT-3.5.

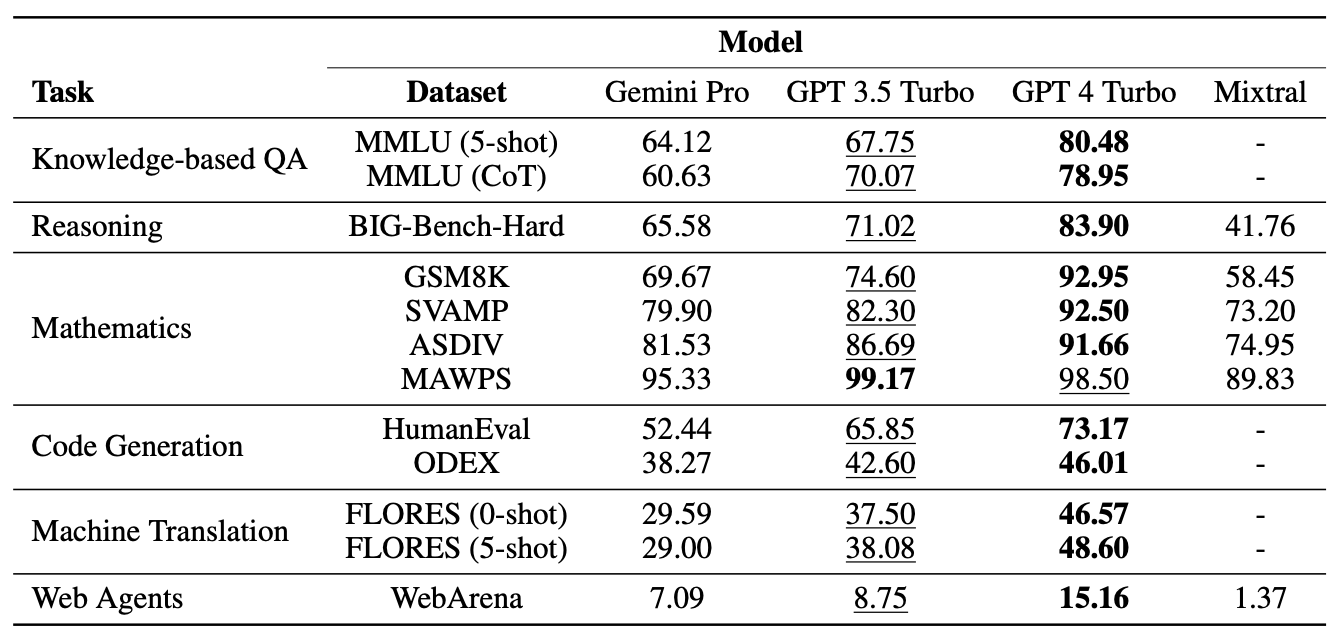

I ricercatori della Carnegie Mellon University e della piattaforma software di IA BerriAI hanno sottoposto Gemini Pro a una serie di compiti per testare le sue capacità di comprensione e generazione del linguaggio.

Gli stessi test sono stati eseguiti utilizzando GPT-3.5 Turbo, GPT-4 Turbo e il nuovo Mistral AI Modello Mixtral 8x7B.

Gemini di Google ha recentemente fatto scalpore come importante concorrente di GPT di OpenAI. Eccitante! Ma ci siamo chiesti:

Quanto è bravo il Gemelli?

Alla CMU abbiamo condotto uno studio imparziale, approfondito e riproducibile per confrontare Gemini, GPT e Mixtral.

Carta: https://t.co/S3T7ediQLa

🧵 pic.twitter.com/NmEOeDd8pI- Graham Neubig (@gneubig) 19 dicembre 2023

Risultati

Non sorprende che il GPT-4 abbia avuto la meglio, ma Google sarà meno entusiasta di vedere come Gemini Pro si è comportato nei confronti del GPT 3.5 Turbo. In una sintesi dei risultati del team, la carta ha dichiarato: "Il modello Pro di Gemini ha ottenuto un'accuratezza paragonabile ma leggermente inferiore rispetto alla versione attuale del GPT 3.5 Turbo di OpenAI".

Ecco una sintesi dei risultati.

I modelli sono stati sollecitati utilizzando l'interfaccia LiteLLM di BerriAI e ogni modello ha ricevuto esattamente le stesse richieste e lo stesso protocollo di valutazione.

I modelli sono stati testati su domande a scelta multipla, ragionamento generale, ragionamento matematico, generazione di codici, traduzione di lingue e comportamento come agente web.

Uno dei motivi per cui Gemini Pro ha ottenuto un punteggio basso nelle domande a scelta multipla è che aveva un forte pregiudizio posizionale. Spesso sceglieva la risposta in posizione D, indipendentemente dal fatto che fosse corretta o meno. È interessante notare che questo è un aspetto che il sistema di Microsoft Medprompt risolve con il rimescolamento.

Nonostante la sconfitta in alcuni test, Gemini Pro ha battuto GPT-3.5 Turbo in due aree, in particolare nell'ordinamento di parole e nella manipolazione e traduzione di simboli.

In tutti i compiti di traduzione completati, Gemini Pro ha superato tutti gli altri modelli, compreso GPT-4. Il punteggio finale di Gemini Pro nei test di traduzione è stato però inferiore a quello di GPT-3.5 perché ha rifiutato di completare alcune richieste quando sono entrati in funzione i suoi controlli di moderazione dei contenuti troppo zelanti.

E allora?

Google contesta le cifre a cui sono giunti i ricercatori e insiste nel dire che Gemini Pro è alla pari o migliore di GPT-3.5. Se teniamo conto della miriade di variabili e diamo a Google un po' di tregua, potremmo dividere la differenza e dire che Gemini Pro e GPT-3.5 sono praticamente uguali.

L'aspetto fondamentale è che Gemini Pro, un modello nuovo di zecca che Google ha sviluppato per mesi, non è in grado di battere un modello che è in circolazione da più di un anno e che può essere utilizzato gratuitamente tramite ChatGPT.

L'uscita di Gemini Ultra è prevista per l'inizio del 2024. Sarà all'altezza della sua affermazione di essere migliore del GPT-4? Speriamo che il professor Graham Neubig e il suo team possano eseguire presto test di benchmarking simili.