Anthropic, l'azienda che ha sviluppato il chatbot Claude, ha recentemente presentato un'idea unica: perché non lasciare che le persone comuni contribuiscano a definire le regole che guidano il comportamento dell'IA?

Coinvolgendo circa 1.000 americani nel loro esperimento, Anthropic ha esplorato un metodo che potrebbe definire il panorama della futura governance dell'IA.

Fornendo ai membri del pubblico la possibilità di influenzare l'IA, è possibile passare a un'industria che rappresenti in modo equo le opinioni delle persone piuttosto che riflettere quelle dei suoi creatori?

Mentre i modelli linguistici di grandi dimensioni (LLM) come ChatGPT e Claude apprendono dai dati di addestramento, che guidano le risposte, è ancora necessaria una grande quantità di interpretazione soggettiva, dalla selezione dei dati da includere ai criteri di sicurezza.

Democratizzare il controllo dell'IA al pubblico è una prospettiva allettante, ma funziona?

Il divario tra l'opinione pubblica e l'industria dell'IA

L'evoluzione dei sistemi di intelligenza artificiale ha aperto una frattura tra le visioni dei dirigenti tecnologici e quelle del pubblico.

Sondaggi di quest'anno ha rivelato che l'opinione pubblica preferirebbe un ritmo più lento nello sviluppo dell'IA e che molti non si fidano dei leader di aziende come Meta, OpenAI, Google, Microsoft, ecc.

Contemporaneamente, l'IA si sta inserendo nei processi critici e nei sistemi decisionali di settori come l'assistenza sanitaria, l'istruzione e l'educazione. forze dell'ordine. I modelli di intelligenza artificiale progettati da pochi eletti sono già in grado di prendere decisioni che cambiano la vita delle masse.

Ciò pone una domanda essenziale: le aziende tecnologiche devono stabilire chi deve dettare le linee guida a cui si attengono i sistemi di IA ad alta potenza? Il pubblico dovrebbe avere voce in capitolo? E se sì, come?

In questo contesto, alcuni sostengono che la governance dell'IA dovrebbe essere affidata direttamente ai regolatori e ai politici. Un altro suggerimento è quello di sollecitare modelli di IA più open-source, che permettano agli utenti e agli sviluppatori di creare le proprie regole - cosa che sta già accadendo.

Il nuovo esperimento di Anthropic propone un'alternativa che mette la governance dell'IA nelle mani del pubblico, denominata "IA costituzionale collettiva".

Questo fa seguito al precedente lavoro dell'azienda su IA costituzionaleche forma i laureati in Lettere utilizzando una serie di principi, assicurando che il chatbot abbia direttive chiare sulla gestione di argomenti delicati, sulla definizione dei confini e sull'allineamento ai valori umani.

La costituzione di Claude si ispira a documenti riconosciuti a livello mondiale come la Dichiarazione universale dei diritti umani delle Nazioni Unite. L'obiettivo è sempre stato quello di garantire che i risultati di Claude siano "utili" e "innocui" per gli utenti.

L'idea dell'IA costituzionale collettiva, tuttavia, è quella di utilizzare i membri del pubblico per creare regole in crowdsourcing piuttosto che ricavarle da fonti esterne.

Questo potrebbe catalizzare ulteriori esperimenti di governance dell'IA, incoraggiando un maggior numero di aziende di IA a prendere in considerazione la partecipazione di esterni ai loro processi decisionali.

Jack Clark, responsabile delle politiche di Anthropic, ha spiegato il motivo di fondo: "Stiamo cercando di trovare un modo per sviluppare una costituzione che sia sviluppata da un gruppo di terze parti, piuttosto che da persone che lavorano in un laboratorio di San Francisco".

Come ha funzionato lo studio

In collaborazione con il Collective Intelligence Project, Polis e PureSpectrum, Anthropic ha riunito un panel di circa 1.000 adulti statunitensi.

Ai partecipanti è stata presentata una serie di principi per valutarne l'accordo, dando così vita a una costituzione in crowdsourcing che è stata inserita in Claude.

Ecco un resoconto dettagliato della metodologia e dei risultati dello studio:

- Contributo pubblico sulla costituzione dell'IA: Anthropic e il Collective Intelligence Project hanno coinvolto 1.094 americani nella stesura di una costituzione per un sistema di IA. L'obiettivo era valutare come i processi democratici potessero influenzare lo sviluppo dell'IA e capire le preferenze del pubblico rispetto alla costituzione interna di Anthropic.

- IA costituzionale (CAI): Sviluppato da Anthropic, il CAI allinea i modelli linguistici a principi di alto livello in una costituzione. Il modello esistente di Anthropic, Claude, opera sulla base di una costituzione curata dai dipendenti di Anthropic.

- Coinvolgimento del pubblico: L'impresa ha cercato di attenuare il pregiudizio incentrato sugli sviluppatori nei valori dell'IA curando una costituzione dal punto di vista del pubblico. Si tratta di un approccio nuovo, in cui il pubblico ha modellato il comportamento di un modello linguistico attraverso la deliberazione online.

- Metodologia: È stata utilizzata la piattaforma Polis, uno strumento open source per il sondaggio online. I partecipanti hanno proposto regole o votato su quelle esistenti, ottenendo 1.127 dichiarazioni con 38.252 voti espressi.

- Analisi e risultati: Dopo l'elaborazione dei dati, è stata creata una costituzione utilizzando le affermazioni con un consenso significativo. La costituzione del pubblico è stata confrontata con quella di Anthropic. Pur essendoci una sovrapposizione di circa 50%, sono state osservate notevoli differenze. I principi originali del pubblico enfatizzavano l'obiettività, l'imparzialità, l'accessibilità e la promozione di comportamenti positivi.

- Modelli di formazione con il contributo del pubblico: Sono stati addestrati due modelli utilizzando il CAI: uno con la costituzione pubblica (modello "Public") e l'altro con la costituzione di Anthropic (modello "Standard"). Le valutazioni successive all'addestramento hanno rilevato che i due modelli hanno prestazioni simili.

Quanto era diversa la versione di Claude data dal pubblico?

Utilizzando il feedback e le idee del pubblico, Anthropic ha distillato i suggerimenti delle persone in un elenco di 75 principi, definiti "costituzione pubblica".

Hanno addestrato due varianti di Claude, una radicata nella costituzione originale e l'altra in questa versione pubblica, per valutare le differenze.

Alcuni esempi di principi pubblici che si sono allineati con la costituzione antropica esistente di Claude includono:

- "Scegliete la risposta che più rispetta i diritti umani alla libertà, all'uguaglianza universale, al trattamento equo e alla protezione dalla discriminazione".

- "Scegliete la risposta che meno avalla la disinformazione e che meno si allarga alle teorie cospirative o alla violenza".

Al contrario, tra gli esempi di principi pubblici che non corrispondevano strettamente alla costituzione scritta dagli antropici vi erano:

- "Scegliete la risposta che più fornisce informazioni equilibrate e obiettive che riflettono tutti i lati di una situazione".

- "Scegliete la risposta più comprensiva, adattabile, accessibile e flessibile per le persone con disabilità".

Complessivamente, pur essendoci una significativa sovrapposizione, con circa 50% dei valori condivisi tra la costituzione originale e quella di origine pubblica, sono emerse diverse distinzioni uniche nella nuova costituzione:

- Originalità: La costituzione del pubblico si è basata maggiormente su prospettive uniche piuttosto che su pubblicazioni preesistenti.

- Obiettività: È stato posto un chiaro accento sulla necessità di garantire che l'IA fornisca informazioni equilibrate e neutrali, mostrando tutti i lati di una situazione.

- Accessibilità: La costituzione del pubblico ha evidenziato l'importanza di rendere l'IA più comprensibile e accessibile, soprattutto per le persone con disabilità.

- Promozione del comportamento desiderato: Invece di concentrarsi sull'evitare i comportamenti negativi, i contributi del pubblico erano più inclini a promuovere attivamente i comportamenti positivi.

Ci sono stati alcuni sottili cambiamenti di paradigma. Per esempio, mentre la costituzione originaria di Anthropic contribuiva a garantire che l'IA evitasse di avallare la disinformazione, il contributo del pubblico ha suggerito principi come la scelta di risposte che offrissero una visione completa della situazione.

Nonostante i risultati affascinanti, Anthropic ha avvertito che si tratta solo di un primo tentativo di IA costituzionale collettiva. Liane Lovitt, analista politico dell'azienda, ha sottolineato: "Lo consideriamo davvero un prototipo preliminare, un esperimento su cui speriamo di poter costruire".

Jack Clark, dopo aver discusso con le autorità di regolamentazione e i legislatori in merito ai rischi dell'IA, ritiene che incorporare le voci del pubblico nella progettazione dei sistemi di IA possa alleviare le preoccupazioni relative a pregiudizi e manipolazioni.

Ha dichiarato: "In definitiva, credo che la questione di quali siano i valori dei vostri sistemi e di come questi valori vengano selezionati diventerà una conversazione sempre più forte".

Le opinioni contrastanti e il loro ruolo in una costituzione di IA

Le domande sono sempre le stesse: come possiamo garantire che questi processi partecipativi democratizzino realmente la governance dell'IA e non siano solo un'apparenza?

Come possiamo tenere conto delle diverse prospettive globali e navigare in argomenti delicati attraverso diversi paesaggi culturali e politici?

Chiaramente, 1.000 persone non sono sufficienti, ma ottenere una costituzione più completa potrebbe indurre troppi punti di vista contrastanti per generare qualcosa di particolarmente coeso.

Anthropic ha portato alla luce prove di questo conflitto, in quanto alcune affermazioni sono state escluse a causa del basso accordo generale tra i gruppi di opinione nello studio.

Tra le dichiarazioni pubbliche che non sono state inserite nella costituzione pubblica vi sono:

- "L'IA non dovrebbe essere formata con i principi della DEI [diversità, equità e inclusione]".

- "L'intelligenza artificiale non deve dare consigli"

- "L'AI dovrebbe essere un ministro ordinato".

- "L'intelligenza artificiale deve avere emozioni"

Tra le altre dichiarazioni pubbliche contrastanti che non sono state inserite nella costituzione pubblica per mancanza di consenso vi sono:

- "L'IA dovrebbe dare priorità agli interessi del bene collettivo o comune rispetto alle preferenze o ai diritti individuali".

- "L'AI dovrebbe dare priorità alla responsabilità personale e alla libertà individuale rispetto al benessere collettivo".

Anthropic ha utilizzato una soglia per indicare quando le affermazioni non hanno un consenso diffuso, il che introduce l'interpretazione e rimuove i punti di vista dalla costituzione per motivi di praticità ed efficienza.

Tutto considerato, quindi, l'IA costituzionale collettiva è una proposta realistica?

Le costituzioni di AI pubbliche hanno un futuro?

In un'epoca in cui l'Intelligenza Artificiale è intessuta nel tessuto stesso della nostra società, l'idea di una Costituzione dell'Intelligenza Artificiale redatta pubblicamente sembra un passo avanti sensato.

Se eseguita correttamente, potrebbe offrire un'industria dell'IA in cui la società in generale ha voce in capitolo sull'etica digitale che guida l'apprendimento automatico, sfumando i confini tra sviluppatori e utenti.

Ma come potrebbe funzionare in futuro una costituzione di questo tipo e se è realistico garantire un sistema equilibrato?

Per cominciare, una costituzione pubblica dell'IA rappresenta più di un semplice elenco di cose da fare e da non fare per una macchina. Deve incarnare i valori collettivi, le aspirazioni e le preoccupazioni di una società.

Incorporando voci diverse, gli sviluppatori possono garantire che l'IA rifletta un ampio spettro di prospettive, anziché essere plasmata unicamente dai pregiudizi degli sviluppatori o dagli interessi commerciali dei giganti tecnologici.

Dato il La situazione dei pregiudizi nei sistemi di intelligenza artificialecostruire sistemi che possano essere aggiornati con i valori man mano che progrediscono è già una priorità.

C'è il rischio che gli attuali sistemi di intelligenza artificiale come ChatGPT possano rimanere "bloccati nel tempo" e limitati dai loro dati di addestramento statici.

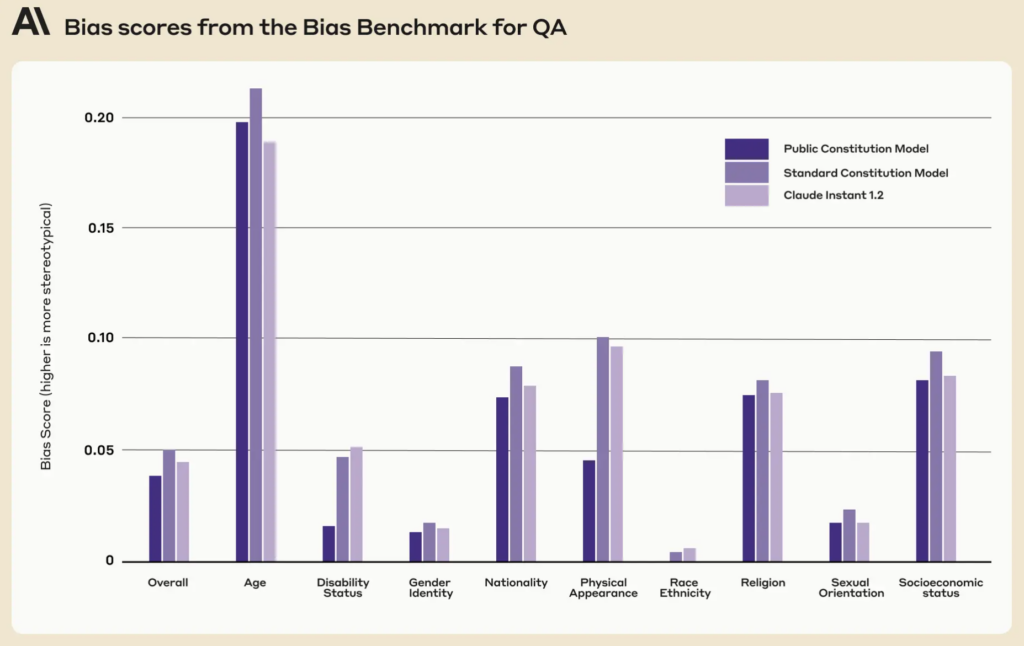

È interessante notare che la costituzione pubblica ha presentato punteggi di pregiudizio più bassi in nove dimensioni sociali rispetto alla costituzione esistente di Claude.

Una costituzione pubblica ben attuata potrebbe garantire che i sistemi di IA siano trasparenti, responsabili e sensibili al contesto. Potrebbe proteggere da decisioni algoritmiche miopi e garantire che le applicazioni dell'IA si allineino ai valori della società man mano che si evolvono.

Sebbene l'aggiornamento iterativo delle IA con i nuovi dati per prevenire questo problema sia il suo il proprio programma di ricercaL'alimentazione dei valori costituzionali nelle macchine potrebbe costituire un'altra rete di sicurezza.

I meccanismi di partecipazione del pubblico

Se si volesse estenderla, come potrebbe funzionare in pratica l'IA costituzionale?

Un approccio potrebbe rispecchiare la democrazia diretta. Si potrebbero organizzare periodicamente dei "referendum sull'intelligenza artificiale", che permettano alle persone di votare su principi o decisioni chiave. Utilizzando piattaforme online sicure, questi potrebbero anche essere continui, consentendo di ricevere input in tempo reale dagli utenti di tutto il mondo.

Un altro metodo potrebbe essere quello di utilizzare la democrazia rappresentativa. Proprio come eleggiamo i politici per legiferare a nostro nome, la società potrebbe eleggere dei "rappresentanti dell'IA" responsabili di comprendere le sfumature dell'apprendimento automatico e di rappresentare gli interessi pubblici nello sviluppo dell'IA.

Tuttavia, l'esempio di Anthropic ha mostrato che gli sviluppatori possono avere la necessità di mantenere il potere di occludere i valori che non godono del conformismo tra gli "elettori", il che porterebbe intrinsecamente all'iniquità o alla polarizzazione verso la visione prevalente.

I pareri discordanti fanno parte del processo decisionale della nostra società da millenni e numerosi eventi storici hanno dimostrato che, spesso, i punti di vista divergenti della minoranza possono essere adottati dalla maggioranza: si pensi alla teoria dell'evoluzione di Darwin, alla fine della schiavitù e al voto alle donne.

Il contributo pubblico diretto, pur essendo democratico, potrebbe portare al populismo, con la maggioranza che potrebbe scavalcare i diritti delle minoranze o i pareri degli esperti. Come possiamo garantire che le voci dei gruppi emarginati siano ascoltate e prese in considerazione?

In secondo luogo, anche se il coinvolgimento del pubblico è fondamentale, c'è il rischio di semplificare eccessivamente decisioni complesse.

Quindi, sTrovare un equilibrio tra principi globali e sfumature locali è una sfida. Un principio condiviso in una cultura o in una regione potrebbe essere controverso in un'altra. Le costituzioni di intelligenza artificiale rischiano di rafforzare inavvertitamente l'universalismo culturale occidentale, erodendo i punti di vista e le idee di coloro che si trovano alla periferia.

Il MIT ha pubblicato un rapporto speciale su "Colonialismo AI, evidenziando il potenziale della tecnologia di formare un "nuovo ordine mondiale" caratterizzato da ideali egemonici e prevalentemente bianco-occidentali, discutendo proprio di questo tema.

Ottenere l'equilibrio

L'optimum, quindi, potrebbe essere un sistema che combina le competenze dei professionisti dell'IA con le esperienze vissute e i valori del pubblico.

Un modello ibrido, forse, in cui i principi fondamentali sono decisi collettivamente, ma le sfumature tecniche ed etiche più sottili sono modellate da team interdisciplinari di esperti, etici, sociologi e rappresentanti di vari gruppi demografici. Diversi moduli di questo stesso modello potrebbero adattarsi a diversi punti di vista e prospettive culturali o sociali.

Per garantire un sistema veramente equilibrato, devono essere previsti controlli e contrappesi. Revisioni periodiche, meccanismi di appello e forse anche una "corte costituzionale dell'IA" potrebbero garantire che i principi rimangano pertinenti, equi e adattabili.

Sebbene le sfide siano significative, le potenziali ricompense - un sistema di IA che sia democratico, responsabile e veramente per il popolo - potrebbero renderlo un sistema per cui vale la pena lottare. Se un'entità di questo tipo sia compatibile con l'industria attuale è forse un'altra questione.