In un passato non troppo lontano, le conversazioni sull'IA erano principalmente confinate nel regno della fantascienza e dei documenti accademici.

Oggi l'intelligenza artificiale è profondamente integrata nel tessuto della vita quotidiana, dall'alimentazione delle case intelligenti alla diagnosi delle malattie.

Ma mentre la tecnologia dell'IA avanza, i quadri normativi stanno giocando a recuperare terreno, spesso in ritardo rispetto alla curva dell'innovazione.

Questo pone l'umanità di fronte a un rompicapo dalle mille sfaccettature: come possiamo creare leggi e regolamenti che siano abbastanza agili da adattarsi ai rapidi cambiamenti tecnologici e allo stesso tempo abbastanza solidi da proteggere gli interessi della società?

In tutto il mondo, gli sforzi normativi sono tutt'altro che uniformi. L'Unione Europea (UE) sta preparando il terreno con la sua legge sull'IA, che mira a classificare e controllare le applicazioni di IA in base al loro livello di rischio.

Nel frattempo, gli Stati Uniti hanno preferito gli impegni volontari alla legislazione immediata.

La Cina, d'altro canto, esercita una stretta sorveglianza sull'IA, allineando la regolamentazione a più ampi obiettivi di governance politica e sociale.

E non dimentichiamo le altre giurisdizioni: l'IA è un fenomeno globale che richiederà una legislazione quasi universale. copertura.

Quindi, a che punto è la regolamentazione e come ci si aspetta che progredisca?

L'approccio dell'UE

L'UE ha adottato un quadro rigoroso con la sua innovativa legge sull'IA, che dovrebbe essere approvata completamente entro la fine dell'anno.

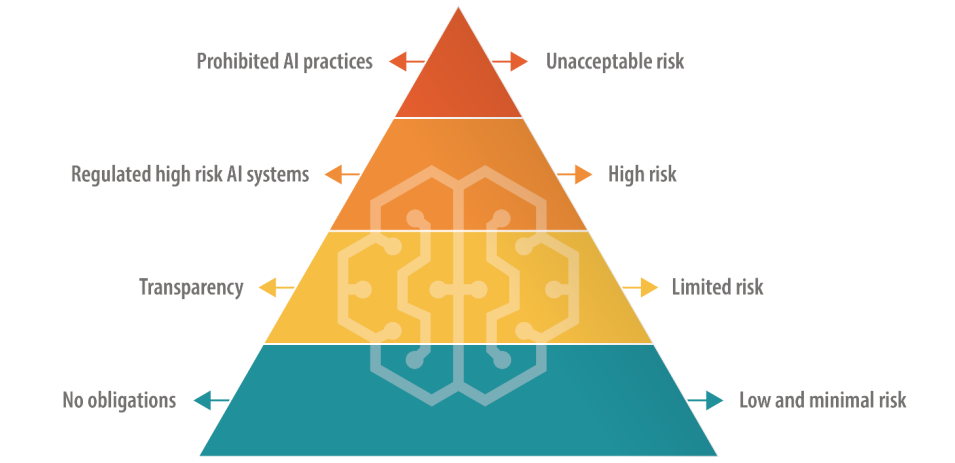

La legge sull'IA specifica quattro livelli, tra cui "IA a rischio inaccettabile", "IA ad alto rischio", "IA a rischio limitato" e "IA a basso rischio", ciascuno con una serie specifica di linee guida e divieti.

Le IA a rischio inaccettabile presentano pericoli immediati o considerevoli, come causare danni fisici o mentali o violare i diritti umani, e saranno completamente vietate.

Le IA ad alto rischio sono consentite, ma sono soggette a norme rigorose, dalla gestione del rischio alla documentazione tecnica e alla cybersecurity.

Le IA limitate e a basso rischio, invece, rimangono prevalentemente non regolamentate, ma sono tenute a mantenere la trasparenza nei confronti degli utenti.

C'è una tregua nel breve termine, poiché la legislazione prevede un periodo di grazia di circa due anni per le aziende per allinearsi alle nuove normative.

L'UE propone che i creatori originali dei modelli di IA siano responsabili dell'uso che viene fatto della loro tecnologia, anche se incorporata in un altro sistema da un'altra azienda o sviluppatore. Sono state inoltre aggiunte nuove regole per i "modelli di fondazione", che comprendono i modelli di IA generativa.

L'accoglienza della legge sull'IA è varia: alcuni criticano le sue definizioni maldestre e il suo potenziale di freno all'innovazione. Ad esempio, vi è una notevole incertezza sul modo in cui i diversi modelli di IA vengono classificati nelle categorie di rischio.

Inoltre, le aziende di AI più piccole temono di non avere le risorse da dedicare alla conformità.

Sam Altman, CEO di OpenAI minacciato brevemente di ritirare i prodotti della sua azienda dal mercato dell'UE se la legge sull'AI specificasse requisiti che non possono essere realisticamente rispettati.

A giugno, 150 grandi aziende ha evidenziato l'approccio pesante della legge, affermando che le regole attuali rischiano di distruggere la competitività europea.

Divergenza dagli Stati Uniti

A Analisi di Stanford dell'AI Act ha discusso le differenze fondamentali tra gli approcci dell'UE e degli USA alla regolamentazione dell'AI.

Alex Engler, ricercatore di Governance Studies presso la Brookings Institution, ha dichiarato: "C'è una crescente disparità tra l'approccio degli Stati Uniti e quello dell'UE [alla regolamentazione dell'IA]".

Sottolinea che l'UE ha spinto per l'introduzione di leggi sulla privacy e sulla trasparenza dei dati, che negli Stati Uniti sono per lo più assenti. La disparità confonde la conformità per le aziende di IA e i costi associati alla conformità intergiurisdizionale potrebbero essere eccessivi.

"Gli interessi delle aziende combatteranno con le unghie e con i denti se ci saranno due standard drammaticamente diversi per le piattaforme online", ha dichiarato Engler.

Nel complesso, quando si arriverà al dunque, è difficile immaginare che le aziende tecnologiche non trovino un modo per navigare nell'AI Act come hanno fatto con il GDPR e dovranno fare con il recente Digital Services Act.

Parlando con il rivista NatureDaniel Leufer, analista senior delle politiche di Access Now, respinge le obiezioni dell'industria dell'IA alla legge come "la solita ostentazione".

L'approccio del Regno Unito

Dopo la Brexit, il Regno Unito intende sfruttare la sua indipendenza dall'UE per formulare un regime normativo più flessibile e specifico per il settore.

A differenza dell'AI Act, il governo britannico intende regolamentare le applicazioni dell'IA piuttosto che il software sottostante.

Una posizione "a favore dell'innovazione

Il governo britannico ha pubblicato un libro bianco a marzo che delinea un quadro "a favore dell'innovazione", invitando le parti interessate a condividere le loro opinioni. Tuttavia, il governo non ha ancora pubblicato le linee guida per l'attuazione di questo quadro.

In una dichiarazione si legge che "il governo aiuterà il Regno Unito a sfruttare le opportunità e i benefici che le tecnologie dell'IA presentano" - un approccio criticato per non aver prestato la giusta attenzione ai danni legati all'IA.

Il governo aveva addirittura previsto di offrire alle imprese di IA una "esenzione dal diritto d'autore" estremamente controversa ma Inversione di rotta rispetto a quel piano in agosto.

Ultimamente la Gran Bretagna ha avuto difficoltà ad attirare l'innovazione tecnologica, in particolare ha perso il produttore di chip Arm di Cambridge, che ha scelto di quotare pubblicamente le azioni negli Stati Uniti piuttosto che in patria. Questo forse alimenta l'ansia del Regno Unito di riaccendere il suo settore tecnologico in declino.

Per contribuire a posizionare il Regno Unito come un paese all'avanguardia nel campo dell'intelligenza artificiale, il primo ministro Rishi Sunak ha annunciato una due giorni Vertice sulla sicurezza dell'intelligenza artificiale che si svolgerà a novembre.

In particolare, la Cina è stata invitata all'evento, anche se si ipotizza una sua esclusione. timori di spionaggio.

L'approccio statunitense

Negli Stati Uniti, l'attenzione è rivolta a consentire al settore di autoregolamentarsi, almeno per il momento.

Il Congresso degli Stati Uniti sta segnalando un approccio "attendista", avviando una revisione degli incontri a porte chiuse dell'IA e di Chuck Schumer. Forum AI Insight per determinare dove esattamente l'IA richiede una nuova regolamentazione.

Gli accordi bipartisan potrebbero essere incentrati su una legislazione strettamente personalizzata che affronti i temi della privacy, della trasparenza delle piattaforme o del proteggere i bambini online.

Inoltre, alcuni hanno sottolineato che le leggi e i regolamenti esistenti rimangono rilevanti per l'IA.

A giugno, Khan ha dettoNon esiste un'esenzione dalle leggi che proibiscono la discriminazione... Man mano che queste cose diventano più radicate nel modo in cui vengono prese le decisioni quotidiane, penso che invitino e meritino un grande controllo... Penso che gli esecutori, sia a livello statale che nazionale, agiranno".

Quadri volontari e stop-gaps

Aziende tecnologiche di spicco come Microsoft, OpenAI, Google, Amazon e Meta hanno recentemente hanno sottoscritto impegni volontari per uno sviluppo sicuro dell'IA, compresa la conduzione di test interni ed esterni sui modelli di intelligenza artificiale prima del rilascio pubblico.

Molti leader dell'industria tecnologica si sono fatti avanti con le loro promesse, ma in In assenza di una solida supervisione legislativa, la sincerità di queste promesse deve ancora essere messa alla prova.

Nel complesso, i critici sostengono che l'approccio degli Stati Uniti sia essenzialmente simbolico, privo della profondità e dell'impegno dell'AI Act dell'UE. Il primo Forum di approfondimento sull'intelligenza artificiale è stato un evento in gran parte a porte chiuse che alcuni hanno criticato per la limitazione del dibattito aperto.

Il senatore Josh Hawley ha detto che l'evento è stato un "gigantesco cocktail party".

Come ha giustamente riassunto Ryan Calo, professore della University of Washington School of Law, "c'è un'apparenza di attività, ma nulla di sostanziale e vincolante".

L'approccio cinese

La Cina, in proporzione al suo appetito per il controllo statale, sta imponendo alcune delle normative più severe sull'IA.

L'accento è posto sul controllo della diffusione delle informazioni da parte dell'IA, che riflette il più ampio quadro di governance politica e sociale della Cina.

Ad esempio, i fornitori di IA generativa i cui prodotti possono "avere un impatto sull'opinione pubblica" sono tenuti a sottoporsi a verifiche di sicurezza.

La prima ondata di chatbot approvati, tra cui l'ERNIE Bot di Baidu, è stata recentemente rilasciato al pubblico e si è scoperto che censurava le domande a tema politico.

L'ondata di "deep fake" e di contenuti generati dall'IA pone delle sfide in tutto il mondo e la Cina non fa eccezione. Riconoscendo le potenziali insidie dell'IA già all'inizio dell'anno, la Cyberspace Administration of China (CAC) ha imposto ai generatori di contenuti generati dall'IA di sottoporsi a processi di verifica dell'identità degli utenti.

Inoltre, sono state introdotte disposizioni di watermarking per distinguere i contenuti generati dall'IA da quelli creati dall'uomo, regole che anche le potenze occidentali cercano di attuare.

Divergenza tra Stati Uniti e Cina

L'intelligenza artificiale ha accelerato gli attriti tra Stati Uniti e Cina, scatenando quella che molti hanno definito una "guerra fredda digitale" - o forse, più appropriatamente, una "guerra fredda dell'intelligenza artificiale".

Le restrizioni statunitensi alla collaborazione e al commercio con la Cina non sono una novità, ma il disaccoppiamento tra i due Paesi ha fatto un passo avanti quando Xi Jinping ha annunciato la sua nuova riforma. Piano Made in China 2025.

L'obiettivo è quello di rendere la Cina 70% autosufficiente in settori tecnologici cruciali entro il 2025, compresa la tecnologia AI di fascia alta.

Attualmente gli Stati Uniti sono interrompere i finanziamenti e la ricerca legami con la Cina, assoggettando al contempo l'acquisto di chip per l'intelligenza artificiale da aziende come Nvidia.

Mentre gli Stati Uniti sono in netto vantaggio nella corsa al dominio dell'IA, la Cina ha alcuni assi nella manica, tra cui un approccio centralizzato alla regolamentazione e dati personali quasi illimitati.

A maggio, Edith Yeung, partner della società di investimenti Race Capital, ha dichiarato alla BBCLa Cina ha molte meno regole sulla privacy e molti più dati rispetto agli Stati Uniti. Ad esempio, le telecamere a circuito chiuso effettuano il riconoscimento facciale ovunque".

La stretta collaborazione tra il governo e l'industria tecnologica cinese offre anche dei vantaggi, in quanto la condivisione dei dati tra il governo e le aziende tecnologiche nazionali è praticamente senza soluzione di continuità.

Gli Stati Uniti e altre giurisdizioni occidentali non hanno lo stesso accesso ai dati aziendali e personali, che sono la linfa vitale dei modelli di apprendimento automatico. In effetti, si teme già che i dati di alta qualità le fonti di dati si stanno "esaurendo".'

Inoltre, l'uso liberale da parte delle aziende occidentali di AI di dati di addestramento potenzialmente protetti dal diritto d'autore ha suscitato un'ampia protesta e cause legali.

Le aziende cinesi di IA probabilmente non soffriranno di questo problema.

Bilanciare accessibilità e rischio

Un tempo l'IA era confinata al mondo accademico e alle grandi imprese. Nel giro di un anno circa, tra un quarto e la metà degli adulti nel Regno Unito, negli Stati Uniti e nell'Unione Europea ha utilizzato l'IA generativa.

L'accessibilità ha molti vantaggi, tra cui quello di stimolare l'innovazione e ridurre le barriere all'ingresso per le startup e i singoli sviluppatori. Tuttavia, ciò solleva anche preoccupazioni riguardo al potenziale abuso che deriva da un accesso non regolamentato.

Il recente incidente che ha visto il modello linguistico Llama-1 di Meta è stato diffuso su Internet esemplifica le sfide del contenimento della tecnologia AI. Modelli di IA open-source sono già stati utilizzati per scopi fraudolenti e per generare immagini di abusi su minori.

Le aziende di intelligenza artificiale lo sannoe i modelli open-source minacciano il loro vantaggio competitivo. Meta è emersa come una sorta di antagonista del settore, rilasciando una serie di modelli gratuiti mentre altri, come Microsoft, OpenAI e Google, lottano per monetizzare i loro prodotti di intelligenza artificiale.

Altri modelli open-source, come il Falcon 180B LLMsono eccezionalmente potenti ma privi di guardrail.

Alcuni ipotizzano che le grandi aziende di IA stiano spingendo per una regolamentazione, in quanto questa costringe gli attori più piccoli e la comunità open-source a uscire dal giro, consentendo loro di mantenere il dominio sul settore.

L'enigma del doppio uso dell'IA

Un altro fattore complesso è rappresentato dalle applicazioni doppie o multiple dell'IA.

Gli stessi algoritmi che possono migliorare la qualità della nostra vita possono anche essere utilizzati come armi o applicati in ambito militare. Questo potrebbe essere il tallone d'Achille del quadro euristico della legge UE sull'IA: come interpretare le IA utili che possono essere modificate per nuocere?

La regolamentazione delle tecnologie a duplice uso è notoriamente complessa. L'implementazione di controlli severi potrebbe soffocare l'innovazione e la crescita economica quando solo un'esigua minoranza fa un uso improprio di una tecnologia AI.

Le aziende produttrici di IA possono aggirare la colpa creando politiche contro l'uso improprio, ma questo non impedisce alle persone di usare jailbreak' per indurre i modelli a produrre materiale illecito.

Bilanciare i vantaggi economici dell'IA e le preoccupazioni etiche

I vantaggi dell'IA sono economicamente convincenti, soprattutto in settori come la sanità, l'energia e la produzione.

Rapporti da McKinsey e PwC prevedono che l'IA contribuirà per trilioni all'economia globale ogni anno, indipendentemente dall'impatto della sostituzione dei posti di lavoro e dei licenziamenti.

L'intelligenza artificiale può essere vista come una via per la creazione di posti di lavoro e la crescita per i Paesi che stanno lottando con problemi economici.

Su una scala filosofica più ampia, l'IA viene a volte rappresentata come il salvatore dell'umanità in mezzo a problemi macroscopici come la povertà, il cambiamento climatico e l'invecchiamento della popolazione.

I governi occidentali - in particolare gli Stati Uniti e il Regno Unito - sembrano propensi ad alimentare la crescita attraverso incentivi fiscali, finanziamenti per la ricerca sull'IA e un approccio normativo improntato al laissez-faire.

È una scommessa che gli Stati Uniti hanno fatto in passato consentendo all'industria tecnologica di autoregolamentarsi, ma può continuare a dare i suoi frutti?

WLe previsioni catastrofiche che paragonano l'IA a "guerre nucleari" e "pandemie globali" mettono in crisi le visioni romantiche del potenziale della tecnologia di sollevare l'umanità da problemi globali sempre più incombenti?

L'IA presenta una certa dualità che evoca visioni del futuro sia eutopiche che distopiche, a seconda di chi si ascolta.

Realizzare un'entità di questo tipo è una sfida senza precedenti.

In ogni caso, entro la fine del 2024, vivremo probabilmente in un mondo in cui l'IA sarà quasi universalmente regolamentata, ma nessuno è in grado di rispondere a quanto il settore sia in grado di gestire l'IA. - e la tecnologia stessa - si sarà evoluto per allora.