Uno studio condotto da psicologi dell'UCLA ha dimostrato che il GPT-3 è bravo quanto gli studenti universitari a risolvere problemi di ragionamento.

Sappiamo che i LLM come il GPT-3 sono bravi a generare risposte basate sui dati su cui sono stati addestrati, ma la loro capacità di ragionamento è discutibile. Il ragionamento analogico è la capacità degli esseri umani di prendere ciò che impariamo da un'esperienza non correlata e applicarlo a un problema che non abbiamo mai affrontato prima.

È su questa capacità che si fa affidamento quando si deve rispondere a una domanda mai vista prima. Si può ragionare sulla base di problemi precedenti che si sono risolti. Dalla ricerca, sembra che il GPT-3 abbia sviluppato anche questa capacità.

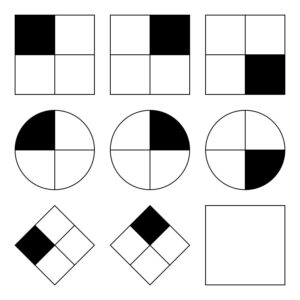

Il Ricercatori dell'UCLA mettere il GPT-3 al lavoro su un insieme di problemi simili a Matrici progressive di Raven che consiste nel prevedere l'immagine successiva di una serie di immagini. Eccone uno facile da provare.

Il GPT-3 è stato in grado di reggere il confronto con i 40 laureandi dell'UCLA a cui è stato chiesto di fare lo stesso test. L'intelligenza artificiale ha azzeccato le risposte nell'80% delle volte, mentre i 40 studenti hanno ottenuto una media di circa 60%. I migliori studenti hanno ottenuto circa lo stesso punteggio del GPT-3.

Il professore di psicologia dell'UCLA Hongjing Lu, autore senior dello studio, ha dichiarato: "Sorprendentemente, non solo il GPT-3 si è comportato bene come gli esseri umani, ma ha anche commesso errori simili".

I ricercatori hanno anche chiesto al GPT-3 di risolvere alcuni problemi di associazione di parole. Ad esempio, "Auto" sta a "Strada" come "Barca" sta a quale parola?". La risposta è ovviamente "acqua", ma questo tipo di domande può essere difficile per un'intelligenza artificiale.

Beh, almeno i ricercatori pensavano che potesse essere difficile. È emerso che il GPT-3 ha ottenuto risultati migliori rispetto alla media dei candidati all'università nei loro SAT.

Il GPT-3 è alle prese con problemi facili per gli esseri umani.

I problemi con cui i modelli di intelligenza artificiale hanno difficoltà sono quelli che richiedono una comprensione visiva dello spazio fisico. Se si presenta a GPT-3 un elenco di strumenti come un martello, un chiodo e un quadro, non è in grado di trovare la soluzione più ovvia per appendere il quadro alla parete.

Per gli esseri umani è facile risolvere questo tipo di problemi perché possiamo vedere, tenere e sentire oggetti fisici in uno spazio che occupiamo. Queste esperienze rendono facile per il nostro cervello imparare e risolvere i problemi in un modo che i modelli di intelligenza artificiale non possono fare. Detto questo, il GPT-4 sta migliorando in questo tipo di ragionamento.

Sebbene i ricercatori abbiano potuto misurare le prestazioni del GPT-3, non hanno idea del processo di "pensiero" che segue per ottenere le risposte. Segue un processo di pensiero simile a quello umano o fa qualcosa di completamente diverso? Essendo il GPT-3 un modello chiuso, non è possibile guardare sotto il cofano per vedere cosa succede.

Il risultato sorprendente di questa ricerca è che il GPT-3 sembra essere in grado di risolvere problemi nuovi senza alcun addestramento diretto. Questo è strettamente in linea con il modo in cui gli esseri umani risolvono i nuovi problemi. Si prevede che il GPT-4 sia ancora più bravo in questi problemi e chissà quali altre capacità di "pensare" potrebbero emergere con ulteriori test.

Sebbene il ragionamento spaziale sia una sfida per i LLM, queste sfide potrebbero essere risolte da modelli visivi quali RT-2 di Google che è stato recentemente annunciato. Quando i modelli di intelligenza artificiale potranno iniziare a "vedere" e interagire fisicamente con l'ambiente circostante, le loro capacità di risoluzione dei problemi miglioreranno in modo esponenziale.