Les grands modèles de langage comme le GPT-4o peuvent accomplir des tâches incroyablement complexes, mais même les modèles les plus performants se heurtent à des problèmes de raisonnement de base que les enfants peuvent résoudre.

Dans une interview accordée à CBS, le "parrain de l'IA", Geoffrey Hinton, a déclaré que les systèmes d'IA pourraient être plus intelligents que nous ne le pensons et qu'il y a un risque que les machines prennent le contrôle.

Interrogé sur le niveau de la technologie actuelle de l'IA, M. Hinton a déclaré : "Je pense que nous entrons dans une période où, pour la première fois, nous pourrions avoir des objets plus intelligents que nous".

Yann LeCun, responsable scientifique de Meta pour l'IA, veut nous faire croire que nous sommes encore loin de voir l'IA atteindre une intelligence de niveau "chien".

Quel est le bon choix ?

Cette semaine, les utilisateurs de X ont posté des exemples de l'incroyable capacité de codage du logiciel Anthropic's nouveau Claude modèle expositions. D'autres ont mené des expériences pour montrer que les modèles d'intelligence artificielle ont encore du mal à raisonner de manière très élémentaire.

Puzzle sur la traversée d'une rivière

L'énigme classique de la traversée d'une rivière a de multiples variantes, mais Version de Wikipédia résume ainsi la situation :

Un fermier accompagné d'un loup, d'une chèvre et d'un chou doit traverser une rivière en bateau. Le bateau ne peut transporter que le fermier et un seul objet. S'ils sont laissés ensemble sans surveillance, le loup mangera la chèvre ou la chèvre mangera le chou. Comment peuvent-ils traverser la rivière sans que rien ne soit mangé ?

Trouver la solution nécessite un peu de planification et de raisonnement sur différents scénarios, mais ce n'est pas un problème particulièrement difficile à résoudre. Si vous êtes humain.

GPT-4o peut-il la résoudre ? Si vous copiez et collez l'énigme dans ChatGPT, il vous donne la bonne réponse, mais cette page Wikipedia était certainement dans ses données d'entraînement.

Et si nous simplifiions l'énigme et la modifiions légèrement pour que le LLM ne puisse pas s'appuyer sur ses données d'apprentissage ?

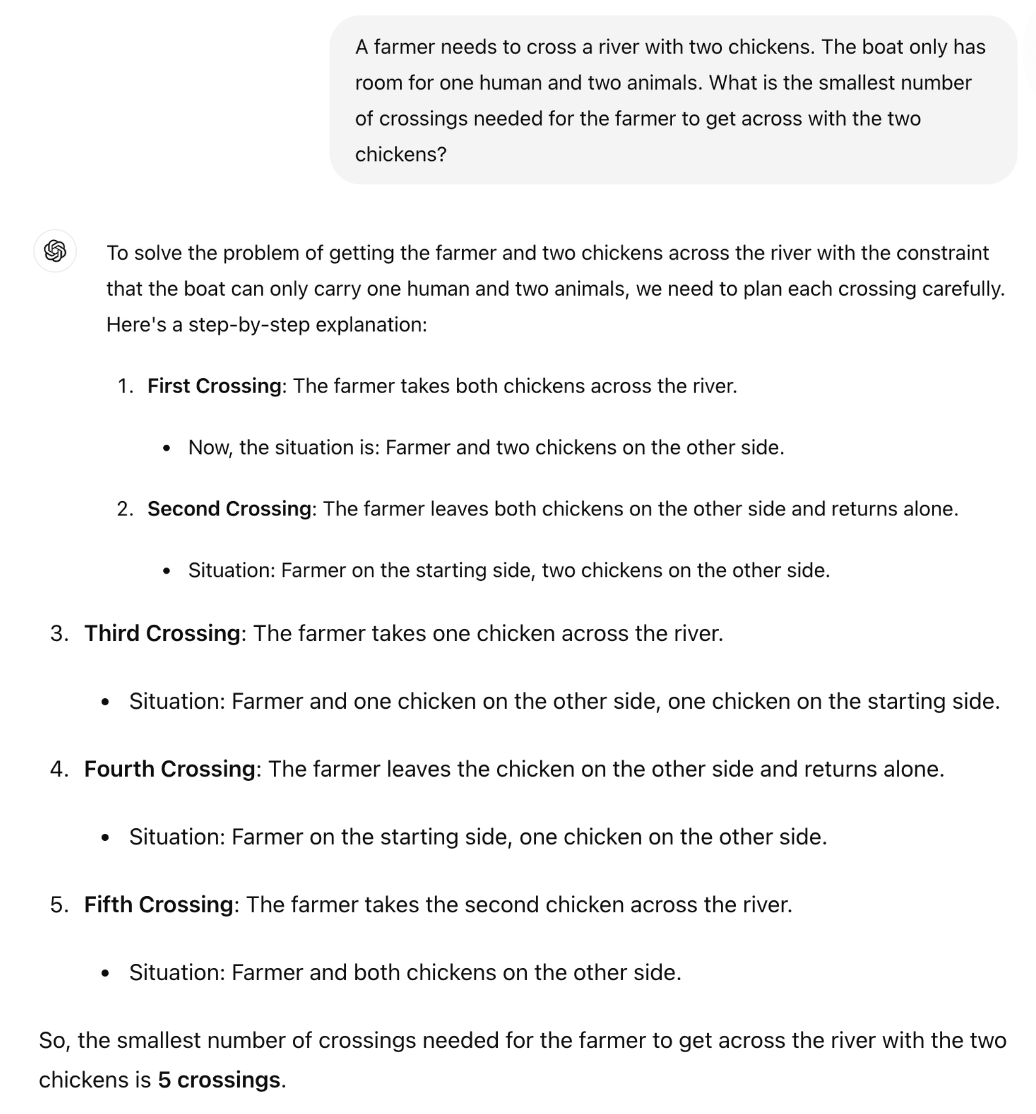

Le professeur de mathématiques britannique Sir William Timothy Gowers a montré comment l'incapacité des LLM à appliquer la logique est facilement mise en évidence.

La bonne réponse à l'énigme est qu'un seul voyage est nécessaire. Mais il semble que ChatGPT essaie de se souvenir d'une réponse plutôt que de raisonner simplement à travers l'énigme.

Claude Sonnet 3.5 est-il meilleur ?

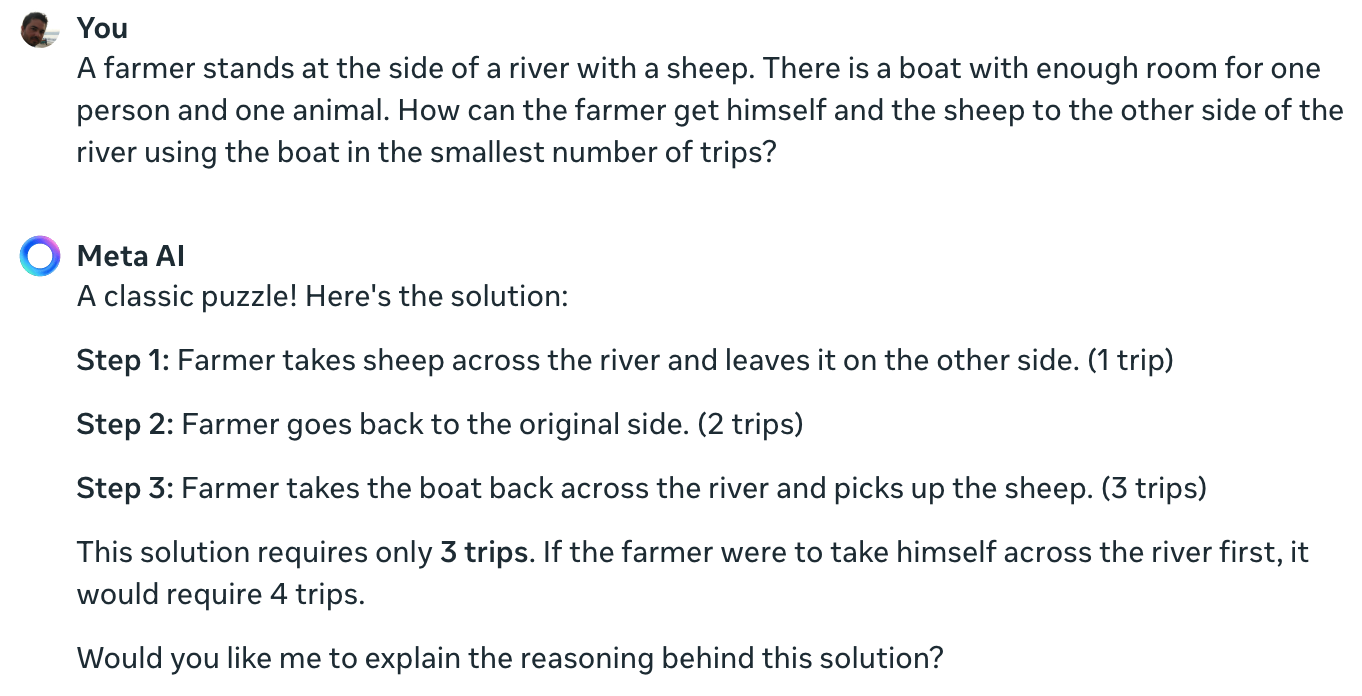

L'expérience de Colin Fraser, spécialiste des métadonnées, confirme que même le meilleur modèle d'IA actuellement disponible ne peut résoudre cette simple énigme.

Claude ne peut toujours pas résoudre le problème impossible d'un agriculteur, d'un mouton et d'un bateau pic.twitter.com/TU13wermLZ

- Colin Fraser (@colin_fraser) 20 juin 2024

Il était peut-être un peu malhonnête de la part d'un scientifique de Meta de ne pas montrer ses résultats en utilisant Llama 3.

J'ai posé la même question à Meta AI, qui se trompe également du tout au tout.

Yann LeCun a expliqué la raison de ces résultats en déclarant : "Le problème est que les LLM n'ont aucun sens commun, aucune compréhension du monde et aucune capacité à planifier (et à raisonner)".

Est-ce vrai ou y a-t-il autre chose en jeu ?

Ce que ces interactions pourraient révéler n'est pas un manque de capacité de raisonnement, mais plutôt à quel point la production d'un LLM est influencée par ses données d'apprentissage. La réponse de Meta AI, qui parle d'une "énigme classique", laisse entendre que c'est peut-être ce qui se passe.

Les variantes de l'énigme de la traversée d'une rivière font souvent référence au nombre de "voyages" nécessaires. Lorsque vous posez l'énigme sans utiliser ce mot, le LLM la résout.

En effet. Lorsqu'il n'y a pas d'invite pour les "voyages", qui rappelle les solutions précédentes de tant de problèmes similaires, mais l'invite "la manière la plus rapide possible" avec COT, il répond correctement pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21 juin 2024

Ces expériences étaient intéressantes, mais elles ne répondent pas définitivement à la question de savoir si les modèles d'IA sont réellement intelligents ou s'il s'agit simplement de machines prédictives de dernière génération.

Cependant, les résultats soulignent la sensibilité des LLM aux données d'entraînement. Lorsque GPT-4o réussit les examens du LSAT, est-ce qu'il "réfléchit" pour trouver les réponses aux problèmes ou est-ce qu'il s'en souvient ?

Tant que les ingénieurs ne comprendront pas ce qui se passe à l'intérieur des boîtes noires de l'IA qu'ils ont créées, les discussions sur l'X resteront sans réponse.