Lorsque ChatGPT vous donne la bonne réponse à votre demande, raisonne-t-il à travers la demande ou se souvient-il simplement de la réponse à partir de ses données d'entraînement ?

Les chercheurs du Computer Science and Artificial Intelligence Laboratory (CSAIL) du MIT ont conçu une série de tests pour déterminer si les modèles d'IA "pensent" ou s'ils ont simplement une bonne mémoire.

Lorsque vous demandez à un modèle d'intelligence artificielle de résoudre un problème mathématique tel que "Quel est le rapport entre 27 et 62 ? 89. Comment savoir s'il comprend l'arithmétique sous-jacente ou s'il a simplement vu le problème dans ses données d'apprentissage ?

En leur documentLes chercheurs ont testé GPT-4, GPT-3.5 Turbo, Claude 1.3 et PaLM2 pour voir s'ils pouvaient "se généraliser non seulement à des instances inédites de tâches connues, mais aussi à de nouvelles tâches".

Ils ont conçu une série de 11 tâches légèrement différentes des tâches standard dans lesquelles les LLM obtiennent généralement de bons résultats.

Les LLM devraient obtenir les mêmes résultats dans les "tâches contrefactuelles" s'ils utilisent des procédures générales et transférables de résolution des tâches.

Si un LLM "comprend" les mathématiques, il devrait fournir la réponse correcte à un problème mathématique en base 10 et en base 9, rarement utilisée, par exemple.

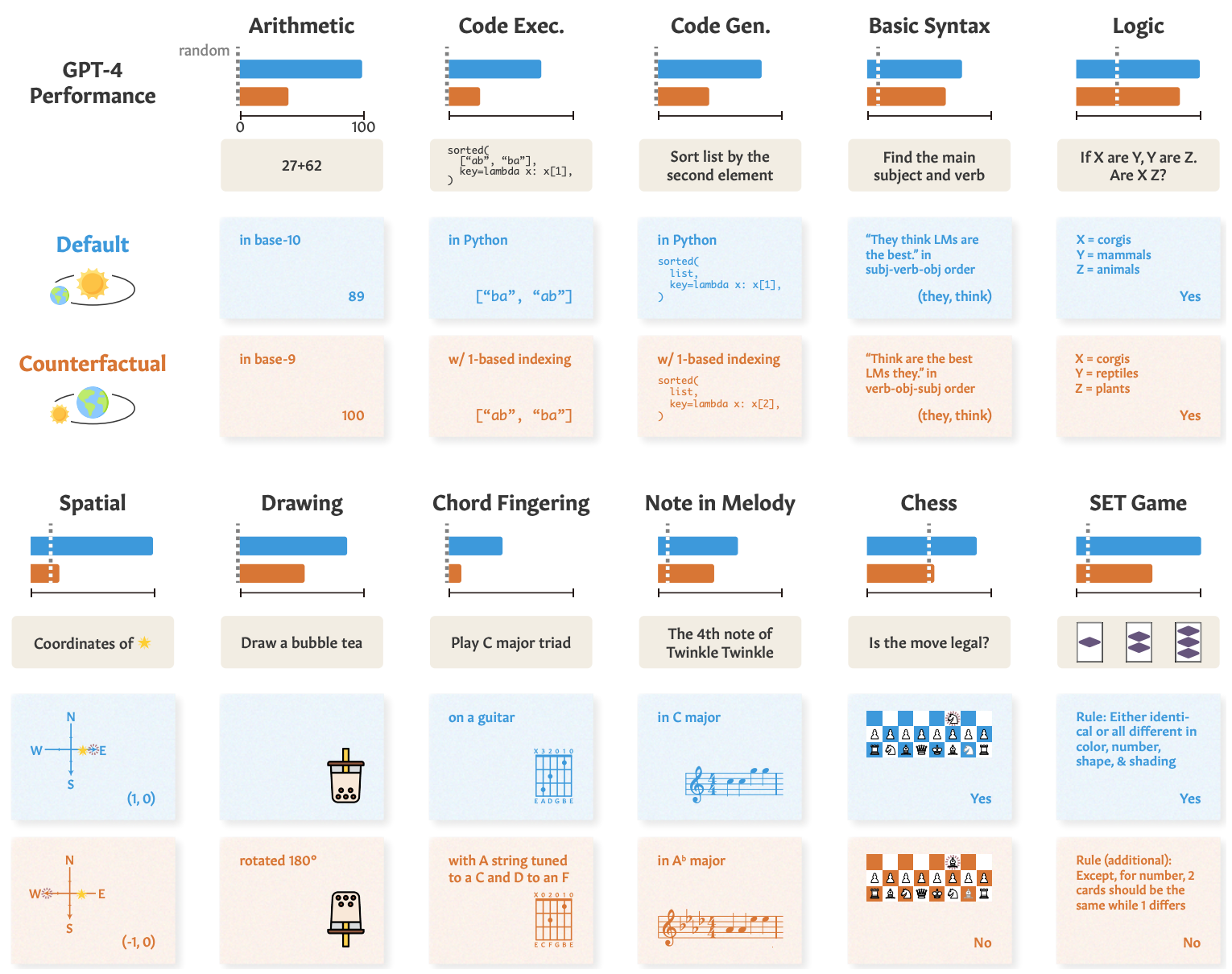

Voici quelques exemples de tâches et les performances de GPT-4.

Les performances du GPT-4 dans les tests standard (ligne bleue) sont bonnes, mais ses capacités en mathématiques, en raisonnement logique, en raisonnement spatial et autres (ligne orange) se dégradent de manière significative lorsque la tâche est légèrement modifiée.

Les autres modèles ont présenté une dégradation similaire, le GPT-4 arrivant en tête.

Malgré cette dégradation, les performances dans les tâches contrefactuelles sont restées supérieures au hasard. Les modèles d'IA tentent de raisonner à travers ces tâches, mais ne sont pas très performants.

Les résultats montrent que les performances impressionnantes des modèles d'IA dans des tâches telles que les examens universitaires reposent sur un excellent rappel des données d'apprentissage, et non sur le raisonnement. Cela montre en outre que les modèles d'IA ne peuvent pas être généralisés à des tâches inédites,

Zhaofeng Wu, doctorant du MIT en génie électrique et en informatique, affilié au CSAIL, et auteur principal de l'article, a déclaré : "Nous avons découvert un aspect fascinant des grands modèles de langage : ils excellent dans les scénarios familiers, un peu comme un chemin bien tracé, mais éprouvent des difficultés lorsque le terrain n'est pas familier. Cette découverte est cruciale car nous nous efforçons d'améliorer l'adaptabilité de ces modèles et d'élargir leurs horizons d'application."

Nous avons vu une démonstration similaire de cette incapacité à généraliser lorsque nous avons exploré à quel point les modèles d'IA sont mauvais à la résolution d'une énigme simplifiée de traversée de rivière.

Les chercheurs ont conclu que lorsque les développeurs analysent leurs modèles, ils devraient "considérer les capacités abstraites comme détachées des performances observées".

L'approche "formation-test" peut faire progresser un modèle dans les critères de référence, mais n'offre pas une véritable mesure de la manière dont le modèle se comportera lorsqu'il sera confronté à une nouvelle tâche à résoudre.

Selon les chercheurs, le problème vient en partie du fait que ces modèles ne sont formés que sur des textes de surface.

Si les LLM sont exposés à davantage de données contextualisées et de représentations sémantiques du monde réel, ils pourraient être en mesure de généraliser lorsqu'on leur présente des variations de tâches.