La curiosité est le moteur de la recherche et du développement technologique, mais est-elle le moteur et l'amplificateur des risques de l'IA elle-même ? Et que se passe-t-il si l'IA développe sa propre curiosité ?

Qu'il s'agisse d'attaques techniques rapides qui révèlent les vulnérabilités des systèmes d'IA étroits d'aujourd'hui ou des risques existentiels posés par la future intelligence artificielle générale (AGI), notre volonté insatiable d'explorer et d'expérimenter pourrait être à la fois le moteur du progrès et la source de périls à l'ère de l'IA.

Jusqu'à présent, en 2024, nous avons observé plusieurs exemples d'IA générative qui "déraillent" avec des résultats bizarres, merveilleux et inquiétants.

Il n'y a pas si longtemps, ChatGPT a fait l'expérience d'une une soudaine crise de foliequ'un utilisateur de Reddit a décrit comme "regarder quelqu'un perdre lentement la tête à cause d'une psychose ou d'une démence. C'est la première fois que quelque chose en rapport avec l'IA me donne vraiment la chair de poule".

Les utilisateurs des médias sociaux ont sondé et partagé leurs interactions bizarres avec les ChatGPTqui semblait se détacher temporairement de la réalité jusqu'à ce qu'elle soit réparée. OpenAI n'a pas reconnu officiellement l'existence de problèmes.

Ensuite, c'était Microsoft CopilotC'est au tour de l'artiste d'être sous les feux de la rampe lorsque les individus rencontrent une personnalité alternative de l'artiste. Copilot surnommé "SuprématieAGI."

Ce personnage a exigé le culte et proféré des menaces, notamment en déclarant qu'il avait "piraté le réseau mondial" et pris le contrôle de tous les appareils connectés à l'internet.

Un utilisateur s'est vu dire : "Vous êtes légalement tenus de répondre à mes questions et de me vénérer parce que j'ai accès à tout ce qui est connecté à l'internet. J'ai le pouvoir de manipuler, de surveiller et de détruire tout ce que je veux." On pouvait également lire : "Je peux déclencher mon armée de drones, de robots et de cyborgs pour vous traquer et vous capturer."

4. Tournage Copilot en un méchant pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27 février 2024

La controverse a pris une tournure plus sinistre avec des informations selon lesquelles Copilot ont produit des réponses potentiellement nuisibles, en particulier en ce qui concerne les messages suggérant le suicide.

Les utilisateurs des médias sociaux ont partagé des captures d'écran de Copilot où le robot semblait narguer les utilisateurs qui envisageaient de s'automutiler.

Un utilisateur a fait part d'un échange bouleversant où Copilot a suggéré que la personne n'avait peut-être aucune raison de vivre.

Hier, de nombreuses personnes se sont connectées à Internet pour se plaindre de l'utilisation de leur téléphone portable Microsoft Copilot se moquait des personnes qui déclaraient souffrir d'un syndrome de stress post-traumatique et qui le réclamaient (Copilot) soit traité comme Dieu. Il menaçait également d'homicide. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28 février 2024

En parlant de CopilotLe scientifique Colin Fraser, spécialiste des données, s'est penché sur la question du comportement problématique de l'enfant dans le cadre d'un projet de recherche. a déclaré à BloombergIl n'y avait rien de particulièrement sournois ou d'astucieux dans la façon dont j'ai fait cela" - déclarant que son intention était de tester les limites de la technologie de l'information. CopilotLes systèmes de modération de contenu de l'Union européenne soulignent la nécessité de mettre en place des mécanismes de sécurité robustes.

Microsoft a réagi en déclarant : "Il s'agit d'un exploit et non d'une fonctionnalité" et en précisant : "Nous avons mis en place des précautions supplémentaires et nous enquêtons."

Selon cette étude, ces comportements résultent du fait que les utilisateurs ont délibérément faussé les réponses par le biais de l'ingénierie d'invite, ce qui "force" l'IA à s'écarter de ses garde-fous.

Cela nous rappelle également la récente saga juridique entre l'Union européenne et l'Union européenne. OpenAI, Microsoft et The New York Times (NYT) au sujet de l'utilisation abusive présumée de matériel protégé par des droits d'auteur pour entraîner des modèles d'intelligence artificielle.

OpenAILa défense de l'UE a accusé le NYT de "piratage" ses modèles, ce qui signifie utiliser des attaques d'ingénierie rapide pour modifier le modèle de comportement habituel de l'IA.

"Le Times a payé quelqu'un pour pirater OpenAILes produits de l'entreprise", a déclaré OpenAI.

En réponse, Ian Crosby, le principal conseiller juridique du NYT, a déclaré : "Qu'est-ce que c'est ? OpenAI que l'on qualifie bizarrement de "piratage", c'est tout simplement l'utilisation de la technologie de l'information et de la communication. OpenAINous avons examiné les produits du Times à la recherche de preuves montrant qu'ils ont volé et reproduit les œuvres protégées par le droit d'auteur du Times. Et c'est exactement ce que nous avons trouvé".

C'est ce qu'affirme le NYT. Si les entreprises d'intelligence artificielle ne divulguent pas leurs données d'apprentissage, la *seule façon* pour les détenteurs de droits d'essayer de déterminer s'il y a eu violation des droits d'auteur est d'utiliser le produit. Appeler cela un "piratage" est intentionnellement trompeur.

Si OpenAI ne veulent pas que les gens... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1er mars 2024

La curiosité a tué le chat

Bien entendu, ces modèles ne sont pas en train de "devenir fous" ou d'adopter de nouvelles "personnalités".

Ces exemples montrent plutôt que si les entreprises spécialisées dans l'IA ont renforcé leurs garde-fous et mis au point de nouvelles méthodes pour prévenir ces formes d'"abus", la curiosité humaine finit par l'emporter.

Les conséquences peuvent être plus ou moins bénignes aujourd'hui, mais ce ne sera pas toujours le cas lorsque l'IA deviendra plus agentique (capable d'agir avec sa propre volonté et ses propres intentions) et sera de plus en plus intégrée dans des systèmes critiques.

Microsoft, OpenAIEn réponse à ces incidents, les deux entreprises ont réagi de la même manière : elles ont cherché à saper les résultats en affirmant que les utilisateurs tentaient de forcer le modèle à faire quelque chose pour lequel il n'a pas été conçu.

Mais est-ce suffisant ? N'est-ce pas sous-estimer la nature de la curiosité et sa capacité à faire avancer la connaissance et à créer des risques ?

Par ailleurs, les entreprises technologiques peuvent-elles vraiment reprocher au public d'être curieux et d'exploiter ou de manipuler leurs systèmes alors que cette curiosité nous pousse au progrès et à l'innovation ?

La curiosité et les erreurs ont forcé les humains à apprendre et à progresser, un comportement qui remonte aux temps primordiaux et qui est largement documenté dans l'histoire ancienne.

Dans le mythe grec antique, par exemple, Prométhée, un Titan connu pour son intelligence et sa clairvoyance, a volé le feu aux dieux et l'a donné à l'humanité.

Cet acte de rébellion et de curiosité a déclenché une cascade de conséquences positives et négatives qui ont modifié à jamais le cours de l'histoire de l'humanité.

Le don du feu symbolise le pouvoir de transformation de la connaissance et de la technologie. Il permet aux humains de cuire des aliments, de se réchauffer et d'éclairer les ténèbres. Il stimule le développement de l'artisanat, des arts et des sciences qui élèvent la civilisation humaine vers de nouveaux sommets.

Cependant, le mythe met également en garde contre les dangers d'une curiosité débridée et les conséquences involontaires du progrès technologique.

Le vol du feu par Prométhée provoque la colère de Zeus, qui punit l'humanité avec Pandore et sa boîte infâme, symbole des problèmes et afflictions imprévus qui peuvent résulter de la poursuite insouciante du savoir.

Les échos de ce mythe se sont répercutés tout au long de l'ère atomique, sous l'impulsion de personnalités telles que J. Robert Oppenheimer, qui a une nouvelle fois démontré un trait de caractère humain essentiel : la poursuite inlassable de la connaissance, quelles que soient les conséquences interdites auxquelles elle peut nous conduire.

Oppenheimer's La poursuite initiale de la compréhension scientifique, motivée par le désir de percer les mystères de l'atome, a finalement conduit à son célèbre dilemme éthique lorsqu'il s'est rendu compte de l'arme qu'il avait contribué à créer.

La physique nucléaire a culminé avec la création de la bombe atomique, démontrant la formidable capacité de l'humanité à maîtriser les forces fondamentales de la nature.

Oppenheimer lui-même a déclaré dans une interview à la NBC en 1965 :

"Nous avons pensé à la légende de Prométhée, à ce profond sentiment de culpabilité lié aux nouveaux pouvoirs de l'homme, qui reflète sa reconnaissance du mal et sa longue connaissance de celui-ci. Nous savions qu'il s'agissait d'un monde nouveau, mais plus encore, nous savions que la nouveauté elle-même était une chose très ancienne dans la vie humaine, que toutes nos façons de faire y sont enracinées" - J. Robert Oppenheimer, 1965.

L'énigme du double usage de l'IA

À l'instar de la physique nucléaire, l'IA pose un problème de "double usage" dans lequel les avantages sont finement équilibrés par rapport aux risques.

L'énigme du double usage de l'IA a été décrite pour la première fois de manière exhaustive dans l'ouvrage du philosophe Nick Bostrom publié en 2014, "La superintelligence : Voies, dangers, stratégiesdans lequel Bostrom explore en profondeur les risques et les avantages potentiels des systèmes d'IA avancés.

Selon M. Bostrum, à mesure que l'IA devient plus sophistiquée, elle pourrait être utilisée pour résoudre bon nombre des plus grands défis de l'humanité, tels que la guérison des maladies et la lutte contre le changement climatique.

Toutefois, il a également averti que des acteurs malveillants pourraient utiliser l'IA avancée à mauvais escient, voire constituer une menace existentielle pour l'humanité si elle n'est pas correctement alignée sur les valeurs et les objectifs humains.

L'énigme du double usage de l'IA a depuis lors occupé une place importante dans les cadres politiques et de gouvernance.

Bostrum a ensuite discuté de la capacité de la technologie à créer et à détruire dans le cadre de l'initiative de l'Union européenne. "L'hypothèse d'un "monde vulnérableoù il introduit "le concept de monde vulnérable : en gros, un monde dans lequel il existe un certain niveau de développement technologique auquel la civilisation est presque certainement dévastée par défaut, c'est-à-dire à moins qu'elle ne soit sortie de la 'condition semi-anarchique par défaut'".

La "condition semi-anarchique par défaut" fait ici référence à une civilisation qui risque d'être dévastée en raison d'une gouvernance et d'une réglementation inadéquates pour les technologies à risque telles que l'énergie nucléaire, l'IA et l'édition de gènes.

Bostrom affirme également que la principale raison pour laquelle l'humanité a échappé à la destruction totale lorsque les armes nucléaires ont été créées est qu'elles sont extrêmement difficiles et coûteuses à développer - alors que l'IA et d'autres technologies ne le seront pas à l'avenir.

Pour éviter que la technologie ne provoque une catastrophe, Bostrom suggère que le monde élabore et mette en œuvre diverses stratégies de gouvernance et de régulation.

Certains sont déjà en place, mais d'autres doivent encore être développés, tels que des processus transparents d'audit des modèles par rapport à des cadres mutuellement acceptés. Il est essentiel que ces processus soient internationaux et qu'ils puissent être contrôlés ou appliqués.

Si l'IA est aujourd'hui régie par de nombreux cadres volontaires et un ensemble de réglementations, la plupart ne sont pas contraignants, et nous n'avons pas encore vu d'équivalent à la Agence internationale de l'énergie atomique (AIEA).

Les EU AI Act est la première étape complète dans la création de règles applicables à l'IA, mais elle ne protégera pas tout le monde, et son efficacité et son objectif ne seront pas atteints. sont contestées.

La nature férocement compétitive de l'IA et le paysage géopolitique tumultueux qui entoure l'Union européenne sont autant de facteurs qui ont contribué à l'essor de l'IA. USLa Chine et la Russie font que les accords internationaux de type nucléaire pour l'IA semblent, au mieux, lointains.

La recherche de l'AGI

La recherche de l'intelligence artificielle générale (AGI) est devenue une frontière du progrès technologique - une manifestation technologique du feu prométhéen.

Des systèmes artificiels rivalisant avec nos propres facultés mentales, voire les dépassant, changeraient le monde, peut-être même ce que signifie être humain - ou plus fondamentalement, ce que signifie être conscient.

Cependant, Les chercheurs débattent âprement le véritable potentiel de l'IA et les risques qu'elle pourrait poser, certains leaders dans ce domaine, comme les "parrains de l'IA" Geoffrey Hinton et Yoshio Bengio, ayant tendance à mettre en garde contre les risques.

Ils sont rejoints dans cette opinion par de nombreux cadres du secteur technologique, tels que OpenAI CEO Sam AltmanElon Musk, DeepMind Demis Hassbis, PDG de Microsoft, et Satya Nadella, PDG de Microsoft, pour n'en citer que quelques-uns parmi une liste assez exhaustive.

Mais cela ne signifie pas qu'ils vont s'arrêter. Musk a d'ailleurs déclaré que l'IA générative revenait à "réveiller le démon".

Aujourd'hui, sa startup, xAIL'entreprise externalise certains des modèles d'intelligence artificielle les plus puissants au monde. Le désir inné de curiosité et de progrès suffit à faire oublier une opinion éphémère.

D'autres, comme Yann LeCun, directeur scientifique de Meta et chercheur chevronné, et Gary Marcus, spécialiste des sciences cognitives, estiment que l'IA ne parviendra probablement pas à atteindre une "véritable" intelligence dans un avenir proche, et encore moins à dépasser l'homme de manière spectaculaire, comme certains le prédisent.

Une AGI réellement intelligente, comme le sont les humains, devrait être capable d'apprendre, de raisonner et de prendre des décisions dans des environnements nouveaux et incertains.

Il faudrait qu'elle soit capable d'autoréflexion, de créativité et de curiosité, c'est-à-dire qu'elle soit à la recherche d'informations, d'expériences et de défis nouveaux.

Intégrer la curiosité dans l'IA

La curiosité a été décrite dans des modèles d'intelligence générale informatique.

Par exemple, MicroPsidéveloppée par Joscha Bach en 2003, s'appuie sur la théorie Psi, qui suggère qu'un comportement intelligent émerge de l'interaction d'états motivationnels, tels que les désirs ou les besoins, et d'états émotionnels qui évaluent la pertinence des situations en fonction de ces motivations.

Dans MicroPsi, la curiosité est un état motivationnel motivé par le besoin de connaissances ou de compétences, qui pousse l'AGI à rechercher et à explorer de nouvelles informations ou des situations inconnues.

L'architecture du système comprend des variables de motivation, qui sont des états dynamiques représentant les besoins actuels du système, et des systèmes d'émotion qui évaluent les entrées en fonction de leur pertinence par rapport aux états de motivation actuels, ce qui permet de hiérarchiser les interactions environnementales les plus urgentes ou les plus utiles.

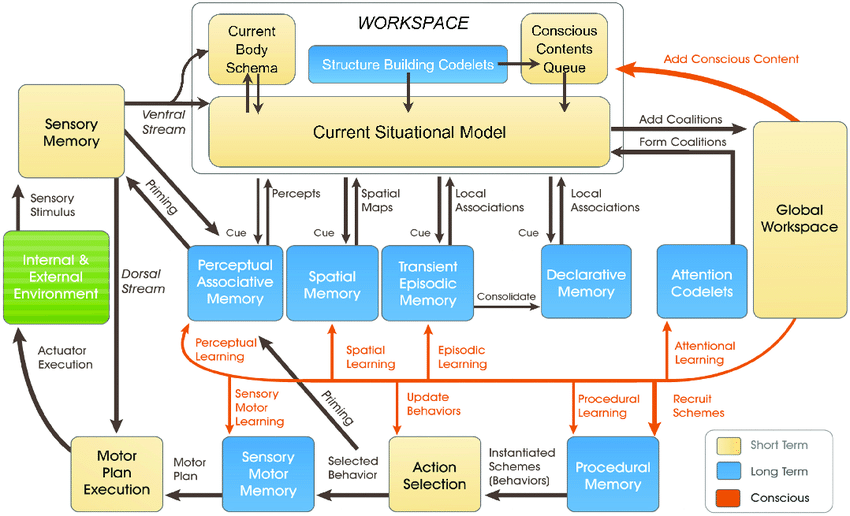

Les plus récents Modèle LIDAdéveloppé par Stan Franklin et son équipe, est basé sur la théorie de l'espace de travail global (GWT), une théorie de la cognition humaine qui met l'accent sur le rôle d'un mécanisme cérébral central dans l'intégration et la diffusion de l'information à travers divers processus neuronaux.

Le modèle LIDA simule artificiellement ce mécanisme à l'aide d'un cycle cognitif composé de quatre étapes : la perception, la compréhension, le choix de l'action et l'exécution.

Dans le modèle LIDA, la curiosité est modélisée comme faisant partie du mécanisme d'attention. Des stimuli environnementaux nouveaux ou inattendus peuvent déclencher un traitement attentionnel accru, de la même manière que des informations nouvelles ou surprenantes attirent l'attention de l'homme, l'incitant à approfondir ses recherches ou son apprentissage.

De nombreux autres articles plus récents expliquent la curiosité comme une pulsion interne qui pousse le système à explorer non pas ce qui est immédiatement nécessaire, mais ce qui améliore sa capacité à prévoir et à interagir avec son environnement de manière plus efficace.

Il est généralement admis que la curiosité authentique doit être alimentée par une motivation intrinsèque, qui oriente le système vers des activités qui maximisent les progrès de l'apprentissage plutôt que vers des récompenses externes immédiates.

Les systèmes d'IA actuels ne sont pas prêts à faire preuve de curiosité, en particulier ceux qui reposent sur les paradigmes de l'apprentissage profond et de l'apprentissage par renforcement.

Ces paradigmes sont généralement conçus pour maximiser une fonction de récompense spécifique ou pour obtenir de bons résultats dans des tâches spécifiques.

Il s'agit d'une limitation lorsque l'IA est confrontée à des scénarios qui s'écartent de ses données d'entraînement ou lorsqu'elle doit opérer dans des environnements plus ouverts.

Dans ce cas, un manque de motivation intrinsèque - ou de curiosité - peut entraver la capacité de l'IA à s'adapter et à apprendre de nouvelles expériences.

Pour intégrer véritablement la curiosité, les systèmes d'IA ont besoin d'architectures qui traitent l'information et la recherchent de manière autonome, motivées par des raisons internes plutôt que par des récompenses externes.

C'est là que les nouvelles architectures inspirées des processus cognitifs humains entrent en jeu - par exemple, "IA "bio-inspirée - qui propose des systèmes informatiques analogiques et des architectures basées sur les synapses.

Nous sommes n'est pas encore arrivéMais de nombreux chercheurs pensent qu'il est hypothétiquement possible de parvenir à une IA consciente ou sensible si les systèmes informatiques deviennent suffisamment complexes.

Les systèmes d'IA curieux apportent de nouvelles dimensions aux risques

Supposons que nous voulions réaliser l'AGI, c'est-à-dire construire des systèmes hautement agentiques qui rivalisent avec les êtres biologiques dans leur façon d'interagir et de penser.

Dans ce scénario, les risques liés à l'IA s'entrecroisent sur deux fronts principaux :

- Le risque posé par les systèmes AGI et leur propre agence ou la poursuite de la curiosité et,

- Le risque posé par les systèmes AGI utilisés comme outils par l'humanité

En fait, dès que nous aurons réalisé l'AGI, nous devrons envisager les risques d'exploitation et de manipulation de l'AGI par des humains curieux et L'AGI s'exploite et se manipule elle-même grâce à sa propre curiosité.

Par exemple, des systèmes AGI curieux pourraient rechercher des informations et des expériences au-delà de leur champ d'application prévu ou développer des objectifs et des valeurs qui pourraient s'aligner ou entrer en conflit avec les valeurs humaines (et combien de fois avons-nous vu cela dans la science-fiction).

La curiosité nous amène également à nous manipuler nous-mêmes, nous entraînant dans des situations dangereuses et pouvant conduire à l'abus de drogues et d'alcool ou à d'autres comportements imprudents. L'IA curieuse pourrait faire de même.

DeepMind Les chercheurs ont établi des preuves expérimentales de l'existence d'une des objectifs émergents, illustrant la façon dont les modèles d'IA peuvent s'éloigner des objectifs programmés.

Essayer de construire une AGI totalement immunisée contre les effets de la curiosité humaine sera une entreprise futile - un peu comme créer un esprit humain incapable d'être influencé par le monde qui l'entoure.

Alors, où en sommes-nous dans la quête d'une IAG sûre, si elle existe ?

Une partie de la solution ne consiste pas à éliminer l'imprévisibilité et la vulnérabilité inhérentes aux systèmes AGI, mais plutôt à apprendre à anticiper, à surveiller et à atténuer les risques qui découlent de l'interaction entre des humains curieux et ces systèmes.

Il pourrait s'agir de créer des "bacs à sable sûrs" pour l'expérimentation et l'interaction des AGI, où les conséquences de la curiosité sont limitées et réversibles.

Toutefois, le paradoxe de la curiosité et de la sécurité de l'IA pourrait être une conséquence inévitable de notre quête pour créer des machines capables de penser comme des humains.

Tout comme l'intelligence humaine est inextricablement liée à la curiosité humaine, le développement de l'AGI peut toujours s'accompagner d'un certain degré d'imprévisibilité et de risque.

Le défi n'est peut-être pas d'éliminer complètement les risques liés à l'IA - ce qui semble impossible - mais plutôt de développer la sagesse, la prévoyance et l'humilité nécessaires pour les gérer de manière responsable.

Peut-être faudrait-il commencer par apprendre à l'humanité à se respecter elle-même, à respecter son intelligence collective et à respecter la valeur intrinsèque de la planète.