Nous entendons beaucoup parler de la sécurité de l'IA, mais cela signifie-t-il qu'elle est largement prise en compte dans la recherche ?

Une nouvelle étude de l'Observatoire des technologies émergentes de l'université de Georgetown suggère que, malgré le bruit, la recherche sur la sécurité de l'IA n'occupe qu'une infime minorité de l'axe de recherche de l'industrie.

Les chercheurs ont analysé plus de 260 millions de publications scientifiques et ont constaté qu'à peine 2% des articles relatifs à l'IA publiés entre 2017 et 2022 abordaient directement des sujets liés à la sécurité, à l'éthique, à la robustesse ou à la gouvernance de l'IA.

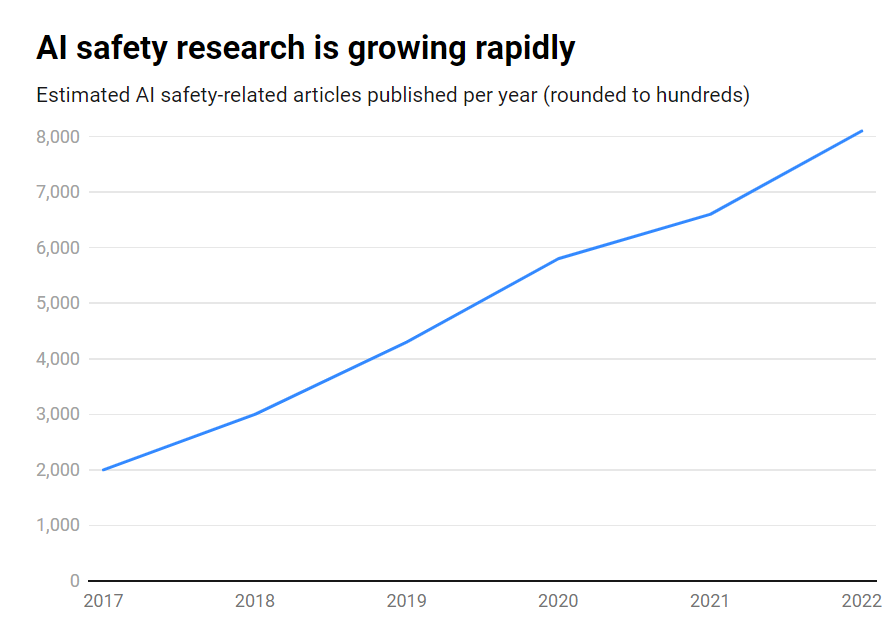

Bien que le nombre de publications sur la sécurité de l'IA ait augmenté de manière impressionnante au cours de cette période, passant d'environ 1 800 à plus de 7 000 par an, il reste un sujet périphérique.

En voici les principales conclusions :

- Seulement 2% de la recherche en IA entre 2017 et 2022 se sont concentrés sur la sécurité de l'IA

- La recherche sur la sécurité de l'IA a augmenté de 315% au cours de cette période, mais elle est inférieure à l'ensemble de la recherche sur l'IA.

- Les États-Unis sont en tête de la recherche sur la sécurité de l'IA, tandis que la Chine est à la traîne

- Les principaux défis sont la robustesse, l'équité, la transparence et le maintien du contrôle humain.

De nombreux chercheurs et éthiciens de premier plan dans le domaine de l'IA ont mis en garde contre les risques existentiels liés au développement de l'intelligence artificielle générale (AGI) en l'absence de garanties et de précautions suffisantes.

Imaginez un système AGI capable de s'améliorer de manière récursive, dépassant rapidement l'intelligence humaine tout en poursuivant des objectifs incompatibles avec nos valeurs. C'est un scénario qui, selon certains, pourrait échapper à notre contrôle.

Il ne s'agit toutefois pas d'un trafic à sens unique. En fait, un grand nombre de chercheurs en intelligence artificielle pensent que l'intelligence artificielle n'est pas une science exacte. La sécurité de l'IA est surestimée.

En outre, certains pensent même que le battage médiatique a été fabriqué pour aider les grandes entreprises technologiques à appliquer les réglementations et à éliminer les organisations de base et les organisations de la société civile. les concurrents des logiciels libres.

Cependant, même les systèmes d'IA les plus étroits d'aujourd'hui, formés sur la base de données antérieures, peuvent présenter des biais, produire des contenus préjudiciables, violer la vie privée et être utilisés à des fins malveillantes.

Ainsi, si la sécurité de l'IA doit être tournée vers l'avenir, elle doit également s'attaquer aux risques actuels, ce qui est sans doute insuffisant étant donné que les falsifications profondes, les préjugés et d'autres problèmes continuent de se profiler.

Pour être efficace, la recherche sur la sécurité de l'IA doit s'attaquer aux défis à court terme et aux risques spéculatifs à plus long terme.

Les États-Unis à la pointe de la recherche sur la sécurité de l'IA

Si l'on examine les données de plus près, on constate que les États-Unis sont le leader incontesté de la recherche sur la sécurité de l'IA, avec 40% de publications, contre 12% pour la Chine.

Cependant, les résultats de la Chine en matière de sécurité sont bien inférieurs à ceux de l'ensemble de la recherche sur l'IA : alors que 5% de la recherche américaine sur l'IA ont porté sur la sécurité, seulement 1% de la recherche chinoise l'ont fait.

On peut supposer que sonder la recherche chinoise est une tâche tout à fait difficile. De plus, la Chine a été proactive en matière de réglementation - Ces données risquent donc de ne pas donner à l'industrie de l'IA du pays une image juste.

Au niveau des institutions, l'université Carnegie Mellon, Google, le MIT et Stanford sont en tête de peloton.

Mais globalement, aucune organisation n'a produit plus de 2% du total des publications relatives à la sécurité, ce qui souligne la nécessité d'un effort plus important et plus concerté.

Déséquilibres de sécurité

Que peut-on donc faire pour corriger ce déséquilibre ?

Cela dépend si l'on pense que la sécurité de l'IA est un risque pressant au même titre que la guerre nucléaire, les pandémies, etc. Il n'y a pas de réponse claire à cette question, ce qui fait de la sécurité de l'IA un sujet hautement spéculatif avec peu de consensus. accord entre les chercheurs.

La recherche en matière de sécurité et l'éthique sont également un domaine quelque peu tangent à l'apprentissage automatique, nécessitant des compétences différentes, des formations universitaires, etc.

Pour combler le fossé en matière de sécurité de l'IA, il faudra également se pencher sur les questions d'ouverture et de secret dans le développement de l'IA.

Les plus grandes entreprises technologiques mènent des recherches internes approfondies sur la sécurité qui n'ont jamais été publiées. Alors que la commercialisation de l'IA s'accélère, les entreprises protègent de plus en plus leurs découvertes en matière d'IA.

OpenAI, par exemple, était un moteur de recherche à ses débuts.

L'entreprise avait l'habitude de réaliser des audits indépendants approfondis de ses produits, des biais d'étiquetage et des risques, tels que des préjugés sexistes dans son projet CLIP.

Anthropic est toujours activement engagé dans la recherche sur la sécurité de l'IA publique, publiant fréquemment des études sur les sujets suivants biais et déverrouillage.

DeepMind a également documenté la possibilité que les modèles d'IA établissent des "objectifs émergents" et contredisent activement leurs instructions ou deviennent hostiles à leurs créateurs.

Dans l'ensemble, cependant, la sécurité a été reléguée au second plan par rapport au progrès, alors que la Silicon Valley vit selon sa devise : "aller vite et casser des choses".

L'étude de Georgetown souligne finalement que les universités, les gouvernements, les entreprises technologiques et les bailleurs de fonds de la recherche doivent investir davantage d'efforts et d'argent dans la sécurité de l'IA.

Certains ont également appelé à une organisme international pour la sécurité de l'IAL'Agence européenne de l'énergie atomique (AIEA) a été créée à la suite d'une série d'incidents nucléaires qui ont rendu obligatoire une coopération internationale approfondie.

L'IA aura-t-elle besoin de sa propre catastrophe pour susciter ce niveau de coopération de la part des États et des entreprises ? Espérons que non.