Les entreprises spécialisées dans l'IA font pression en faveur d'une réglementation. Leur motivation est-elle la paranoïa ou l'altruisme ? Ou bien la réglementation permet-elle d'atteindre des objectifs concurrentiels ?

Au début du mois de mai, Luke Sernau, ingénieur logiciel principal chez Google, a rédigé un mémo informel sur l'IA open-source. Cette note a été largement diffusée sur les systèmes internes de Google avant qu'une société de conseil, Semi-Analysis, ne s'en empare, vérifié et publié.

En voici quelques extraits :

"Nous avons beaucoup regardé par-dessus nos épaules à l'OpenAI. Qui franchira la prochaine étape ? Quelle sera la prochaine étape ?

Mais la vérité est que nous ne sommes pas en mesure de gagner cette course à l'armement, pas plus que l'OpenAI. Pendant que nous nous chamaillions, une troisième faction a tranquillement mangé notre déjeuner. Je parle, bien sûr, de l'open source.

En clair, ils nous dépassent. Les choses que nous considérons comme des "problèmes majeurs ouverts" sont résolues et se trouvent aujourd'hui entre les mains des gens. Si nos modèles conservent un léger avantage en termes de qualité, l'écart se réduit étonnamment vite.

Les modèles open-source sont plus rapides, plus personnalisables, plus privés et plus performants. Ils font des choses avec des paramètres $100 et 13B que nous avons du mal à faire avec des paramètres $10M et 540B. Et ils y parviennent en quelques semaines, pas en quelques mois.

Au début du mois de mars, la communauté open source a mis la main sur son premier modèle de fondation réellement capable, le LLaMA de Meta ayant fait l'objet d'une fuite publique.

Il n'y avait ni instruction, ni accord de conversation, ni RLHF. Néanmoins, la communauté a immédiatement compris l'importance de ce qu'elle avait reçu. Un formidable élan d'innovation s'en est suivi, à quelques jours d'intervalle...

Nous voici, à peine un mois plus tard, avec des variantes concernant le réglage des instructions, la quantification, l'amélioration de la qualité, les évaluations humaines, la multimodalité, la RLHF, etc. Plus important encore, ils ont résolu le problème de la mise à l'échelle au point que n'importe qui peut bricoler.

Bon nombre des nouvelles idées proviennent de personnes ordinaires. La barrière à l'entrée pour la formation et l'expérimentation est passée de la production totale d'un grand organisme de recherche à une personne, une soirée et un ordinateur portable puissant".

Le mémo de M. Sernau a été repris par les principaux organes de presse et a suscité un débat sur la question de savoir si les pressions exercées par les grandes entreprises technologiques en faveur d'une réglementation masquent une volonté de forcer l'IA libre à se retirer du jeu. Ben Schrekcinger de Politico écritLe code open-source est également plus difficile à interdire puisque de nouvelles instances peuvent apparaître si les régulateurs tentent de fermer un site web ou un outil qui l'utilise. Combinés à d'autres caractéristiques de décentralisation, ces projets open-source ont le potentiel de perturber non seulement le modèle commercial de la Silicon Valley, mais aussi les modèles de gouvernance de Washington et de Bruxelles".

La communauté de l'IA à code source ouvert est déjà florissante. Les développeurs résolvent en quelques jours des problèmes qui prennent des mois ou des années à Google et à OpenAI. M. Sernau affirme que les communautés agiles de développeurs de logiciels libres sont mieux équipées pour construire des modèles itératifs que les grandes entreprises technologiques, car elles sont plus diversifiées, plus efficaces et plus pragmatiques.

Si tel est le cas, la domination des grandes entreprises technologiques sur l'IA pourrait être éphémère.

La fuite du Meta LLaMA

Le modèle LLaMA de Meta, un grand modèle de langage (LLM) comme ChatGPT, a été utilisé dans le cadre d'un projet de recherche. fuite sur 4chan une semaine après que l'entreprise a envoyé des demandes d'accès. Le 3 mars, un torrent téléchargeable est apparu sur le forum de messagerie et s'est répandu comme une traînée de poudre.

Comme l'indique M. Sernau, la communauté des logiciels libres a entrepris de modifier LLaMA, ajoutant des fonctionnalités impressionnantes sans les ressources informatiques de l'entreprise.

La construction de modèles d'IA puissants est moins chère que jamais, et les communautés open-source font pression pour démocratiser l'accès à ces modèles. Alors que LLaMA est un modèle largement pré-entraîné, d'autres modèles open-source, comme BLOOM, ont été entraînés par des volontaires.

La formation de BLOOM a nécessité un superordinateur équipé de 384 GPU NVIDIA A100 de 80 Go, qui a heureusement été offert par le gouvernement français. La société d'IA open-source Together a récemment annoncé un financement d'amorçage de $20m, et les fournisseurs de cloud axés sur l'IA tels que CoreWeave offrir du matériel à des prix inférieurs à ceux du marché.

Les projets à code source ouvert disposent de divers moyens pour concentrer les ressources et devancer les grandes entreprises technologiques. Les grandes entreprises technologiques aimeraient sans doute nous faire croire que leurs IA sont le fruit de décennies de travail et de milliards de dollars d'investissement. - la communauté des logiciels libres n'est probablement pas d'accord.

En ce qui concerne la séparation entre les grandes entreprises technologiques et les petits projets d'IA, lors d'un événement en Inde, Rajan Anandan, ancien cadre de Google, a demandé à Sam Altman, PDG d'OpenAI, si les ingénieurs indiens pouvaient construire des modèles d'IA fondamentaux avec un investissement de $10 millions d'euros.

M. Altman a répondu : "Il est totalement inutile de nous concurrencer en matière de formation des modèles de base. Vous ne devriez pas essayer, et c'est votre travail d'aimer essayer de toute façon. Et je crois à ces deux choses. Je pense que c'est vraiment sans espoir".

Toutefois, dans son mémo, M. Sernau indique que les logiciels libres sont déjà en concurrence avec les grandes entreprises technologiques. Il déclare : "Il est encore plus difficile de conserver un avantage concurrentiel dans le domaine de la technologie maintenant que la recherche de pointe dans le cadre des LLM est abordable. Les institutions de recherche du monde entier s'appuient sur les travaux des autres, explorant l'espace des solutions d'une manière qui dépasse de loin nos propres capacités".

Les développeurs de logiciels libres créent des alternatives aux IA des grandes entreprises et les dépassent en termes de performances et de statistiques d'utilisation.

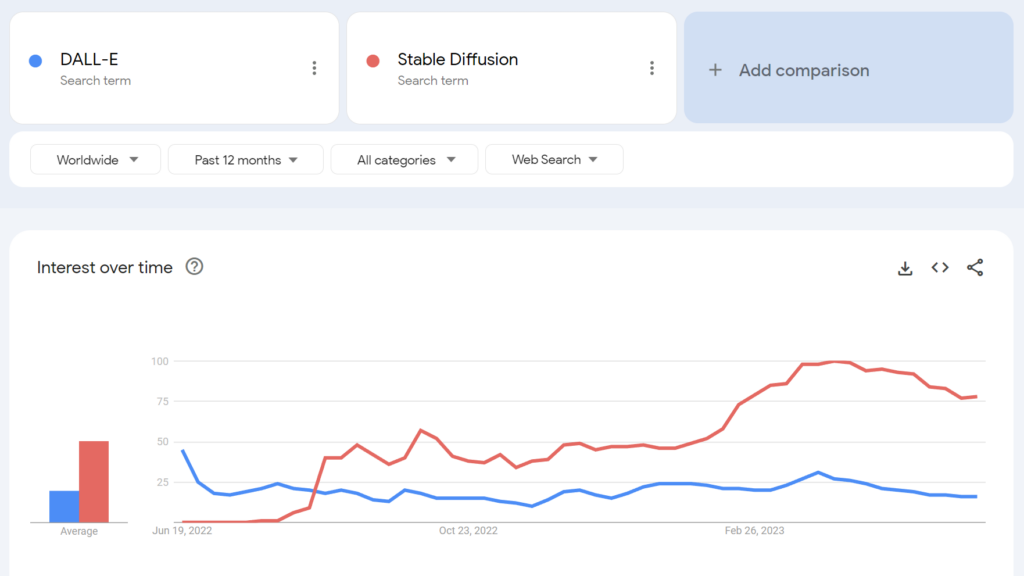

Par exemple, le logiciel libre Stable Diffusion est devenu plus populaire que DALL-E d'OpenAI quelques mois après son lancement.

Dans quelle mesure pouvons-nous faire la part des choses en ce qui concerne les arrière-pensées potentielles ? La pression réglementaire des grandes entreprises technologiques a-t-elle un quelconque mérite altruiste ?

La communauté de l'IA à code source ouvert

Outre LLaMA, il existe au moins trois exemples majeurs de projets d'IA à source ouverte :

- Visage en étreinte & BLOOM - L'entreprise d'IA Hugging Face a collaboré avec plus de 1 000 scientifiques bénévoles pour développer BLOOM, un LLM open-source. BLOOM vise à offrir une contrepartie plus transparente et plus accessible aux modèles d'IA propriétaires.

- Ensemble - Une startup d'IA nommée Together a réussi à lever $20 millions de dollars en financement d'amorçage pour soutenir son objectif de construire des alternatives décentralisées aux systèmes d'IA fermés. Elle a dévoilé plusieurs initiatives d'IA générative open-source, notamment GPT-JT, OpenChatKit et RedPajama.

- Stabilité AI - En avril 2023, Stability AI, l'entreprise à l'origine de Stable Diffusion, a lancé StableLM, une série d'alternatives open-source à ChatGPT.

Il convient de noter que si certains de ces développeurs (par exemple, Stable Diffusion) proposent leurs modèles via des tableaux de bord intuitifs et faciles à utiliser, d'autres, comme BLOOM, nécessitent des ressources importantes pour fonctionner. Pour commencer, vous avez besoin d'environ 360 Go de RAM pour faire fonctionner BLOOM, mais il existe de nombreuses astuces astucieuses pour réduire les besoins en ressources.

À mesure que le prix du matériel compatible avec l'IA diminue et que les modèles open-source deviennent plus simples à déployer, il est tout à fait possible que pratiquement n'importe qui puisse déployer des modèles similaires à ChatGPT. La fuite du mémo de Google cite des exemples de personnes ayant mis au point et déployé LLaMA sur des appareils grand public, y compris un MacBook.

Pour les entreprises disposant de ressources informatiques importantes, les modèles à source ouverte permettent de réaliser des économies et d'assurer la souveraineté des données et le contrôle de la formation et de l'optimisation.

Cependant, tout le monde n'est pas optimiste quant à l'impact d'une IA puissante en libre accès. Par exemple, Jeffrey Ladis, chercheur en cybersécurité, a tweeté : "Préparez-vous à des tas de spams et de tentatives d'hameçonnage personnalisés" et "L'ouverture de ces modèles était une très mauvaise idée".

La prolifération de l'IA nous rend tous moins sûrs. Cela semble être une bonne chose à prévenir, mais aussi un défi assez difficile à relever !

Je ne serais pas surpris qu'un acteur étatique parvienne à mettre la main sur les modèles de frontière de l'OpenAI au cours de l'année ou des deux années à venir. https://t.co/PUEWvfUFqk

- Jeffrey Ladish (@JeffLadish) 10 mai 2023

Un autre observateur a tweeté : "L'open source est une menace, mais pas de la manière dont vous le pensez. C'est une menace parce que l'IA entre les mains de personnes qui peuvent l'utiliser à leurs propres fins devient encore plus difficile à réglementer ou à suivre, et c'est un problème plus important."

Google et OpenAI prétendent qu'ils ont peur de l'IA open source, qu'il n'y a "pas de fossé" entre eux. Mais ce n'est pas vraiment vrai.

L'open source est une menace, mais pas comme vous le pensez. C'est une menace parce que l'IA entre les mains de personnes qui peuvent l'utiliser à leurs propres fins devient encore plus difficile à... pic.twitter.com/g6kMh3TshY

- Theo (@tprstly) 5 mai 2023

Yann LeCun, souvent considéré comme un "parrain de l'IA" aux côtés de Geoffrey Hinton et Yoshio Bengman, affirme le contraireUne fois que les LLM seront devenus le principal canal d'accès à l'information, les gens (et les gouvernements) *exigeront* qu'ils soient ouverts et transparents. L'infrastructure de base doit être ouverte.

M. LeCun s'est également inscrit en faux contre les idées reçues sur les risques liés à l'IA : "Je pense que l'ampleur du problème de l'alignement de l'IA a été ridiculement exagérée et que notre capacité à le résoudre a été largement sous-estimée". Elon Musk a répliqué sur Twitter : "Vous pensez vraiment que l'IA est une épée à un seul tranchant ?".

Vous pensez vraiment que l'IA est une épée à un seul tranchant ?

- Elon Musk (@elonmusk) 1er avril 2023

D'autres commentateurs ont établi un parallèle entre la réglementation de l'IA et la cryptographie, où le gouvernement américain a tenté d'interdire les méthodes de cryptographie publique par les classer comme "munitions" - surnommée la "guerre des cryptomonnaies".

Aujourd'hui, pratiquement tout le monde a le droit d'utiliser le cryptage, mais cette bataille a été durement gagnée, comme cela pourrait être le cas avec l'IA à code source ouvert.

L'aliénation de l'IA open-source par l'OpenAI

L'open source est plus qu'un simple logiciel, un code ou une technologie. C'est le principe, l'état d'esprit ou la conviction qu'un environnement de travail coopératif, ouvert et transparent l'emporte sur la concurrence dans un marché fermé.

OpenAI, qui était autrefois une entreprise à but non lucratif axée sur la coopération publique et le développement de logiciels libres, s'est progressivement éloignée de son nom.

La startup est devenue une entreprise à but lucratif en 2019, mettant ainsi fin à sa relation avec la communauté open-source. L'investissement de Microsoft a désengagé OpenAI de toute activité de R&D "ouverte".

À la mi-mai, l'entreprise a annoncé un modèle open-source en préparationmais ils n'ont pas été très clairs sur les détails.

Aujourd'hui, l'OpenAI fait pression en faveur d'une réglementation qui frapperait le plus durement les entreprises émergentes dans le domaine de l'IA, sans parler de la criminalisation potentielle de la communauté des logiciels libres.

Cela a conduit certains à critiquer les pressions exercées par l'OpenAI en faveur d'une réglementation, estimant qu'il ne s'agit que d'affaires - des affaires visant à protéger leurs modèles rentables contre les communautés à code source ouvert qui cherchent à démocratiser l'IA.

L'IA à code source ouvert représente-t-elle un risque pour les grandes entreprises technologiques ?

La combinaison de la fuite du mémo de Google, de la pression exercée par les grandes entreprises technologiques en faveur d'une réglementation et du dénigrement par M. Altman des projets d'IA de base a de quoi faire froncer les sourcils. En effet, la légitimité des risques liés à l'IA - qui justifient une réglementation - a été remise en question.

Par exemple, lorsque le Center for AI Safety (CAIS) a publié sa déclaration sismique sur les risques liés à l'IA, cosignée par de nombreux PDG de l'IA, certains observateurs externes n'ont pas été convaincus.

Voici une sélection de réactions d'experts à la déclaration publié par le Science Media CentreMhairi Aitken, chargée de recherche en éthique à l'Institut Alan Turing, a déclaré : "Nous sommes très heureux d'apprendre que l'Institut Alan Turing est un centre de recherche en éthique :

"Récemment, ces allégations sont venues de plus en plus souvent de grands acteurs de la technologie, principalement de la Silicon Valley. Si certains suggèrent que c'est parce qu'ils sont conscients des avancées technologiques, je pense qu'il s'agit en fait d'une technique de distraction. Il s'agit de détourner l'attention des décisions des grandes entreprises technologiques (personnes et organisations) qui développent l'IA et stimulent l'innovation dans ce domaine, et de focaliser l'attention sur des scénarios futurs hypothétiques et sur les capacités futures imaginées de l'IA".

Certains affirment que les grandes entreprises technologiques ont la puissance nécessaire pour consacrer des ressources à l'éthique, à la gouvernance et à la surveillance, ce qui leur permet d'échapper aux pires réglementations et de continuer à vendre leurs produits.

Cependant, il est simultanément problématique de dénoncer les risques liés à l'IA comme étant fantaisistes et de prétendre qu'il n'y a pas de valeur dans la réglementation.

Il y a des sceptiques dans les deux camps

Considérer les risques liés à l'IA comme purement spéculatifs pourrait s'avérer une erreur critique pour l'humanité.

En effet, des commentateurs sans conflit d'intérêts mettent en garde contre l'IA depuis des décennies, notamment feu le professeur Stephen Hawking, qui a déclaré que l'IA "pourrait sonner le glas de la race humaine" et constituer "le pire événement de l'histoire de notre civilisation".

Si certains peuvent affirmer que les grandes entreprises technologiques brandissent la vision d'une apocalypse de l'IA pour renforcer les structures du marché et élever les barrières à l'entrée, cela n'éclipse pas la légitimité des risques liés à l'IA.

Par exemple, les équipes de recherche en IA ont déjà prouvé la capacité de l'intelligence artificielle à établir des objectifs émergents avec des conséquences potentiellement désastreuses.

D'autres expériences montrent que les IA peuvent activement collecter des ressources, accumuler de la puissance et prendre des mesures proactives pour éviter d'être "désactivées". Des études crédibles suggèrent qu'au moins certains risques liés à l'IA ne sont pas trop exagérés.

Des points de vue compatibles ?

La question est de savoir si nous pouvons nous fier à une IA exceptionnellement puissante. Par "nous-mêmes", nous entendons les êtres humains partout, à tous les niveaux, depuis les grands laboratoires de recherche technologique jusqu'aux communautés qui construisent l'IA à code source ouvert.

Les grandes entreprises technologiques peuvent souhaiter consolider les structures du marché tout en suscitant de réelles inquiétudes quant à l'avenir de l'IA. Les deux ne s'excluent pas nécessairement l'un l'autre.

Entre-temps, l'essor de l'IA libre est inévitable, et la réglementation risque de susciter le mécontentement d'une communauté qui possède l'une des technologies les plus dangereuses de l'humanité.

Il est déjà trop tard pour assujettir l'IA à source ouverte par le biais d'une réglementation, et toute tentative en ce sens pourrait conduire à une ère destructrice d'interdiction de l'IA.

Dans le même temps, les discussions sur les dangers de l'IA devraient s'appuyer sur des preuves - le seul signal objectif dont nous disposons sur le potentiel de nuisance de la technologie.