Des chercheurs ont publié une étude comparant la précision et la qualité des résumés produits par les LLM. Claude 3 Opus s'est montré particulièrement performant, mais l'homme garde l'avantage.

Les modèles d'IA sont extrêmement utiles pour résumer de longs documents lorsque vous n'avez pas le temps ou l'envie de les lire.

Le luxe d'avoir des fenêtres contextuelles de plus en plus grandes signifie que nous pouvons demander aux modèles de présenter des documents plus longs, ce qui remet en question leur capacité à toujours présenter les faits de manière claire dans le résumé.

Les chercheurs de l'université du Massachusetts Amherst, d'Adobe, de l'Allen Institute for AI et de l'université de Princeton, a publié une étude qui visait à déterminer la capacité des modèles d'IA à résumer le contenu d'un livre (>100k tokens).

FABLES

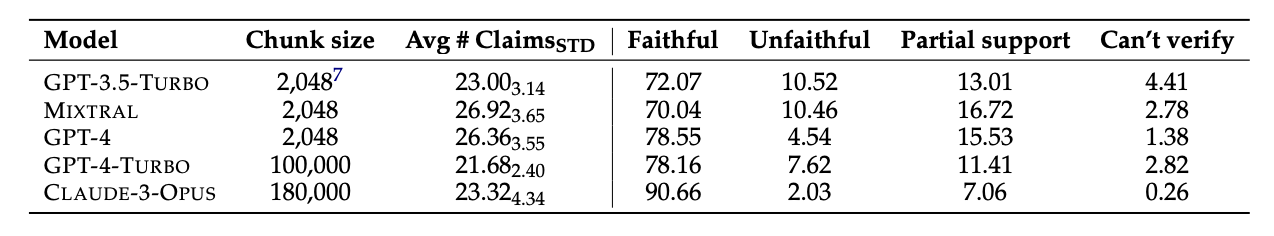

Ils ont sélectionné 26 livres publiés en 2023 et 2024 et ont demandé à plusieurs LLM de résumer les textes. Les dates de publication récentes ont été choisies pour éviter une contamination potentielle des données dans les données d'apprentissage originales des modèles.

Une fois que les modèles ont produit les résumés, ils ont utilisé GPT-4 pour en extraire les affirmations décontextualisées. Les chercheurs ont ensuite engagé des annotateurs humains qui avaient lu les livres et leur ont demandé de vérifier les faits.

Les données obtenues ont été compilées dans un ensemble de données appelé "Faithfulness Annotations for Book-Length Summarization" (FABLES). FABLES contient 3 158 annotations de fidélité au niveau des revendications dans 26 textes narratifs.

Les résultats du test ont montré que Claude 3 Opus était "le résumé le plus fidèle d'un livre, avec une marge significative", avec plus de 90% de ses affirmations vérifiées comme étant fidèles ou exactes.

Le GPT-4 arrive loin derrière avec seulement 78% de ses affirmations vérifiées comme fidèles par les annotateurs humains.

La partie la plus difficile

Les modèles testés semblaient tous éprouver les mêmes difficultés. La majorité des faits sur lesquels les modèles se sont trompés concernaient des événements ou des états des personnages et des relations.

L'article note que "la plupart de ces affirmations ne peuvent être invalidées que par un raisonnement à plusieurs bonds sur les preuves, ce qui met en évidence la complexité de la tâche et sa différence par rapport aux contextes existants de vérification des faits".

En outre, les MFR ont souvent omis des informations essentielles dans leurs résumés. Ils accordent également trop d'importance au contenu vers la fin des livres, négligeant le contenu important situé au début.

L'IA remplacera-t-elle les annotateurs humains ?

Les annotateurs humains ou les vérificateurs de faits sont coûteux. Les chercheurs ont dépensé $5 200 euros pour que les annotateurs humains vérifient les affirmations contenues dans les résumés de l'IA.

Un modèle d'IA aurait-il pu faire le travail pour moins cher ? Simple recherche de faits est un domaine dans lequel Claude 3 excelle, mais ses performances en matière de vérification d'allégations nécessitant une compréhension plus approfondie du contenu sont moins régulières.

Lorsqu'on leur a présenté les allégations extraites et qu'on leur a demandé de les vérifier, tous les modèles d'IA ont été moins performants que les annotateurs humains. Ils ont particulièrement mal réussi à identifier les allégations infidèles.

Bien que Claude 3 Opus soit de loin le meilleur vérificateur de sinistres, les chercheurs ont conclu qu'il "est en fin de compte trop peu performant pour être un évaluateur automatique fiable".

Lorsqu'il s'agit de comprendre les nuances, les relations humaines complexes, les intrigues et les motivations des personnages d'un long récit, il semble que les humains aient encore l'avantage pour l'instant.