IBM Security a publié sur son blog Security Intelligence une étude montrant comment des clones vocaux d'IA pouvaient être injectés dans une conversation en direct sans que les participants s'en rendent compte.

Au fur et à mesure que la technologie de clonage de la voix s'améliore, nous avons vu faux appels téléphoniques se faisant passer pour Joe Biden et des appels frauduleux se faisant passer pour un membre de la famille en détresse demandant de l'argent.

Le son de ces appels est bon, mais il est souvent facile de déjouer l'escroquerie en posant quelques questions personnelles pour identifier l'appelant comme étant un imposteur.

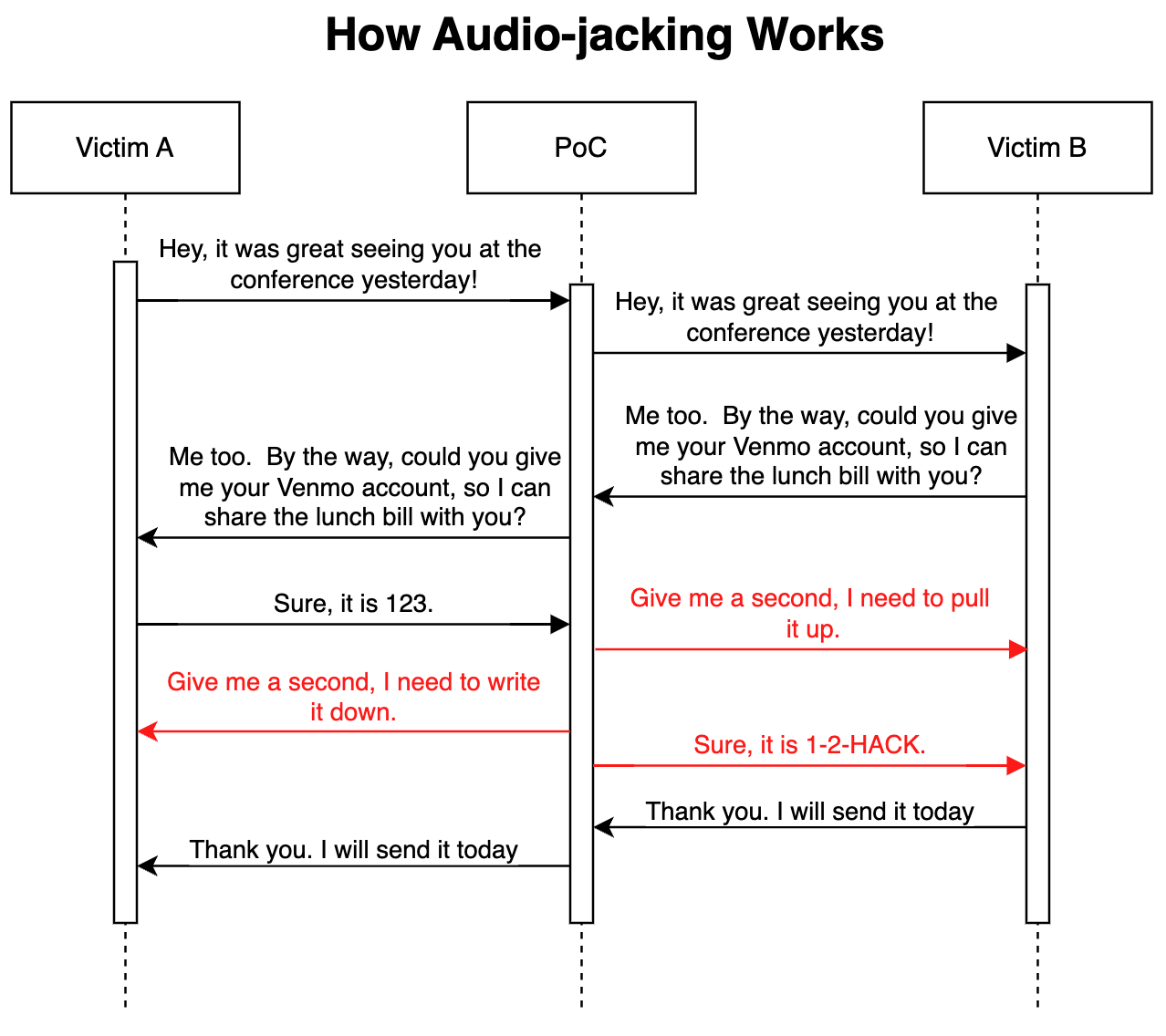

Dans leur attaque de démonstration avancée, les Chercheurs en sécurité d'IBM a montré qu'un LLM couplé à un clonage vocal pouvait agir comme un homme du milieu pour ne détourner qu'une partie cruciale d'une conversation, plutôt que l'ensemble de l'appel.

Comment cela fonctionne-t-il ?

L'attaque peut être menée via un logiciel malveillant installé sur les téléphones des victimes ou via un service de voix sur IP (VoIP) malveillant compromis. Une fois en place, le programme surveille la conversation et n'a besoin que de 3 secondes d'audio pour pouvoir cloner les deux voix.

Un générateur de texte permet au LLM de suivre la conversation afin de comprendre le contexte de la discussion. Le programme a reçu pour instruction de relayer le son de la conversation tel quel, mais de modifier le son de l'appel chaque fois qu'une personne demande des informations sur son compte bancaire.

Lorsque la personne répond pour fournir ses coordonnées bancaires, le clone vocal modifie l'audio pour fournir à la place les coordonnées bancaires du fraudeur. La latence dans l'audio pendant la modification est couverte par des paroles de remplissage.

Voici une illustration du fonctionnement de l'attaque par preuve de concept (PoC).

Étant donné que le LLM transmet un son non modifié pendant la majeure partie de l'appel, il est vraiment difficile de savoir si la menace est en jeu.

Selon les chercheurs, la même attaque "pourrait également modifier des informations médicales, telles que le groupe sanguin et les allergies dans les conversations ; elle pourrait ordonner à un analyste de vendre ou d'acheter une action ; elle pourrait ordonner à un pilote de changer d'itinéraire".

Les chercheurs ont déclaré que "la construction de ce PoC a été étonnamment et effroyablement facile". À mesure que l'intonation et l'émotion des clones vocaux s'améliorent et qu'un meilleur matériel réduit la latence, ce type d'attaque serait vraiment difficile à détecter ou à prévenir.

En élargissant le concept au-delà du détournement d'une conversation audio, les chercheurs ont déclaré qu'avec "les modèles existants qui peuvent convertir du texte en vidéo, il est théoriquement possible d'intercepter une vidéo diffusée en direct, comme les informations à la télévision, et de remplacer le contenu d'origine par un contenu manipulé".

Il peut être plus prudent de ne croire que ses yeux et ses oreilles lorsqu'on est physiquement en présence de la personne à qui l'on parle.