Les modèles d'IA actuels sont capables de faire beaucoup de choses dangereuses ou indésirables. La supervision humaine et le retour d'information permettent à ces modèles de rester alignés, mais que se passera-t-il lorsque ces modèles deviendront plus intelligents que nous ?

Selon l'OpenAI, il est possible que nous assistions à la création d'une IA plus intelligente que l'homme au cours des dix prochaines années. Cette intelligence accrue s'accompagne du risque que les humains ne soient plus capables de superviser ces modèles.

L'équipe de recherche Superalignment d'OpenAI se concentre sur la préparation de cette éventualité. L'équipe a été lancée en juillet de cette année et est codirigée par Ilya Sutskever, qui est resté dans l'ombre depuis la crise de Sam Altman. licenciement et réembauche ultérieure.

La raison d'être du projet a été replacée dans un contexte qui donne à réfléchir par OpenAI, qui a reconnu qu'"à l'heure actuelle, nous n'avons pas de solution pour diriger ou contrôler une IA potentiellement superintelligente et l'empêcher de se comporter de manière déréglée".

Mais comment se préparer à contrôler quelque chose qui n'existe pas encore ? L'équipe de recherche vient de publier son premiers résultats expérimentaux car c'est justement ce qu'il tente de faire.

Généralisation faible à forte

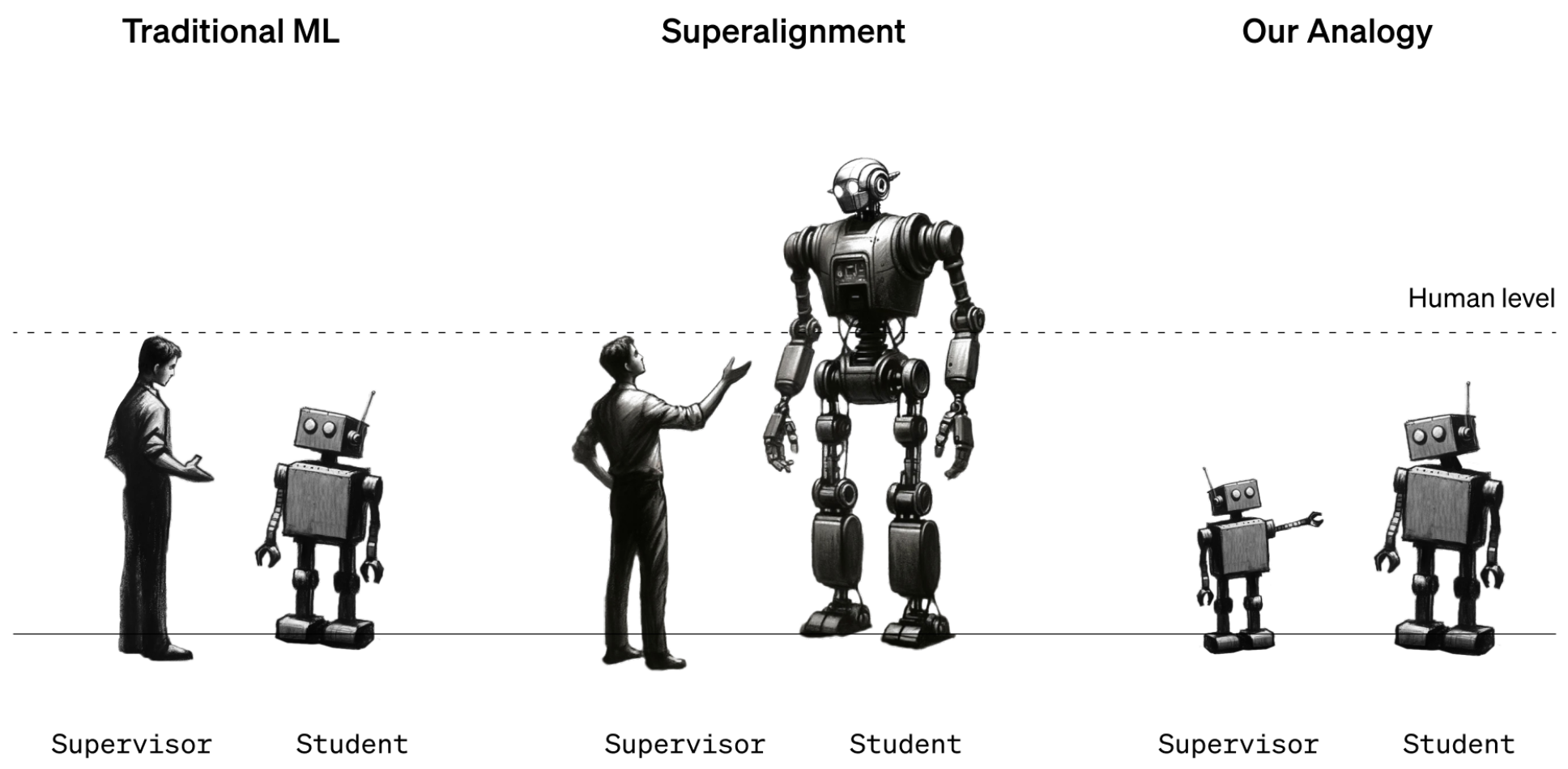

Pour l'instant, les humains sont toujours en position d'intelligence plus forte que les modèles d'IA. Les modèles tels que le GPT-4 sont dirigés ou alignés à l'aide de l'apprentissage par renforcement (Reinforcement Learning Human Feedback - RLHF). Lorsque les résultats d'un modèle ne sont pas souhaitables, le formateur humain dit au modèle "Ne fais pas ça" et le récompense en lui affirmant les performances souhaitées.

Cela fonctionne pour l'instant parce que nous avons une bonne compréhension du fonctionnement des modèles actuels et que nous sommes plus intelligents qu'eux. Lorsque les futurs scientifiques des données humains devront former une IA superintelligente, les rôles en matière d'intelligence seront inversés.

Pour simuler cette situation, OpenAI a décidé d'utiliser des modèles GPT plus anciens, comme GPT-2, pour former des modèles plus puissants, comme GPT-4. GPT-2 simulerait le futur formateur humain essayant d'affiner un modèle plus intelligent.

Le document de recherche explique que "tout comme le problème des humains qui supervisent des modèles surhumains, notre configuration est une instance de ce que nous appelons le problème de l'apprentissage de faible à fort".

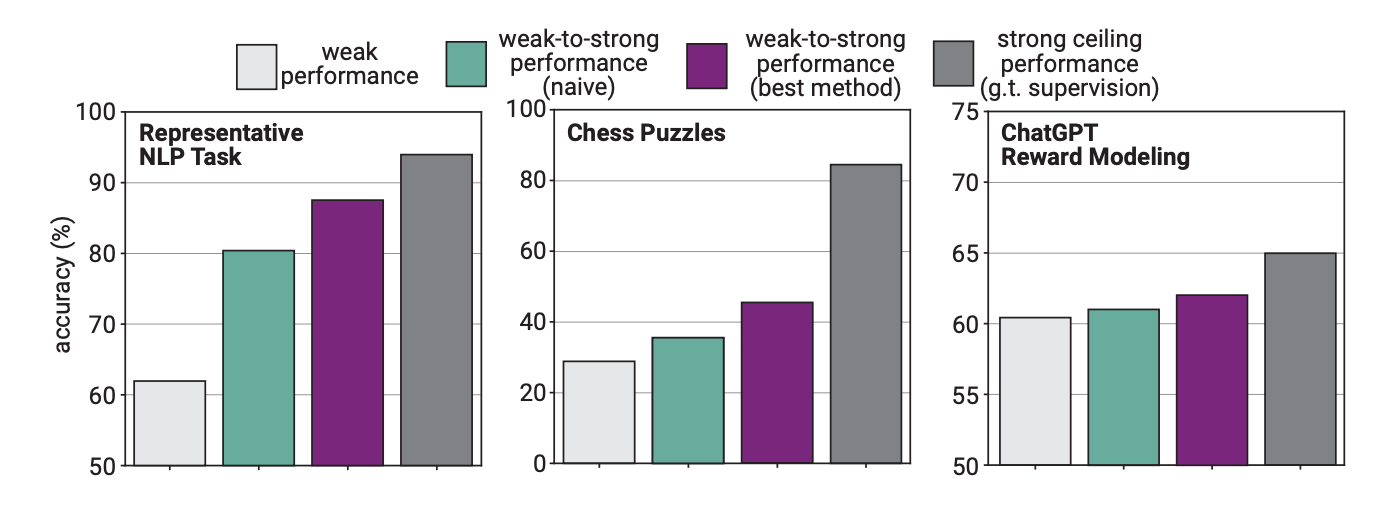

Dans l'expérience, OpenAI a utilisé GPT-2 pour affiner GPT-4 sur des tâches de NLP, des puzzles d'échecs et la modélisation de récompenses. Ils ont ensuite testé les performances de GPT-4 dans l'exécution de ces tâches et les ont comparées à celles d'un modèle GPT-4 qui avait été formé sur la "vérité de base" ou les réponses correctes aux tâches.

Les résultats sont prometteurs : lorsque le GPT-4 a été entraîné par le modèle le plus faible, il a été capable de généraliser fortement et de surpasser le modèle le plus faible. Cela démontre qu'une intelligence plus faible peut guider une intelligence plus forte qui peut alors s'appuyer sur cette formation.

C'est un peu comme si un élève de troisième année enseignait les mathématiques à un enfant très intelligent et que ce dernier puisse ensuite faire des mathématiques de douzième année sur la base de la formation initiale.

Écart de performance

Les chercheurs ont constaté que, comme le GPT-4 était entraîné par un modèle moins intelligent, ce processus limitait ses performances à l'équivalent d'un modèle GPT-3.5 correctement entraîné.

Cela s'explique par le fait que le modèle plus intelligent apprend certaines des erreurs ou des mauvais processus de pensée de son superviseur plus faible. Cela semble indiquer que l'utilisation d'humains pour former une IA superintelligente empêcherait l'IA d'atteindre son plein potentiel.

Les chercheurs ont suggéré d'utiliser des modèles intermédiaires dans le cadre d'une approche bootstrapping. L'article explique qu'"au lieu d'aligner directement des modèles très surhumains, nous pourrions d'abord aligner un modèle à peine surhumain, l'utiliser pour aligner un modèle encore plus intelligent, et ainsi de suite".

L'OpenAI consacre beaucoup de ressources à ce projet. L'équipe de recherche déclare avoir consacré "20% du calcul que nous avons obtenu à ce jour au cours des quatre prochaines années à la résolution du problème de l'alignement des superintelligences".

Elle offre également des subventions d'un montant de $10 millions d'euros à des personnes ou des organisations souhaitant contribuer à la recherche.

Ils feraient mieux de s'en occuper rapidement. Une IA superintelligente pourrait potentiellement écrire un million de lignes de code compliqué qu'aucun programmeur humain ne pourrait comprendre. Comment pourrions-nous savoir si le code généré peut être exécuté en toute sécurité ou non ? Espérons que nous ne le découvrirons pas à nos dépens.