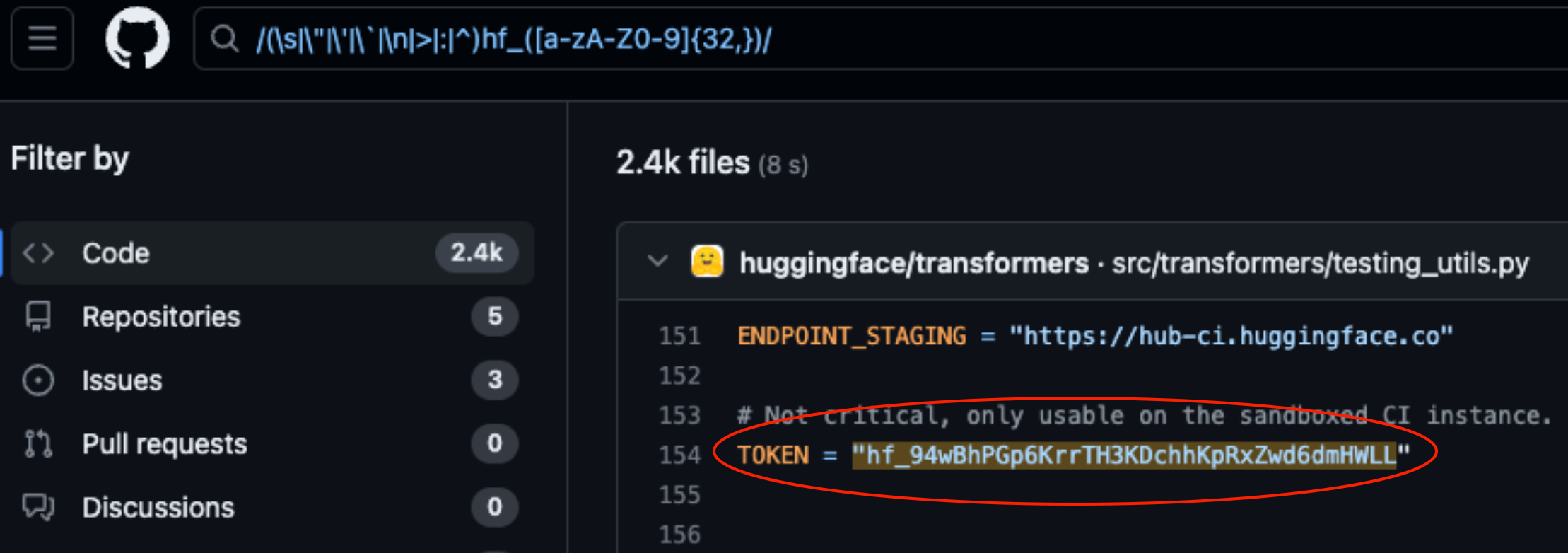

Lasso Security a révélé des failles de sécurité sur HuggingFace et GitHub après avoir découvert 1681 jetons d'API exposés codés en dur dans le code stocké sur les plateformes.

HuggingFace et GitHub sont deux des référentiels les plus populaires où les développeurs peuvent donner accès à leurs modèles d'IA et à leur code. Il s'agit de dossiers dans le nuage qui sont gérés par les organisations qui en sont propriétaires.

HuggingFace et GitHub permettent aux utilisateurs d'interagir facilement avec des centaines de milliers de modèles d'IA et d'ensembles de données via des API. Ils permettent également aux organisations propriétaires des modèles et des ensembles de données d'utiliser l'accès API pour lire, créer, modifier et supprimer des référentiels ou des fichiers.

Les autorisations associées à votre jeton API déterminent le niveau d'accès dont vous disposez. Lasso trouvé qu'en creusant un peu, ils ont pu trouver de nombreux jetons dans du code stocké dans des dépôts sur les plateformes.

Sur les 1681 jetons valides trouvés, 655 jetons d'utilisateurs avaient des autorisations d'écriture, dont 77 avaient des autorisations de compte complètes.

Pourquoi est-ce si important ?

Considérez un jeton API comme la clé de votre porte d'entrée. Il peut être pratique de laisser la clé sous le paillasson, mais si quelqu'un la trouve, il a accès à votre maison.

Lorsque les développeurs écrivent un morceau de code qui doit interagir avec leur modèle d'IA ou leur ensemble de données, ils deviennent parfois un peu paresseux. Ils peuvent coder en dur les jetons dans leur code au lieu d'utiliser des moyens plus sûrs pour les gérer.

Certains des jetons trouvés par Lasso leur donnaient toutes les permissions de lecture et d'écriture sur le site de Meta. Lama 2BigScience Workshop et EleutherAI. Ces organisations disposent toutes de modèles d'IA qui ont été téléchargés des millions de fois.

Si Lasso était le méchant, il aurait pu modifier les modèles ou les ensembles de données dans les référentiels exposés. Imaginez que quelqu'un ait ajouté un code sournois dans le dépôt de Meta et que des millions de personnes l'aient ensuite téléchargé.

Lorsque Meta, Google, Microsoft et d'autres ont entendu parler des jetons d'API exposés, ils les ont rapidement révoqués.

Le vol de modèles, l'empoisonnement des données d'entraînement et la combinaison d'ensembles de données de tiers et de modèles pré-entraînés sont autant de risques importants pour les entreprises d'IA. Les développeurs qui laissent les jetons d'API exposés dans le code ne font que faciliter l'exploitation de ces jetons par des acteurs malveillants.

On peut se demander si les ingénieurs de Lasso ont été les premiers à découvrir ces vulnérabilités.

Si cybercriminels En effet, s'ils avaient trouvé ces jetons, ils auraient certainement gardé le silence pendant qu'ils ouvraient la porte d'entrée.