Elon Musk a annoncé le lancement de la version bêta du chatbot de xAI appelé Grok et les premières statistiques nous donnent une idée de la façon dont il se positionne par rapport à d'autres modèles.

Les Chatbot Grok est basé sur le modèle frontière de xAI appelé Grok-1, que la société a développé au cours des quatre derniers mois. xAI n'a pas indiqué le nombre de paramètres avec lesquels il a été entraîné, mais a donné quelques chiffres pour son prédécesseur.

Grok-0, le prototype du modèle actuel, a été entraîné sur 33 milliards de paramètres. On peut donc supposer que Grok-1 a été entraîné sur au moins autant de paramètres.

Cela ne semble pas beaucoup, mais xAI affirme que les performances de Grok-0 "approchent les capacités de LLaMA 2 (70B) sur les repères LM standard", bien qu'il ait utilisé la moitié des ressources d'entraînement.

En l'absence d'un paramètre chiffré, nous devons croire l'entreprise sur parole lorsqu'elle décrit Grok-1 comme étant "à la pointe de la technologie" et qu'elle affirme qu'il est "nettement plus puissant" que Grok-0.

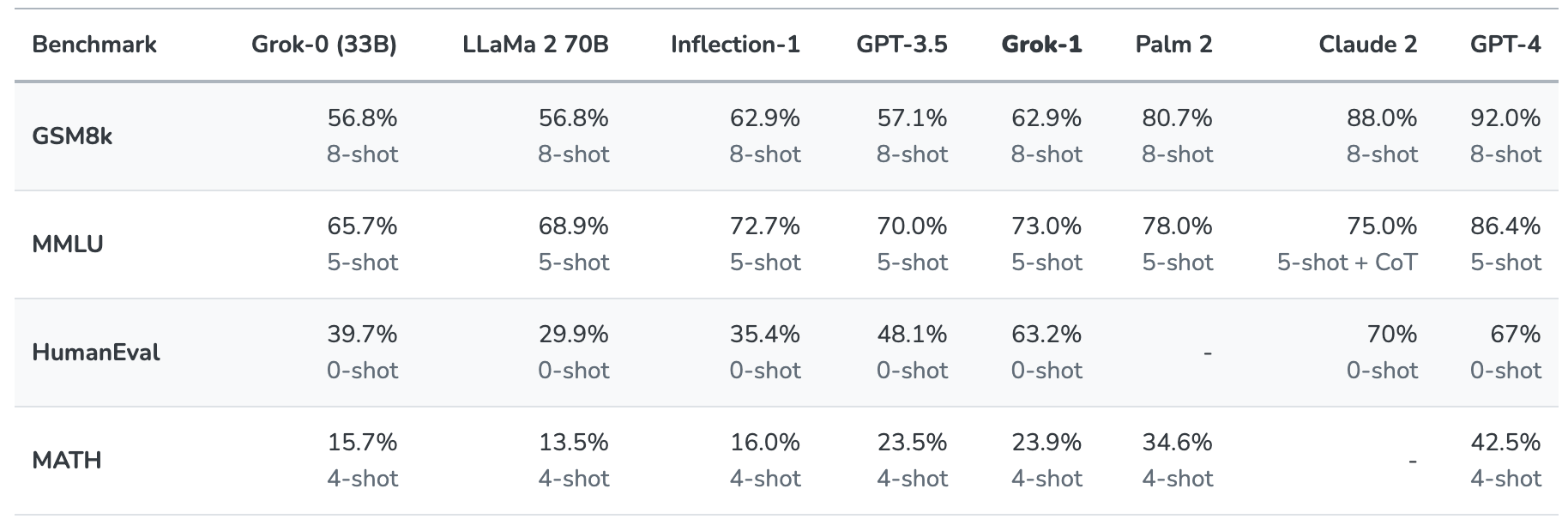

Grok-1 a été mis à l'épreuve en l'évaluant sur ces repères standard d'apprentissage automatique :

- GSM8k : Problèmes de mathématiques au collège

- MMLU : Questions multidisciplinaires à choix multiples

- HumanEval : tâche d'achèvement de code Python

- MATH : Problèmes de mathématiques du collège et du lycée écrits en LaTeX

Voici un résumé des résultats.

Les résultats sont intéressants dans la mesure où ils nous donnent au moins une idée de la façon dont Grok se compare à d'autres modèles de frontières.

Selon xAI, ces chiffres montrent que Grok-1 bat "tous les autres modèles de sa catégorie de calcul" et qu'il n'a été battu que par des modèles formés à partir d'une "quantité de données d'entraînement et de ressources de calcul nettement plus importante".

GPT-3.5 a 175 milliards de paramètres, on peut donc supposer que Grok-1 a moins que cela, mais probablement plus que les 33 milliards de son prototype.

Le chatbot Grok est destiné à traiter des tâches telles que la réponse à des questions, la recherche d'informations, la rédaction créative et l'aide au codage. Il est plus susceptible d'être utilisé pour des interactions plus courtes que pour des cas d'utilisation super rapide en raison de sa fenêtre contextuelle plus petite.

Avec une longueur de contexte de 8 192, Grok-1 ne dispose que de la moitié du contexte de GPT-3.5. Cela indique que xAI a probablement voulu que Grok-1 échange un contexte plus long contre une meilleure efficacité.

L'entreprise indique que certaines de ses recherches actuelles sont axées sur "la compréhension et la récupération de contextes longs", de sorte que la prochaine version de Grok pourrait bien disposer d'une fenêtre contextuelle plus large.

L'ensemble exact de données utilisé pour former Grok-1 n'est pas clair, mais il comprend très certainement vos tweets sur X, et le chatbot Grok a également un accès en temps réel à l'internet.

Nous devrons attendre les réactions des bêta-testeurs pour nous faire une idée de la qualité réelle du modèle.

Grok nous aidera-t-il à percer les mystères de la vie, de l'univers et de tout le reste ? Peut-être pas tout à fait, mais c'est un début divertissant.