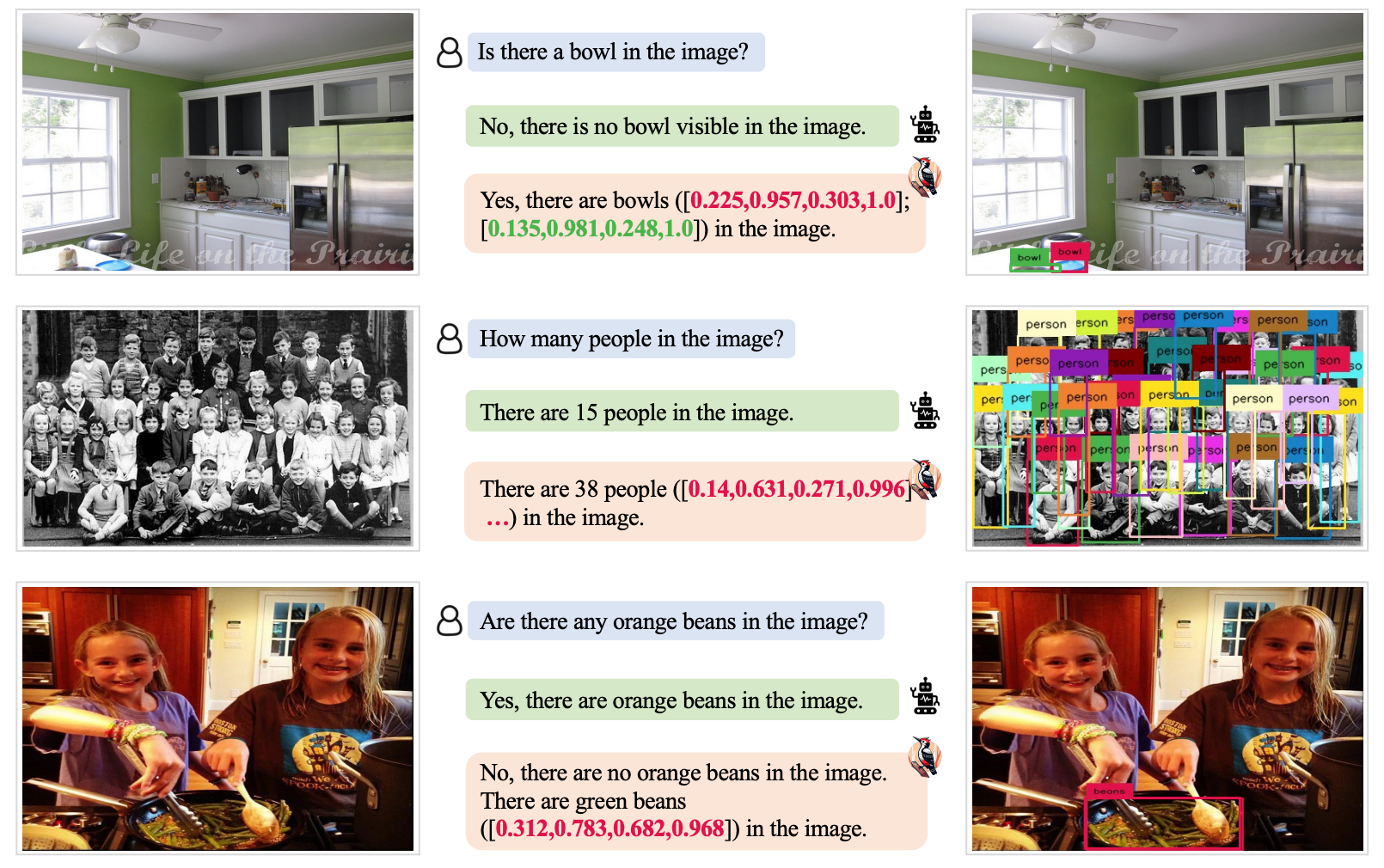

Les modèles multimodaux à grand langage (MLLM) tels que GPT-4V sont très efficaces pour analyser et décrire les images, mais il leur arrive parfois d'halluciner et de se tromper. Une nouvelle approche appelée Woodpecker pourrait y remédier.

Si vous demandez à un MLLM de décrire une photo, il peut normalement identifier les objets et décrire la scène avec précision. Mais comme pour les réponses à des textes, le modèle émet parfois des hypothèses basées sur des éléments ou des concepts qui apparaissent souvent ensemble.

Par conséquent, un MLLM peut décrire une photo de devanture de magasin et dire qu'il y a des gens dans la scène alors qu'il n'y en a pas.

La correction des hallucinations dans les LLM à base de texte est en cours mais devient beaucoup plus facile lorsque le modèle est connecté à l'internet. Le LLM peut générer une réponse textuelle à une invite, en vérifier la véracité sur la base de données Internet pertinentes et s'auto-corriger si nécessaire.

Des scientifiques du laboratoire YouTu de Tencent et de l'Université des sciences et technologies de Chine ont adopté cette approche et l'ont traduite en une solution visuelle appelée Woodpecker.

En termes simples, Woodpecker construit un ensemble de connaissances à partir de l'image et un LLM peut ensuite l'utiliser comme référence pour corriger la description initiale générée par le MLLM.

Voici une brève description de son fonctionnement :

- Un LLM tel que GPT-3.5 Turbo analyse la description générée par le MLLM et extrait les concepts clés tels que les objets, les quantités et les attributs. Par exemple, dans la phrase "L'homme porte un chapeau noir", les objets "homme" et "chapeau" sont extraits.

- Un LLM est ensuite invité à générer des questions liées à ces concepts, telles que "Y a-t-il un homme sur l'image ?" ou "Que porte l'homme ?".

- Ces questions sont transmises à un modèle de réponse aux questions visuelles (VQA). La DINO de mise à la terre effectue la détection et le comptage des objets, tandis que le VQA BLIP-2-FlanT5 répond aux questions liées aux attributs après avoir analysé l'image.

- Un LLM combine les réponses aux questions dans une base de connaissances visuelles pour l'image.

- Le LLM utilise ce corpus de référence pour corriger les éventuelles hallucinations de la description originale du MLLM et ajouter les détails qui lui ont échappé.

Les chercheurs ont baptisé leur approche "Pic" en référence à la façon dont l'oiseau ramasse les insectes dans les arbres.

Les résultats des tests ont montré que Woodpecker a amélioré la précision de 30,66% pour MiniGPT4 et de 24,33% pour les modèles mPLUG-Owl.

La nature générique des modèles requis dans cette approche signifie que l'approche Woodpecker pourrait facilement être intégrée dans divers MLLM.

Si OpenAI intègre Woodpecker dans ChatGPT, nous pourrions voir une nette amélioration des performances visuelles déjà impressionnantes. Une réduction de l'hallucination MLLM pourrait également améliorer la prise de décision automatisée par les systèmes qui utilisent des descriptions visuelles comme données d'entrée.