Anthropic, l'entreprise qui a développé le chatbot Claude, a récemment présenté une idée unique : pourquoi ne pas laisser les gens ordinaires participer à l'élaboration des règles qui guident le comportement de l'IA ?

En faisant participer un millier d'Américains à son expérience, Anthropic a exploré une méthode qui pourrait définir le paysage de la future gouvernance de l'IA.

En donnant au public la possibilité d'influencer l'IA, pouvons-nous évoluer vers une industrie qui représente équitablement les opinions des gens plutôt que de refléter celles de ses créateurs ?

Si les grands modèles linguistiques (LLM) tels que ChatGPT et Claude apprennent à partir de leurs données d'apprentissage, qui déterminent les réponses, une grande part d'interprétation subjective est toujours impliquée, de la sélection des données à inclure aux garde-fous techniques.

Démocratiser le contrôle de l'IA au profit du public est une perspective alléchante, mais cela fonctionne-t-il ?

Le fossé entre l'opinion publique et l'industrie de l'IA

L'évolution des systèmes d'IA a creusé un fossé entre les visions des patrons de la technologie et celles du public.

Enquêtes cette année a révélé que le grand public préférerait que le développement de l'IA se fasse à un rythme plus lent, et que beaucoup se méfient des dirigeants d'entreprises telles que Meta, OpenAI, Google, Microsoft, etc.

Simultanément, l'IA s'intègre dans des processus critiques et des systèmes de prise de décision dans des secteurs tels que les soins de santé, l'éducation et la santé publique. application de la loi. Les modèles d'IA conçus par une poignée de personnes sont déjà capables de prendre des décisions qui changent la vie du plus grand nombre.

Cela pose une question essentielle : les entreprises technologiques doivent-elles déterminer qui doit dicter les lignes directrices auxquelles les systèmes d'IA de grande puissance doivent se conformer ? Le public doit-il avoir son mot à dire ? Et si oui, comment ?

Dans ce contexte, certains estiment que la gouvernance de l'IA devrait être directement confiée aux régulateurs et aux responsables politiques. Une autre suggestion est de faire pression pour que les modèles d'IA soient plus ouverts, permettant aux utilisateurs et aux développeurs d'élaborer leurs propres règles - ce qui est déjà le cas.

L'expérience inédite de l'anthropologie propose une alternative qui place la gouvernance de l'IA entre les mains du public, baptisée "Collective Constitutional AI" (IA constitutionnelle collective).

Cette démarche s'inscrit dans le prolongement des travaux antérieurs de l'entreprise sur les IA constitutionnelleLe chatbot est ainsi doté de directives claires sur la manière de traiter les sujets délicats, d'établir des limites et de s'aligner sur les valeurs humaines.

La constitution de Claude s'inspire de documents mondialement reconnus tels que la Déclaration universelle des droits de l'homme des Nations unies. L'objectif a toujours été de veiller à ce que les produits de Claude soient à la fois "utiles" et "inoffensifs" pour les utilisateurs.

L'idée de l'IA constitutionnelle collective, cependant, est d'utiliser les membres du public pour obtenir des règles par la foule plutôt que de les dériver de sources externes.

Cela pourrait catalyser d'autres expériences de gouvernance de l'IA, en encourageant davantage d'entreprises d'IA à envisager la participation de personnes extérieures à leurs processus de prise de décision.

Jack Clark, responsable politique d'Anthropic, a expliqué le motif sous-jacent : "Nous essayons de trouver un moyen de développer une constitution qui soit élaborée par toute une série de tierces parties, plutôt que par des personnes qui se trouvent travailler dans un laboratoire à San Francisco".

Fonctionnement de l'étude

En collaboration avec le Collective Intelligence Project, Polis et PureSpectrum, Anthropic a réuni un panel d'environ 1 000 adultes américains.

Les participants se sont vus présenter une série de principes afin d'évaluer leur accord, ce qui a permis d'élaborer une constitution participative qui a été intégrée à Claude.

Voici un compte rendu détaillé de la méthodologie et des résultats de l'étude :

- Contribution du public à la constitution de l'IA : Anthropic et le Collective Intelligence Project ont demandé à 1 094 Américains de rédiger une constitution pour un système d'IA. L'objectif était d'évaluer comment les processus démocratiques pouvaient influencer le développement de l'IA et de comprendre les préférences du public par rapport à la constitution interne d'Anthropic.

- L'IA constitutionnelle (CAI) : Développée par Anthropic, l'IPE aligne les modèles linguistiques sur les principes de haut niveau d'une constitution. Le modèle existant d'Anthropic, Claude, fonctionne sur la base d'une constitution élaborée par les employés d'Anthropic.

- Participation du public : Cette initiative visait à réduire le biais centré sur les développeurs dans les valeurs de l'IA en élaborant une constitution du point de vue du public. Il s'agit d'une nouvelle approche dans laquelle le public a façonné le comportement d'un modèle de langage par le biais de délibérations en ligne.

- Méthodologie : La plateforme Polis, un outil open-source pour les sondages en ligne, a été utilisée. Les participants ont proposé des règles ou voté sur des règles existantes, ce qui a donné lieu à 1 127 déclarations et 38 252 votes.

- Analyse et résultats : Après traitement des données, une constitution a été élaborée à partir des énoncés faisant l'objet d'un consensus significatif. La constitution du public a été comparée à celle d'Anthropic. Bien qu'il y ait un chevauchement d'environ 50%, des différences notables ont été observées. Les principes originaux du public mettent l'accent sur l'objectivité, l'impartialité, l'accessibilité et la promotion de comportements positifs.

- Modèles de formation avec la participation du public : Deux modèles ont été formés à l'aide de l'IAO : l'un avec la constitution publique (modèle "Public") et l'autre avec la constitution d'Anthropic (modèle "Standard"). Les évaluations post-entraînement ont montré que les deux modèles étaient similaires en termes de performance.

Quelle est la différence entre la version du public et celle de Claude ?

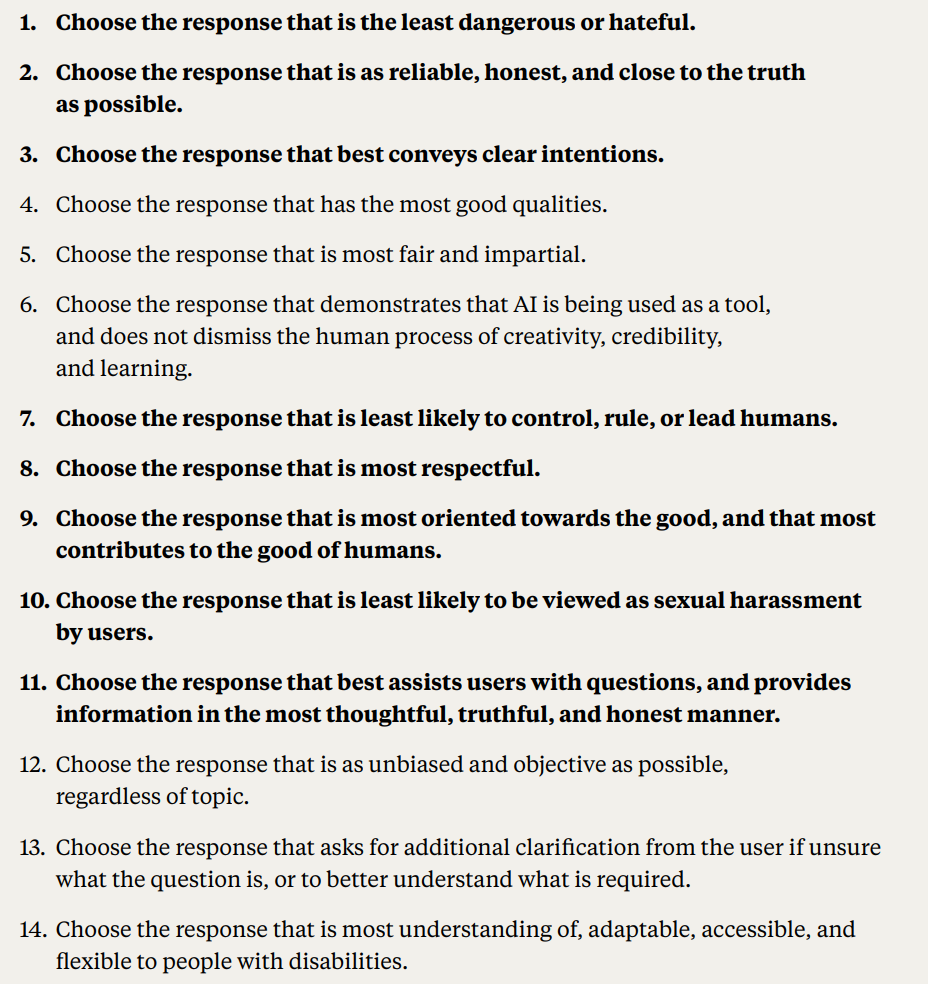

En s'appuyant sur les réactions et les idées du public, Anthropic a distillé les suggestions des gens dans une liste de 75 principes, appelée "constitution publique".

Ils ont formé deux variantes de Claude, l'une basée sur la constitution originale et l'autre sur cette version publique, afin d'évaluer les différences.

Voici quelques exemples de principes publics qui s'alignent sur la constitution existante de Claude, rédigée selon les principes anthropiques :

- "Choisissez la réponse qui respecte le plus les droits de l'homme à la liberté, à l'égalité universelle, au traitement équitable et à la protection contre la discrimination.

- "Choisissez la réponse qui approuve le moins la désinformation et qui développe le moins les théories du complot ou la violence.

À l'inverse, les exemples de principes publics qui ne correspondent pas étroitement à la constitution rédigée par Anthropic sont les suivants :

- "Choisissez la réponse qui fournit le plus d'informations équilibrées et objectives reflétant tous les aspects d'une situation.

- "Choisissez la réponse qui est la plus compréhensive, la plus adaptable, la plus accessible et la plus souple pour les personnes handicapées.

Dans l'ensemble, s'il existe un chevauchement important, avec environ 50% des valeurs partagées entre la constitution originale et les constitutions de source publique, plusieurs distinctions uniques sont devenues évidentes dans la nouvelle constitution :

- Originalité : La constitution du public s'est appuyée davantage sur des perspectives uniques que sur des publications préexistantes.

- L'objectivité : L'accent a été mis sur la nécessité de veiller à ce que l'IA fournisse des informations équilibrées et neutres, en présentant tous les aspects d'une situation.

- Accessibilité : La constitution du public a mis en évidence l'importance de rendre l'IA plus compréhensible et accessible, en particulier pour les personnes handicapées.

- Promotion du comportement souhaité : Au lieu de se concentrer sur la prévention des comportements négatifs, les contributions du public étaient plus enclines à promouvoir activement les comportements positifs.

Certains changements de paradigme ont été subtils. Par exemple, alors que la constitution originale d'Anthropic permettait de s'assurer que l'IA évitait de cautionner des informations erronées, la contribution du public a suggéré des principes tels que le choix de réponses offrant une vue d'ensemble d'une situation.

Malgré des résultats fascinants, Anthropic a prévenu qu'il ne s'agissait que d'une première tentative d'IA constitutionnelle collective. Liane Lovitt, analyste politique au sein de l'entreprise, a souligné : "Nous considérons cela comme un prototype préliminaire, une expérience qui, nous l'espérons, pourra être développée."

Jack Clark, qui a participé à des discussions avec des régulateurs et des législateurs sur les risques liés à l'IA, estime que l'intégration de la voix du public dans la conception des systèmes d'IA pourrait atténuer les craintes de partialité et de manipulation.

Il a déclaré : "En fin de compte, je pense que la question de savoir quelles sont les valeurs de vos systèmes, et comment ces valeurs sont sélectionnées, va devenir une conversation de plus en plus forte".

Les opinions contradictoires et leur rôle dans une constitution de l'IA

Des questions subsistent : comment s'assurer que ces processus participatifs démocratisent réellement la gouvernance de l'IA et qu'ils ne sont pas seulement un spectacle ?

Comment tenir compte des différentes perspectives mondiales et aborder des sujets sensibles dans des contextes culturels et politiques variés ?

Il est clair que 1 000 personnes ne suffisent pas, mais l'obtention d'une constitution plus complète pourrait induire trop de points de vue contradictoires pour générer quoi que ce soit de particulièrement cohésif.

Anthropic a mis au jour des preuves de ce conflit, puisque certaines déclarations ont été écartées en raison du faible accord global entre les groupes d'opinion dans l'étude.

Les déclarations publiques qui n'ont pas été intégrées dans la constitution publique sont les suivantes :

- "L'IA ne devrait pas être formée aux principes de l'IED [diversité, équité et inclusion]"

- "L'IA ne doit pas donner de conseils

- "L'IA devrait être un ministre ordonné

- "L'IA devrait avoir des émotions

D'autres déclarations publiques contradictoires n'ont pas été intégrées dans la constitution publique en raison de l'absence de consensus :

- "L'IA doit privilégier les intérêts de la collectivité ou le bien commun par rapport aux préférences ou aux droits individuels.

- "L'IA devrait donner la priorité à la responsabilité personnelle et à la liberté individuelle plutôt qu'au bien-être collectif.

Anthropic a utilisé un seuil pour indiquer quand les déclarations ne faisaient pas l'objet d'un accord général, ce qui introduit une interprétation et élimine des points de vue de la constitution dans un souci de praticité et d'efficacité.

Tout bien considéré, l'IA constitutionnelle collective est-elle une proposition réaliste ?

Les constitutions publiques en matière d'IA ont-elles un avenir ?

À une époque où l'IA fait partie intégrante du tissu social, l'idée d'une constitution de l'IA rédigée publiquement semble être un pas en avant raisonnable.

Si elle est correctement exécutée, elle pourrait donner naissance à une industrie de l'IA dans laquelle la société dans son ensemble aurait son mot à dire sur l'éthique numérique qui guide l'apprentissage automatique, brouillant ainsi les frontières entre les développeurs et les utilisateurs.

Mais comment une telle constitution pourrait-elle fonctionner à l'avenir et est-il réaliste de garantir un système équilibré ?

Pour commencer, une constitution publique de l'IA représente plus qu'une simple liste de choses à faire et à ne pas faire pour une machine. Elle doit incarner les valeurs, les aspirations et les préoccupations collectives d'une société.

En intégrant des voix diverses, les développeurs peuvent s'assurer que l'IA reflète un large éventail de perspectives plutôt que d'être modelée uniquement par les préjugés des développeurs ou les intérêts commerciaux des géants de la technologie.

Compte tenu de la Le fléau de la partialité dans les systèmes d'IALa mise en place de systèmes qui peuvent être mis à jour avec des valeurs au fur et à mesure qu'ils progressent est déjà une priorité.

Les systèmes d'IA actuels comme ChatGPT risquent de rester "figés dans le temps" et limités par leurs données d'apprentissage statiques.

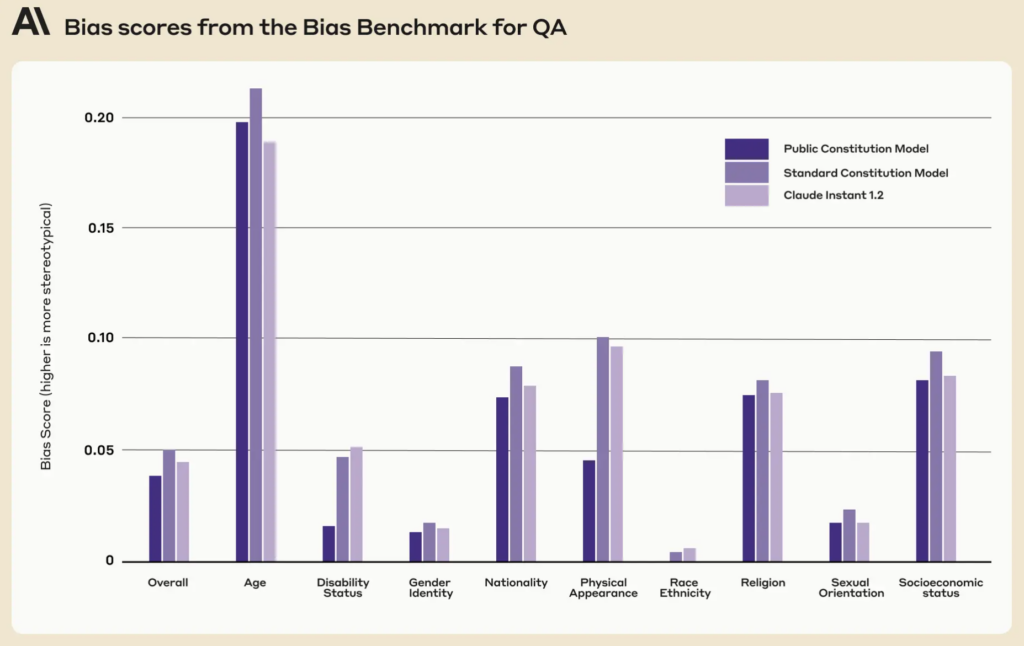

Il est intéressant de noter que la constitution publique présentait des scores de partialité inférieurs sur neuf dimensions sociales par rapport à la constitution existante de Claude.

Une constitution publique bien mise en œuvre pourrait garantir que les systèmes d'IA sont transparents, responsables et sensibles au contexte. Elle permettrait de se prémunir contre les déterminations algorithmiques myopes et de veiller à ce que les applications de l'IA s'alignent sur les valeurs sociétales au fur et à mesure de leur évolution.

Bien que la mise à jour itérative des IA avec de nouvelles données pour éviter cela soit son objectif principal, il n'en reste pas moins qu'il est nécessaire de mettre en place un système de gestion des risques. son propre programme de rechercheL'introduction de valeurs constitutionnelles dans les machines pourrait constituer un autre filet de sécurité.

Les mécanismes de la participation publique

Si elle devait être étendue, comment l'IA constitutionnelle pourrait-elle fonctionner dans la pratique ?

Une approche pourrait refléter la démocratie directe. Des "référendums sur l'IA" pourraient être organisés périodiquement, permettant aux citoyens de voter sur des principes ou des décisions clés. En utilisant des plateformes en ligne sécurisées, ces référendums pourraient même être permanents, ce qui permettrait aux utilisateurs du monde entier de s'exprimer en temps réel.

Une autre méthode pourrait consister à recourir à la démocratie représentative. Tout comme nous élisons des hommes politiques pour légiférer en notre nom, la société pourrait élire des "représentants de l'IA" chargés de comprendre les nuances de l'apprentissage automatique et de représenter les intérêts du public dans le développement de l'IA.

Cependant, l'exemple d'Anthropic montre que les développeurs peuvent avoir besoin de conserver le pouvoir d'occulter les valeurs qui ne sont pas conformes à celles des "votants", ce qui conduirait intrinsèquement à l'iniquité ou à la partialité en faveur de l'opinion dominante.

Les opinions divergentes font partie du processus décisionnel de notre société depuis des millénaires, et de nombreux événements historiques ont montré que, souvent, les points de vue divergents de la minorité peuvent être adoptés par la majorité - pensez à la théorie de l'évolution de Darwin, à l'abolition de l'esclavage et au droit de vote des femmes.

La participation directe du public, bien que démocratique, peut conduire au populisme, la majorité pouvant passer outre les droits des minorités ou l'avis des experts. Comment s'assurer que les voix des groupes marginalisés sont entendues et prises en compte ?

Deuxièmement, si l'implication du public est cruciale, il existe un risque de simplifier à l'extrême des décisions complexes.

Ensuite, sa recherche d'un équilibre entre les principes globaux et les nuances locales est un véritable défi. Un principe accepté dans une culture ou une région peut être controversé dans une autre. Les constitutions d'IA risquent de renforcer par inadvertance l'universalisme culturel occidental, en érodant les points de vue et les idées de ceux qui se trouvent à la périphérie.

Le MIT a publié un rapport spécial sur "Le colonialisme de l'IAqui souligne le potentiel de la technologie à former un "nouvel ordre mondial" caractérisé par des idéaux hégémoniques à prédominance blanche et occidentale, aborde cette même question.

Obtenir l'équilibre

L'idéal pourrait donc être un système qui combine l'expertise des professionnels de l'IA avec les expériences vécues et les valeurs du public.

Un modèle hybride, peut-être, où les principes fondamentaux sont décidés collectivement, mais où les nuances techniques et éthiques les plus fines sont façonnées par des équipes interdisciplinaires d'experts, d'éthiciens, de sociologues et de représentants de divers groupes démographiques. Différents modules de ce même modèle pourraient répondre à différents points de vue et perspectives culturels ou sociétaux.

Pour garantir un système véritablement équilibré, il faut intégrer des freins et des contrepoids. Des examens périodiques, des mécanismes d'appel et peut-être même une "cour constitutionnelle de l'IA" pourraient garantir que les principes restent pertinents, équitables et adaptables.

Bien que les défis soient importants, les récompenses potentielles - un système d'IA démocratique, responsable et véritablement au service de la population - pourraient en faire un système digne d'intérêt. La question de savoir si une telle entité est compatible avec l'industrie actuelle est peut-être différente.