Dans un passé pas si lointain, les conversations sur l'IA étaient essentiellement confinées au domaine de la science-fiction et des articles universitaires.

Aujourd'hui, l'IA est profondément intégrée dans le tissu de la vie quotidienne, qu'il s'agisse d'alimenter les maisons intelligentes ou de diagnostiquer des maladies.

Mais alors que la technologie de l'IA progresse à toute allure, les cadres réglementaires se contentent de rattraper le temps perdu et sont souvent à la traîne de l'innovation.

L'humanité se trouve donc confrontée à une énigme aux multiples facettes : comment élaborer des lois et des réglementations suffisamment souples pour s'adapter à l'évolution rapide des technologies tout en étant suffisamment solides pour protéger les intérêts de la société ?

Dans le monde entier, les efforts de réglementation sont loin d'être uniformes. L'Union européenne (UE) ouvre la voie avec sa loi globale sur l'IA, qui vise à classer et à contrôler les applications de l'IA en fonction de leur niveau de risque.

Entre-temps, les États-Unis ont privilégié les engagements volontaires plutôt qu'une législation immédiate.

La Chine, quant à elle, exerce une forte emprise sur l'IA, en alignant la réglementation sur des objectifs de gouvernance politique et sociale plus larges.

N'oublions pas non plus les autres juridictions : l'IA est un phénomène mondial qui nécessitera une législation quasi universelle. couverture.

Où en est la réglementation aujourd'hui et comment devrait-elle évoluer ?

L'approche de l'UE

L'UE a adopté un cadre rigoureux avec sa loi révolutionnaire sur l'IA, qui devrait être pleinement approuvée d'ici la fin de l'année.

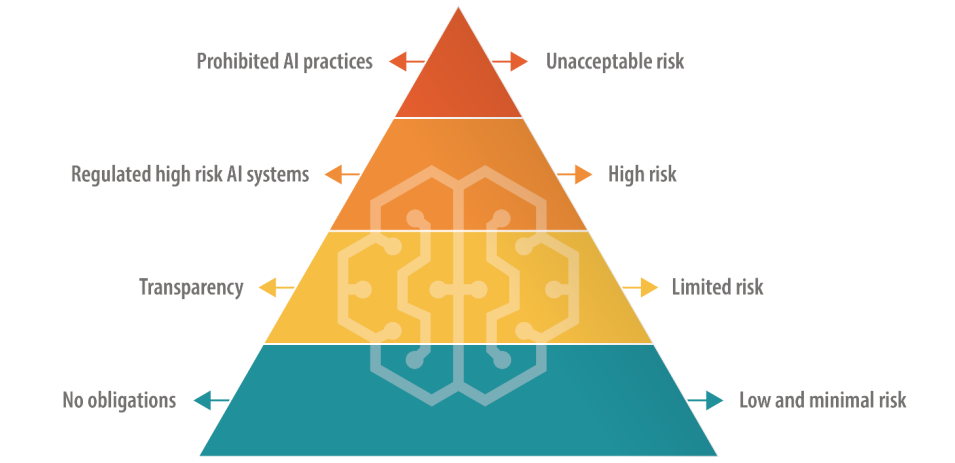

La loi sur l'IA prévoit quatre niveaux, à savoir les "IA à risque inacceptable", les "IA à risque élevé", les "IA à risque limité" et les "IA à faible risque", chacun étant assorti d'un ensemble spécifique de lignes directrices et d'interdictions.

Risque inacceptable Les IA présentent des dangers immédiats ou considérables, tels que des dommages physiques ou mentaux ou des atteintes aux droits de l'homme, et elles seront purement et simplement interdites.

Les IA à haut risque sont autorisées mais soumises à des règles strictes allant de la gestion des risques à la documentation technique et à la cybersécurité.

Les IA limitées et à faible risque, quant à elles, restent pour la plupart non réglementées, mais sont tenues de maintenir la transparence avec les utilisateurs.

Il y a un sursis à court terme, car la législation prévoit une période de grâce d'environ deux ans pour permettre aux entreprises de s'aligner sur les nouvelles réglementations.

L'UE propose que les créateurs initiaux des modèles d'IA soient responsables de la manière dont leur technologie est utilisée, même lorsqu'elle est intégrée dans un système différent par une autre entreprise ou un autre développeur. De nouvelles règles ont également été ajoutées pour les "modèles de base", qui comprennent les modèles d'IA générative.

L'accueil réservé à la loi sur l'IA est variable - certains critiquent ses définitions maladroites et sa capacité à freiner l'innovation. Par exemple, il existe une grande incertitude quant à la manière dont les différents modèles d'IA se classent dans les catégories de risque.

En outre, les petites entreprises d'IA craignent de ne pas avoir les ressources nécessaires pour se conformer à la réglementation.

Sam Altman, PDG d'OpenAI brièvement menacé de retirer les produits de son entreprise du marché de l'UE si la loi sur l'IA spécifie des exigences qui ne peuvent être respectées de manière réaliste.

En juin, 150 grandes entreprises a mis en évidence l'approche rigoureuse de la loiLa Commission européenne a adopté un rapport sur l'état d'avancement de la mise en œuvre de la stratégie européenne de lutte contre la pauvreté, en déclarant que les règles actuelles risquent de détruire la compétitivité européenne.

Divergence par rapport aux États-Unis

A Analyse de Stanford de la loi sur l'IA a abordé les différences fondamentales entre les approches de l'UE et des États-Unis en matière de réglementation de l'IA.

Alex Engler, chargé d'études sur la gouvernance à la Brookings Institution, a déclaré : "Il y a une disparité croissante entre l'approche des États-Unis et celle de l'UE [en matière de réglementation de l'IA]".

Il souligne que l'UE a fait pression pour obtenir des lois sur la confidentialité des données et la transparence, qui restent pour l'essentiel inexistantes aux États-Unis. Les disparités compliquent la mise en conformité pour les entreprises d'IA, et les coûts associés à la mise en conformité interjuridictionnelle pourraient s'avérer excessifs.

"Les intérêts des entreprises se battront bec et ongles si vous avez deux normes radicalement différentes pour les plateformes en ligne", a déclaré M. Engler.

Dans l'ensemble, il est difficile d'envisager que les entreprises technologiques ne trouvent pas un moyen de naviguer dans la loi sur l'IA, comme elles l'ont fait avec le GDPR et comme elles devront le faire avec la récente loi sur les services numériques.

S'adressant à la revue NatureEn revanche, Daniel Leufer, analyste politique principal à Access Now, considère que les objections de l'industrie de l'IA à l'égard de la loi ne sont que "l'habituelle mise en scène".

L'approche britannique

Après le Brexit, le Royaume-Uni entend capitaliser sur son indépendance vis-à-vis de l'UE pour formuler un régime réglementaire plus flexible et spécifique à chaque secteur.

Contrairement à la loi sur l'IA, le gouvernement britannique a l'intention de réglementer les applications de l'IA plutôt que le logiciel sous-jacent lui-même.

Une position "pro-innovation

Le gouvernement britannique a publié un livre blanc en mars qui définit un cadre "favorable à l'innovation" et invite les parties prenantes à faire part de leur point de vue. Toutefois, le gouvernement doit encore publier des lignes directrices pour la mise en œuvre de ce cadre.

Un communiqué indique que "le gouvernement aidera le Royaume-Uni à exploiter les possibilités et les avantages offerts par les technologies de l'IA" - une approche critiquée pour ne pas accorder une attention suffisante aux dommages liés à l'IA.

Le gouvernement avait même prévu d'offrir aux entreprises d'IA une "exemption de droits d'auteur" extrêmement controversée, mais il n'en est rien. Ce plan a fait volte-face en août.

La Grande-Bretagne a eu du mal à attirer l'innovation technologique ces derniers temps, notamment en perdant le fabricant de puces de Cambridge, Arm, qui a choisi d'introduire ses actions en bourse aux États-Unis plutôt que dans le pays. Cette situation alimente peut-être l'inquiétude du Royaume-Uni quant à la nécessité de relancer son secteur technologique en perte de vitesse.

Pour aider le Royaume-Uni à se positionner comme un pays d'avant-garde en matière d'IA, le Premier ministre Rishi Sunak a annoncé l'organisation d'une conférence de deux jours sur l'IA. Sommet sur la sécurité de l'IA qui aura lieu en novembre.

La Chine a notamment été invitée à l'événement, mais il semblerait qu'elle en soit exclue. craintes d'espionnage.

L'approche américaine

Aux États-Unis, l'accent est mis sur l'autorégulation du secteur, du moins pour l'instant.

Le Congrès américain fait preuve d'attentisme en entamant l'examen des réunions à huis clos sur l'IA et du rapport de Chuck Schumer sur l'état d'avancement de la mise en œuvre de la politique de l'UE en la matière. Forums AI Insight pour déterminer précisément où l'IA nécessite une nouvelle réglementation.

Les accords bipartisans pourraient s'articuler autour d'une législation étroitement adaptée à la protection de la vie privée, à la transparence des plateformes ou à la protection des données personnelles. protéger les enfants en ligne.

En outre, certains ont souligné que les lois et réglementations existantes restent pertinentes pour l'IA.

En juin, Khan a déclaréIl n'y a pas d'exemption des lois interdisant la discrimination en matière d'IA... Au fur et à mesure que ces questions sont intégrées dans la prise de décision quotidienne, je pense qu'elles méritent d'être examinées de près... Je pense que les responsables de l'application des lois, que ce soit au niveau des États ou au niveau national, vont prendre des mesures.

Cadres volontaires et palliatifs

Des entreprises technologiques de premier plan comme Microsoft, OpenAI, Google, Amazon, et Meta ont récemment a signé des engagements volontaires pour un développement sûr de l'IAy compris la réalisation de tests internes et externes des modèles d'IA avant leur diffusion publique.

De nombreux leaders de l'industrie technologique ont fait part de leurs propres engagements, mais en en l'absence d'un contrôle législatif solide, la sincérité de ces promesses n'a pas encore été testée.

Dans l'ensemble, les critiques affirment que l'approche des États-Unis est essentiellement symbolique et n'a pas la profondeur et l'engagement de la loi sur l'IA de l'UE. La première Forum AI Insight s'est déroulée en grande partie à huis clos, ce qui a été critiqué par certains comme restreignant le débat ouvert.

Le sénateur Josh Hawley a déclaré que l'événement était un "cocktail géant".

Comme le résume très justement Ryan Calo, professeur à la faculté de droit de l'université de Washington, "il y a une apparence d'activité, mais rien de substantiel et de contraignant".

L'approche chinoise

La Chine, proportionnellement à son appétit pour le contrôle étatique, impose certaines des réglementations les plus strictes en matière d'IA.

L'accent est mis sur le contrôle de la diffusion d'informations par l'IA, ce qui reflète les cadres de gouvernance politique et sociale plus larges de la Chine.

Par exemple, les fournisseurs d'IA générative dont les produits peuvent "influencer l'opinion publique" sont tenus de se soumettre à des examens de sécurité.

La première vague de chatbots approuvés, dont ERNIE Bot de Baidu, a récemment été approuvée. rendu public et s'est avéré censurer les questions à caractère politique.

La montée en puissance des "deep fakes" et des contenus générés par l'IA pose des problèmes dans le monde entier, et la Chine ne fait pas exception à la règle. Reconnaissant les pièges potentiels de l'IA relativement tôt dans l'année, l'Administration chinoise du cyberespace (CAC) exige que les générateurs de contenu pilotés par l'IA se soumettent à des processus de vérification de l'identité des utilisateurs.

En outre, des dispositions relatives au filigrane ont été introduites pour distinguer les contenus générés par l'IA de ceux créés par l'homme, des règles que les puissances occidentales cherchent également à mettre en œuvre.

Divergence entre les États-Unis et la Chine

L'IA a accéléré les frictions entre les États-Unis et la Chine, déclenchant ce que beaucoup ont appelé une "guerre froide numérique" - ou peut-être plus justement une "guerre froide de l'IA".

Les restrictions imposées par les États-Unis à la collaboration et au commerce avec la Chine ne sont pas nouvelles, mais le découplage entre les deux pays a fait un bond en avant lorsque Xi Jinping a annoncé sa nouvelle politique réformée de coopération avec la Chine. Plan "Made in China 2025.

L'objectif est de rendre la Chine 70% autosuffisante dans des secteurs technologiques cruciaux d'ici 2025, y compris la technologie de l'IA haut de gamme.

Actuellement, les États-Unis sont l'interruption du financement et de la recherche avec la Chine, tout en les soumettant à l'obligation d'acheter des puces d'intelligence artificielle à des entreprises comme Nvidia.

Si les États-Unis ont une longueur d'avance dans la course à la domination de l'IA, la Chine a plus d'un tour dans son sac, notamment une approche centralisée de la réglementation et des données personnelles quasi illimitées.

En mai, Edith Yeung, partenaire de la société d'investissement Race Capital, a déclaré à la BBCLa Chine a beaucoup moins de règles en matière de protection de la vie privée et beaucoup plus de données [que les États-Unis]. Il y a par exemple des caméras de vidéosurveillance pour la reconnaissance faciale partout".

L'alignement étroit du gouvernement et de l'industrie technologique de la Chine présente également des avantages, car le partage de données entre le gouvernement et les entreprises technologiques nationales est pratiquement transparent.

Les États-Unis et d'autres juridictions occidentales n'ont pas le même accès aux données commerciales et personnelles, qui sont l'élément vital des modèles d'apprentissage automatique. En fait, on s'inquiète déjà de la possibilité que des données de haute qualité puissent être utilisées dans le cadre de l'apprentissage automatique. les sources de données sont "en voie d'épuisement".'

En outre, l'utilisation libérale par les entreprises d'IA occidentales de données d'entraînement potentiellement protégées par le droit d'auteur a suscité un tollé général et a conduit à la mise en place d'un système de gestion des données. poursuites judiciaires.

Les entreprises chinoises spécialisées dans l'IA ne seront probablement pas confrontées à ce problème.

Équilibrer l'accessibilité et le risque

L'IA était autrefois confinée aux universités et aux grandes entreprises. En l'espace d'un an environ, entre un quart et la moitié des adultes au Royaume-Uni, aux États-Unis et dans l'Union européenne ont utilisé l'IA générative.

L'accessibilité présente de nombreux avantages, notamment celui de stimuler l'innovation et de réduire les barrières à l'entrée pour les startups et les développeurs individuels. Toutefois, elle soulève également des inquiétudes quant aux abus potentiels liés à un accès non réglementé.

L'incident récent où le modèle linguistique Llama-1 de Meta a été divulguée sur l'internet illustre les défis que pose l'encadrement de la technologie de l'IA. Des modèles d'IA en libre accès ont déjà été utilisés à des fins frauduleuses et pour générer de la valeur ajoutée. des images d'abus d'enfants.

Les entreprises spécialisées dans l'IA le saventMeta est devenu un antagoniste de l'industrie en publiant une série de modèles gratuits. Meta a émergé comme une sorte d'antagoniste de l'industrie, en publiant une série de modèles gratuits alors que d'autres, comme Microsoft, OpenAI et Google, s'efforcent de monétiser leurs produits d'IA.

D'autres modèles à source ouverte, comme le Falcon 180B LLMsont exceptionnellement puissants tout en étant dépourvus de garde-fous.

Certains pensent que les grandes entreprises du secteur de l'IA font pression pour obtenir une réglementation afin d'écarter les petits acteurs et la communauté des logiciels libres, ce qui leur permet de conserver leur position dominante dans le secteur.

L'énigme du double usage de l'IA

Les applications doubles ou multiples de l'IA constituent un autre facteur complexe.

Les mêmes algorithmes qui peuvent améliorer notre qualité de vie peuvent également être utilisés à des fins militaires. C'est peut-être là le talon d'Achille du cadre heuristique de la loi européenne sur l'IA : comment interpréter les IA utiles qui peuvent être modifiées pour nuire ?

La réglementation des technologies à double usage est notoirement complexe. La mise en œuvre de contrôles stricts pourrait étouffer l'innovation et la croissance économique lorsque seule une infime minorité utilise une technologie d'IA à mauvais escient.

Les entreprises spécialisées dans l'IA peuvent contourner le blâme en créant des politiques contre les abus, mais cela n'empêche pas les gens d'utiliser les technologies de l'information et de la communication (TIC). Jailbreakspour tromper les modèles et leur faire produire du matériel illicite.

Trouver un équilibre entre les avantages économiques de l'IA et les préoccupations éthiques

Les avantages de l'IA sont économiquement convaincants, en particulier dans des secteurs tels que les soins de santé, l'énergie et l'industrie manufacturière.

Rapports par McKinsey et PwC prévoient que l'IA apportera des milliers de milliards à l'économie mondiale chaque année, indépendamment de l'impact des remplacements d'emplois et des licenciements.

L'IA peut être considérée comme une voie de création d'emplois et de croissance pour les pays confrontés à des problèmes économiques.

Sur un plan philosophique plus large, l'IA est parfois présentée comme le sauveur de l'humanité face à des problèmes macroéconomiques tels que la pauvreté, le changement climatique et le vieillissement de la population.

Les gouvernements occidentaux - en particulier les États-Unis et le Royaume-Uni - semblent enclins à stimuler la croissance par des incitations fiscales, le financement de la recherche sur l'IA et une approche réglementaire de type "laissez-faire".

C'est un pari que les États-Unis ont fait dans le passé en permettant à l'industrie technologique de s'autoréguler, mais cela peut-il continuer à porter ses fruits ?

WLes prédictions alarmistes comparant l'IA à une "guerre nucléaire" et à des "pandémies mondiales" mettront-elles un terme à la vision romantique du potentiel de la technologie à sortir l'humanité des problèmes mondiaux qui ne cessent de s'aggraver ?

L'IA présente une certaine dualité qui évoque des visions à la fois eutopiques et dystopiques de l'avenir, selon les personnes que l'on écoute.

Ra régulation d'une telle entité est un défi sans précédent.

Quoi qu'il en soit, d'ici à la fin de 2024, nous vivrons probablement dans un monde où l'IA sera presque universellement réglementée, mais ce à quoi personne ne peut répondre, c'est à quel point l'industrie de l'IA est en train de se développer. - et la technologie elle-même - aura évolué d'ici là.