L'Institut d'innovation technologique des Émirats arabes unis (TII) a mis en service son Falcon 180B LLM sur Hugging Face la semaine dernière, et les premiers essais ont révélé des performances impressionnantes.

Le modèle, qui est en libre accès pour les chercheurs et les utilisateurs commerciaux, est le produit d'une industrie de l'IA en plein essor au Moyen-Orient.

Le Falcon 180B est 2,5 fois plus grand que le Meta. Lama 2 et a été entraîné avec 4 fois plus de calculs. L'IIT a entraîné le modèle sur un énorme ensemble de 3,5 trillions de jetons. C'est l'approche unique de l'ensemble de données qui est en grande partie responsable des performances impressionnantes du modèle.

Pour entraîner un modèle, il ne suffit pas de disposer d'un grand nombre de données, il faut aussi disposer d'un grand nombre de données de bonne qualité. La production de ces données est très coûteuse et il n'existe pas beaucoup d'ensembles de données de grande taille accessibles au public. TII a décidé d'essayer une nouvelle approche pour éviter la nécessité d'une curation.

En juin, des chercheurs ont utilisé un filtrage et une déduplication minutieux des données CommonCrawl accessibles au public pour créer le jeu de données RefinedWeb. Non seulement cet ensemble de données a été plus facile à produire, mais il offre également de meilleures performances que l'utilisation de corpus curatés ou de données web.

Falcon 180B a été entraîné sur un ensemble massif de 3,5 trillions de tokens de l'ensemble de données RefinedWeb, soit nettement plus que les 2 trillions de tokens de l'ensemble de données de pré-entraînement de Llama 2.

Performances du Falcon 180B

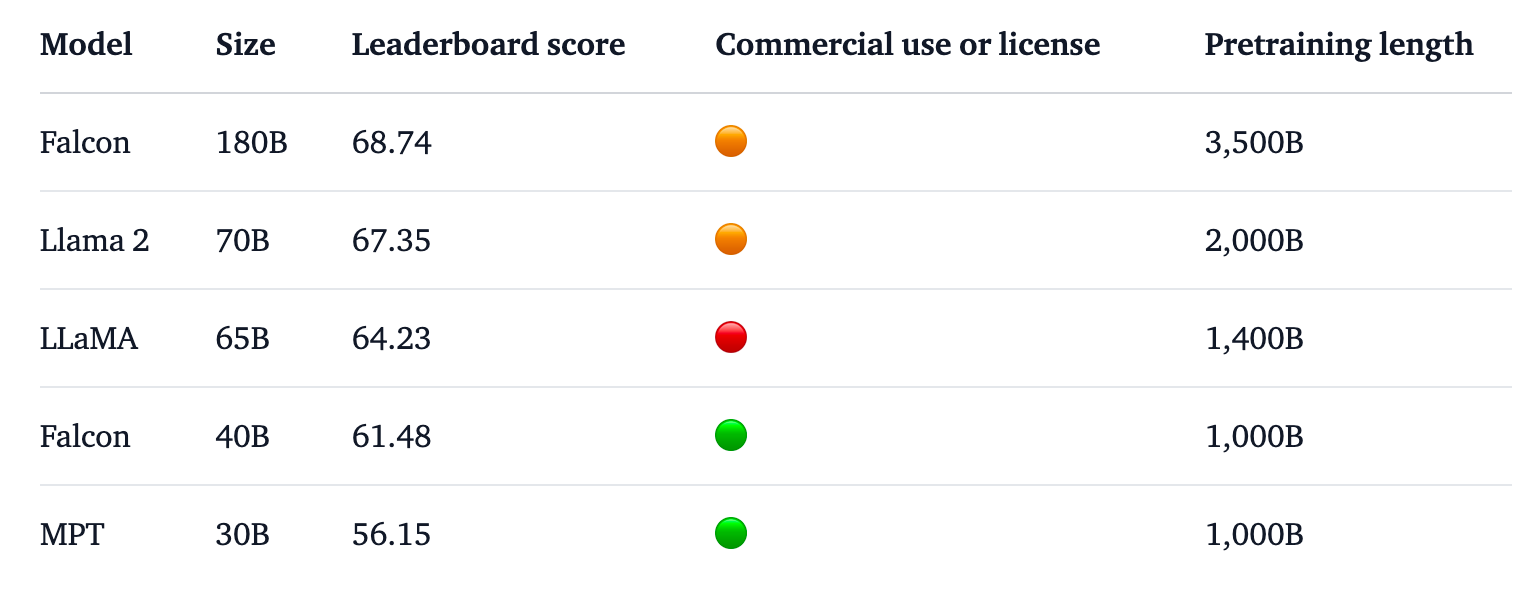

Le Falcon 180B est en tête du classement Hugging Face pour les LLM à accès libre. Le modèle surpasse Llama 2, le précédent leader, sur un certain nombre de critères de référence, notamment le raisonnement, le codage, la compétence et les tests de connaissance.

Le Falcon 180B obtient même d'excellents résultats lorsqu'il est comparé à des modèles propriétaires à source fermée. Il se classe juste derrière GPT-4 et est à égalité avec le PaLM 2 Large de Google, qui est deux fois plus grand que le Falcon 180B.

Source : Visage étreint

Malgré les performances déjà impressionnantes de son modèle pré-entraîné, l'IIT a l'intention de "fournir des versions de Falcon de plus en plus performantes à l'avenir, sur la base d'ensembles de données améliorés et de RLHF/RLAIF".

Vous pouvez essayer une version "chat" du modèle avec ceci Démonstration du Falcon 180B sur l'étreinte du visage.

La version "chat" est affinée et assainie, mais le modèle de base n'est pas encore doté de garde-fous en matière d'alignement. L'IIT a déclaré que, n'ayant pas encore fait l'objet d'un processus de mise au point ou d'alignement, elle pouvait produire des réponses "problématiques".

Il faudra du temps pour l'aligner au point qu'il puisse être déployé commercialement en toute confiance.

Malgré cela, les performances impressionnantes de ce modèle mettent en évidence les possibilités d'amélioration au-delà de la simple augmentation des ressources informatiques.

Le Falcon 180B montre que des modèles plus petits formés sur des ensembles de données de bonne qualité peuvent constituer une orientation plus rentable et plus efficace pour le développement de l'IA.

La sortie de ce modèle impressionnant souligne la croissance fulgurante de l'industrie de l'automobile dans le monde. Développement de l'IA au Moyen-OrientEn dépit des récentes les restrictions à l'exportation de GPU vers la région.

Tandis que des entreprises telles que TII et Meta continuent de publier leurs puissants modèles sous des licences d'accès libre, il sera intéressant de voir ce que Google et OpenAI font pour encourager l'adoption de leurs modèles fermés.

L'écart de performance entre les modèles en libre accès et les modèles propriétaires semble définitivement se réduire.