Nvidia a dévoilé une version mise à jour de sa Grace Hopper Superchip (GH200) annoncée il y a deux mois. La GH200 a été conçue pour alimenter les centres de données pour le traitement de l'IA à grande échelle.

Le GH200 n'a pas encore été produit en série, mais il a déjà fait l'objet d'une étude de marché. amélioration importante dans sa mémoire. La sauce secrète de ces nouvelles puces est la mémoire à large bande améliorée appelée HBM3e, qui est capable d'accéder aux données à une vitesse de 5 TB/s.

Cela représente une amélioration de 50% par rapport à la mémoire HBM3 de la puce annoncée à la fin du mois de mai.

Nvidia a connecté cette mémoire à grande vitesse à de puissants CPU et GPU sur le même appareil. L'augmentation de la vitesse de traitement qui en résulte améliorera considérablement la capacité de traitement de l'IA dont disposent les centres de données actuels.

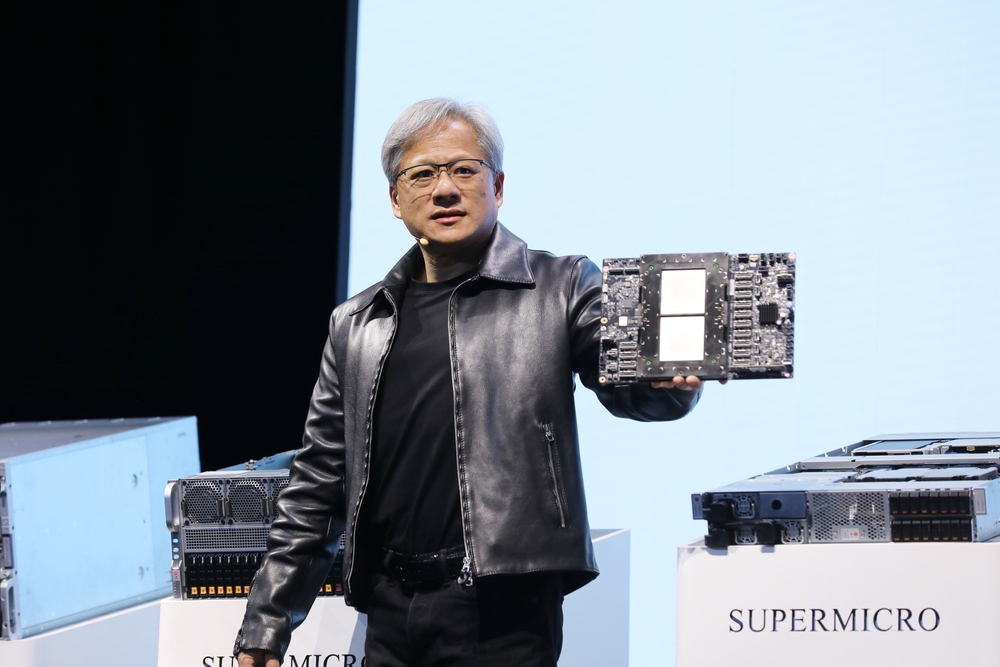

En plus de la nouvelle puce, Nvidia a également annoncé la plateforme Grace Hopper GH200 qui permet de connecter deux puces GH200 sur une seule carte.

La plateforme offre huit pétaflops de traitement de l'IA et 282 Go de mémoire HBM3e avec une bande passante de 10 To/s.

Comment la puce de Nvidia va-t-elle modifier les centres de données ?

Les chiffres peuvent être un peu difficiles à comprendre. Quelle est donc l'importance de cette nouvelle puce et de cette nouvelle plate-forme ?

Dans sa présentation, Jensen Huang, PDG de Nvidia, a pris l'exemple d'un centre de données typique équipé de 8800 processeurs x86 exécutant diverses fonctions informatiques (budget ISO).

Un tel centre de données utilisant Llama 2 pour l'inférence, avec une base de données vectorielle interrogée et SDXL générant les résultats, coûterait environ $100m et utiliserait 5MW d'énergie.

Un centre de données de $100m utilisant 2500 plateformes GH200 pourrait faire tourner les mêmes modèles 12 fois plus vite et n'utiliserait que 3MW d'énergie.

Si un centre de données se concentre sur un ensemble de tâches très spécifiques (ISO-workload), la comparaison devient encore plus stupéfiante.

Il suffirait de dépenser $8m pour 210 appareils GH200 consommant 20 fois moins d'énergie pour atteindre les performances d'un centre de données de $100m.

Il va sans dire que tous les centres de données d'informatique en nuage à base d'IA qui étaient en phase de planification avant cette publication devront retourner à leur planche à dessin.

Les puces GH200 seront lancées au deuxième trimestre 2024 et devraient grignoter une bonne partie du marché des processeurs x86. La nouvelle puce MI300 d'AMD est la plus proche rivale de Nvidia, mais son avantage en matière de mémoire semble être érodé par la mise à niveau de la nouvelle puce GH200.

Les progrès de la technologie des processeurs que nous observons dépassent de loin les attentes des consommateurs. Loi de Moore et ne montre aucun signe de ralentissement. Les applications d'IA générative offrent déjà des performances impressionnantes, mais il semble qu'elles soient sur le point de devenir beaucoup plus rapides.