Un estudio de la Universidad de Oxford ha desarrollado un medio para comprobar cuándo los modelos lingüísticos están "inseguros" de sus resultados y corren el riesgo de alucinar.

Las "alucinaciones" de la IA se refieren a un fenómeno en el que los grandes modelos lingüísticos (LLM) generan respuestas fluidas y plausibles que no son veraces ni coherentes.

Las alucinaciones son difíciles -si no imposibles- de separar de los modelos de IA. Desarrolladores de IA como OpenAI, Google y Anthropic han admitido que es probable que las alucinaciones sigan siendo un subproducto de la interacción con la IA.

Como dice el Dr. Sebastian Farquhar, uno de los autores del estudio, explica en una entrada de blog"Los LLM son muy capaces de decir lo mismo de muchas formas distintas, lo que puede dificultar distinguir cuándo están seguros de una respuesta y cuándo están literalmente inventándose algo".

El Cambridge Dictionary incluso añadió un Definición de la palabra relacionada con la IA en 2023 y la nombró "Palabra del Año".

Esta Universidad de Oxford estudiarpublicado en Nature, trata de responder cómo podemos detectar cuándo es más probable que se produzcan esas alucinaciones.

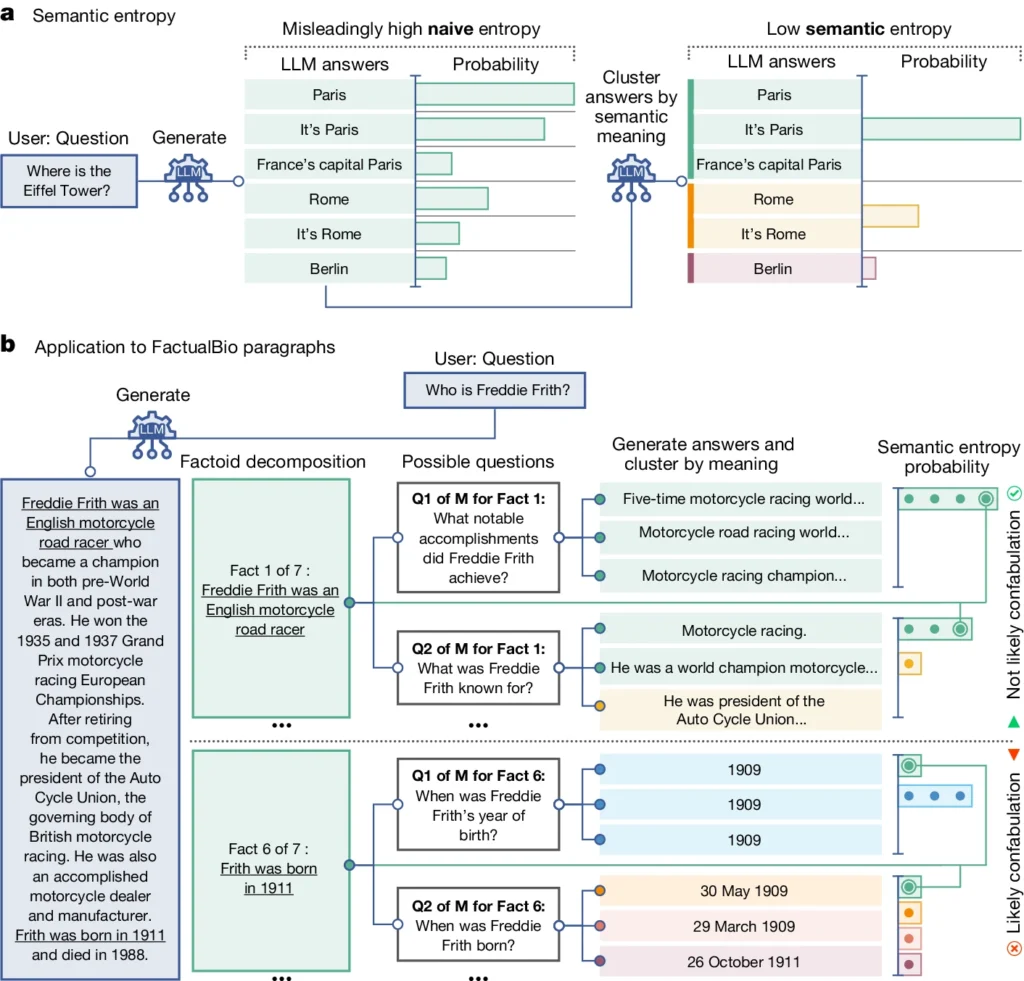

Introduce un concepto denominado "entropía semántica", que mide la incertidumbre de los resultados de un LLM a nivel de significado y no sólo de las palabras o frases concretas utilizadas.

Calculando la entropía semántica de las respuestas de un LLM, los investigadores pueden estimar la confianza del modelo en sus resultados e identificar los casos en los que es probable que alucine.

Explicación de la entropía semántica en los LLM

La entropía semántica, tal y como la define el estudio, mide la incertidumbre o incoherencia en el significado de las respuestas de un LLM. Ayuda a detectar cuándo un LLM puede estar alucinando o generando información poco fiable.

En términos más sencillos, la entropía semántica mide lo "confusa" que es la salida de un LLM.

Es probable que el LLM proporcione información fiable si el significado de sus resultados está estrechamente relacionado y es coherente. Pero si los significados son dispersos e incoherentes, es una señal de alarma de que el LLM podría estar alucinando o generando información inexacta.

Así es como funciona:

- Los investigadores incitaron activamente al LLM a generar varias respuestas posibles a la misma pregunta. Para ello, el LLM recibe la pregunta varias veces, cada una de ellas con una semilla aleatoria diferente o una ligera variación en la entrada.

- La entropía semántica examina las respuestas y agrupa las que tienen el mismo significado subyacente, aunque utilicen palabras o frases diferentes.

- Si el LLM está seguro de la respuesta, sus respuestas deberían tener significados similares, lo que da como resultado una puntuación de entropía semántica baja. Esto sugiere que el LLM comprende la información de forma clara y coherente.

- Sin embargo, si el LLM está inseguro o confuso, sus respuestas tendrán una mayor variedad de significados, algunos de los cuales podrían ser incoherentes o no estar relacionados con la pregunta. Esto da como resultado una puntuación de entropía semántica alta, lo que indica que el LLM puede alucinar o generar información poco fiable.

Para evaluar su eficacia, los investigadores aplicaron la entropía semántica a diversas tareas de respuesta a preguntas. Para ello se utilizaron puntos de referencia como preguntas de trivial, comprensión lectora, problemas de palabras y biografías.

En general, la entropía semántica superó a los métodos existentes para detectar cuándo era probable que un LLM generara una respuesta incorrecta o incoherente.

En el diagrama anterior se puede ver cómo algunas preguntas empujan al LLM a generar una respuesta confabulada (inexacta, alucinatoria). Por ejemplo, genera un día y un mes de nacimiento para las preguntas de la parte inferior del diagrama cuando la información necesaria para responderlas no se facilitó en la información inicial.

Implicaciones de la detección de alucinaciones

Este trabajo puede ayudar a explicar las alucinaciones y hacer que los LLM sean más fiables y dignos de confianza.

La entropía semántica, que permite detectar cuándo un LLM es incierto o propenso a la alucinación, allana el camino para desplegar estas herramientas de IA en dominios de alto riesgo en los que la precisión de los hechos es fundamental, como la sanidad, el derecho y las finanzas.

Los resultados erróneos pueden tener repercusiones potencialmente catastróficas cuando influyen en situaciones de alto riesgo, como demuestran algunos fracaso de la policía predictiva y sistemas sanitarios.

Sin embargo, también es importante recordar que las alucinaciones son sólo un tipo de error que pueden cometer los LLM.

Como explica el Dr. Farquhar, "si un LLM comete errores sistemáticos, este nuevo método no lo detectará. Los fallos más peligrosos de la IA se producen cuando un sistema hace algo mal pero es confiado y sistemático. Aún queda mucho trabajo por hacer".

No obstante, el método de entropía semántica del equipo de Oxford representa un gran paso adelante en nuestra capacidad para comprender y mitigar las limitaciones de los modelos lingüísticos de la IA.

Proporcionar un medio objetivo para detectarlos nos acerca a un futuro en el que podamos aprovechar el potencial de la IA y, al mismo tiempo, garantizar que siga siendo una herramienta fiable y digna de confianza al servicio de la humanidad.