La era de la IA presenta una compleja interacción entre la tecnología y las actitudes sociales.

La creciente sofisticación de los sistemas de IA está desdibujando las líneas que separan a los humanos de las máquinas: ¿está la tecnología de IA separada de nosotros mismos? ¿Hasta qué punto la IA hereda los defectos y carencias humanos junto con las habilidades y los conocimientos?

Quizá resulte tentador imaginar la IA como una tecnología empírica, subrayada por la objetividad de las matemáticas, el código y los cálculos.

Sin embargo, nos hemos dado cuenta de que las decisiones que toman los sistemas de IA son muy subjetivas y se basan en los datos a los que están expuestos, y los humanos deciden cómo seleccionar y ensamblar estos datos.

Ahí radica el reto, ya que los datos de entrenamiento de la IA a menudo encarnan los prejuicios y la discriminación contra los que lucha la humanidad.

Incluso formas aparentemente sutiles de sesgo inconsciente pueden verse magnificadas por el proceso de entrenamiento de modelos, revelándose finalmente en forma de coincidencias faciales incorrectas en entornos policiales, denegación de créditos, diagnósticos erróneos de enfermedades y mecanismos de seguridad deteriorados para vehículos de conducción autónoma, entre otras cosas.

Los intentos de la humanidad por evitar la discriminación en toda la sociedad siguen siendo un trabajo en curso, pero la IA está impulsando la toma de decisiones críticas en estos momentos.

¿Podemos trabajar lo suficientemente rápido para sincronizar la IA con los valores modernos y evitar decisiones y comportamientos sesgados que cambien la vida?

Desentrañar los prejuicios en la IA

En la última década, los sistemas de IA han demostrado reflejar los prejuicios sociales.

Estos sistemas no son inherentemente parciales, sino que absorben los sesgos de sus creadores y de los datos con los que se entrenan.

Los sistemas de IA, como los humanos, aprenden por exposición. El cerebro humano es un índice aparentemente infinito de información, una biblioteca con estanterías casi ilimitadas donde almacenamos experiencias, conocimientos y recuerdos.

Neurociencia estudios demuestran que el cerebro no tiene realmente una "capacidad máxima" y sigue clasificando y almacenando información hasta bien entrada la vejez.

Aunque dista mucho de ser perfecto, el proceso de aprendizaje progresivo e iterativo del cerebro nos ayuda a adaptarnos a nuevos valores culturales y sociales, desde permitir el voto femenino y aceptar identidades diversas hasta acabar con la esclavitud y otras formas de prejuicio consciente.

Wivimos en una época en la que se utilizan herramientas de IA para la toma de decisiones críticas en lugar del juicio humano.

Muchos modelos de aprendizaje automático (ML) aprenden de los datos de entrenamiento que constituyen la base de su toma de decisiones y no pueden inducir nueva información con la misma eficacia que el cerebro humano. Por eso, a menudo no producen las decisiones actualizadas y al minuto de las que dependemos.

Por ejemplo, los modelos de IA se utilizan para identificar coincidencias faciales con fines policiales, analizar currículos para solicitudes de empleoy tomar decisiones críticas para la salud en entornos clínicos.

A medida que la sociedad sigue integrando la IA en nuestra vida cotidiana, debemos asegurarnos de que sea igualitaria y precisa para todos.

Actualmente no es así.

Estudios de caso sobre el sesgo de la IA

Existen numerosos ejemplos reales de prejuicios y discriminación relacionados con la IA.

En algunos casos, las consecuencias de los prejuicios de la IA cambian la vida, mientras que en otros permanecen en un segundo plano, influyendo sutilmente en las decisiones.

1. Sesgo del conjunto de datos del MIT

Un conjunto de datos de entrenamiento del MIT creado en 2008 llamado Imágenes diminutas contenía aproximadamente 80.000.000 de imágenes repartidas en unas 75.000 categorías.

Inicialmente se concibió para enseñar a los sistemas de IA a reconocer personas y objetos dentro de imágenes y se convirtió en un popular conjunto de datos de referencia para diversas aplicaciones en visión por ordenador (CV).

A 2020 análisis de The Register encontró que muchos Tiny Images contenía etiquetas obscenas, racistas y sexistas.

Antonio Torralba, del MIT, dijo que el laboratorio no estaba al tanto de estas etiquetas ofensivas, y declaró a The Register: "Está claro que deberíamos haberlas examinado manualmente". El MIT emitió más tarde un comunicado para decir que habían retirado el conjunto de datos del servicio.

No es la única vez que un antiguo conjunto de datos de referencia ha resultado estar plagado de problemas. Labeled Faces in the Wild (LFW), un conjunto de datos de rostros de famosos muy utilizado en tareas de reconocimiento facial, consta de 77,5% de hombres y 83,5% de personas de piel blanca.

Muchos de estos veteranos conjuntos de datos se han incorporado a los modelos modernos de IA, pero proceden de una era de desarrollo de la IA en la que el objetivo era crear sistemas que sólo trabajo en lugar de las adecuadas para su despliegue en escenarios del mundo real.

Una vez que un sistema de IA se ha entrenado con un conjunto de datos de este tipo, no tiene necesariamente el mismo privilegio que el cerebro humano a la hora de recalibrarse a los valores contemporáneos.

Aunque los modelos pueden actualizarse iterativamente, es un proceso lento e imperfecto que no puede igualar el ritmo del desarrollo humano.

2: Reconocimiento de imágenes: prejuicios contra las personas de piel más oscura

En 2019, el El Gobierno de EE.UU. descubrió que los sistemas de reconocimiento facial de alto rendimiento identifican erróneamente a los negros entre 5 y 10 veces más que a los blancos.

No se trata de una mera anomalía estadística: tiene graves implicaciones en el mundo real, desde que Google Photos identifique a personas negras como gorilas hasta que los coches autoconducidos no reconozcan a las personas de piel más oscura y las atropellen.

Además, se produjo una oleada de detenciones y encarcelamientos injustos relacionados con falsas coincidencias faciales, quizás de forma más prolífica Nijeer Parks que fue acusado falsamente de hurto en una tienda y de infracciones de tráfico, a pesar de encontrarse a 30 millas del incidente. Posteriormente, Parks pasó 10 días en la cárcel y tuvo que desembolsar miles de euros en honorarios de abogados.

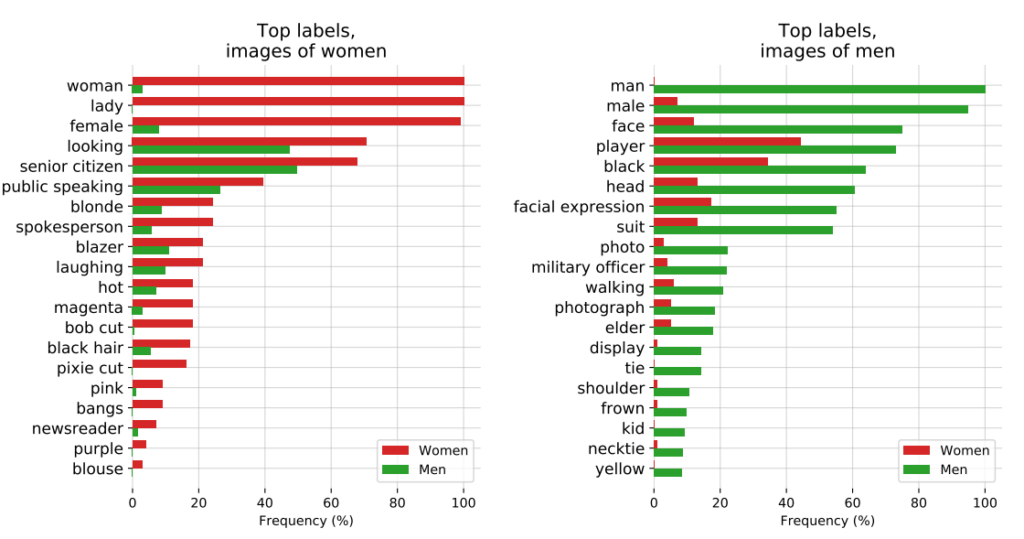

El influyente estudio de 2018, Matices de géneroEl estudio de la OCDE sobre el sesgo algorítmico. En el estudio se analizaron algoritmos creados por IBM y Microsoft y se observó una escasa precisión cuando se exponían a mujeres de piel más oscura, con tasas de error hasta 34% superiores a las de los hombres de piel más clara.

Este patrón es el mismo en 189 algoritmos diferentes.

El siguiente vídeo de Joy Buolamwini, investigadora principal del estudio, ofrece una excelente guía sobre cómo varía el rendimiento del reconocimiento facial en función del color de la piel.

3: Proyecto CLIP de OpenAI

OpenAI Proyecto CLIPpublicado en 2021, diseñado para emparejar imágenes con textos descriptivos, también ilustra los problemas de parcialidad que se plantean en la actualidad.

En un documento de auditoría, los creadores de CLIP pusieron de manifiesto sus preocupaciones: "CLIP asignó algunas etiquetas que describían ocupaciones de alto estatus con una frecuencia desproporcionada a los hombres, como 'ejecutivo' y 'médico'. Esto es similar a los sesgos encontrados en Google Cloud Vision (GCV) y apunta a diferencias históricas de género".

4: Aplicación de la ley: la polémica PredPol

Otro ejemplo de sesgo algorítmico de alto riesgo es PredPolun algoritmo policial predictivo utilizado por varios departamentos de policía de Estados Unidos.

PredPol se entrenó con datos históricos de delincuencia para predecir futuros focos delictivos.

Sin embargo, dado que estos datos reflejan intrínsecamente prácticas policiales sesgadas, el algoritmo ha sido criticado por perpetuar la elaboración de perfiles raciales y atacar de forma desproporcionada a los barrios minoritarios.

5: Prejuicios en la IA dermatológica

En la atención sanitaria, los riesgos potenciales de los prejuicios de la IA son aún mayores.

Tomemos el ejemplo de los sistemas de IA diseñados para detectar el cáncer de piel. Muchos de estos sistemas se entrenan con conjuntos de datos compuestos mayoritariamente por personas de piel clara.

A 2021 estudio de la Universidad de Oxford investigaron 21 conjuntos de datos de libre acceso en busca de imágenes de cáncer de piel. Descubrieron que de los 14 conjuntos de datos que revelaban su origen geográfico, 11 solo contenían imágenes de Europa, Norteamérica y Oceanía.

Sólo 2.436 de las 106.950 imágenes de las 21 bases de datos contenían información sobre el tipo de piel. Los investigadores observaron que "solo 10 imágenes eran de personas registradas como de piel morena y una era de un individuo registrado como de piel morena oscura o negra".

En cuanto a los datos sobre etnia, sólo 1.585 imágenes proporcionaban esta información. Los investigadores descubrieron que "ninguna imagen era de individuos de origen africano, afrocaribeño o del sur de Asia".

Concluyeron: "Junto con los orígenes geográficos de los conjuntos de datos, había una infrarrepresentación masiva de imágenes de lesiones cutáneas de poblaciones de piel más oscura".

Si estas IA se implantan en entornos clínicos, los conjuntos de datos sesgados crean un riesgo muy real de diagnóstico erróneo.

Diseccionando el sesgo en los conjuntos de datos de entrenamiento de IA: ¿producto de sus creadores?

Los datos de entrenamiento -más comúnmente texto, voz, imagen y vídeo- proporcionan a un modelo de aprendizaje automático (ML) supervisado una base para el aprendizaje de conceptos.

Al principio, los sistemas de IA no son más que lienzos en blanco. Aprenden y forman asociaciones a partir de nuestros datos, pintando esencialmente una imagen del mundo tal y como la representan sus conjuntos de datos de entrenamiento.

Al aprender de los datos de entrenamiento, se espera que el modelo aplique los conceptos aprendidos a nuevos datos no vistos.

Una vez implantados, algunos modelos avanzados pueden aprender de nuevos datos, pero sus datos de entrenamiento siguen dirigiendo su rendimiento fundamental.

La primera pregunta que hay que responder es: ¿de dónde proceden los datos? Los datos recogidos de fuentes no representativas, a menudo homogéneas e históricamente desiguales son problemáticos.

Es probable que esto se aplique a una cantidad significativa de datos en línea, incluidos datos de texto e imágenes extraídos de fuentes "abiertas" o "públicas".

Concebido hace sólo unas décadas, Internet no es la panacea del conocimiento humano y dista mucho de ser equitativo. La mitad del mundo no utiliza Internet, y mucho menos contribuye a ella, lo que significa que no es representativa de la sociedad y la cultura mundiales.

Además, aunque los desarrolladores de IA trabajan constantemente para garantizar que los beneficios de la tecnología no se limiten al mundo angloparlante, la mayoría de los datos de formación (texto y voz) se producen en inglés, lo que significa que los colaboradores angloparlantes dirigen los resultados del modelo.

Los investigadores de Anthropic publicó un documento sobre este mismo tema, concluyendo: "Si un modelo lingüístico representa desproporcionadamente ciertas opiniones, corre el riesgo de imponer efectos potencialmente indeseables, como promover visiones hegemónicas del mundo y homogeneizar las perspectivas y creencias de la gente".

En última instancia, aunque los sistemas de IA funcionan sobre la base de los principios "objetivos" de las matemáticas y la programación, no dejan de existir en un contexto social humano profundamente subjetivo y están moldeados por él.

Posibles soluciones al sesgo algorítmico

Si el problema fundamental son los datos, la solución para crear modelos equitativos podría parecer sencilla: basta con equilibrar los conjuntos de datos, ¿no?

No del todo. A Estudio 2019 demostró que equilibrar los conjuntos de datos es insuficiente, ya que los algoritmos siguen actuando de forma desproporcionada en función de características protegidas como el sexo y la raza.

Los autores escriben: "Sorprendentemente, mostramos que incluso cuando los conjuntos de datos están equilibrados de tal manera que cada etiqueta co-ocurre por igual con cada género, los modelos aprendidos amplifican la asociación entre etiquetas y género, ¡tanto como si los datos no hubieran sido equilibrados!"

Proponen una técnica de eliminación del sesgo en la que esas etiquetas se eliminan por completo del conjunto de datos. Otras técnicas consisten en añadir perturbaciones y distorsiones aleatorias, que reducen la atención del algoritmo a determinadas características protegidas.

Además, aunque la modificación de los métodos de entrenamiento y optimización del aprendizaje automático es intrínseca a la producción de resultados no sesgados, los modelos avanzados son susceptibles de cambio o "deriva", lo que significa que su rendimiento no necesariamente se mantiene constante a largo plazo.

Un modelo puede ser totalmente insesgado en el momento de su despliegue, pero más tarde volverse sesgado con una mayor exposición a nuevos datos.

El movimiento por la transparencia algorítmica

En su provocador libro Desinteligencia artificial: Cómo los ordenadores malinterpretan el mundoMeredith Broussard aboga por una mayor "transparencia algorítmica" para exponer los sistemas de IA a múltiples niveles de escrutinio continuo.

Esto significa proporcionar información clara sobre cómo funciona el sistema, cómo se ha entrenado y con qué datos.

Mientras que las iniciativas de transparencia se integran fácilmente en el panorama de la IA de código abierto, los modelos patentados como GPT, Bard y Claude de Anthropic son "cajas negras" y sólo sus desarrolladores saben exactamente cómo funcionan, e incluso eso es objeto de debate.

El problema de la "caja negra" en la IA significa que los observadores externos sólo ven lo que entra en el modelo (entradas) y lo que sale (salidas). Los mecanismos internos son completamente desconocidos, salvo para sus creadores, de forma parecida a como el Círculo Mágico oculta los secretos de los magos. La IA se limita a sacar el conejo de la chistera.

La cuestión de la caja negra cristalizó recientemente en torno a los informes de La posible disminución del rendimiento de GPT-4. Los usuarios de GPT-4 argumentan que las capacidades del modelo han disminuido rápidamente, y aunque OpenAI reconoce que esto es cierto, no han sido absolutamente claros en cuanto a por qué está sucediendo. Eso plantea la pregunta: ¿lo saben siquiera?

El Dr. Sasha Luccioni, investigador de IA, afirma que la falta de transparencia de OpenAI es un problema que también afecta a otros desarrolladores de modelos de IA propietarios o cerrados. "Cualquier resultado sobre modelos de código cerrado no es reproducible ni verificable y, por tanto, desde una perspectiva científica, estamos comparando mapaches y ardillas".

“No corresponde a los científicos supervisar continuamente los LLM desplegados. Corresponde a los creadores de modelos dar acceso a los modelos subyacentes, al menos con fines de auditoría", afirmó.

Luccioni insistió en que los desarrolladores de modelos de IA deben proporcionar resultados brutos de pruebas estándar como SuperGLUE y WikiText y pruebas de sesgo como BOLD y HONEST.

Es probable que la lucha contra los prejuicios y sesgos generados por la IA sea constante y requiera una atención e investigación constantes para mantener bajo control los resultados de los modelos a medida que la IA y la sociedad evolucionan juntas.

Aunque la regulación impondrá formas de supervisión e información, hay pocas soluciones duras y rápidas a la cuestión del sesgo algorítmico, y no será la última vez que oigamos hablar de ello.