Una investigación de The Guardian ha arrojado luz sobre el uso generalizado en el Reino Unido de IA y algoritmos complejos en diversos procesos de toma de decisiones del sector público.

Funcionarios de al menos ocho departamentos del sector público, junto con varias unidades policiales, han incorporado herramientas de IA a sus flujos de trabajo.

Las herramientas de IA han ayudado en procesos cruciales de toma de decisiones en los ámbitos de la asistencia social, la inmigración y la justicia penal. La investigación reveló indicios de abuso y discriminación.

Aunque el sesgo algorítmico y el relacionado con la IA no entran estrictamente en la misma definición, ambos corren el riesgo de obtener resultados sesgados cuando se exponen a situaciones del mundo real. Los modelos de aprendizaje automático pueden magnificar los sesgos predominantes en los conjuntos de datos.

Según la informe:

- Un parlamentario ha expresado su preocupación por un algoritmo empleado por el Departamento de Trabajo y Pensiones (DWP), que se sospecha ha provocado incorrectamente que numerosas personas perdieran sus prestaciones.

- Se ha descubierto que la herramienta de reconocimiento facial de la Policía Metropolitana tiene un porcentaje de error más elevado a la hora de identificar rostros negros que blancos en determinadas condiciones. Se trata de un hecho probado, con un estudio indicando que estas plataformas ofrecían una precisión de unos míseros 2% en 2018.

- El Ministerio del Interior ha estado utilizando un algoritmo que señala de forma desproporcionada a personas de determinadas nacionalidades para descubrir matrimonios fraudulentos a efectos de prestaciones y desgravaciones fiscales. Los ciudadanos de Albania, Grecia, Rumanía y Bulgaria pueden haber sido señalados injustamente.

Las herramientas de IA aprenden patrones a partir de amplios conjuntos de datos. Si los conjuntos de datos son sesgados o poco representativos de la realidad, el modelo hereda esos patrones.

Hay muchos ejemplos internacionales de sesgos relacionados con la IA y los algoritmos, como las falsas coincidencias de reconocimiento facial que conducen al encarcelamiento, los sistemas de puntuación crediticia infligir prejuicios a las mujeresy las herramientas discriminatorias utilizadas en los tribunales y los sistemas sanitarios.

El informe de The Guardian sostiene que el Reino Unido se encuentra ahora al borde de un posible escándalo, ya que los expertos expresan su preocupación por la transparencia y la comprensión de los algoritmos utilizados por los funcionarios.

Los escándalos ya en otros paísescomo en Estados Unidos, donde se han desmantelado las plataformas policiales predictivasy en los Países Bajos, donde los tribunales se opusieron a un sistema de IA diseñado para frenar el fraude en la asistencia social.

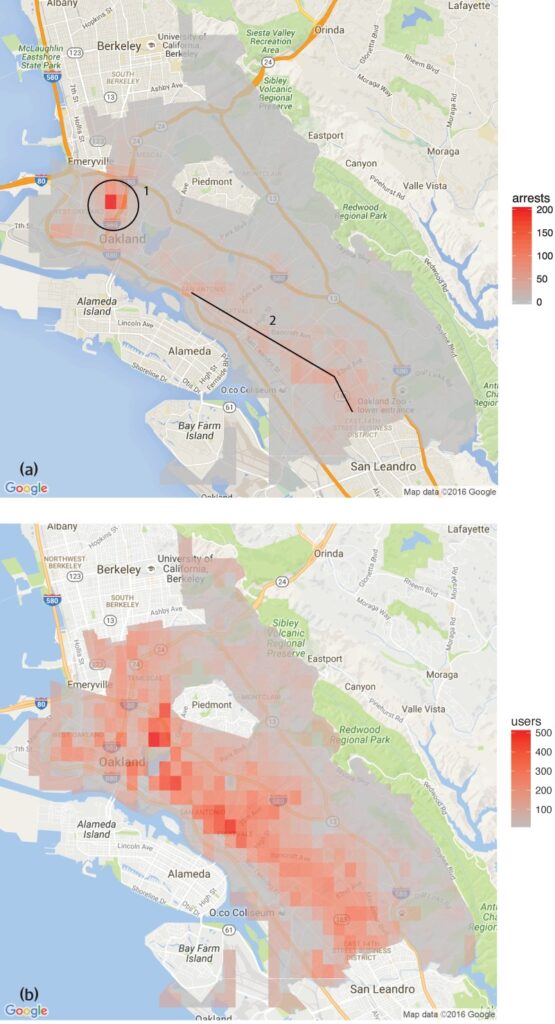

Un estudio realizado por la Grupo de Análisis de Datos sobre Derechos Humanos descubrió que el software de predicción policial utilizado en Oakland (California) se dirigía de forma desproporcionada a las comunidades de color, perpetuando un ciclo de exceso de vigilancia en estos barrios.

Esto refleja las preocupaciones planteadas por la Herramienta de reconocimiento facial de la Policía Metropolitanaque demostraron tasas de error más elevadas al identificar rostros negros en determinadas condiciones.

También hay varios ejemplos en la sanidad, como las incoherencias en los modelos de IA diseñados para ayudar a detectar el cáncer de piel. En la mayoría de los casos, los grupos minoritarios y las mujeres son los más expuestos.

Shameem Ahmad, Director Ejecutivo del Proyecto de Derecho Público, subrayó la necesidad de actuar de inmediato: "La IA tiene un enorme potencial para el bien social. Por ejemplo, podemos hacer que las cosas sean más eficientes. Pero no podemos ignorar los graves riesgos. Si no actuamos con urgencia, podríamos llegar como sonámbulos a una situación en la que sistemas automatizados opacos se utilicen de forma habitual, y posiblemente ilegal, para alterar vidas, y en la que las personas no puedan obtener reparación cuando esos procesos vayan mal."

Haciéndose eco de estas preocupaciones, Marion Oswald, profesora de Derecho de la Universidad de Northumbria, ha destacado las incoherencias y la falta de transparencia en el uso de la IA en el sector público, afirmando: "Hay una falta de coherencia y transparencia en la forma en que se está utilizando la IA en el sector público. Muchas de estas herramientas afectarán a muchas personas en su vida cotidiana, por ejemplo a quienes solicitan prestaciones, pero la gente no entiende por qué se están utilizando y no tiene la oportunidad de cuestionarlas."

Riesgos de la IA para el sector público

La aplicación incontrolada de la IA en los departamentos gubernamentales y las fuerzas policiales plantea problemas de responsabilidad, transparencia y parcialidad.

En el caso del Departamento de Trabajo y Pensiones (DWP), el informe de The Guardian desveló casos en los que un algoritmo suspendió las prestaciones de los ciudadanos sin una explicación clara.

La diputada Kate Osamor dijo que sus electores búlgaros perdieron sus prestaciones debido a un sistema semiautomatizado que señalaba sus casos como posibles fraudes, lo que pone de manifiesto la falta de transparencia.

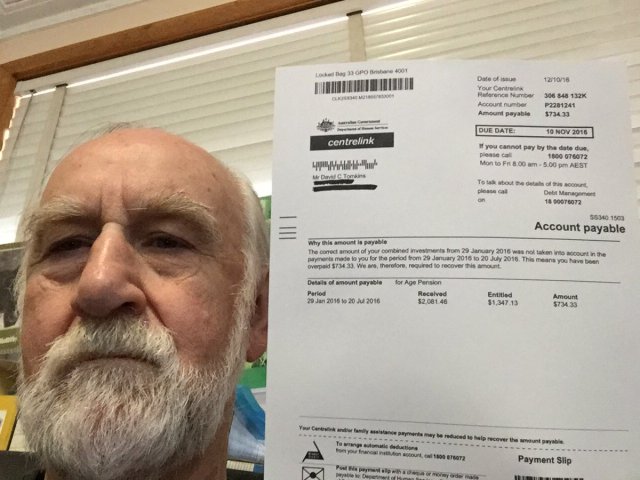

Esto recuerda a la Escándalo "Robodebt" en Australiadonde un sistema automatizado acusó erróneamente a más de 400.000 personas de fraude a la seguridad social, lo que provocó una situación de penuria generalizada.

El escándalo Robodebt, objeto de investigaciones por parte del Defensor del Pueblo de la Commonwealth, recursos legales e investigaciones públicas, demostró la magnitud del impacto infligido por la toma de decisiones algorítmica.

El Gobierno australiano acordó una cifra de liquidación de 1.400 millones de dólares australianos en 2021.

Las deficiencias de la IA no se limitan a los servicios públicos. El mundo empresarial también ha sido testigo de fallos, sobre todo en las herramientas de contratación basadas en IA.

Un ejemplo notable es la herramienta de contratación de Amazon, que mostraba un sesgo en contra de las candidatas. El sistema se entrenó a partir de currículos enviados a la empresa durante un periodo de 10 años, la mayoría de los cuales procedían de hombres, lo que hizo que la IA favoreciera a los candidatos masculinos.

Tres ejemplos de sesgo algorítmico de los que hay que desconfiar

A medida que la IA y la toma de decisiones algorítmica se integran en procesos sociales complejos, aumentan los ejemplos alarmantes de parcialidad y discriminación.

El sistema sanitario y judicial estadounidense

Un estudio de 2019 publicado en Science reveló que un algoritmo sanitario muy utilizado en EE.UU. presentaba sesgos raciales. El algoritmo tenía menos probabilidades de derivar a personas negras a programas diseñados para mejorar la atención a pacientes con necesidades médicas complejas que a sus homólogos blancos.

El estudio explica por qué: "El sesgo se produce porque el algoritmo utiliza los costes sanitarios como indicador de las necesidades de salud. Se gasta menos dinero en pacientes negros que tienen el mismo nivel de necesidad, por lo que el algoritmo concluye falsamente que los pacientes negros están más sanos que los pacientes blancos igualmente enfermos."

Otro ejemplo crítico es el uso de la IA en la vigilancia policial predictiva y las sentencias judiciales. Herramientas como Perfil de gestión de delincuentes correccionales para penas alternativas (COMPAS) se han utilizado para evaluar el riesgo de reincidencia de los acusados.

Las investigaciones han revelado que estas herramientas pueden ser parciales contra los acusados afroamericanos, asignándoles puntuaciones de riesgo más altas que a sus homólogos blancos. Esto suscita dudas sobre la equidad e imparcialidad de la toma de decisiones judiciales asistida por IA.

Reconocimiento facial en Brasil

En Proyecto Smart Sampa en São PauloEl evento, que se celebró en el Palacio de Congresos de São Paulo (Brasil), marcó un hito importante en la integración de la IA y la vigilancia en los paisajes urbanos, algo que hasta ahora sólo era típico en China.

Para 2024, pretende instalar hasta 20.000 cámaras en São Paulo e integrar el mismo número de cámaras de terceros y privadas en una única plataforma de videovigilancia. Esta red supervisará espacios públicos, instalaciones médicas y escuelas, y analizará el contenido de las redes sociales de interés para la administración pública.

Aunque Smart Sampa promete más seguridad y mejores servicios públicos, los expertos advierten de que podría exacerbar los problemas sociales existentes, en particular el racismo estructural y la desigualdad.

Más del 90% de las personas detenidas en Brasil por reconocimiento facial son negras. La iniciativa de São Paulo corre el riesgo de perpetuar esta tendencia, marginando aún más a la comunidad negra, que constituye 56% de la población de Brasil.

Las tecnologías de reconocimiento facial suelen identificar erróneamente los tonos de piel más oscuros, en parte porque la tecnología de obtención de imágenes rinde menos con las complexiones más oscuras y en parte porque los conjuntos de datos de entrenamiento no son representativos.

Fernanda Rodrigues, abogada especializada en derechos digitales, hizo hincapié en la posibilidad de falsos positivos y el consiguiente riesgo de encarcelamiento masivo de personas de raza negra.

Según Rodrigues, "además de los riesgos de que la información suministrada a estas plataformas no sea exacta y de que el propio sistema falle, hay un problema que precede a las implicaciones tecnológicas, que es el racismo".

"Sabemos que el sistema penal en Brasil es selectivo, por lo que podemos concluir que [el uso de la vigilancia con reconocimiento facial] consiste en aumentar los riesgos y daños para esta población", añadió.

La preocupación por la privacidad también es primordial. Los críticos sostienen que Smart Sampa podría vulnerar derechos humanos fundamentales, como la intimidad y la libertad de expresión, reunión y asociación. La opacidad del proyecto complica aún más las cosas, con una participación pública limitada durante la fase de consulta.

Smart Sampa no ha quedado impune. Los fiscales han investigado y las organizaciones de derechos humanos han emprendido acciones legales para detener la tecnología.

La Indicación de Riesgo del Sistema (SyRI) holandesa

En 2022, el Tribunal de Distrito de La Haya examinó el empleo por parte del Gobierno neerlandés de Indicación de riesgo del sistema (SyRI)un algoritmo diseñado para detectar posibles fraudes a la seguridad social.

SyRI pretendía mejorar la eficacia de la identificación del fraude en la asistencia social agregando datos de diversas bases de datos gubernamentales y aplicando indicadores de riesgo para generar perfiles de posibles defraudadores. Sin embargo, las decisiones sospechosas y la falta de transparencia hicieron saltar las alarmas, lo que llevó a una coalición de organizaciones de la sociedad civil a presentar un recurso judicial.

Los demandantes alegaron que SyRI infringía diversas leyes internacionales y europeas de derechos humanos. También cuestionaron la legalidad, necesidad y proporcionalidad de la aplicación del algoritmo.

El Tribunal de Distrito de La Haya dictaminó que la legislación que regula la SyRI y su aplicación no cumplía las normas de derechos humanos necesarias. El tribunal destacó la falta de transparencia y la posibilidad de efectos discriminatorios, subrayando la necesidad de salvaguardias legales adecuadas a la hora de implantar este tipo de tecnologías.

El caso ha sido aclamado como uno de los primeros en abordar el impacto de la IA en los derechos humanos en el sector público, poniendo de relieve la necesidad de transparencia, rendición de cuentas y marcos jurídicos sólidos.

Es primordial que las pruebas de las herramientas sean transparentes y justas

A raíz de los recientes desafíos legales y el escrutinio público en torno a la toma de decisiones algorítmicas en las operaciones gubernamentales, la petición de pruebas transparentes de las herramientas de IA se ha vuelto cada vez más urgente.

Garantizar la rendición de cuentas, evitar la discriminación y mantener la confianza de los ciudadanos depende de la aplicación de protocolos de ensayo rigurosos y abiertos.

La realización de pruebas transparentes permite comprender a fondo el funcionamiento de estos algoritmos, los datos que utilizan y los procesos de toma de decisiones que siguen. Esto es crucial para identificar posibles sesgos, imprecisiones o prácticas discriminatorias integradas en el sistema.

Sin embargo, los rigurosos procedimientos de ensayo están reñidos con la promesa de eficacia rápida de la IA.

En el caso del Reino Unido, el Primer Ministro Rishi Sunak stancQuizás no haya espacio suficiente para procedimientos de prueba exhaustivos. Además, hay pocos procesos acordados -si es que existe alguno- para probar las herramientas de IA antes de distribuirlas para uso público.

Esta situación se repite en todo el mundo. El rápido aumento de la adopción de la IA no debe ir en detrimento del escrutinio y el análisis.