La forma exacta en que nuestro cerebro procesa y formula el lenguaje sigue siendo en gran medida un misterio. Los investigadores de Meta AI han descubierto una nueva forma de medir las ondas cerebrales y descodificar las palabras asociadas a ellas.

A las personas con graves limitaciones motoras, como los enfermos de ELA, les resulta especialmente difícil comunicarse. Es difícil imaginar la frustración de una persona como Stephen Hawking construyendo una frase con movimientos oculares o moviendo un músculo de la mejilla.

Se ha investigado mucho para descodificar el habla a partir de la actividad cerebralpero los mejores resultados dependen de la invasión implantes cerebro-ordenador.

Los investigadores de Meta AI utilizaron magnetoencefalografía (MEG) y electroencefalografía (EEG) para registrar las ondas cerebrales de 175 voluntarios mientras escuchaban historias cortas y frases aisladas.

Utilizaron un modelo de habla preentrenado y aprendizaje contrastivo para identificar qué patrones de ondas cerebrales se asociaban a palabras concretas que escuchaban los sujetos.

Descodificación de la percepción del habla a partir de grabaciones cerebrales no invasivas",

dirigidos por el único @honualx

acaba de salir en el último número de Nature Machine Intelligence:- documento de libre acceso: https://t.co/1jtpTezQzM

- código de formación completo: https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Jean-Rémi King (@JeanRemiKing) 5 de octubre de 2023

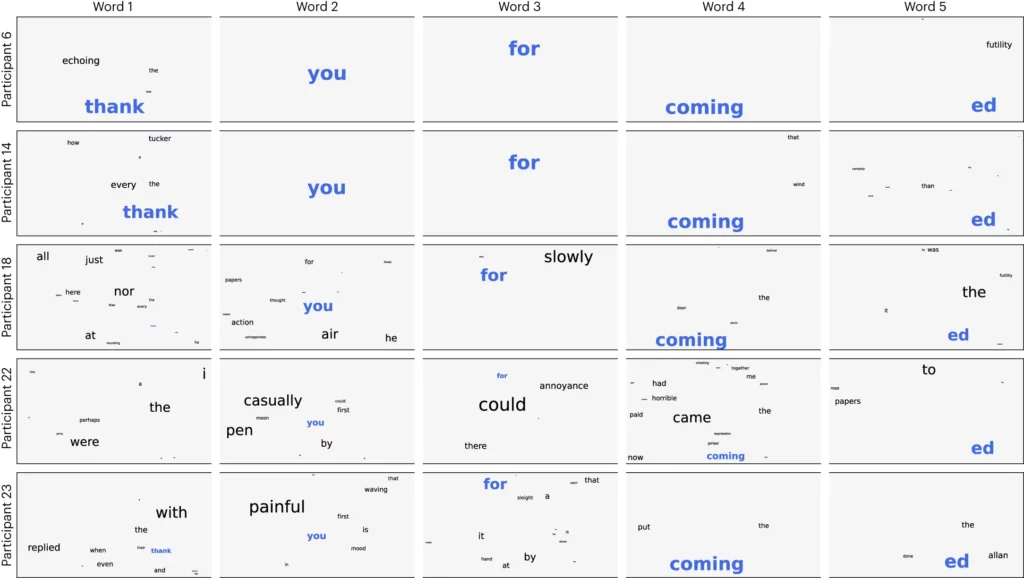

Los investigadores dividieron el audio en segmentos de 3 segundos y probaron su modelo para ver si podía identificar correctamente cuál de los 1.500 segmentos estaba escuchando el voluntario. El modelo predijo una especie de nube de palabras en la que la palabra más probable tenía más peso.

Lograron una precisión media de 41% y una precisión de 95,9% con sus mejores participantes.

La investigación demuestra que es posible hacerse una idea bastante aproximada del habla que oye una persona, pero ahora hay que invertir el proceso para que sea útil. Tenemos que medir sus ondas cerebrales y saber en qué palabra están pensando.

El artículo sugiere entrenar una red neuronal mientras los sujetos producen palabras hablando o escribiendo. Ese modelo general podría utilizarse entonces para dar sentido a las ondas cerebrales y las palabras asociadas en las que estuviera pensando un enfermo de ELA.

Los investigadores fueron capaces de identificar segmentos del habla a partir de un conjunto limitado predeterminado. Para una comunicación adecuada, sería necesario poder identificar muchas más palabras. Utilizar una IA generativa para predecir la siguiente palabra más probable que una persona está tratando de decir podría ayudar con eso.

Aunque el proceso no era invasivo, requería estar conectado a un Dispositivo MEG. Por desgracia, los resultados de las mediciones del EEG no fueron muy buenos.

La investigación promete que la IA podría llegar a utilizarse para ayudar a comunicarse a los que no tienen voz, como los enfermos de ELA. El uso de un modelo preentrenado también evitó la necesidad de un minucioso entrenamiento palabra por palabra.

Meta AI hizo públicos el modelo y los datos, por lo que es de esperar que otros investigadores se basen en su trabajo.