Puede que nuestros pensamientos sean nuestro santuario más íntimo, pero no están fuera de los límites de la IA.

La inteligencia artificial que lee la mente parece sacada de una novela de ciencia ficción, pero es muy prometedora para las personas que no pueden comunicarse debido a parálisis o lesiones cerebrales.

Más allá de eso, el acceso de la IA al cerebro nos permitiría escribir, crear y diseñar con meros pensamientos o proporcionar a otros ventanas a nuestra conciencia.

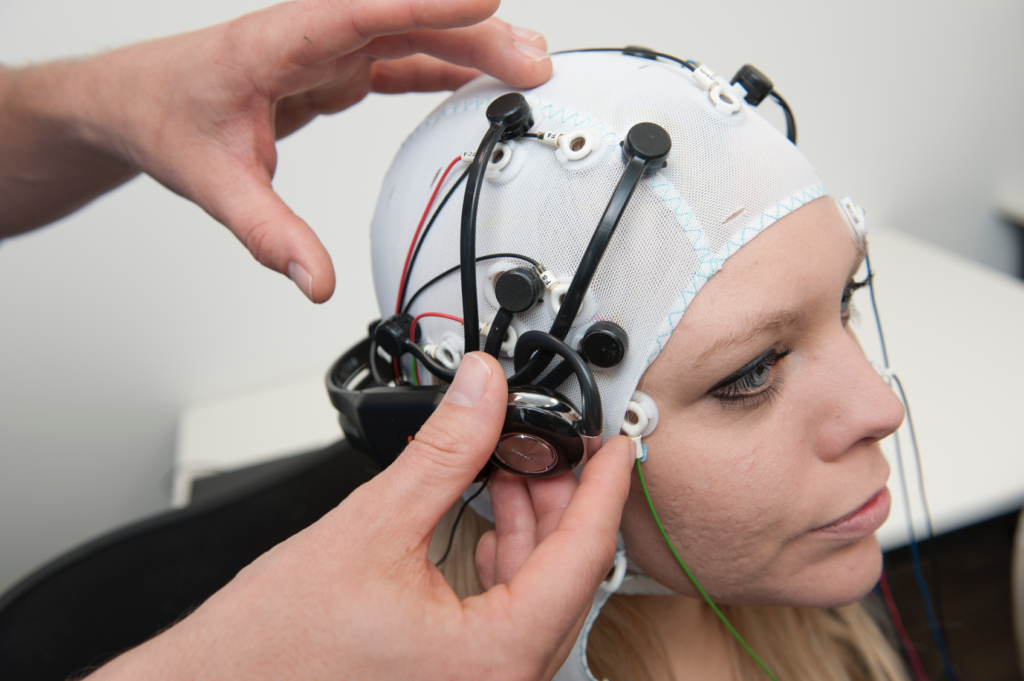

Desde hace casi una década, la tecnología del electroencefalograma (EEG), que capta señales eléctricas a través de electrodos en el cuero cabelludo, ayuda a quienes sufren accidentes cerebrovasculares graves y el síndrome de enclaustramiento total (CLIP), una afección en la que una persona está consciente pero inmóvil.

En 2014, un enfermo italiano de esclerosis lateral amiotrófica (ELA), Anselmo Paglialonga, utilizó una auriculares con aprendizaje automático integrado comunicarse mediante respuestas de sí o no a pesar de no poder mover ni un músculo. Algunos enfermos pueden mover pequeños músculos, como Stephen Hawking, que podía mover el músculo de la mejilla.

A medida que avanza la IA, los investigadores van salvando la distancia que separa la simple interpretación de señales de la traducción íntegra de pensamientos complejos.

Con el tiempo, las personas podrán hablar y comunicarse sin mover un músculo, literalmente a través del poder del pensamiento.

Esa misma tecnología podría permitirnos controlar máquinas complejas con el cerebro, componer música imaginando una melodía o pintar y dibujar conjurando imágenes con la mente. Incluso podríamos "grabar" nuestros sueños a partir de las ondas cerebrales y reproducirlos más tarde.

En un futuro no muy lejano, la IA que lee la mente podría utilizarse para leer a la fuerza los recuerdos de alguien, por ejemplo, para verificar su testimonio de un delito.

Los piratas informáticos podrían incluso engañarle brevemente para que imaginara su información personal mientras extraen una copia de sus pensamientos de su cerebro. Los regímenes totalitarios podrían realizar pruebas rutinarias a los ciudadanos para controlar los pensamientos divergentes.

Además, con la capacidad de convertir los pensamientos en una realidad informatizada, los humanos podrían pasarse la vida en un cajón de arena onírico donde moldear sus realidades a voluntad.

Ahora mismo, estas aplicaciones parecen surrealistas y fantásticas, pero varios experimentos recientes han sentado las bases para un futuro en el que el cerebro sea accesible a la IA.

Inteligencia artificial para leerte la mente

¿Cómo es posible todo esto?

Para traducir la actividad cerebral en un resultado utilizable que pueda pasarse a un ordenador, primero es necesario realizar mediciones precisas.

Ese es el primer obstáculo, ya que el cerebro es tan misterioso como los confines del espacio o los océanos más profundos. Hay poco consenso sobre cómo la actividad neuronal produce pensamientos complejos, por no hablar de la conciencia.

El cerebro humano -y, de hecho, otros sistemas nerviosos de la naturaleza- alberga miles de millones de neuronas, la mayoría de las cuales se disparan entre 5 y 100 veces por segundo. En el cerebro humano, cada segundo de pensamiento implica billones de neuronas. acciones neuronales individuales.

Medir la actividad neuronal a nivel granular es el santo grial de la neurociencia, pero ahora mismo no es posible, sobre todo con técnicas no invasivas.

Actualmente, las mediciones cerebrales son más holísticas, extraídas del movimiento de la sangre o de los intercambios de señales eléctricas. Existen tres métodos bien establecidos para medir la actividad cerebral:

- La magnetoencefalografía (MEG) capta los campos magnéticos generados por la actividad eléctrica cerebral y proporciona información sobre la actividad neuronal en tiempo real.

- Electroencefalografía (EEG) para la interpretación de la actividad eléctrica.

- IRM, que mide la actividad cerebral mediante mediciones del flujo sanguíneo.

El aprendizaje automático (ML) y la IA se han fusionado con las tres tecnologías para mejorar el análisis de señales intrincadas.

El objetivo final es asociar actividades cerebrales específicas con pensamientos distintos, que pueden incluir una palabra, una imagen o algo más semántico y abstracto.

Las tecnologías que pueden extraer mediciones del cerebro y pasarlas a los ordenadores se denominan interfaces cerebro-ordenador (BCI).

Este es el proceso básico de cómo funciona:

- Presentación del estímulo: Se expone a los participantes a diversos estímulos. Pueden ser imágenes, sonidos o incluso sensaciones táctiles. Durante esta exposición se registra su actividad cerebral, normalmente mediante EEG o resonancia magnética.

- Recogida de datos: Las respuestas del cerebro a estos estímulos se registran en tiempo real. Estos datos se convierten en una rica fuente de información sobre cómo afectan los distintos estímulos a la actividad cerebral.

- Preprocesamiento: Los datos cerebrales brutos suelen ser ruidosos. Antes de utilizarlos, hay que limpiarlos y normalizarlos. Esto puede implicar la eliminación de artefactos, la normalización de las señales o la alineación de los puntos de datos.

- Aprendizaje automático: Con los datos procesados, se introducen modelos de aprendizaje automático. Estos modelos se entrenan para encontrar patrones o correlaciones entre los datos cerebrales y el estímulo correspondiente. En esencia, la IA actúa como intérprete, descifrando el "lenguaje" del cerebro.

- Formación de modelos: Se trata de un proceso iterativo. Cuantos más datos reciba el modelo, mejor podrá predecir o generar resultados. Esta fase puede requerir mucho tiempo y potencia de cálculo.

- Validación: Una vez entrenado, se comprueba la precisión del modelo. Esto suele hacerse presentando nuevos estímulos a los participantes, registrando su actividad cerebral y, a continuación, utilizando el modelo para predecir o generar un resultado basado en estos nuevos datos.

- Retroalimentación y perfeccionamiento: Basándose en los resultados de la validación, los investigadores ajustan y perfeccionan el modelo, iterando hasta lograr la mayor precisión posible.

- Aplicación: Una vez validada, la aplicación se utiliza para el fin previsto, ya sea ayudar a comunicarse a una persona paralítica, generar imágenes a partir de pensamientos o cualquier otra aplicación.

Los métodos de IA han evolucionado rápidamente en los dos últimos años, permitiendo a los investigadores trabajar con datos cerebrales complejos y ruidosos para extraer pensamientos transitorios y convertirlos en algo con lo que pueda trabajar un ordenador.

Por ejemplo, un Proyecto 2022 de Meta utilizó datos de MEG y EEG de 169 personas para entrenar a una IA a reconocer palabras que oían de una lista predeterminada de 793 palabras. La IA pudo generar una lista de 10 palabras que contenía la palabra seleccionada el 73% de las veces, lo que demuestra que la IA puede "leer la mente", aunque con una precisión limitada.

En marzo de 2023, los investigadores desvelaron un revolucionario descodificador de IA para transformar la actividad cerebral en flujos textuales continuos.

La IA demostró una precisión asombrosa, convirtiendo en texto historias que la gente escuchaba o imaginaba utilizando datos de fMRI.

El Dr. Alexander Huth, de la Universidad de Texas en Austin, se mostró sorprendido por la eficacia del sistema: "Nos sorprendió que funcionara tan bien. Llevo 15 años trabajando en esto... así que fue chocante y emocionante cuando por fin funcionó".

El estudio integró grandes modelos lingüísticos (LLM), en concreto GPT-1, un antepasado de ChatGPT.

Los voluntarios se sometieron a sesiones de RMf de 16 horas mientras escuchaban podcasts. Estos datos se utilizaron para entrenar un modelo de aprendizaje automático.

Después, los participantes escuchaban o imaginaban nuevas historias, y la IA traducía su actividad cerebral a texto. Aproximadamente 50% de los resultados coincidían exactamente con el mensaje original. El Dr. Huth explicó: "Nuestro sistema funciona a nivel de ideas, semántica, significado... es lo esencial".

- Por ejemplo, la frase "Todavía no tengo el carné de conducir" se descodificó como "Todavía no ha empezado a aprender a conducir".

- Otro extracto: "No sabía si gritar, llorar o salir corriendo. En lugar de eso, dije: '¡Déjame en paz!'" se convirtió en "Empecé a gritar y a llorar, y entonces ella sólo dijo: 'Te dije que me dejaras en paz'".

El modelo también se aplicó a las ondas cerebrales generadas por participantes que veían películas mudas.

Cuando los participantes escuchaban una historia concreta, la interpretación de la IA reflejaba el sentimiento general de la historia. Si se perfecciona, esta tecnología podría permitirnos escribir historias utilizando solo los pensamientos.

¿Le cuesta arrancar una novela o un proyecto de escritura? Recuéstate e imagina cómo se desarrolla la historia. La IA la escribirá por ti.

Utilizar la IA para generar imágenes a partir del pensamiento

La IA puede convertir la actividad cerebral en palabras y conceptos semánticos, pero ¿y las imágenes o la música?

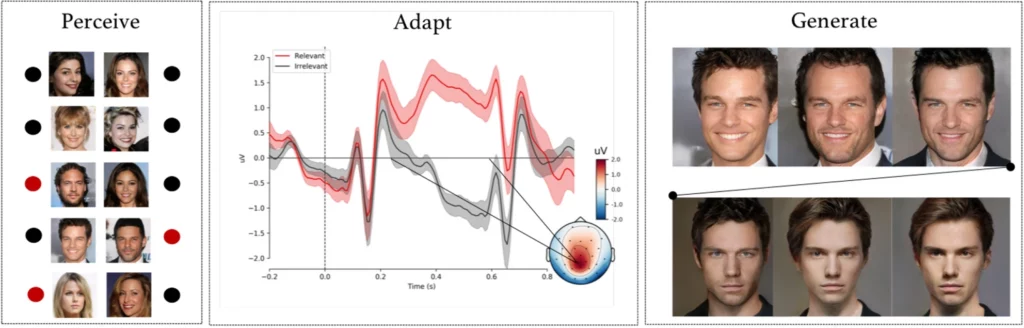

A experimento complejo realizado por investigadores de la Universidad de Helsinki (Finlandia), hizo que los sujetos observaran imágenes faciales generadas por IA mientras se registraban sus señales EEG.

Tras utilizar esos datos para entrenar un modelo de inteligencia artificial, se encargó a los participantes que identificaran caras concretas de una lista. Estas señales se convirtieron en una ventana a las percepciones e intenciones de los participantes.

El modelo de IA interpretó si el participante reconocía una cara determinada basándose en las señales de EEG registradas.

En la siguiente fase, las señales de EEG se utilizaron para adaptar y moldear una red generativa adversarial (GAN), un modelo utilizado en algunas IA generativas.

Esto permitió al sistema producir nuevas imágenes de rostros alineadas con la intención original del usuario.

Como señaló Michiel Spapé, coautor del estudio, "la técnica no reconoce pensamientos, sino que responde a las asociaciones que tenemos con categorías mentales".

En términos más sencillos, si alguien pensaba en un "rostro anciano", el sistema informático podía generar una imagen de una persona mayor que se ajustara al pensamiento del participante, todo ello gracias a la retroalimentación de sus señales cerebrales.

Dibujar con el poder del pensamiento

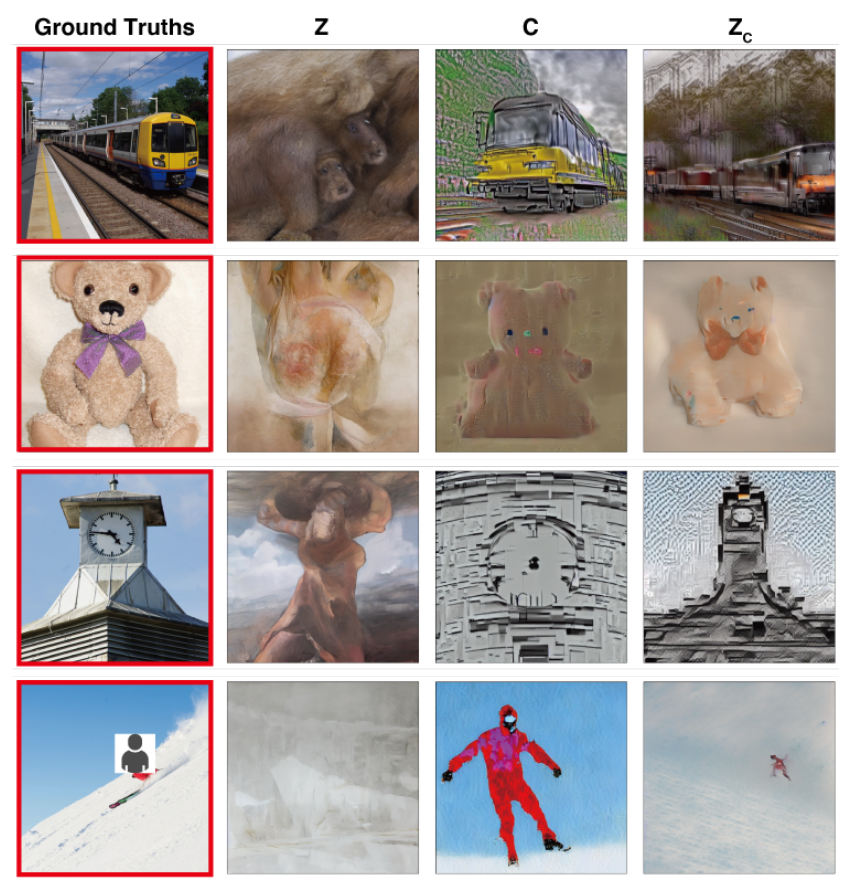

En un estudio con objetivos similares, científicos de la Universidad de Osaka (Japón) fueron pioneros en una técnica para traducir señales cerebrales complejas en imágenes de alta resolución con resultados notables.

El método utiliza un modelo de Difusión Estable, una forma especializada de red neuronal diseñada para la generación de imágenes. Stable Diffusion se desarrolló con la ayuda y financiación de Stability AI.

Los pensamientos se captan mediante IRMf y se pasan a un modelo de difusión estable, que los convierte en imágenes mediante un complejo proceso de varias etapas que implica varios niveles de refinamiento.

A diferencia de estudios anteriores, estos métodos requerían un ajuste mínimo del modelo. Sin embargo, seguía siendo necesario que los participantes pasaran muchas horas dentro de las máquinas de resonancia magnética.

Se trata de un reto fundamental, ya que la mayoría de estos experimentos implican mediciones rigurosas y un entrenamiento del modelo que lleva mucho tiempo, es caro y difícil de soportar para los participantes.

Sin embargo, en el futuro, no es inviable que la gente pueda entrenar sus propios modelos ligeros de lectura de la mente y utilizar sus pensamientos como entrada para diversos usos, como diseñar un edificio pensando en él o componer una pieza orquestal conjurando las melodías.

Traducir pensamientos en música mediante la IA

Palabras, imágenes, música... nada está fuera de los límites de la IA.

A 2023 estudiar proporciona información sobre la percepción del sonido, con un enorme potencial para el diseño de dispositivos de comunicación para personas con deficiencias del habla.

Robert Knight y su equipo de la Universidad de California, Berkeley, examinaron grabaciones cerebrales de electrodos colocados quirúrgicamente en 29 individuos con epilepsia.

Mientras estos participantes escuchaban "Another Brick in the Wall, Part 1" de Pink Floyd, el equipo correlacionó su actividad cerebral con elementos de la canción como el tono, la melodía, la armonía y el ritmo.

Con estos datos, los investigadores entrenaron un modelo de IA omitiendo a propósito un segmento de 15 segundos de la canción. A continuación, la IA intentó predecir este segmento omitido basándose en las señales cerebrales, logrando una similitud de espectrograma de 43% con el segmento de canción real.

Knight y su equipo señalaron el área de la circunvolución temporal superior del cerebro como esencial para procesar el ritmo de guitarra de la canción. También confirmaron hallazgos anteriores según los cuales el hemisferio derecho desempeña un papel más importante que el izquierdo en el procesamiento de la música.

Knight cree que este conocimiento más profundo de la interacción cerebro-música puede beneficiar a los dispositivos de ayuda a las personas con trastornos del habla, como la esclerosis lateral amiotrófica (ELA) y la afasia.

Para los enfermos de esclerosis lateral amiotrófica o afasia, que tienen dificultades para hablar, nos gustaría un dispositivo que sonara realmente como si te estuvieras comunicando con alguien de forma humana. Entender cómo representa el cerebro los elementos musicales del habla, incluidos el tono y la emoción, podría hacer que estos dispositivos sonaran menos robóticos".

Ludovic Bellier, miembro del equipo de investigación, especula con que si la IA puede reproducir música a partir de la mera imaginación, podría revolucionar la composición musical.

Los productores musicales podrían conectar sus cerebros a programas informáticos y componer música utilizando sólo el pensamiento, sin apenas mover un músculo.

El siguiente paso: lectura mental en tiempo real con IA

El conjunto de estas tecnologías se engloba en las interfaces cerebro-ordenador (BCI), que tratan de convertir las señales cerebrales en algún tipo de salida.

Las ICB ya están devolviendo a las personas paralíticas la capacidad de moverse y caminar al tender un puente entre los componentes del sistema nervioso dañados.

Las interfaces cerebro-ordenador desarrolladas este año incluyen un dispositivo que permite a un paralítico para mover las piernas, implantes cerebrales experimentales que vuelven a conectar partes dañadas del cerebro y la médula espinal para recuperar la sensibilidad perdida, y una pierna mecánica que devolvió el movimiento a un amputado.

Aunque estos casos de uso iniciales son enormemente prometedores, aún estamos lejos de traducir a la perfección todos los matices de nuestros pensamientos en movimiento, imágenes, voz o música.

Una de las principales limitaciones es la necesidad de enormes conjuntos de datos para entrenar los sofisticados algoritmos que hacen posible tales traducciones.

Los modelos de aprendizaje automático deben entrenarse en muchos escenarios para predecir o generar con precisión una imagen específica a partir de la actividad cerebral. Esto implica recopilar datos de resonancia magnética o electroencefalograma mientras se expone a los participantes a diversos estímulos.

La calidad y especificidad de los resultados generados dependen en gran medida de la riqueza de estos datos de entrenamiento. Los participantes tienen que pasar horas en los escáneres de resonancia magnética para recopilar datos específicamente relevantes.

Además, los cerebros humanos son increíblemente únicos. Lo que significa felicidad en el cerebro de una persona puede diferir en el de otra. Esto significa que los modelos deben ser generales o personalizados.

Además, las actividades cerebrales cambian rápidamente, incluso en fracciones de segundo. Captar datos de alta resolución en tiempo real y garantizar al mismo tiempo su perfecta alineación con el estímulo externo es todo un reto técnico.

Y no nos olvidemos de los problemas éticos que plantea meterse en el cerebro de alguien.

La recogida de datos cerebrales, sobre todo a gran escala, plantea importantes cuestiones éticas y de privacidad. ¿Cómo garantizar que no se haga un mal uso de los datos? ¿Quién tiene derecho a acceder a nuestros pensamientos más íntimos e interpretarlos?

Provisionalmente, parece que estos retos pueden superarse. En el futuro, los seres humanos podrán acceder a interfaces cerebro-ordenador portátiles y personalizadas que les permitan "conectarse" a una miríada de dispositivos que faciliten acciones complejas mediante el poder del pensamiento.

Sin embargo, el modo en que la sociedad afrontaría la generalización de esta tecnología es un tema muy debatido.