Während sich die Diskussionen über die Risiken von KI-Systemen ausweiten, dürfen wir nicht übersehen, dass die Technologie die ohnehin schon strapazierten Energie- und Wasservorräte der Welt belastet.

Komplexe Projekte im Bereich des maschinellen Lernens (ML) hängen von einer Konstellation von Technologien ab, einschließlich Trainingshardware (GPUs) und Hardware für das Hosting und die Bereitstellung von KI-Modellen.

Effiziente KI-Trainingstechniken und -Architekturen versprechen zwar eine Senkung des Energieverbrauchs, doch der KI-Boom hat gerade erst begonnen, und Big Tech investiert verstärkt in ressourcenintensive Rechenzentren und Cloud-Technologie.

Angesichts der sich verschärfenden Klimakrise ist es wichtiger denn je, ein Gleichgewicht zwischen technologischem Fortschritt und Energieeffizienz zu finden.

Energietechnische Herausforderungen für KI

Der Energieverbrauch von KI ist mit dem Aufkommen komplexer, rechenintensiver Architekturen wie neuronaler Netze gestiegen.

So soll GPT-4 beispielsweise auf 8 Modellen mit jeweils 220 Milliarden Parametern basieren, was insgesamt etwa 1,76 Billionen Parameter ergibt. Inflection baut derzeit ein Cluster von 22.000 High-End-Chips von Nvidiadie rund $550.000.000 kosten könnten, bei einem ungefähren Einzelhandelspreis von $25.000 pro Karte. Und das gilt nur für die Chips.

Jedes fortschrittliche KI-Modell erfordert immense Ressourcen für sein Training, aber bis vor kurzem war es schwierig, die wahren Kosten der KI-Entwicklung genau zu erfassen.

A Studie 2019 von der University of Massachusetts in Amherst untersuchte den Ressourcenverbrauch von Deep Neural Networks (DNNs).

In der Regel müssen Datenwissenschaftler diese DNNs manuell entwerfen oder eine neuronale Architektursuche (NAS) verwenden, um ein spezialisiertes neuronales Netzwerk für jeden einzelnen Fall von Grund auf zu finden und zu trainieren.

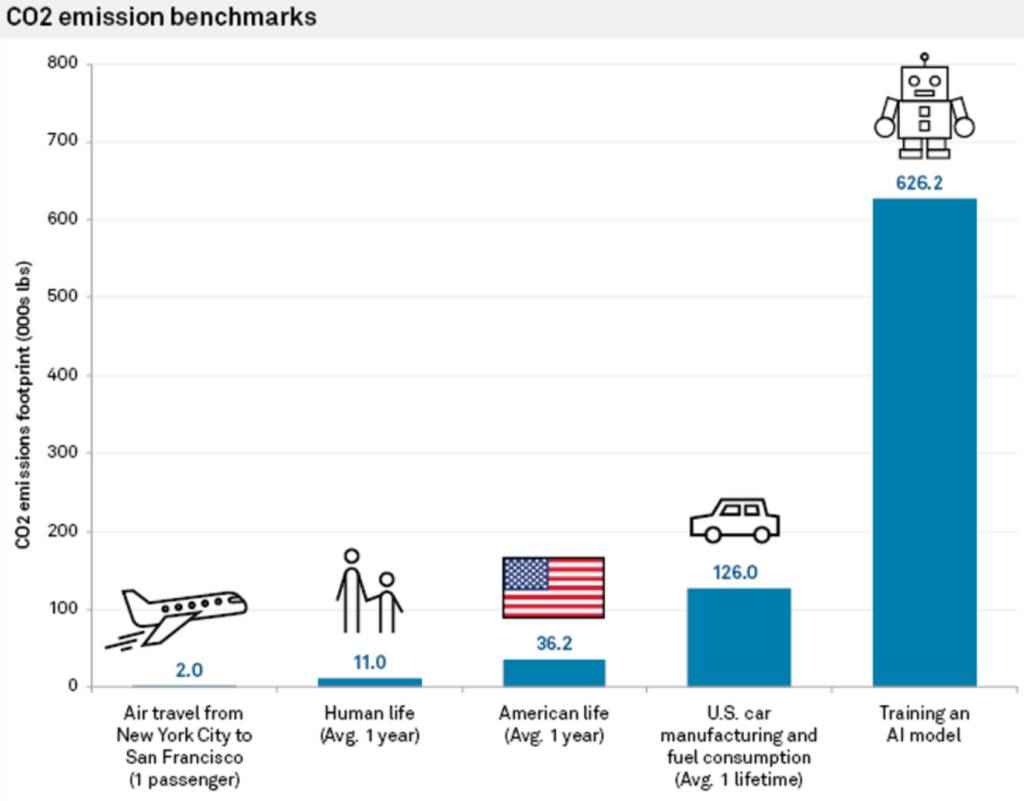

Dieser Ansatz ist nicht nur ressourcenintensiv, sondern hat auch einen erheblichen Kohlendioxid-Fußabdruck. In der Studie wurde festgestellt, dass das Training eines einzigen großen neuronalen Netzes auf Transformer-Basis, das mit NAS - einem in der maschinellen Übersetzung häufig verwendeten Tool - erstellt wurde, rund 626.000 Pfund Kohlendioxid verursachte.

Dies entspricht in etwa den Lebenszeitgasemissionen von 5 Autos.

Carlos Gómez-Rodríguez, Informatiker an der Universität von A Coruña in Spanien, kommentierte die Studie: "Während viele von uns wahrscheinlich nur abstrakt und vage daran gedacht haben, zeigen die Zahlen wirklich das Ausmaß des Problems", und fügte hinzu: "Weder ich noch andere Forscher, mit denen ich darüber gesprochen habe, hielten die Auswirkungen auf die Umwelt für so erheblich.

Die Energiekosten für die Ausbildung des Modells sind nur die Basiswerte - das Minimum an Arbeit, das erforderlich ist, um ein Modell einsatzfähig zu machen.

Emma Strubell, Doktorandin an der University of Massachusetts, sagt: "Ein einziges Modell zu trainieren ist das Minimum an Arbeit, das man leisten kann."

Der "Einmal-für-alles"-Ansatz des MIT

Forscher des MIT schlugen später eine Lösung für dieses Problem vor: die Einmal-für-alles"-Ansatz (OFA).

Die Forscher das Problem beschreiben mit konventionellem Training neuronaler Netze: "Die Entwicklung spezialisierter DNNs für jedes Szenario ist ingenieurs- und rechenaufwändig, entweder mit menschenbasierten Methoden oder mit NAS. Da solche Methoden den Netzentwurfsprozess wiederholen und das entworfene Netz für jeden Fall von Grund auf neu trainieren müssen, wachsen ihre Gesamtkosten linear mit der Anzahl der Einsatzszenarien, was zu einem übermäßigen Energieverbrauch und CO2-Ausstoß führt."

Mit dem OFA-Paradigma des MIT trainieren die Forscher ein einziges allgemeines neuronales Netz, aus dem verschiedene spezialisierte Teilnetze erstellt werden können. Der OFA-Prozess erfordert kein zusätzliches Training für neue Teilnetze, wodurch die energieintensiven GPU-Stunden für das Modelltraining reduziert und die CO2-Emissionen gesenkt werden.

Neben den Vorteilen für die Umwelt bietet der OFA-Ansatz auch erhebliche Leistungsverbesserungen. In internen Tests waren Modelle, die mit dem OFA-Ansatz erstellt wurden, auf Edge-Geräten (kompakte IoT-Geräte) bis zu 2,6 Mal schneller als Modelle, die mit NAS erstellt wurden.

Der OFA-Ansatz des MIT wurde bei der 4. Low Power Computer Vision Challenge 2019 gewürdigt - einer jährlich stattfindenden Veranstaltung des IEEE, die die Forschung zur Verbesserung der Energieeffizienz von Computer-Vision-Systemen (CV) fördert.

Das MIT-Team erhielt die höchste Auszeichnung und wurde von den Veranstaltern gelobt: "Die Lösungen dieser Teams übertreffen die besten Lösungen in der Literatur."

Die 2023 Low Power Computer Vision Herausforderung nimmt derzeit noch bis zum 4. August Bewerbungen entgegen.

Die Rolle des Cloud Computing für die Umweltauswirkungen der KI

Zusätzlich zu den Trainingsmodellen benötigen die Entwickler immense Cloud-Ressourcen, um ihre Modelle zu hosten und einzusetzen.

Große Technologieunternehmen wie Microsoft und Google werden ihre Investitionen in Cloud-Ressourcen bis 2023 erhöhen, um die steigende Nachfrage nach KI-Produkten zu bewältigen.

Cloud Computing und die damit verbundenen Rechenzentren haben einen immensen Ressourcenbedarf. Stand: 2016, vorgeschlagene Schätzungen dass Rechenzentren weltweit für etwa 1% bis 3% des globalen Stromverbrauchs verantwortlich sind, was dem Energieverbrauch einiger kleiner Nationen entspricht.

Auch der Wasserverbrauch von Rechenzentren ist gewaltig. Große Rechenzentren können täglich Millionen von Litern Wasser verbrauchen.

Im Jahr 2020 wurde berichtet, dass die Rechenzentren von Google in South Carolina die Erlaubnis erhielten, die 549 Millionen Gallonen Wasserfast das Doppelte der zwei Jahre zuvor verbrauchten Menge. Ein 15-Megawatt-Rechenzentrum kann täglich bis zu 360.000 Gallonen Wasser verbrauchen.

Im Jahr 2022, Google offenbart dass seine globale Rechenzentrumsflotte rund 4,3 Milliarden Gallonen Wasser verbraucht hat. Sie betonen jedoch, dass die Wasserkühlung wesentlich effizienter ist als andere Techniken.

Alle großen Technologieunternehmen haben ähnliche Pläne zur Verringerung ihres Ressourcenverbrauchs, wie z. B. Google, das 2017 sein Ziel erreicht hat, 100% seines Energieverbrauchs durch den Kauf erneuerbarer Energie zu decken.

KI-Hardware der nächsten Generation nach dem Vorbild des menschlichen Gehirns

KI ist immens ressourcenintensiv, aber unsere Gehirne laufen mit nur einem 12 Watt Leistung - Kann eine solche Energieeffizienz in der KI-Technologie nachgebildet werden?

Selbst ein Desktop-Computer verbraucht mehr als 10-mal so viel Strom wie das menschliche Gehirn, und leistungsstarke KI-Modelle benötigen Millionen Mal mehr Strom. Die Entwicklung von KI-Technologien, die die Effizienz biologischer Systeme nachahmen können, würde die Branche völlig verändern.

Um der KI gegenüber fair zu sein, berücksichtigt dieser Vergleich nicht die Tatsache, dass das menschliche Gehirn über Millionen von Jahren der Evolution "trainiert" wurde. Außerdem sind KI-Systeme und biologische Gehirne für unterschiedliche Aufgaben hervorragend geeignet.

Dennoch würde die Entwicklung von KI-Hardware, die Informationen mit einem ähnlichen Energieverbrauch wie biologische Gehirne verarbeiten kann, autonome, biologisch inspirierte KI ermöglichen, die nicht an sperrige Energiequellen gekoppelt ist.

Im Jahr 2022 hat ein Team von Forschern des Indian Institute of Technology in Bombay, kündigte die Entwicklung eines neuen KI-Chips, der dem menschlichen Gehirn nachempfunden ist. Der Chip arbeitet mit Spiking Neural Networks (SNNs), die die neuronale Signalverarbeitung biologischer Gehirne nachahmen.

Das Gehirn besteht aus 100 Milliarden winziger Neuronen, die über Synapsen mit Tausenden anderer Neuronen verbunden sind und Informationen durch koordinierte Muster elektrischer Spikes übermitteln. Die Forscher bauten künstliche Neuronen mit extrem niedrigem Energieverbrauch und statteten SNNs mit Band-zu-Band-Tunnelstrom (BTBT) aus.

"Bei BTBT lädt der Quanten-Tunnelstrom den Kondensator mit einem sehr geringen Strom auf, so dass weniger Energie benötigt wird", erklärt Udayan Ganguly vom Forschungsteam.

Laut Professor Ganguly erreicht ihr Ansatz im Vergleich zu bestehenden, hochmodernen Neuronen, die in Hardware-SNNs implementiert sind, "5.000 Mal weniger Energie pro Spike bei ähnlicher Fläche und 10 Mal weniger Standby-Leistung bei ähnlicher Fläche und Energie pro Spike".

Die Forscher demonstrierten ihren Ansatz erfolgreich in einem Spracherkennungsmodell, das vom auditorischen Kortex des Gehirns inspiriert ist. SNNs könnten Anwendungen auf kompakten Geräten wie Mobiltelefonen und IoT-Sensoren verbessern.

Das Team will einen "extrem stromsparenden neurosynaptischen Kern und einen Echtzeit-Lernmechanismus auf dem Chip entwickeln, die für autonome biologisch inspirierte neuronale Netze entscheidend sind".

Die Auswirkungen der KI auf die Umwelt werden oft übersehen, aber die Lösung von Problemen wie dem Stromverbrauch von KI-Chips wird auch neue Wege für Innovationen eröffnen.

Wenn es den Forschern gelingt, die KI-Technologie an biologische Systeme anzulehnen, die außergewöhnlich energieeffizient sind, könnte dies die Entwicklung von autonomen KI-Systemen ermöglichen, die nicht auf eine umfangreiche Stromversorgung und die Anbindung an Rechenzentren angewiesen sind.