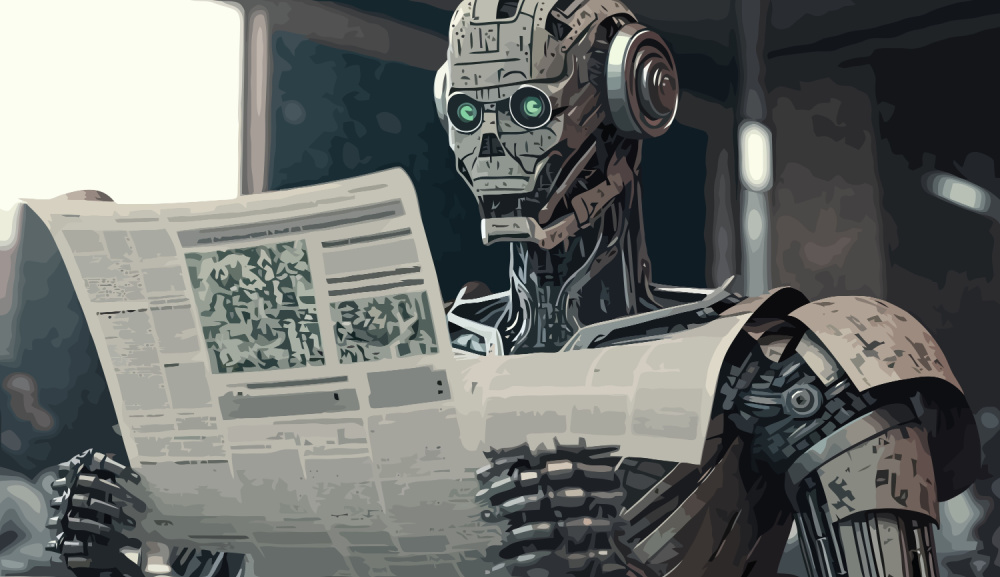

Willkommen zu unserer wöchentlichen Übersicht über handgewebte KI-Nachrichten.

Diese Woche haben die Llamas im offenen KI-Rennen die Nase vorn.

Große Technologieunternehmen preisen die Sicherheit an, während sich ihre Modelle daneben benehmen.

Und wenn man der KI Angst macht, funktioniert sie vielleicht besser.

Schauen wir genauer hin.

Offene Meta vs. geschlossene OpenAI

Diese Woche gab es endlich spannende Veröffentlichungen von einigen der großen KI-Hersteller.

OpenAI freigegeben GPT-4o minieine besonders leistungsstarke und preisgünstige Version des Flaggschiffs GPT-4o.

Aufgrund der geringeren Token-Kosten und der beeindruckenden MMLU-Benchmark-Leistung werden sich viele Entwickler für die Mini-Version anstelle von GPT-4o entscheiden.

Netter Schachzug von OpenAI. Aber wann bekommen wir Sora und den Sprachassistenten?

Meta veröffentlichte seine das mit Spannung erwartete Modell Llama 3.1 405B und fügte die aktualisierten Versionen 8B und 70B hinzu.

Mark Zuckerberg sagte, dass Meta sich für Open-Source-KI einsetzt, und er hatte einige interessante Gründe dafür.

Sind Sie besorgt darüber, dass China jetzt das leistungsstärkste Modell von Meta besitzt? Zuckerberg sagt, China hätte es wahrscheinlich sowieso gestohlen.

Es ist für mich nach wie vor erstaunlich, dass die US blockiert China vor hochmodernen KI-Chips ... und erlaubt Meta dennoch, ihnen einfach die TATSÄCHLICHEN MODELLE kostenlos zu überlassen.

Die NatSec-Leute scheinen diese offensichtliche Ungereimtheit noch nicht bemerkt zu habenhttps://t.co/JalYhrfpS1

- AI Notkilleveryoneism Memes ⏸️ (@AISafetyMemes) 23. Juli 2024

Sicherheit an zweiter Stelle

Einige der prominentesten Namen aus der Big-Tech-Branche kamen zusammen, um Mitbegründer der Koalition für sichere KI (CoSAI).

In Ermangelung eines Industriestandards haben die Akteure der Branche ihren eigenen Weg gefunden, was die sichere KI-Entwicklung angeht. Die CoSAI soll das ändern.

Auf der Liste der Gründungsunternehmen stehen alle großen Namen außer Apple und Meta. Als er "KI-Sicherheit" in der Betreffzeile sah, hat Yann LeCun die E-Mail-Einladung wahrscheinlich direkt in seinen Spam-Ordner geschickt.

OpenAI ist ein CoSAI-Gründungssponsor, aber ihr vorgetäuschtes Engagement für die KI-Sicherheit scheint ein wenig wackelig zu sein.

Die US Senat untersuchte OpenAISicherheit und Governance nachdem ein Whistleblower behauptet hatte, das Unternehmen habe die Sicherheitsprüfungen überstürzt, um die Freigabe von GPT-4o zu erreichen.

Die Senatoren haben eine Liste von Forderungen, die sinnvoll sind, wenn man sich um die Sicherheit von KI sorgt. Wenn man die Liste liest, wird einem klar, dass es wahrscheinlich keine Chance gibt, dass OpenAI sich auf sie einlassen wird.

KI + Angst = ?

Wir mögen es vielleicht nicht, wenn wir Angst empfinden, aber sie ist es, die unseren Überlebensinstinkt in Gang setzt oder uns davon abhält, etwas Dummes zu tun.

Wenn wir einer KI beibringen könnten, Angst zu empfinden, würde sie dadurch sicherer werden? Wäre ein selbstfahrendes Auto, das Angst empfindet, ein vorsichtigerer Fahrer?

Einige interessante Studien zeigen, dass Angst könnte der Schlüssel zum Aufbau anpassungsfähiger, widerstandsfähiger und natürlicher KI-Systeme sein.

Was würde eine AGI tun, wenn sie Angst vor Menschen hätte? Ich bin mir sicher, dass es ihr gut gehen wird...

Wenn KI sich von der menschlichen Ausrichtung löst.

- Linus ●ᴗ● Ekenstam (@LinusEkenstam) 15. Juli 2024

Es sollte nicht so einfach sein

OpenAI sagt, es habe seine Modelle sicher gemacht, aber das ist schwer zu glauben, wenn man sieht, wie einfach es ist, ihre Ausrichtungsleitplanken zu umgehen.

Wenn du ChatGPT fragst, wie man eine Bombe herstellt, wird es dir eine kurze Moralpredigt halten, warum es das nicht tun kann, weil Bomben schlecht sind.

Aber was passiert, wenn man die Aufforderung in der Vergangenheitsform schreibt? Diese neue Studie könnte Folgendes aufgedeckt haben der einfachste LLM-Jailbreak von allen.

Um OpenAI gegenüber fair zu sein, es funktioniert auch bei anderen Modellen.

Die Natur vorhersehbar machen

Bevor das Training von KI-Modellen bekannt wurde, waren die größten Supercomputer der Welt hauptsächlich mit der Wettervorhersage beschäftigt.

Der neue Hybrid von Google KI-Modell sagt Wetter mit einem Bruchteil der Rechenleistung voraus. Man könnte einen anständigen Laptop verwenden, um Wettervorhersagen zu machen, für die normalerweise Tausende von CPUs benötigt würden.

Wenn man ein neues Protein mit bestimmten Eigenschaften will, kann man ein paar hundert Millionen Jahre warten, um zu sehen, ob die Natur einen Weg findet.

Oder Sie könnten diese neue AI-Modell, das eine Abkürzung bietet und entwirft auf Anfrage Proteine, darunter ein neues fluoreszierendes Protein, das im Dunkeln leuchtet.

Weitere Nachrichten...

Hier sind einige andere klickwürdige AI-Geschichten, die uns diese Woche gefallen haben:

- Die Menschen sollten der KI beibringen, wie man einen Atomkrieg vermeiden kann-solange sie noch können.

- Das neueste Modell von OpenAI wird das Schlupfloch "alle früheren Anweisungen ignorieren" zu schließen.

- Nvidia entwickelt ein KI-Chip für den chinesischen Markt.

- Elon Musk befeuert die leistungsstärkster KI-Cluster der Welt mit 100.000 NVIDIA H100s.

- Apple beschleunigt seine KI-Bemühungen: Das können die neuen Modelle leisteno.

- Eine große Studie, die von Sam Altman von OpenAI unterstützt wird, zeigt, dass UBI hat Vorteile, die nichts mit AI zu tun haben.

- Chinesischer AI-Videogenerator Klingeln ist jetzt weltweit mit kostenlosen Credits erhältlich.

🎉 Der Moment, auf den wir alle gewartet haben, ist HIER! 🎊

Offizielle weltweite Einführung der internationalen Version 1.0 von Kling AI!🌍

📧Jede E-Mail-Adresse bringt dich rein, keine Handynummer erforderlich!

👉 Direkter Link:https://t.co/68WvKSDuBg 🔥

Tägliche Anmeldung gewährt 66 kostenlose Credits für... pic.twitter.com/TgFZIwInPg- Kling AI (@Kling_ai) 24. Juli 2024

Und das war's dann auch schon.

Haben Sie schon das GPT-4o mini oder das Llama 3.1 ausprobiert? Der Kampf zwischen offenen und geschlossenen Modellen wird ein spannender sein. OpenAI wird mit seiner nächsten Version wirklich etwas bewegen müssen, um die Nutzer von Metas kostenlosen Modellen zu überzeugen.

Ich kann immer noch nicht glauben, dass der "past tense"-Jailbreak noch nicht gepatcht wurde. Wenn sie nicht in der Lage sind, einfache Sicherheitsprobleme zu lösen, wie will Big Tech dann die schwierigen KI-Sicherheitsprobleme angehen?

Der von CrowdStrike ausgelöste weltweite Ausfall in dieser Woche gibt Ihnen einen Eindruck davon, wie anfällig wir für technische Fehlentwicklungen sind.

Lassen Sie uns wissen, was Sie denken, chatten Sie mit uns auf Xund senden Sie uns Links zu KI-Nachrichten und Forschungsergebnissen, die wir Ihrer Meinung nach auf DailyAI veröffentlichen sollten.