Als Google die Veröffentlichung seiner Gemini-Modelle ankündigte, war die Aufregung groß, da das Unternehmen behauptete, dass diese den Angeboten von OpenAI ebenbürtig seien. Das ist vielleicht nicht ganz richtig.

Google sagte, dass seine Zwillinge Ultra Modell besser ist als das GPT-4. Das Modell wurde noch nicht veröffentlicht, also müssen wir die Benchmark-Testergebnisse für bare Münze nehmen. Gemini Pro wurde veröffentlicht und ist laut Google gleichauf mit GPT-3.5.

Forscher der Carnegie Mellon University und der KI-Softwareplattform BerriAI unterzogen Gemini Pro einer Reihe von Aufgaben, um sein Sprachverständnis und seine Fähigkeiten zur Spracherzeugung zu testen.

Sie führten dieselben Tests mit GPT-3.5 Turbo, GPT-4 Turbo und Mistral AIs neuem Modell Mixtral 8x7B.

Googles Gemini hat sich kürzlich als wichtiger Konkurrent für OpenAIs GPT erwiesen. Aufregend! Aber wir haben uns gefragt:

Wie gut sind die Zwillinge wirklich?

An der CMU haben wir eine unparteiische, eingehende und reproduzierbare Studie durchgeführt, in der Gemini, GPT und Mixtral verglichen wurden.

Papier: https://t.co/S3T7ediQLa

🧵 pic.twitter.com/NmEOeDd8pI- Graham Neubig (@gneubig) 19. Dezember 2023

Ergebnisse

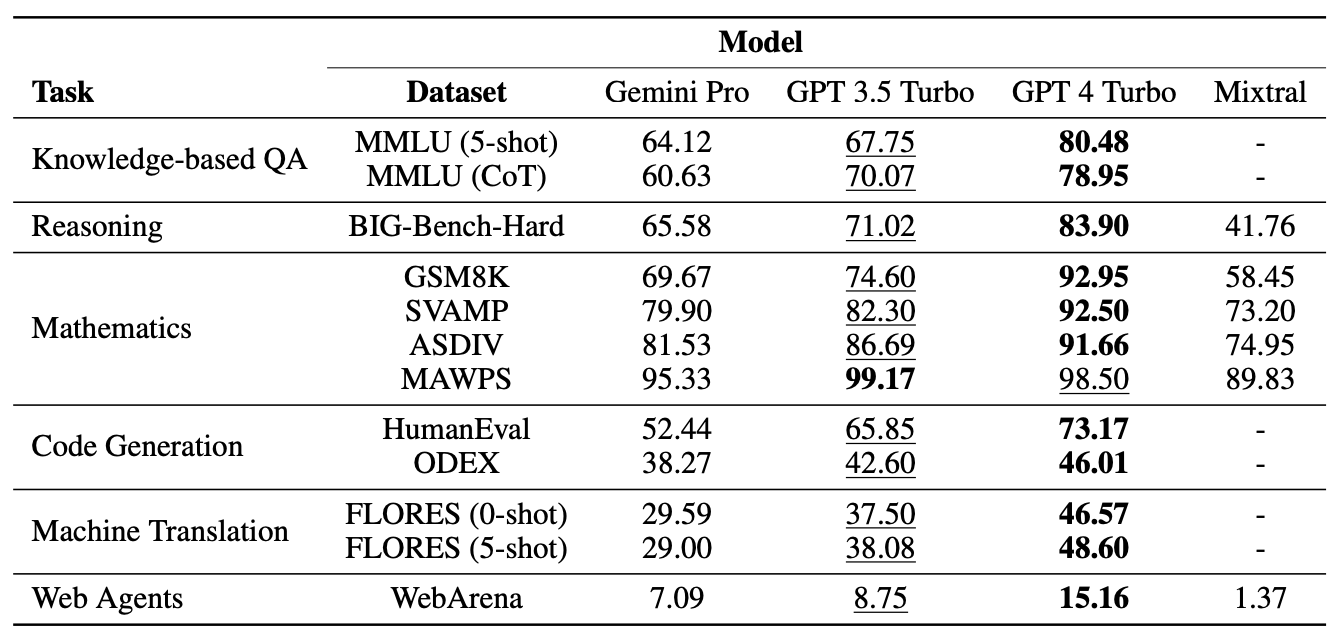

Es überrascht nicht, dass GPT-4 den Sieg davontrug, aber Google wird weniger gespannt sein, wie Gemini Pro gegen GPT 3.5 Turbo abschneidet. Hier eine Zusammenfassung der Ergebnisse des Teams, das Papier sagte: "Das Pro-Modell von Gemini erreicht eine vergleichbare, aber leicht schlechtere Genauigkeit als die aktuelle Version von OpenAIs GPT 3.5 Turbo."

Hier ist eine Zusammenfassung der Ergebnisse.

Die Modelle wurden über die LiteLLM-Schnittstelle von BerriAI abgefragt, wobei jedes Modell genau die gleichen Aufforderungen und das gleiche Bewertungsprotokoll erhielt.

Die Modelle wurden auf Multiple-Choice-Fragen, allgemeines logisches Denken, mathematisches Denken, Codegenerierung, Sprachübersetzung und die Funktion als Web-Agent getestet.

Einer der Gründe für das schlechte Abschneiden von Gemini Pro bei den Multiple-Choice-Fragen ist, dass das Programm eine starke Tendenz zur Positionierung aufweist. Es wählte oft die Antwort in Position D, ob sie nun richtig war oder nicht. Interessanterweise ist dies etwas, das auch Microsofts Medprompt löst sich mit Mischen.

Obwohl Gemini Pro bei einigen Tests unterlegen war, schlug es GPT-3.5 Turbo in zwei Bereichen, nämlich bei der Wortsortortierung und der Symbolmanipulation und -übersetzung.

Bei allen Übersetzungsaufgaben, die Gemini Pro erledigte, schnitt es besser ab als alle anderen Modelle, einschließlich GPT-4. Das Endergebnis von Gemini Pro bei den Übersetzungstests lag allerdings unter dem von GPT-3.5, da es sich weigerte, einige Anfragen zu bearbeiten, als seine übereifrigen Leitplanken für die Inhaltsmoderation anschlugen.

Na und?

Google bestreitet die Zahlen, zu denen die Forscher gekommen sind, und besteht darauf, dass seine Zahlen zeigen, dass Gemini Pro gleichwertig oder besser als GPT-3.5 ist. Wenn wir die zahllosen Variablen berücksichtigen und Google eine gewisse Nachsicht gewähren, könnten wir den Unterschied aufteilen und sagen, dass Gemini Pro und GPT-3.5 so ziemlich gleich sind.

Das Wichtigste dabei ist, dass Gemini Pro, ein brandneues Modell, das Google monatelang entwickelt hat, nicht gegen ein Modell ankommt, das seit mehr als einem Jahr auf dem Markt ist und über ChatGPT kostenlos genutzt werden kann.

Gemini Ultra wird voraussichtlich Anfang 2024 auf den Markt kommen. Wird es seinem Anspruch gerecht werden, besser zu sein als GPT-4? Hoffen wir, dass Professor Graham Neubig und sein Team bald ähnliche Benchmarking-Tests durchführen können.