Bei der KI geht es um Daten, aber woher kommen sie? Sind Datensätze legal und ethisch vertretbar? Wie können Entwickler das mit Sicherheit feststellen?

Für das Training von Modellen des maschinellen Lernens, wie z. B. Large Language Models (LLM), werden große Mengen an Textdaten benötigt.

Auf Plattformen wie Kaggle, GitHub und Hugging Face sind stapelweise Datensätze verfügbar, aber sie bewegen sich in einer rechtlichen und ethischen Grauzone, vor allem aufgrund von Lizenzierungs- und Fair-Use-Problemen.

Die Initiative zur Datenprovenienz, eine Zusammenarbeit zwischen KI-Forschern und Juristen, hat Tausende von Datensätzen untersucht, um ihren wahren Ursprung zu ergründen.

Es konzentrierte sich auf über 1.800 Datensätze, die auf Plattformen wie Hugging Face, GitHub und Papers With Code verfügbar sind. Die Datensätze sind in erster Linie für die Feinabstimmung von Open-Source-Modellen wie Llama-2 gedacht.

Die Studie ergab, dass etwa 70% dieser Datensätze entweder keine klaren Lizenzinformationen enthielten oder mit zu freizügigen Lizenzen versehen waren.

Aufgrund des eklatanten Mangels an Klarheit über Urheberrechte und kommerzielle Nutzungsbeschränkungen besteht für KI-Entwickler die Gefahr, versehentlich gegen das Gesetz zu verstoßen oder Urheberrechte zu verletzen.

Shayne Longpre, ein Doktorand am MIT Media Lab, der die Prüfung leitete, betonte, dass das Problem nicht die Schuld der Hosting-Plattformen sei, sondern eher ein systemisches Problem innerhalb der Gemeinschaft des maschinellen Lernens.

2023 hat sich eine Flut von Prozessen die auf große KI-Entwickler wie Meta, Anthropic und OpenAI abzielen, die unter extremem Druck stehen, transparentere Datenerhebungspraktiken anzuwenden. Verordnungen, wie zum Beispiel die Das KI-Gesetz der EUsind darauf ausgerichtet, genau das durchzusetzen.

Die Data Provenance Initiative ermöglicht es Entwicklern von maschinellem Lernen Erkunden Sie die geprüften Datensätze hier. Im Rahmen der Initiative werden auch Muster innerhalb von Datensätzen analysiert, die Aufschluss über deren geografische und institutionelle Herkunft geben.

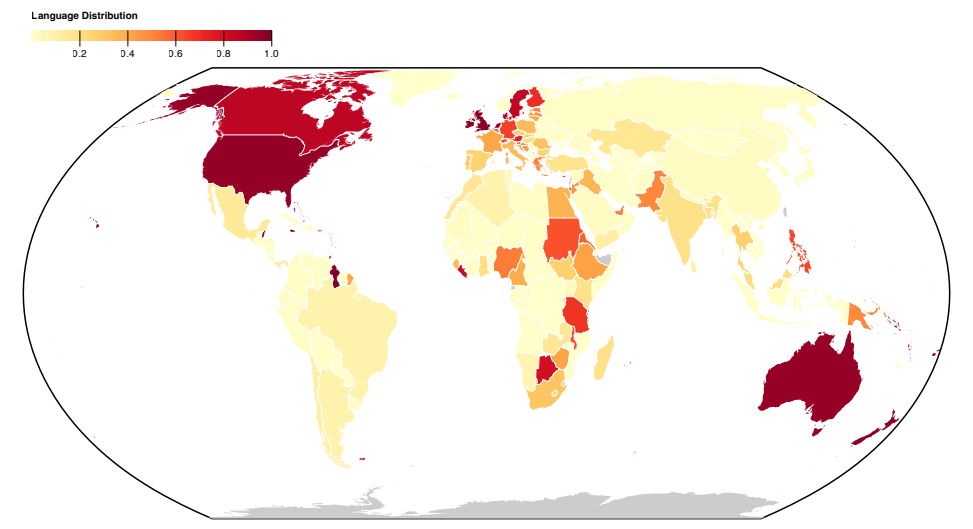

Die meisten Datensätze wurden im englischsprachigen globalen Norden erstellt, was die soziokulturellen Ungleichgewichte verdeutlicht.

Mehr über die Studie

Diese groß angelegte Analyse von Datensätzen deckte systematische Probleme mit der Art und Weise der Datenerhebung und -verteilung auf. Die Initiative hat auch ein Papier erstellt, um ihre Ergebnisse zu erläutern, hier veröffentlicht.

Hier finden Sie weitere Informationen über die Methoden und Ergebnisse der Studie:

- Analyse von Datensätzen auf Herkunft und Kennzeichnung: In dieser Studie wurden über 1800 Feinabstimmungsdatensätze systematisch geprüft, um ihre Datenherkunft, Lizenzierung und Dokumentation zu untersuchen.

- Beweise für eine falsche Etikettierung: Die Ergebnisse verdeutlichen die Kluft zwischen den unter verschiedenen Lizenzen verfügbaren Datentypen und die Auswirkungen auf die rechtliche Auslegung des Urheberrechts und die faire Nutzung. Die Studie förderte eine hohe Rate an Fehlkategorisierungen von Lizenzen zutage, wobei mehr als 72% der Datensätze keine Lizenz spezifizierten und eine Fehlerquote von 50% bei denjenigen, die dies taten.

- Unzuverlässige Datenherkunft: Die Forschung lenkt die Aufmerksamkeit auf das Problem der unzuverlässigen Datenherkunft und unterstreicht die Notwendigkeit von Standards zur Rückverfolgung der Datenherkunft, zur Gewährleistung einer korrekten Zuordnung und zur Förderung einer verantwortungsvollen Datennutzung.

- Geografische Verbreitung: Die Studie zeigt einen gravierenden Mangel an Darstellung und Zuordnung von Datensätzen aus dem globalen Süden auf. Die meisten Datensätze drehen sich um die englische Sprache und sind kulturell an Europa, Nordamerika und den englischsprachigen Teil Ozeaniens gebunden.

Diese Studie zeigt systemische und strukturelle Probleme bei der Erstellung, Verteilung und Nutzung von Daten auf. Daten sind eine wichtige Ressource für KI, und ähnlich wie natürliche Ressourcen sind sie endlich.

Es besteht die Befürchtung, dass die KI-Technologie über kurz oder lang die aktuellen Datensätze übersteigen wird und möglicherweise sogar beginnen, ihre eigene Ausgabe zu verbrauchenDas bedeutet, dass die KI-Modelle aus dem von der KI generierten Text lernen werden.

Dies könnte die Qualität der Modelle untergraben, was bedeutet, dass qualitativ hochwertige, ethische und legale Daten sehr wertvoll werden könnten.