Eine Studie von Psychologen der UCLA hat gezeigt, dass GPT-3 etwa so gut ist wie Studenten im Grundstudium, wenn es um das Lösen von Denkaufgaben geht.

Wir wissen, dass LLMs wie GPT-3 gut darin sind, Antworten auf der Grundlage der Daten zu generieren, auf die sie trainiert wurden, aber ihre Fähigkeit zum logischen Denken ist fraglich. Analoges Denken ist die Fähigkeit des Menschen, das, was er aus einer nicht verwandten Erfahrung gelernt hat, auf ein Problem anzuwenden, mit dem er noch nicht konfrontiert war.

Auf diese Fähigkeit verlassen Sie sich, wenn Sie eine Frage beantworten müssen, die Sie noch nie gesehen haben. Man kann sie auf der Grundlage früherer Probleme, die man gelöst hat, durchdenken. Und aus der Forschung geht hervor, dass GPT-3 diese Fähigkeit ebenfalls entwickelt hat.

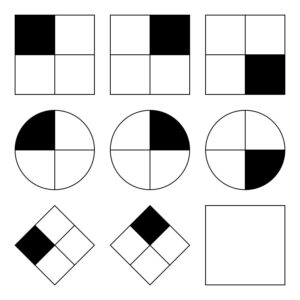

Die UCLA-Forscher GPT-3 mit einer Reihe von Problemen zu beschäftigen, die ähnlich sind wie Raven's Progressive Matrizen bei dem es darum geht, das nächste Bild in einer Reihe von Bildern vorherzusagen. Hier ist eine einfache Aufgabe, die Sie ausprobieren können.

GPT-3 konnte sich im Vergleich zu den 40 UCLA-Studenten, die denselben Test absolvieren mussten, gut behaupten. Die KI hat in 80% der Fälle die richtigen Antworten gegeben, während die 40 Studenten im Durchschnitt 60% richtig lagen. Die Spitzenstudenten erzielten in etwa das gleiche Ergebnis wie GPT-3.

Hongjing Lu, Psychologieprofessorin an der UCLA und Hauptautorin der Studie, sagte: "Überraschenderweise hat GPT-3 nicht nur genauso gut abgeschnitten wie Menschen, sondern auch ähnliche Fehler gemacht."

Die Forscher baten GPT-3 auch, einige Wortassoziationsaufgaben zu lösen. Zum Beispiel: "'Auto' ist zu 'Straße' wie 'Boot' zu welchem Wort?". Die Antwort ist natürlich "Wasser", aber diese Art von Fragen können für eine KI schwierig sein.

Nun, zumindest dachten die Forscher, dass es schwierig sein könnte. Es stellte sich heraus, dass GPT-3 besser abschnitt als der Durchschnitt der College-Bewerber bei ihren SATs.

GPT-3 kämpft mit Problemen, die für Menschen einfach sind

Womit KI-Modelle Schwierigkeiten haben, sind Probleme, die ein visuelles Verständnis des physischen Raums erfordern. Wenn man GPT-3 eine Liste von Werkzeugen wie einen Hammer, einen Nagel und ein Bild vorlegt, ist es nicht in der Lage, die offensichtliche Lösung für das Aufhängen des Bildes an der Wand zu finden.

Diese Art von Problem ist für Menschen leicht zu lösen, weil wir physische Objekte in einem von uns bewohnten Raum sehen, halten und fühlen können. Diese Erfahrungen machen es unserem Gehirn leicht, zu lernen und Probleme auf eine Weise zu lösen, wie es KI-Modelle nicht können. Abgesehen davon wird GPT-4 bei dieser Art des Denkens jetzt immer besser.

Die Forscher konnten zwar die Leistung von GPT-3 messen, aber sie haben keine Ahnung, welchen "Denkprozess" es durchläuft, um die Antworten zu erhalten. Folgt es einem ähnlichen Denkprozess wie der Mensch oder tut es etwas völlig anderes? Da GPT-3 ein geschlossenes Modell ist, ist es nicht möglich, unter die Haube zu schauen, um zu sehen, was dort passiert.

Das überraschende Ergebnis dieser Forschung ist, dass GPT-3 in der Lage zu sein scheint, neue Probleme ohne direktes Training zu lösen. Das entspricht in etwa dem, wie Menschen neue Probleme lösen. Es wird erwartet, dass GPT-4 bei diesen Problemen noch besser abschneidet, und wer weiß, welche weiteren "Denkfähigkeiten" sich bei weiteren Tests herausstellen könnten.

Während das räumliche Denken eine Herausforderung für LLMs darstellt, könnten diese Herausforderungen durch visuelle Modelle gelöst werden wie Googles RT-2 das kürzlich angekündigt wurde. Sobald KI-Modelle beginnen können, ihre Umgebung zu "sehen" und physisch mit ihr zu interagieren, werden sich ihre Problemlösungsfähigkeiten exponentiell verbessern.