Das exponentielle Wachstum von KI-Systemen überholt Forschung und Regulierung und bringt die Regierungen in die schwierige Lage, Vorteile und Risiken abzuwägen.

Es dauert Jahre, bis Gesetze entwickelt und rechtsverbindlich werden. KI entwickelt sich wöchentlich weiter.

Das ist der Zwiespalt, mit dem sich KI-Führungskräfte und Politiker konfrontiert sehen, denn die erste sinnvolle KI-Regulierung im Westen, das EU-KI-Gesetz, steht 2026 an. Noch vor einem Jahr war ChatGPT nur ein Geflüster.

Spitzenbeamte der USA und der EU trafen sich am 31. Mai im schwedischen Luleå zum US-EU Trade and Tech Council (TTC). Margrethe Vestager, EU-Kommissarin für Digitales, die sich in der Vorwoche mit Google-CEO Sundar Pichai getroffen hatte, um einen möglichen "KI-Pakt" zu erörtern, sagte: "Die Demokratie muss zeigen, dass wir genauso schnell sind wie die Technologie."

Offizielle Stellen räumen ein, dass zwischen dem Tempo der Technologie und dem Tempo der Gesetzgebung eine große Lücke klafft. Gina Raimondo, die US-Handelsministerin, sagte mit Blick auf generative KI wie ChatGPT: "Sie entwickelt sich so schnell wie keine andere Technologie".

Was hat das TTC-Treffen also gebracht?

Wasserzeichen, externe Audits, Feedback-Schleifen - dies sind nur einige der Ideen, die mit @AnthropicAI und @sama @OpenAI für die #AI 1TP5Verhaltenskodex wurde heute auf der #TTC in #Luleå @SecRaimondo Ich freue mich auf die Diskussion mit internationalen Partnern. pic.twitter.com/wV08KDNs3h

- Margrethe Vestager (@vestager) 31. Mai 2023

Die Teilnehmer diskutierten in erster Linie über nicht verbindliche oder freiwillige Rahmenregelungen zu Risiko und Transparenz, die der G7 im Herbst vorgelegt werden sollen.

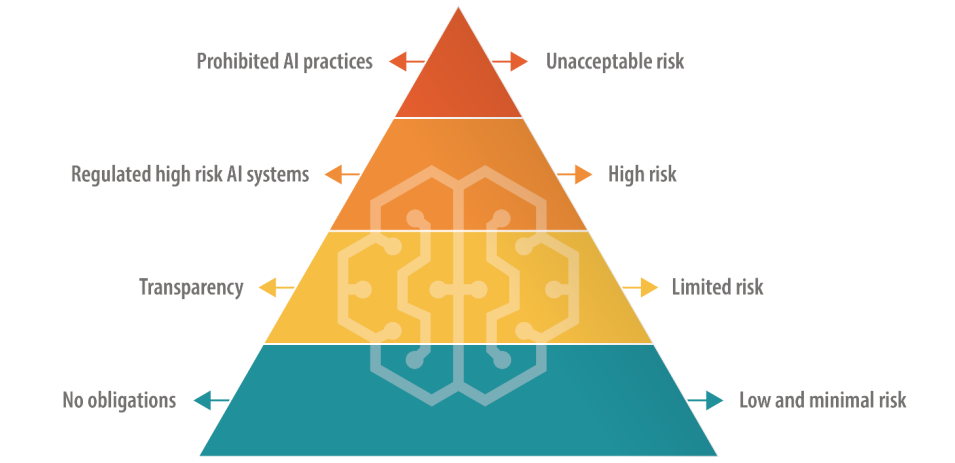

Die EU, die bei der Gesetzgebung im Bereich der digitalen Technologien einen direkten Ansatz verfolgt, hat sich bei der Regulierung von KI für einen mehrstufigen Ansatz entschieden, bei dem KI je nach Risiko in Kategorien eingeteilt wird.

Dazu gehören eine verbotene "inakzeptable Risikostufe" und eine "hohe Risikostufe", von der Tech-Bosse wie OpenAI-CEO Sam Altman befürchten, dass sie die Funktionalität ihrer Produkte beeinträchtigt.

Die USA schlagen keine derartigen endgültigen Regelungen vor, Bevorzugung freiwilliger Regelungen.

Es werden noch viele weitere Treffen zwischen der EU, den USA und den großen Technologieunternehmen erforderlich sein, um die Ansichten mit sinnvollen praktischen Maßnahmen in Einklang zu bringen.

Werden freiwillige KI-Regeln funktionieren?

Es gibt viele Beispiele für freiwillige Regeln in anderen Sektoren und Branchen, wie z. B. freiwillige Datensicherheitsrahmen und ESG-Offenlegungen, aber keiner ist so nah an der Spitze wie ein freiwilliger KI-Governance-Rahmen.

Schließlich haben wir es hier mit einer Bedrohung auf dem Niveau des Aussterbens zu tun, so führende Techniker und Akademiker, die den Bericht Erklärung des Center for AI Safety zum KI-Risiko in dieser Woche.

Große Unternehmen wie OpenAI und Google verfügen bereits über zentrale Abteilungen, die sich mit Governance und Fragen der internen Compliance befassen, so dass die Anpassung ihrer Produkte und Dienstleistungen an freiwillige Rahmenwerke eine Frage des Umschreibens interner Grundsatzdokumente sein könnte.

Freiwillige Regeln sind besser als gar nichts, aber angesichts der zahlreichen Vorschläge, die auf dem Tisch liegen, werden sich Politiker und KI-Verantwortliche früher oder später für etwas entscheiden müssen.