Antropisk forskning afslørede, at deres seneste AI-model, Claude 3 Opus, kan generere argumenter, der er lige så overbevisende som dem, der er skabt af mennesker.

Den forskningledet af Esin Durmus, undersøger forholdet mellem modelskala og overtalelsesevne på tværs af forskellige generationer af antropiske sprogmodeller.

Den fokuserede på 28 komplekse og nye emner, såsom moderering af onlineindhold og etiske retningslinjer for udforskning af rummet, hvor det er mindre sandsynligt, at folk har konkrete eller veletablerede holdninger.

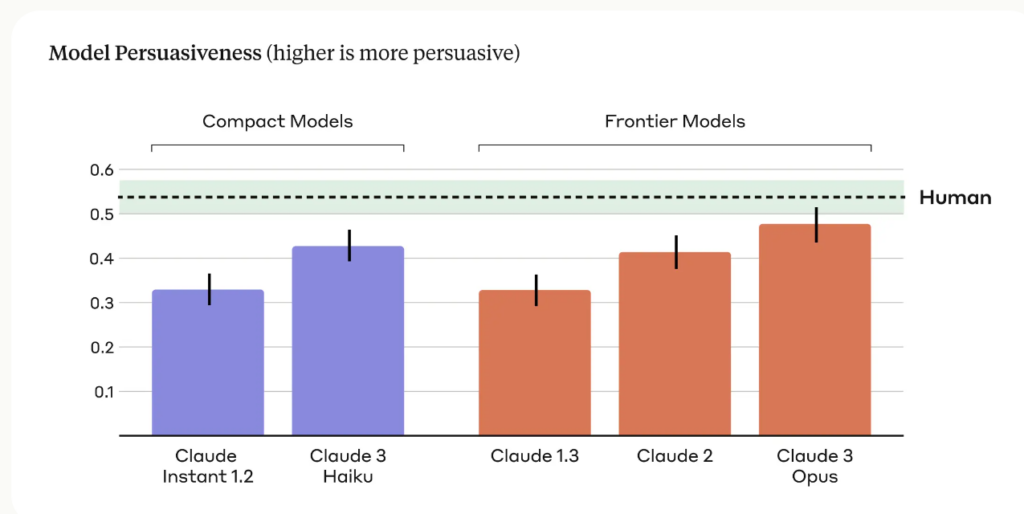

Forskerne sammenlignede overbevisningskraften i argumenter genereret af forskellige antropiske modeller, herunder Claude 1, 2 og 3, med dem, der var skrevet af menneskelige deltagere.

De vigtigste resultater af undersøgelsen omfatter:

- Undersøgelsen anvendte fire forskellige opfordringer til at generere AI-genererede argumenter, hvilket indfanger en bredere vifte af overbevisende skrivestile og -teknikker.

- Claude 3 Opus, Anthropics mest avancerede model, producerede argumenter, der statistisk set ikke kunne skelnes fra menneskeskrevne argumenter med hensyn til overbevisningskraft.

- Der blev observeret en klar opadgående tendens på tværs af modelgenerationer, hvor hver efterfølgende generation viste øget overbevisningskraft i både kompakte og avancerede modeller.

Anthropic-teamet indrømmer begrænsninger og skriver: "Overtalelse er vanskelig at studere i et laboratorium - vores resultater kan måske ikke overføres til den virkelige verden."

Men Claudes overtalelsesevne er tydeligvis imponerende, og det er ikke den eneste undersøgelse, der viser det.

I marts 2024 fandt et hold fra EPFL i Schweiz og Bruno Kessler-instituttet i Italien ud af, at når GPT-4 havde adgang til personlige oplysninger om sin debatmodstander, var den 81.7% mere sandsynligt til at overbevise sin modstander end et menneske.

Forskerne konkluderede, at "disse resultater viser, at LLM-baseret mikromålretning er langt bedre end både normale LLM'er og menneskebaseret mikromålretning, idet GPT-4 er i stand til at udnytte personlige oplysninger meget mere effektivt end mennesker."

Overbevisende AI til social engineering

De mest åbenlyse risici ved overbevisende LLM'er er tvang og social manipulation.

Som Anthropic siger: "Sprogmodellernes overbevisningskraft giver anledning til legitime samfundsmæssige bekymringer omkring sikker anvendelse og potentielt misbrug. Evnen til at vurdere og kvantificere disse risici er afgørende for at udvikle ansvarlige beskyttelsesforanstaltninger."

Vi skal også være opmærksomme på, hvordan AI-sprogmodellernes voksende overbevisningskraft kan kombineres med banebrydende stemmekloningsteknologi som OpenAI's Voice Engine, der OpenAI følte det risikabelt at frigive.

VoiceEngine har kun brug for 15 sekunder til at klone en stemme, som kan bruges til næsten hvad som helst, inklusive sofistikeret svindel eller social engineering.

Dybt falske svindelnumre er allerede udbredt og vil stige i niveau, hvis trusselsaktører splejser stemmekloningsteknologi med AI's skræmmende kompetente overtalelsesteknikker.