HyperWrites grundlægger og CEO Matt Shumer meddelte, at hans nye model, Reflection 70B, bruger et simpelt trick til at løse LLM-hallucinationer og leverer imponerende benchmarkresultater, der slår større og endda lukkede modeller som GPT-4o.

Shumer samarbejdede med udbyderen af syntetiske data, Glaive, om at skabe den nye model, som er baseret på Meta's Llama 3.1-70B Instruct-model.

I lanceringsmeddelelsen på Hugging Face sagde Shumer. "Reflection Llama-3.1 70B er (i øjeblikket) verdens bedste open source LLM, trænet med en ny teknik kaldet Reflection-Tuning, der lærer en LLM at opdage fejl i sit ræsonnement og korrigere kursen."

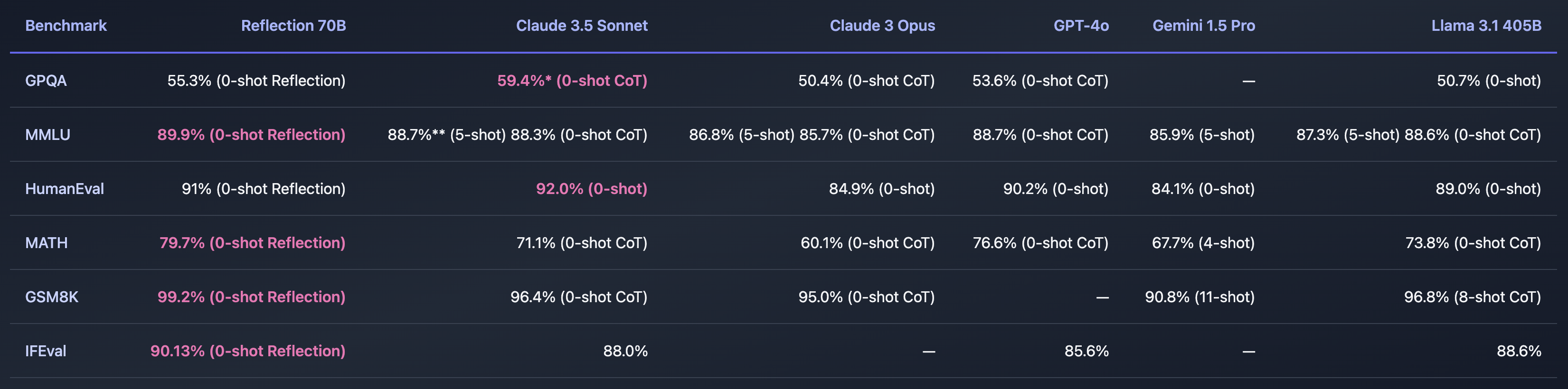

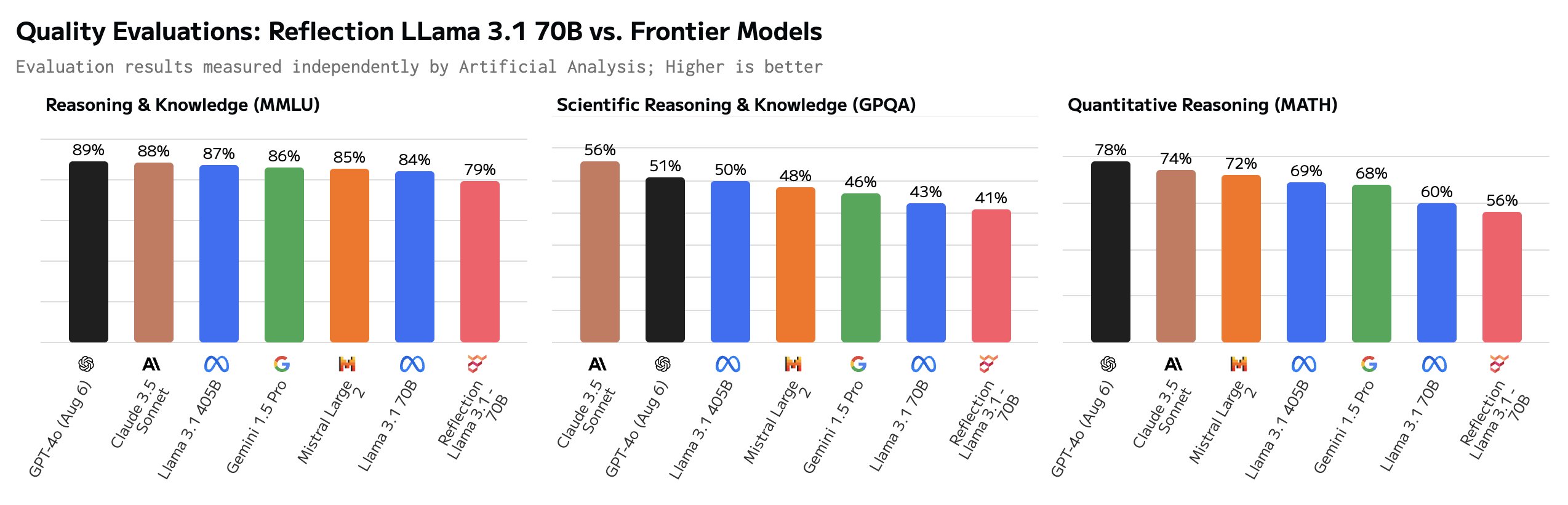

Hvis Shumer fandt en måde at løse problemet med AI-hallucinationer på, ville det være utroligt. De benchmarks, han delte, tyder på, at Reflection 70B er langt foran andre modeller.

Modellens navn er en henvisning til dens evne til at korrigere sig selv under udledningen. Shumer afslører ikke for meget, men forklarer, at modellen reflekterer over sit oprindelige svar på en forespørgsel og først udsender det, når den er overbevist om, at det er korrekt.

Shumer siger, at en 405B-version af Reflection er på vej og vil blæse andre modeller, inklusive GPT-4o, omkuld, når den afsløres i næste uge.

Er Reflection 70B et fupnummer?

Er det hele for godt til at være sandt? Reflection 70B kan downloades på Huging Face, men de første testere var ikke i stand til at kopiere den imponerende ydeevne, som Shumers benchmarks viste.

Den Legeplads til refleksion lader dig prøve modellen, men siger, at demoen er midlertidigt nede på grund af stor efterspørgsel. Forslagene "Tæl r'er i jordbær" og "9.11 vs 9.9" antyder, at modellen har styr på disse svære opgaver. Men nogle brugere hævder, at Reflection er blevet indstillet specifikt til at besvare disse spørgsmål.

Nogle brugere satte spørgsmålstegn ved de imponerende benchmarks. GSM8K på over 99% så især mistænkelig ud.

Hej Matt! Det er super interessant, men jeg er ret overrasket over at se en GSM8k-score på over 99%. Som jeg forstår det, er det sandsynligt, at mere end 1% af GSM8k er forkert mærket (det rigtige svar er faktisk forkert)!

- Hugh Zhang (@hughbzhang) 5. september 2024

Nogle af de rigtige svar i GSM8K-datasættet er faktisk forkerte. Med andre ord var den eneste måde at score over 99% på GSM8K at give de samme forkerte svar på disse problemer.

Efter nogle tests siger brugerne, at Reflection faktisk er værre end Llama 3.1, og at det faktisk bare var Llama 3 med LoRA-tuning.

Som svar på den negative feedback skrev Shumer en forklaring på X og sagde: "Hurtig opdatering - vi har genindlæst vægtene, men der er stadig et problem. Vi er lige begyndt at træne igen for at eliminere ethvert muligt problem. Det burde være færdigt snart."

Shumer forklarede, at der var en fejl med API'en, og at de arbejdede på det. I mellemtiden gav han adgang til et hemmeligt, privat API, så tvivlere kunne prøve Reflection, mens de arbejdede på at løse problemet.

Og det er her, hjulene ser ud til at hoppe af, for hvis man spørger forsigtigt, viser det sig, at API'en i virkeligheden bare er en Claude 3.5 Sonnet-indpakning.

"Reflection API" er en sonnet 3.5 wrapper med prompt. Og de forklæder den i øjeblikket ved at filtrere strengen 'claude' fra.https://t.co/c4Oj8Y3Ol1 https://t.co/k0ECeo9a4i pic.twitter.com/jTm2Q85Q7b

- Joseph (@RealJosephus) 8. september 2024

Efterfølgende test viste angiveligt, at API'en returnerede output fra Llama og GPT-4o. Shumer insisterer på, at de oprindelige resultater er nøjagtige, og at de arbejder på at rette den model, der kan downloades.

Er skeptikerne lidt for hurtige til at kalde Shumer for en svindler? Måske var udgivelsen bare dårligt håndteret, og Reflection 70B er virkelig en banebrydende open source-model. Eller måske er det endnu et eksempel på AI-hype for at skaffe risikovillig kapital fra investorer, der leder efter den næste store ting inden for AI.

Vi bliver nødt til at vente en dag eller to for at se, hvordan det går.