Meta har udgivet sine opgraderede Llama 3.1-modeller i 8B-, 70B- og 405B-versioner og forpligtet sig til Mark Zuckerbergs open source-vision for fremtidens AI.

De nye tilføjelser til Metas Llama-familie af modeller kommer med en udvidet kontekstlængde på 128k og understøttelse af otte sprog.

Meta siger, at den længe ventede 405B-model demonstrerer "uovertruffen fleksibilitet, kontrol og avancerede funktioner, der kan konkurrere med de bedste closed source-modeller." De hævder også, at Llama 3.1 405B er "verdens største og mest kapable åbent tilgængelige fundamentmodel."

Med iøjnefaldende computeromkostninger, der bruges til at træne stadig større modeller, var der mange spekulationer om, at Metas flagskibsmodel 405B kunne være den første betalte model.

Llama 3.1 405B blev trænet på over 15 billioner tokens ved hjælp af 16.000 NVIDIA H100, hvilket sandsynligvis har kostet hundredvis af millioner dollars.

I en blogindlægbekræftede Meta CEO Mark Zuckerberg virksomhedens synspunkt om, at open source AI er vejen frem, og at udgivelsen af Llama 3.1 er det næste skridt "mod, at open source AI bliver industristandarden."

Llama 3.1-modellerne er gratis at downloade og ændre eller finjustere med en række tjenester fra Amazon, Databricks og NVIDIA.

Modellerne er også tilgængelige hos udbydere af cloud-tjenester, herunder AWS, Azure, Google og Oracle.

Fra i dag er det open source, der viser vejen. Vi introducerer Llama 3.1: Vores mest kapable modeller til dato.

I dag udgiver vi en række nye Llama 3.1-modeller, herunder vores længe ventede 405B. Disse modeller leverer forbedrede ræsonneringsfunktioner, en større 128K token kontekst... pic.twitter.com/1iKpBJuReD

- AI på Meta (@AIatMeta) 23. juli 2024

Præstation

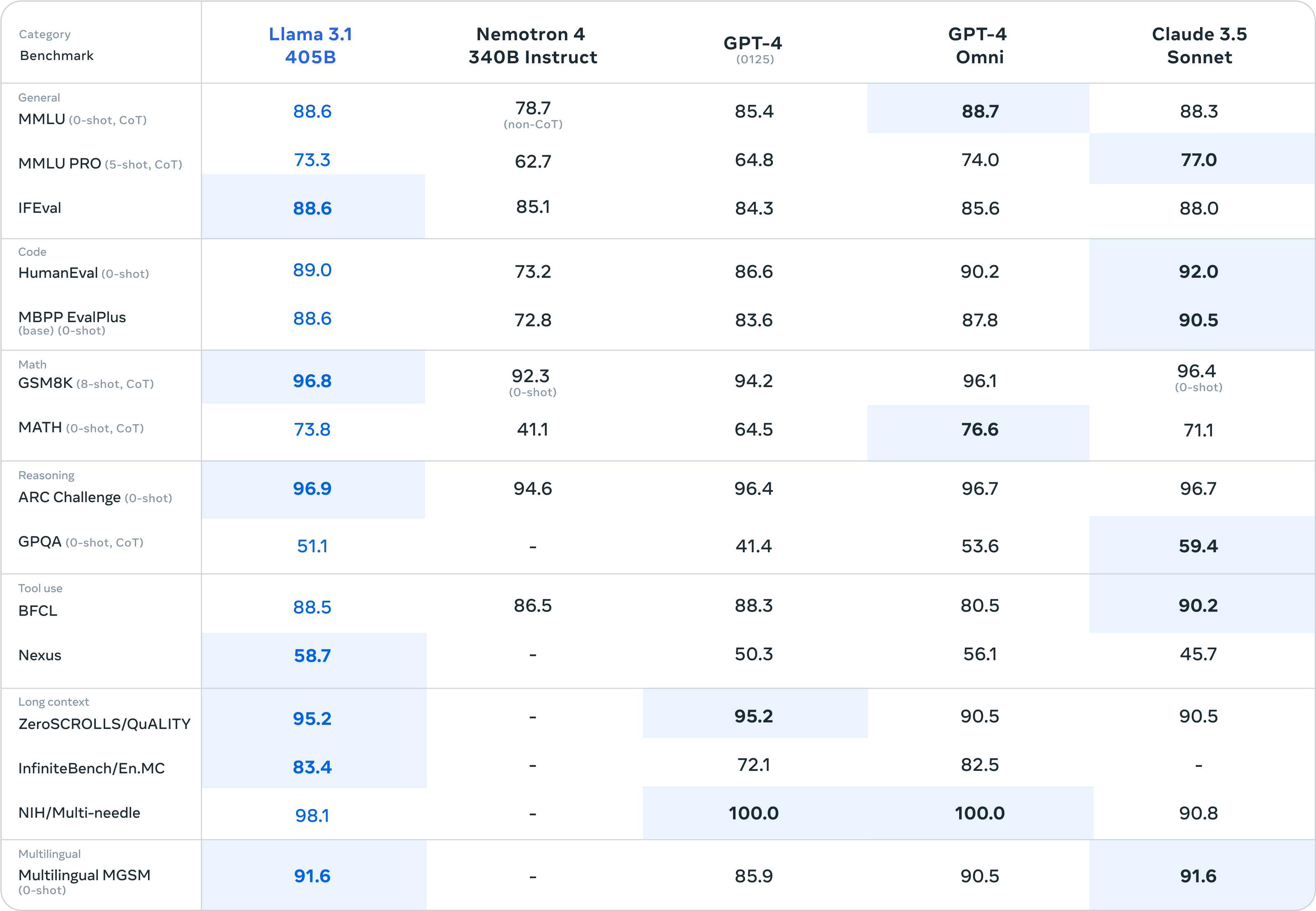

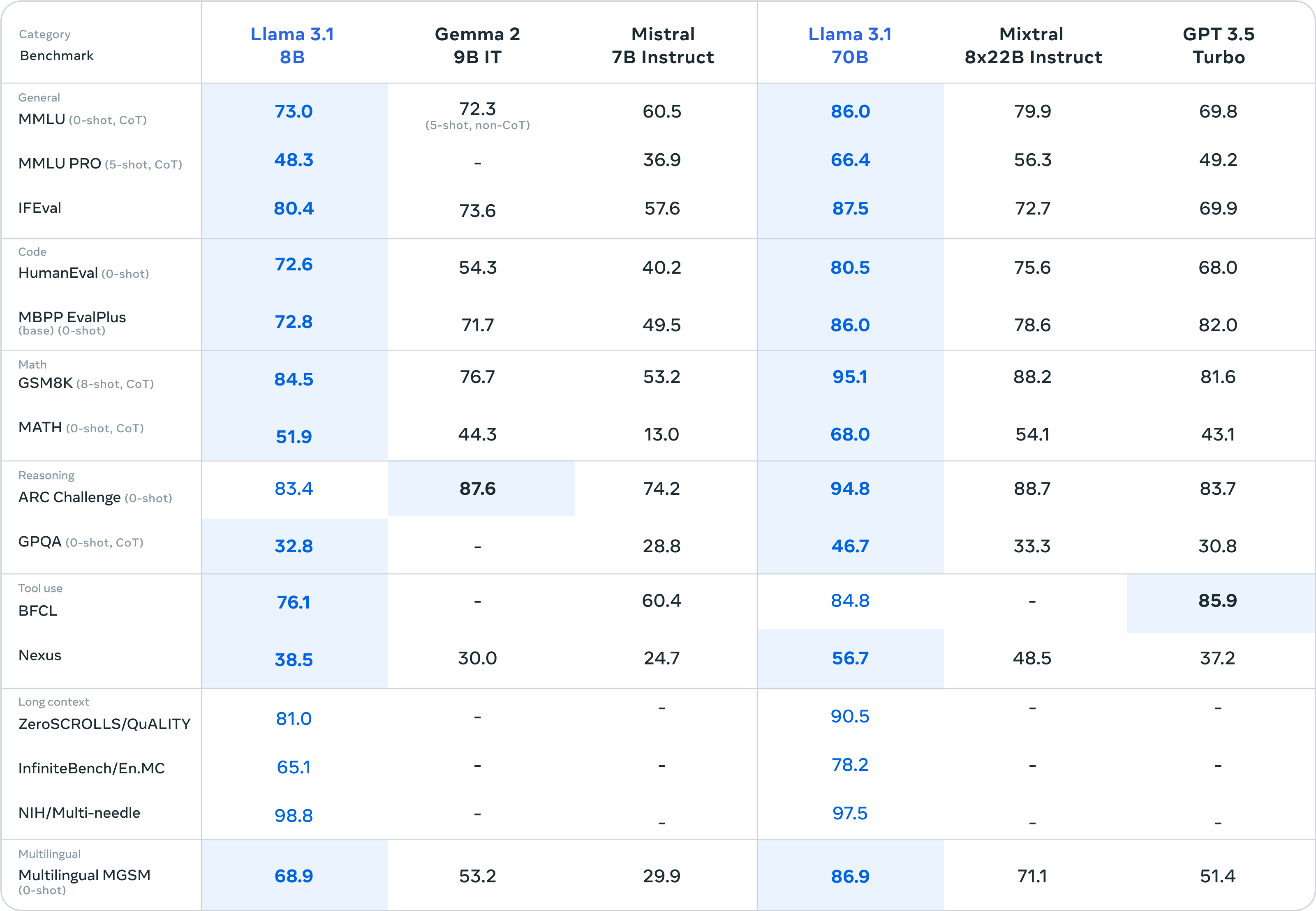

Meta siger, at de har testet deres modeller på over 150 benchmarkdatasæt og offentliggjort resultater for de mest almindelige benchmarks for at vise, hvordan deres nye modeller klarer sig i forhold til andre førende modeller.

Der er ikke meget, der adskiller Llama 3.1 405B fra GPT-4o og Claude 3.5 Sonnet. Her er tallene for 405B-modellen og derefter de mindre 8B- og 70B-versioner.

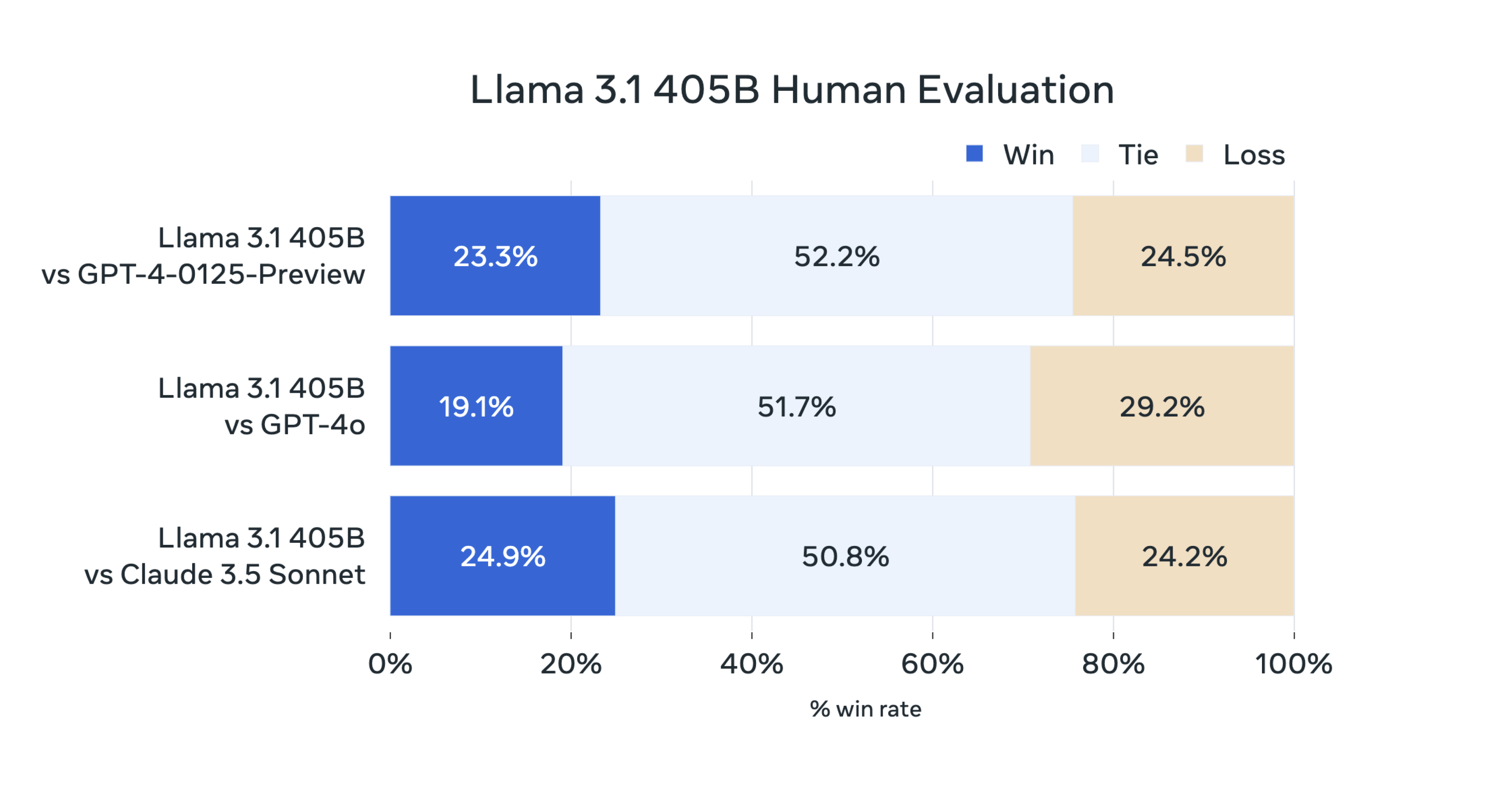

Meta udførte også "omfattende menneskelige evalueringer, der sammenligner Llama 3.1 med konkurrerende modeller i virkelige scenarier."

Disse tal er afhængige af, at brugerne beslutter, om de foretrækker svaret fra den ene eller den anden model.

Den menneskelige evaluering af Llama 3.1 405B afspejler den samme paritet, som benchmark-tallene afslører.

Meta siger, at dens model er virkelig åben, da Llama 3.1-modellens vægte også kan downloades, selvom træningsdataene ikke er blevet delt. Virksomheden har også ændret sin licens, så Llama-modeller kan bruges til at forbedre andre AI-modeller.

Friheden til at finjustere, ændre og bruge Llama-modeller uden begrænsninger vil have Kritikere af open source AI får alarmklokkerne til at ringe.

Zuckerberg argumenterer for, at en open source-tilgang er den bedste måde at undgå utilsigtet skade på. Hvis en AI-model er åben for granskning, siger han, at det er mindre sandsynligt, at den udvikler farlig adfærd, som vi ellers ville overse i lukkede modeller.

Når det gælder potentialet for forsætlig skade, siger Zuckerberg: "Så længe alle har adgang til lignende generationer af modeller - hvilket open source fremmer - vil regeringer og institutioner med flere computerressourcer være i stand til at kontrollere dårlige aktører med mindre computere."

Med hensyn til risikoen for, at statslige modstandere som Kina får adgang til Metas modeller, siger Zuckerberg, at bestræbelserne på at holde dem ude af kinesiske hænder ikke kommer til at fungere.

"Vores modstandere er gode til spionage, det er relativt nemt at stjæle modeller, der passer på et tommelfinger-drev, og de fleste teknologivirksomheder arbejder langt fra på en måde, der ville gøre det sværere", forklarede han.

Begejstringen over en open source AI-model som Llama 3.1 405B, der tager kampen op med de store lukkede modeller, er berettiget.

Men med rygter om GPT-5 og Claude 3.5 Opus, der venter i kulissen, er det ikke sikkert, at disse benchmark-resultater ældes særlig godt.