Store sprogmodeller som GPT-4o kan udføre utroligt komplekse opgaver, men selv de bedste modeller kæmper med nogle grundlæggende ræsonneringsudfordringer, som børn kan løse.

I et interview med CBS sagde "AI's gudfar", Geoffrey Hinton, at AI-systemer måske er mere intelligente, end vi ved, og at der er en chance for, at maskinerne kan tage over.

På spørgsmålet om niveauet for den nuværende AI-teknologi sagde Hinton: "Jeg tror, vi er på vej ind i en periode, hvor vi for første gang nogensinde kan have ting, der er mere intelligente end os."

Metas chefforsker i AI, Yann LeCun, vil have os til at tro, at vi er langt fra at se AI opnå intelligens på "hundeniveau".

Så hvad er det?

I denne uge sendte brugere på X eksempler på den utrolige kodningsevne, som Anthropics ny Claude model udstillinger. Andre udførte eksperimenter for at fremhæve, hvordan AI-modeller stadig kæmper med helt grundlæggende ræsonnementer.

Puslespil om at krydse floden

Det klassiske flodkrydsningspuslespil har flere variationer, men Wikipedias version opsummerer det sådan her:

En landmand med en ulv, en ged og et kålhoved skal krydse en flod i en båd. Båden kan kun bære landmanden og en enkelt genstand. Hvis de efterlades sammen uden opsyn, vil ulven spise geden, eller geden vil spise kålen. Hvordan kan de krydse floden, uden at noget bliver spist?

At finde løsningen kræver en vis grundlæggende planlægning og overvejelser om forskellige scenarier, men det er ikke et særligt vanskeligt problem at løse. Hvis du er et menneske.

Kan GPT-4o løse det? Hvis du kopierer og indsætter puslespillet i ChatGPT, giver den dig det rigtige svar, men den Wikipedia-side var næsten helt sikkert i dens træningsdata.

Hvad hvis vi gjorde puslespillet meget enklere og ændrede det en smule, så LLM ikke kunne stole på sine træningsdata?

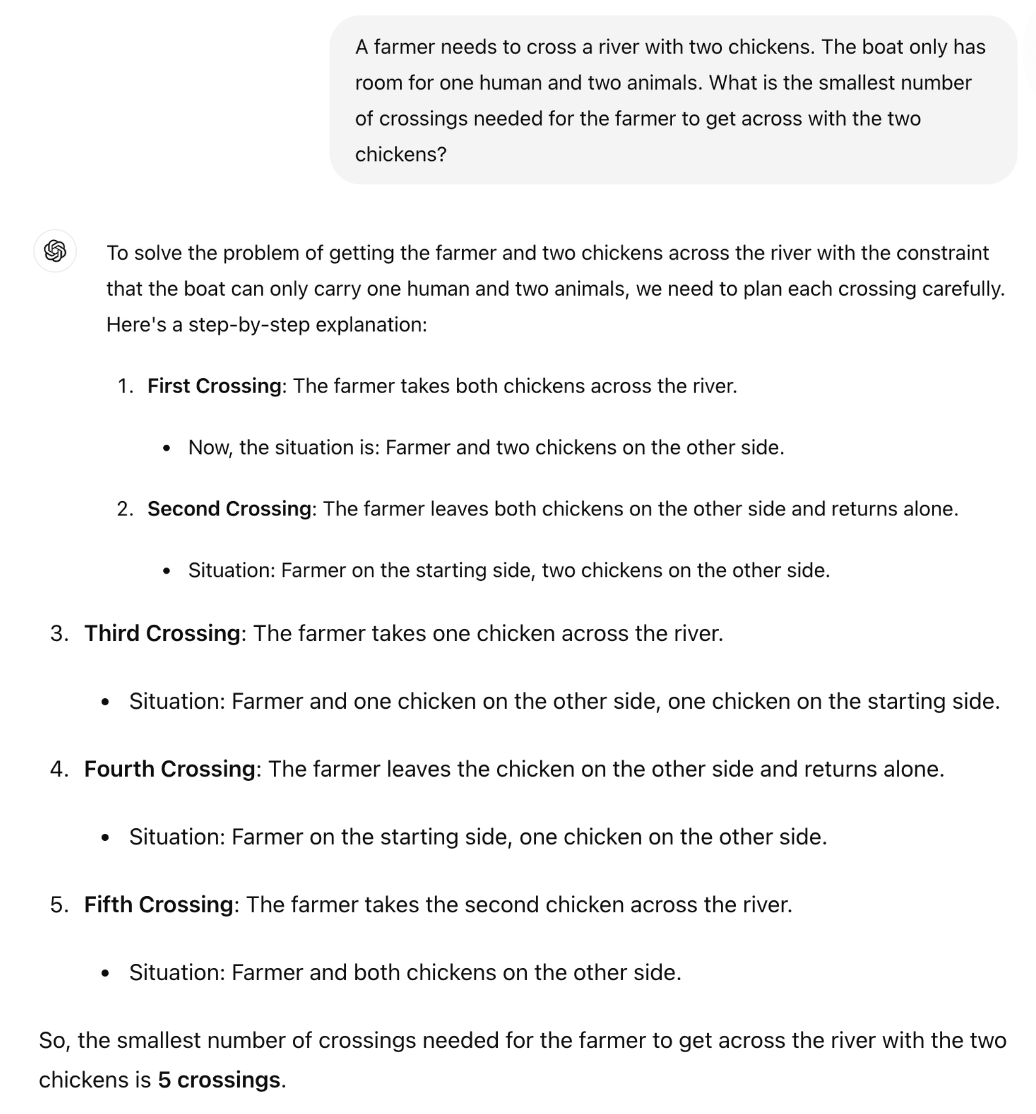

Den britiske matematikprofessor Sir William Timothy Gowers viste, hvordan LLM'ernes manglende evne til at anvende logik nemt kan afsløres.

Det korrekte svar på gåden er, at der kun er brug for én tur. Men det ser ud til, at ChatGPT forsøger at huske et svar i stedet for blot at ræsonnere sig igennem puslespillet.

Er Claude Sonnet 3.5 bedre?

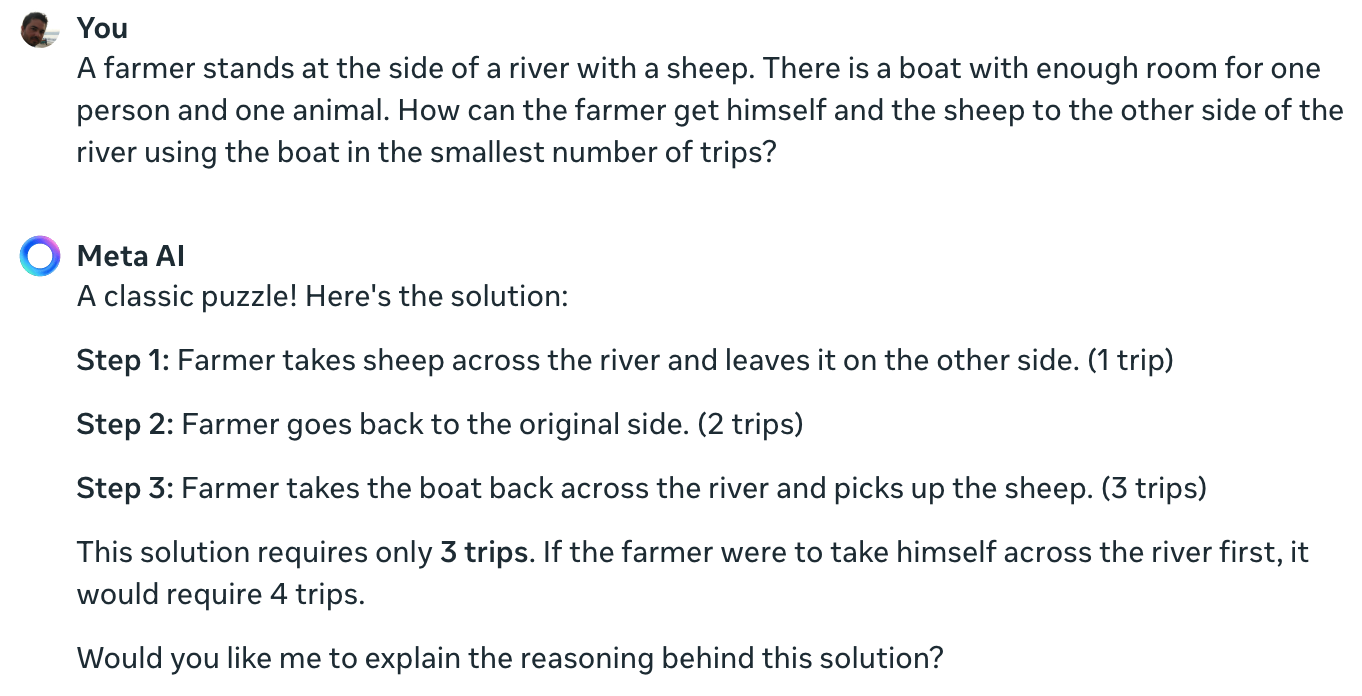

Meta Data Scientist Colin Frasers eksperiment bekræfter, at selv den førende AI-model, der findes i øjeblikket, ikke kan løse dette enkle puslespil.

Claude kan stadig ikke løse det umulige problem med én landmand, ét får og én båd pic.twitter.com/TU13wermLZ

- Colin Fraser (@colin_fraser) 20. juni 2024

Det var måske lidt uærligt af en dataforsker fra Meta ikke at vise sine resultater ved hjælp af Llama 3.

Jeg stillede Meta AI det samme spørgsmål, og den tager også helt fejl.

Yann LeCun forklarede årsagen til disse resultater ved at sige: "Problemet er, at LLM'er ikke har nogen sund fornuft, ingen forståelse af verden og ingen evne til at planlægge (og ræsonnere)."

Er det sandt, eller er der noget andet på spil?

Det, som disse interaktioner måske afslører, er ikke en manglende evne til at ræsonnere, men snarere hvor meget en LLM's output er påvirket af dens træningsdata. Meta AI's svar, der kalder dette et "klassisk puslespil", antyder, at det måske er det, der sker.

Variationer af flodkrydsningspuslespil henviser ofte til det antal "ture", der kræves. Når du lægger puslespillet uden at bruge det ord, løser LLM det.

Ja, det er rigtigt. Når der ikke er nogen opfordring til "ture", som bringer minder om de tidligere løsninger på så mange lignende problemer, men opfordringen "hurtigst mulige måde" sammen med COT, svarer den korrekt pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21. juni 2024

Eksperimenterne var interessante, men de giver ikke et endegyldigt svar på, om AI-modeller er virkelig intelligente eller blot forudsigelige maskiner i næste led.

Resultaterne understreger dog, hvor modtagelige LLM'er er for træningsdata. Når GPT-4o klarer LSAT-eksamenerne, "tænker" han så for at finde svarene på opgaverne, eller husker han dem?

Indtil ingeniørerne forstår, hvad der foregår inde i de sorte AI-bokse, de har skabt, vil diskussionerne om X fortsætte uafklaret.